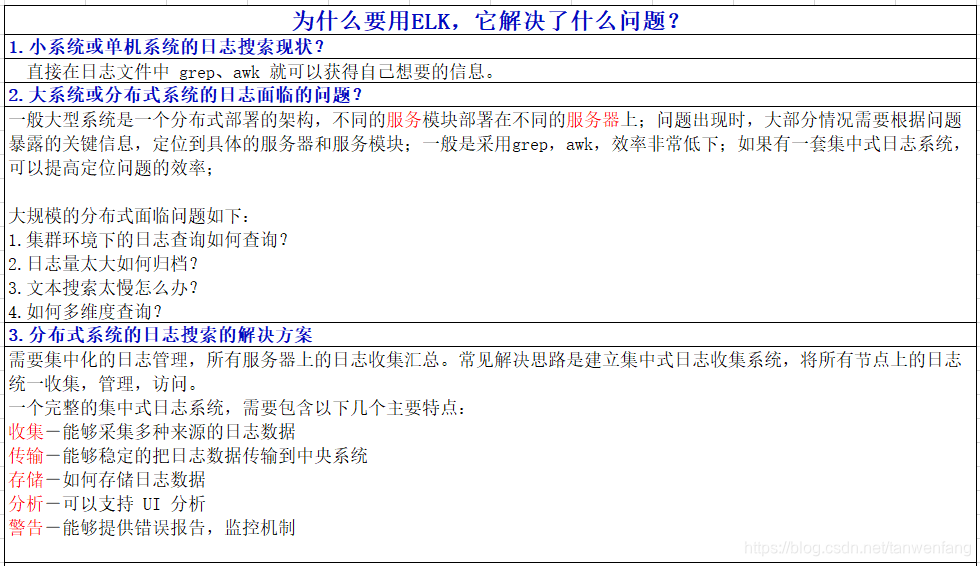

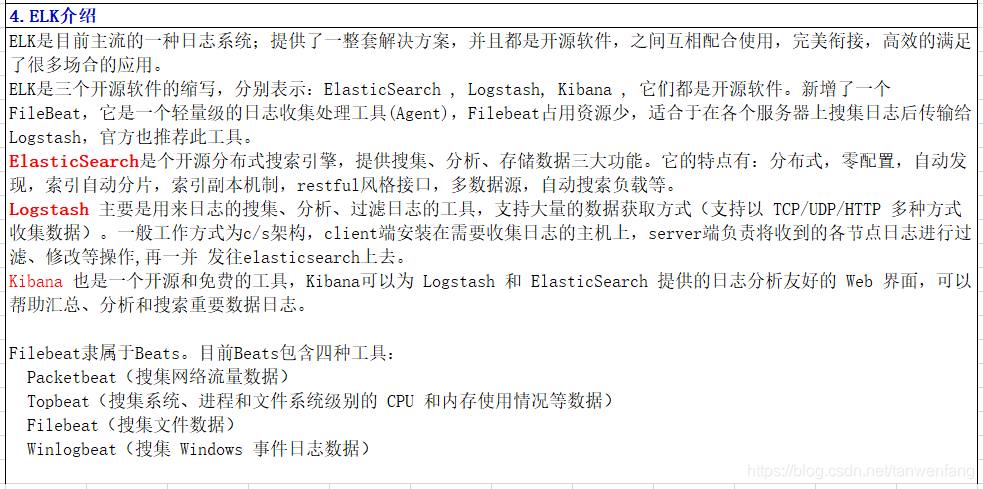

第一节,为什么要用ELK,它解决了什么问题?

第二节,ElasticSearch搭建演示

请看 微服务架构学习-进阶篇–(13-1)ElasticSearch搭建演示

第三节,logstash搭建演示

请看 微服务架构学习-进阶篇–(13-2)logstash搭建演示

第四节,kibana搭建演示

请看 微服务架构学习-进阶篇–(13-3)kibana搭建演示

第五节,spring cloud与ELK的集成演示

(1)将sleuth-consumer和sleuth-product各拷贝一份,分别重命名为sleuth-elk-consumer和sleuth-elk-product。

(2)在他们的pom文件中加入如下依赖:

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.0</version>

</dependency>

(3)修改日志文件logback.xml,如下:

<?xml version="1.0" encoding="UTF-8"?>

<!--该日志将日志级别不同的log信息保存到不同的文件中 -->

<configuration>

<include resource="org/springframework/boot/logging/logback/defaults.xml" />

<springProperty scope="context" name="springAppName"

source="spring.application.name" />

<!-- 日志在工程中的输出位置 -->

<property name="LOG_FILE" value="${BUILD_FOLDER:-build}/${springAppName}" />

<!-- 控制台的日志输出样式 -->

<property name="CONSOLE_LOG_PATTERN"

value="%clr(%d{yyyy-MM-dd HH:mm:ss.SSS}){faint} %clr(${LOG_LEVEL_PATTERN:-%5p}) %clr(${PID:- }){magenta} %clr(---){faint} %clr([%15.15t]){faint} %m%n${LOG_EXCEPTION_CONVERSION_WORD:-%wEx}}" />

<!-- 控制台输出 -->

<appender name="console" class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>INFO</level>

</filter>

<!-- 日志输出编码 -->

<encoder>

<pattern>${CONSOLE_LOG_PATTERN}</pattern>

<charset>utf8</charset>

</encoder>

</appender>

<!-- 为logstash输出的JSON格式的Appender -->

<appender name="logstash"

class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>119.3.228.85:9250</destination>

<!-- 日志输出编码 -->

<encoder

class="net.logstash.logback.encoder.LoggingEventCompositeJsonEncoder">

<providers>

<timestamp>

<timeZone>UTC</timeZone>

</timestamp>

<pattern>

<pattern>

{

"severity": "%level",

"service": "${springAppName:-}",

"trace": "%X{X-B3-TraceId:-}",

"span": "%X{X-B3-SpanId:-}",

"exportable": "%X{X-Span-Export:-}",

"pid": "${PID:-}",

"thread": "%thread",

"class": "%logger{40}",

"rest": "%message"

}

</pattern>

</pattern>

</providers>

</encoder>

</appender>

<!-- 日志输出级别 -->

<root level="DEBUG">

<appender-ref ref="console" />

<appender-ref ref="logstash" />

</root>

</configuration>

(4)启动这两个项目,以及启动elk。

(5)浏览器访问http://localhost:8113/productList。

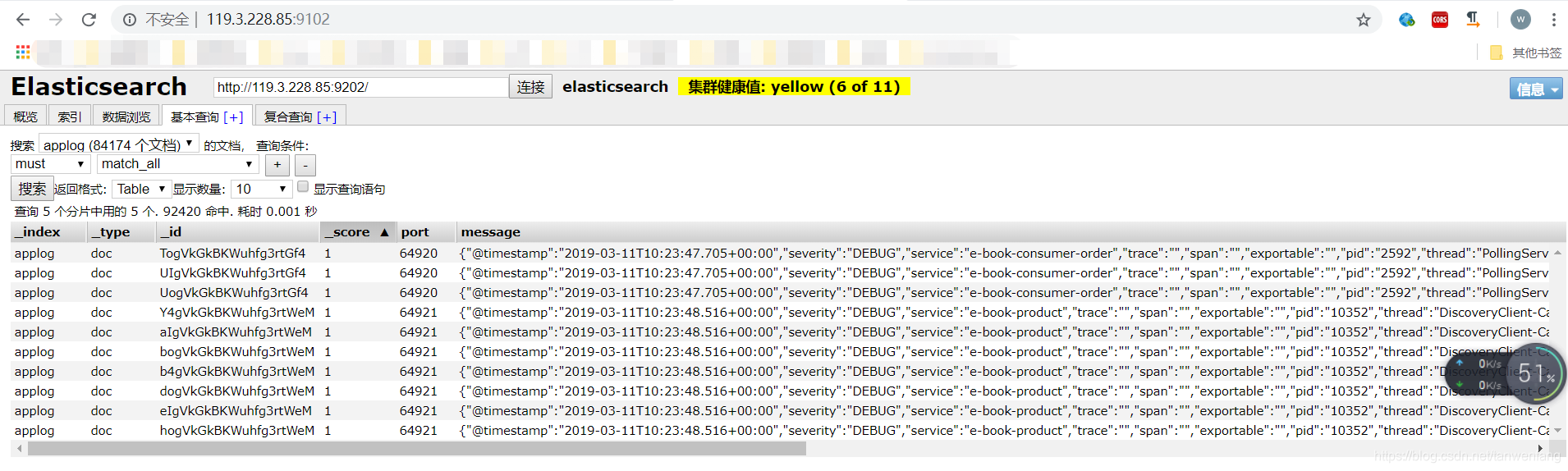

(6)访问http://119.3.228.85:9102/,点“基本查询”,选择applog–》搜索,得如下结果。

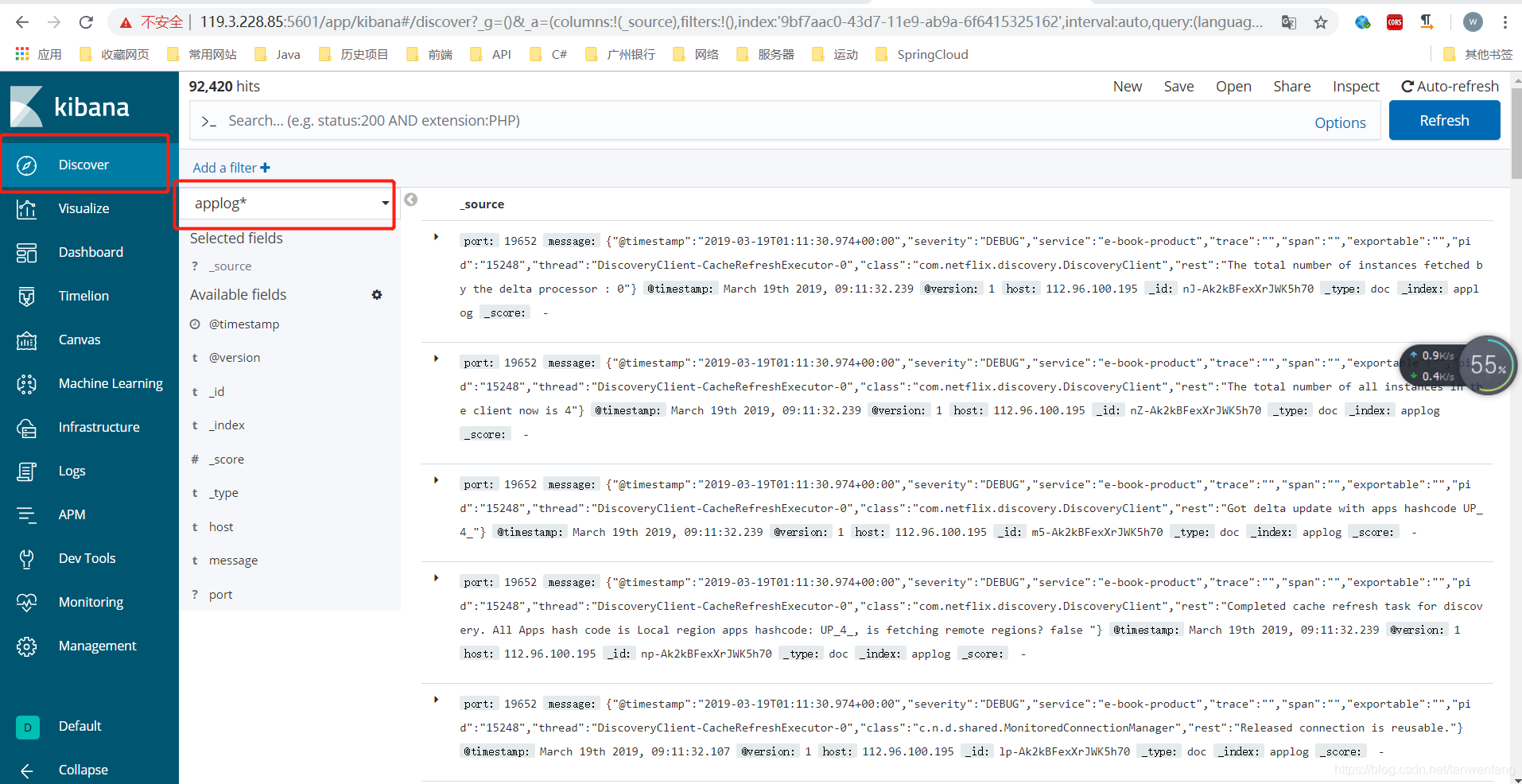

(7)访问http://119.3.228.85:5601/app/kibana。

先创建一个进行匹配得索引,比如这里建了一个applog。

在Discover部分,选择applog索引,可以在右边看到信息。

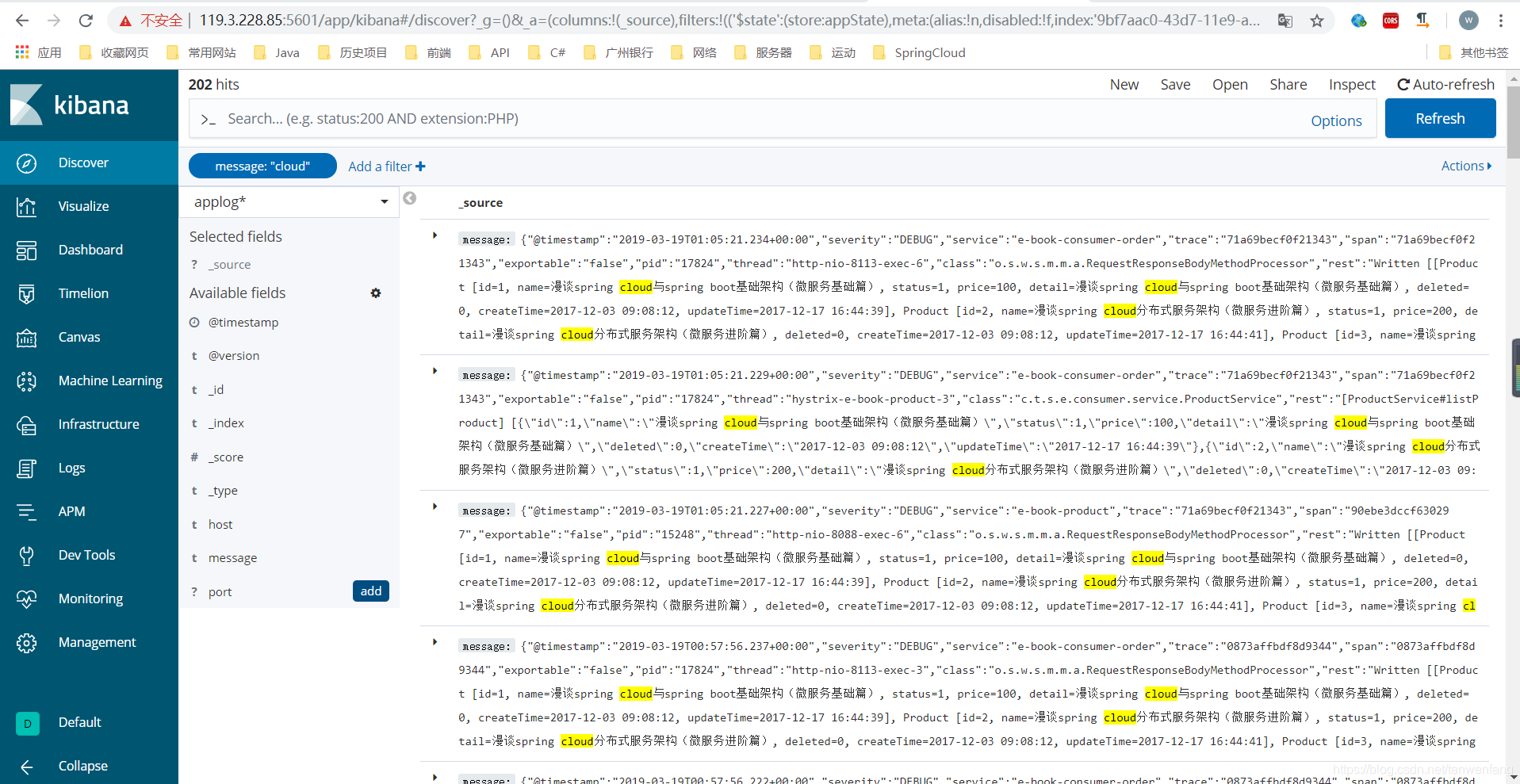

然后创建一个过滤器,选择过滤message为cloud得数据。

应用过滤器,结果如下:

从结果可以看出,日志已经到达了kibana。

(8)源码点这里。