Accurate Causal Inference on Discrete Data

这个组在因果学习尤其是离散变量因果定向方面做了很多相关的工作。本文还算是比较近的一篇。

本文提出的是一个利用信息熵和ANM模型来对两个变量的因果性进行确定的算法。这里的数据集只考虑离散数据集。

仍然沿用前面说过的ANM模型,即:

(这里的垂直符号应该是双竖线,表示独立的意思。)

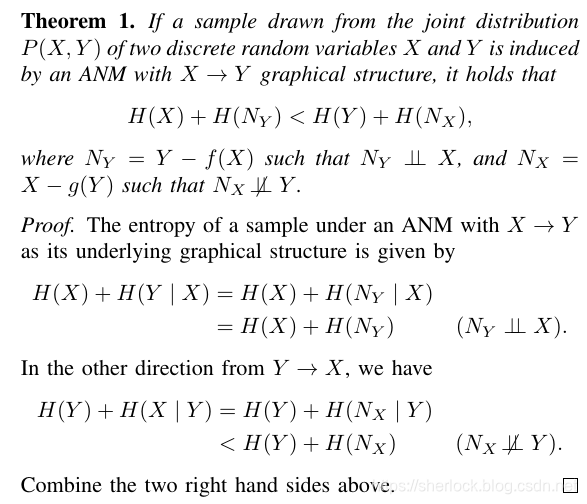

那么,如何表示X和N的独立性呢?本文采用的metric是信息熵。也就是说,如果X和N加起来信息熵比较小,那么更可能是X→

Y,反之,如果Y和N‘加起来更小,那么更可能是Y→X。文中给出了简单的证明:

有这个性质,就可以对两个变量进行定向了。定向方法就是比较信息熵的大小。

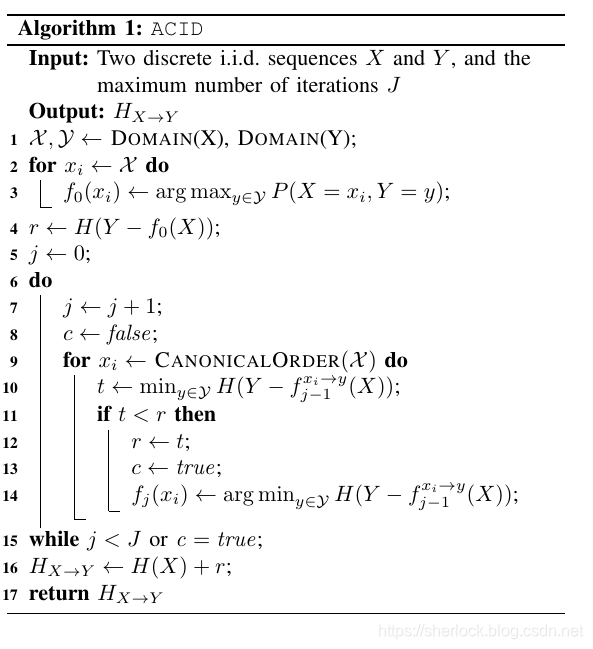

下面,关键问题就变成了如何找到这两个N和N’。换句话说,我们如何找到X到Y的映射,从而把映射的确定部分f(X)减掉,得到的残差作为N。由于是离散数据,而且没有说是线性的。所以无法利用连续数据的那种非线性回归来处理。于是,本文提出了一种启发式的算法。

首先,什么样的映射是最优的?这里文章中认为,能使residue熵最小的mapping是最优的。因此,算法实际上就是通过试验来min 这个香农熵的loss函数。最终得到f。

得到f以后,就可以计算出X的熵和N的熵之和。同样的,把X和Y互换,也能计算出这两个熵的和。比较大小,就可以确定方向了。

这个算法实际上是说,我们prefer一个熵更小的图结构。

另外,X到Y和Y到X这两种方向计算得到的H的和,如果相差越大,我们的confidence就越大,反之,如果两个差别不明显,那么置信度也就小。实际应用中,可以设一个阈值,只有超过某个值的confidence才确定,否则判断为无法确定。

2019年03月12日23:24:58