版权声明:本文为博主原创文章,如若转载请注明出处 https://blog.csdn.net/tonydz0523/article/details/87787833

newspaper包

官网:https://newspaper.readthedocs.io/en/latest/

这是一个翻译过来的简单介绍:http://hao.jobbole.com/python-newspaper/

newspaper主要用来获取新闻类信息,而且支持中文,有一些集成的对网站,网页的处理方法,还有nlp处理。

本篇使用newspaper结合jieba对新浪财经新闻进行词频统计

数据

本篇使用的是新浪财经的关于斗鱼上市的新闻:

https://finance.sina.com.cn/chanjing/gsnews/2019-02-20/doc-ihqfskcp6738832.shtml

使用

import newspaper

import re # 正则表达式库

import collections # 词频统计库

import numpy as np # numpy库

import jieba # 结巴分词

import wordcloud # 词云展示库

from PIL import Image # 图像处理库

import matplotlib.pyplot as plt # 图像展示库

newspaper相关使用,下载、解析、nlp

# 获取文章 以斗鱼上市新闻为例

article = newspaper.Article('https://finance.sina.com.cn/chanjing/gsnews/2019-02-20/doc-ihqfskcp6738832.shtml', language='zh')

# 下载文章

article.download()

# 解析文章

article.parse()

# 对文章进行nlp处理

article.nlp()

# nlp处理后的文章拼接

article_words = "".join(article.keywords)

这样就获取到了文章内容

jieba分词、筛选

seg_list_exact = jieba.cut(article_words, cut_all=False) # 精确模式分词[默认模式]

object_list = [] # 建立空列表用于存储分词结果

# 需要移出的词

remove_words = ['的', ', ', '和', '是', '随着','对于', ' ', '对', '等', '能', '都', '。', '、', '中', '与', '在', '其', '了', '可以',

'进行', '有', '更', '需要', '提供', '多', '能力', '也', '年', '通过', '会', '不同', '一个','这个', '我们', '将', '并',

'同时', '看', '如果', '但', '到', '非常','—', '如何', '包括', '这']

for word in seg_list_exact: # 迭代读出每个分词对象

if word not in remove_words: # 如果不在去除词库中

object_list.append(word) # 分词追加到列表

统计词频

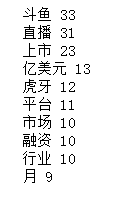

统计词频,并输出前10个词

# 词频统计

word_counts = collections.Counter(object_list) # 对分词做词频统计

word_counts_top10 = word_counts.most_common(10) # 获取前10个频率最高的词

for w, c in word_counts_top10: # 分别读出每条词和出现从次数

print(w, c) # 打印输出

结果如下:

制作词云图

根据获取的词频做词云图,背景图片自行选择

# 词频展示

mask = np.array(Image.open('timg.jpg')) # 定义词频背景

wc = wordcloud.WordCloud(

font_path='C:/Windows/Fonts/simhei.ttf', # 设置字体格式,不设置将无法显示中文

mask=mask, # 设置背景图

max_words=200, # 设置最大显示的词数

max_font_size=100 # 设置字体最大值

)

wc.generate_from_frequencies(word_counts) # 从字典生成词云

image_colors = wordcloud.ImageColorGenerator(mask) # 从背景图建立颜色方案

wc.recolor(color_func=image_colors) # 将词云颜色设置为背景图方案

plt.imshow(wc) # 显示词云

plt.axis('off') # 关闭坐标轴

plt.savefig('wordcloud.png')

plt.show() # 显示图像

大功告成,展示结果

补充:进行页面中新闻批量统计

import requests

from bs4 import BeautifulSoup

import datetime as dt

today = dt.datetime.today().strftime("%Y-%m-%d")

response = requests.get('https://finance.sina.com.cn/stock/')

html = response.content.decode('utf-8')

soup = BeautifulSoup(html, 'lxml')

all_a = soup.find_all('a')

object_list = [] # 建立空列表用于存储分词结果

remove_words = ['的', ', ', '和', '是', '随着','对于', ' ', '对', '等', '能', '都', '。', '、', '中', '与', '在', '其',

'了', '可以', '进行', '有', '更', '需要', '提供', '多', '能力', '通过', '会', '不同', '一个','这个', '我们',

'将', '并', '同时', '看', '如果', '但', '到', '非常','—', '如何', '包括', '这']

for a in all_a:

url = a['href']

if ('finance.sina.com.cn' in url)&(today in url):

article = newspaper.Article(url, language='zh')

# 下载文章

article.download()

# 解析文章

article.parse()

# 对文章进行nlp处理

article.nlp()

#

article_words = "".join(article.keywords)

seg_list_exact = jieba.cut(article_words, cut_all=False) # 精确模式分词[默认模式]

for word in seg_list_exact: # 迭代读出每个分词对象

if word not in remove_words: # 如果不在去除词库中

object_list.append(word) # 分词追加到列表

# 词频统计

word_counts = collections.Counter(object_list) # 对分词做词频统计

word_counts_top10 = word_counts.most_common(10) # 获取前10个频率最高的词

for w, c in word_counts_top10: # 分别读出每条词和出现从次数

print(w, c) # 打印输出

# 词频展示

mask = np.array(Image.open('timg.jpg')) # 定义词频背景

wc = wordcloud.WordCloud(

font_path='C:/Windows/Fonts/simhei.ttf', # 设置字体格式,不设置将无法显示中文

mask=mask, # 设置背景图

max_words=200, # 设置最大显示的词数

max_font_size=100 # 设置字体最大值

)

wc.generate_from_frequencies(word_counts) # 从字典生成词云

image_colors = wordcloud.ImageColorGenerator(mask) # 从背景图建立颜色方案

wc.recolor(color_func=image_colors) # 将词云颜色设置为背景图方案

plt.imshow(wc) # 显示词云

plt.axis('off') # 关闭坐标轴

plt.show() # 显示图像