摘要

《MobileNetV2: Inverted Residuals and Linear Bottlenecks》提出了一种新的移动端架构MobileNetV2。同时将这个移动端模型应用到了目标检测,得到了一个新框架SSDLite。此外通过Mobile DeepLabv3演示了如何构建移动端语义分割模型。

引言

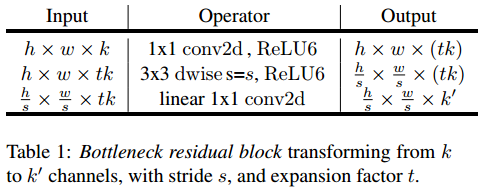

主要贡献提出了一种新颖的模块:the inverted residual with linear bottleneck。它先膨胀到高维度,然后进行轻量级的depthwise convolution,随后用一个线性卷积(不带非线性激活的卷积)将特征映射到低维表示。

细节

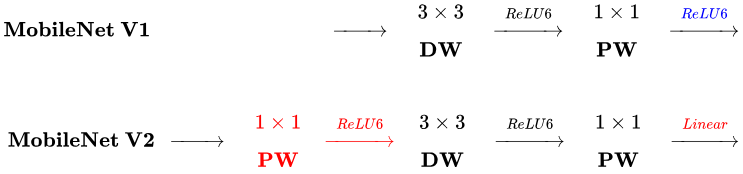

MobileNet V2与MobileNet V1的区别

- MobileNet V2在3x3 Depthwise Conv之前加入了一个可以提升维度的1x1 Conv,用于获取更多特征。

- MobileNet V2在最后使用1x1 Linear Conv,而不是带ReLU的Conv。(去掉狭窄层后面的非线性,可以维持表达能力)

Inverted residual block与Residual block的区别

- Residual block是先用1x1Conv降维,然后进行3x3 Conv,最后用1x1Conv恢复维度。Inverted residual block正好相反,先用1x1Conv升维,然后进行3x3 Depthwise Conv,最后用1x1Conv恢复维度。

- Residual block是3x3 标准的Conv,Inverted residual block是3x3 DWConv。

- Inverted residual block的1x1 Conv后面没有跟ReLU。

模块细节

We use ReLU6 as the non-linearity because of its robustness when used with low-precision computation。

与其他架构的模块对比

模型架构

实现

tensorflow实现

https://github.com/tensorflow/models/tree/master/research/slim/nets/mobilenet

caffe实现

https://github.com/shicai/MobileNet-Caffe

其他

存在的问题

摘自:https://zhuanlan.zhihu.com/p/33075914

表述前后不一致。论文里面文字描述说有19个 Bottleneck Residual Block,但是之后给出的网络结构表(论文中的Table 2)里却只列出了17个。Table 2 第五行的 stride 和第六行的输入尺寸也是矛盾的。最后一行的输入通道数应该是1280而不是k。最后似乎也没有用 Softmax,不知道是否有意为之等等。

关于性能优化不知道具体实现。论文里面提到可以将 Bottleneck Residual Block 内的运算拆成 Expansion Ratio 个分别运算,以减小运行时的内存占用,但是没细说具体怎么实现。

目前我基于 Keras/TensorFlow 按照论文给的结构尝试实现了 V2 的网络,简单测了下预测速度,不知道为什么比 V1 还要慢… 用 GTX 1050 上跑一个 Forward Pass,V1 平均只用时 11ms,而 V2 却要用 14ms。这和论文里面用 CPU 测试的性能是不符的,按理说CPU都能快50%,GPU应该也有类似的提升效果吧?不知道是我的网络问题还是论文里面使用了特殊的性能优化实现 + TensorFlow Lite 的优化加成导致的。按理说 TensorFlow 已经实现了高效的 DepthwiseConv2D,不应该存在由于 V2 比 V1 的层数多了不少且DW也多了一些而导致速度下降的可能吧?

我一直以为只要A网络比B网络的时间复杂度和空间复杂度都低,那么A网络的预测速度就一定比B网络快,但是现在的初步测试结果让我很困惑,也许是我的网络写的有问题吧… 只能期待作者能够尽快公布代码和预训练模型了。