不一定。

看模式:

client:

1.如果是client-windows:dirver在windows上执行

2.如果是client-linux: driver在spark-submit脚本

cluster:

1.如果是cluster:Master决定哪台空闲在哪台上跑

Master会让worker启动一个进程——Driver

Driver启动后会向Master请求很多资源

Master会根据需求让Worker启动多个Executor

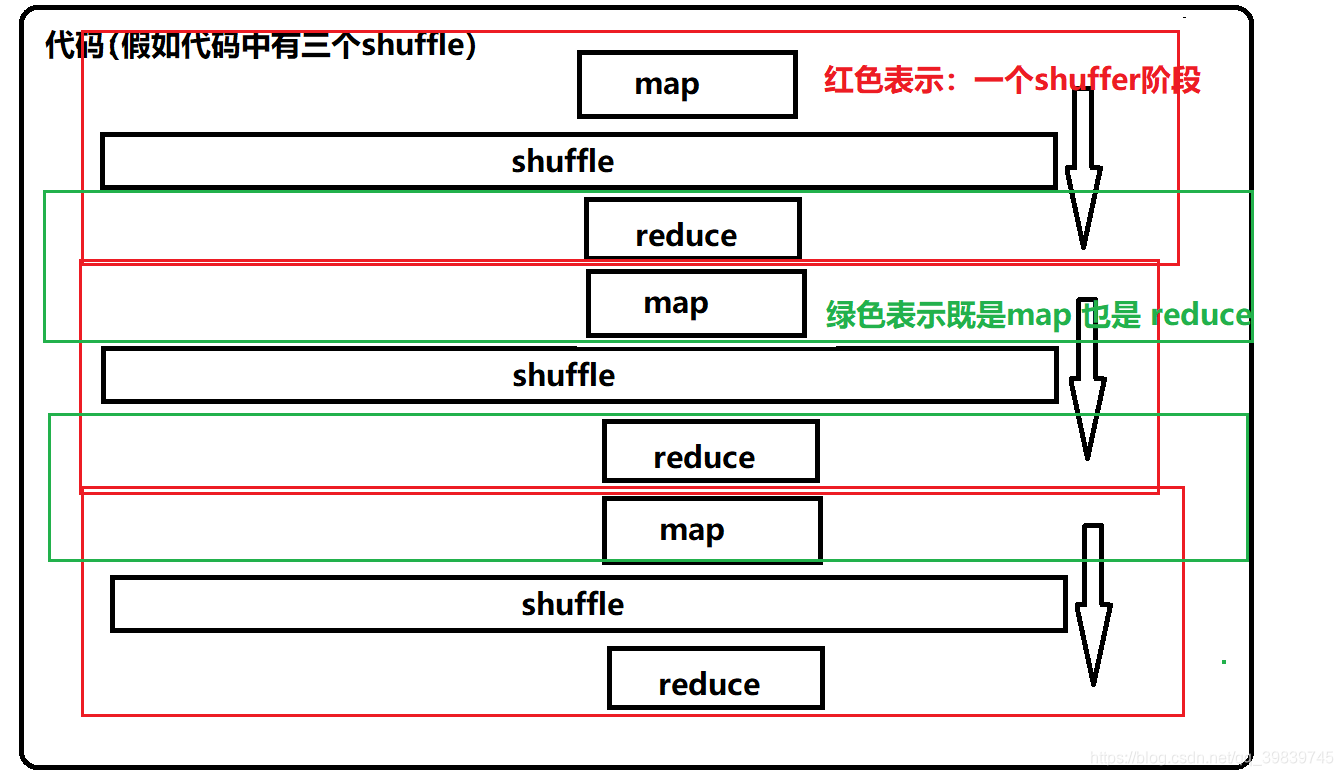

spark代码层次:

shuffle 清洗 = map+reduce