线性回归是很多机器学习机器学习算法的基础,所谓基础决定上层建筑,学好线性回归及其各种优化技巧,能为以后学习聚类乃至神经网络奠定坚实基础。

数据类型探讨

- 单变量数据:考虑的是一个变量的频数或频率,描述的对象只有一个。

- 二变量数据:对于每一个观察结果,二变量数据给出两个变量的数值—而不是一个。如果其中一个变量以某种方式受到控制,或者被用来解释另外一个变量,则这个变量被称为自变量或解释变量;另一个变量则被称为因变量或反应变量。

变量之间的相关性

- 正线性相关:随着x的增长,y也呈现出增长的趋势;

- 负线性相关:随着x的增长,y呈现下降的趋势;

- 不相关:如果x和y呈现出一个随机的模式,则我们说两者是不相关的;

两个变量之间存在着相关关系,并不意味着一个变量会影响另外一个变量,也不意味着两者存在实际的关系。

如何预测趋势

我们可以借助散点图,看出变量之间存在某种关系,可以用一条直线尽可能的接近所有的点,即使用数学或统计学的方法利用现有的数据去找出最佳的拟合曲线。

大致流程:

- 收集一组包含自变量和应变量的数据;

- 设定模型,利用数据按照某种准则计算模型中的系数;

- 利用统计方法对不同的模型进行比较,找出与数据拟合的最好的模型;

- 判断得出的模型是否适合这组数据;

- 利用模型对因变量做出预测或解释;

如何衡量拟合直线与数据的拟合度

相关系数:是一个介于-1和1之间的一个数,描述了各个数据点与直线的偏离程度。

相关概念:

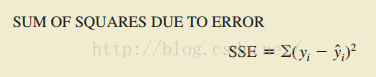

- Sum Of Squares Due To Error

对于第i个观察点, 真实数据的Yi与估算出来的Yi-head的之间的差称为第i个residual, SSE 就是所有观察点的residual的和

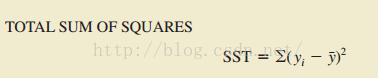

- Total Sum Of Squares

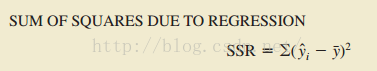

- Sum Of Squares Due To Regression

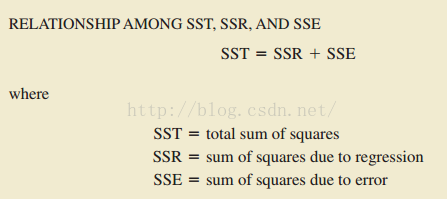

上述的三个概念通过下面这个公式联系在一起:

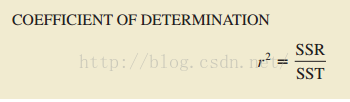

(coefficient of determination)决定系数也就是说: 通过回归方程得出的 dependent variable 有 number% 能被 independent variable 所解释. 判断拟合的程度

协方差Covariance

协方差Covariance,Cov(X,Y)=E[(X-E(X))(Y-E(Y))],观察X与其均值之差X-E(X)以及Y与其均值之差E(Y)之间的同步关系,是否X-E(X)上升,Y-E(Y)也上升,两者之间的关联。

相关公式推导:

Cov(X,Y)=E[(X-E(X))(Y-E(Y))]=E[XY-XE(Y)-YE(X)+E(X)E(Y)]

=E(XY)-E(X)E(Y)-E(X)E(Y)+E(X)E(Y)

=E(XY)-E(X)E(Y)

针对用采样样本进行估算,则有

重写regression line的斜率 ,

当中Var(X)=E[(X-E(X))2]=Cov(X,X)。