在无约束优化中,设

f(x)是凸函数。可以通过

∂f(x)=0求解,如果不能直接得到解析解,可以通过构造一个序列,

x0,x1,...,xk,使得

f(x0)>f(x1)>...>f(xk),给定一个阈值

η,当

▽f(x)<η停止。

x:=x+tΔx

(

f是凸函数,满足

f(y)≥f(x)+▽f(x)TΔx)

于是就有了

一般下降方法General Descent Method:

给定一个初始值x,

重复以下步骤:

- 确定下降方向

Δx

- 确定步长

t(1.Exact line search, 2.Backtracking line search)

- 更新

x,

x=x+tΔx

直到满足停止条件

梯度下降法,就是

Δx=−▽f(x),停止准则是

∣∣▽f(x)∣∣2≤η

下面介绍最陡下降法Steepest descent method

f(x)的一阶展开式为

f(x+v)≈f(x)+▽f(x)Tv,选择一个方向

v使

f(x+v)最小,这个方向就是最陡下降法的方向。

v大小要有一个限制,才有意义。

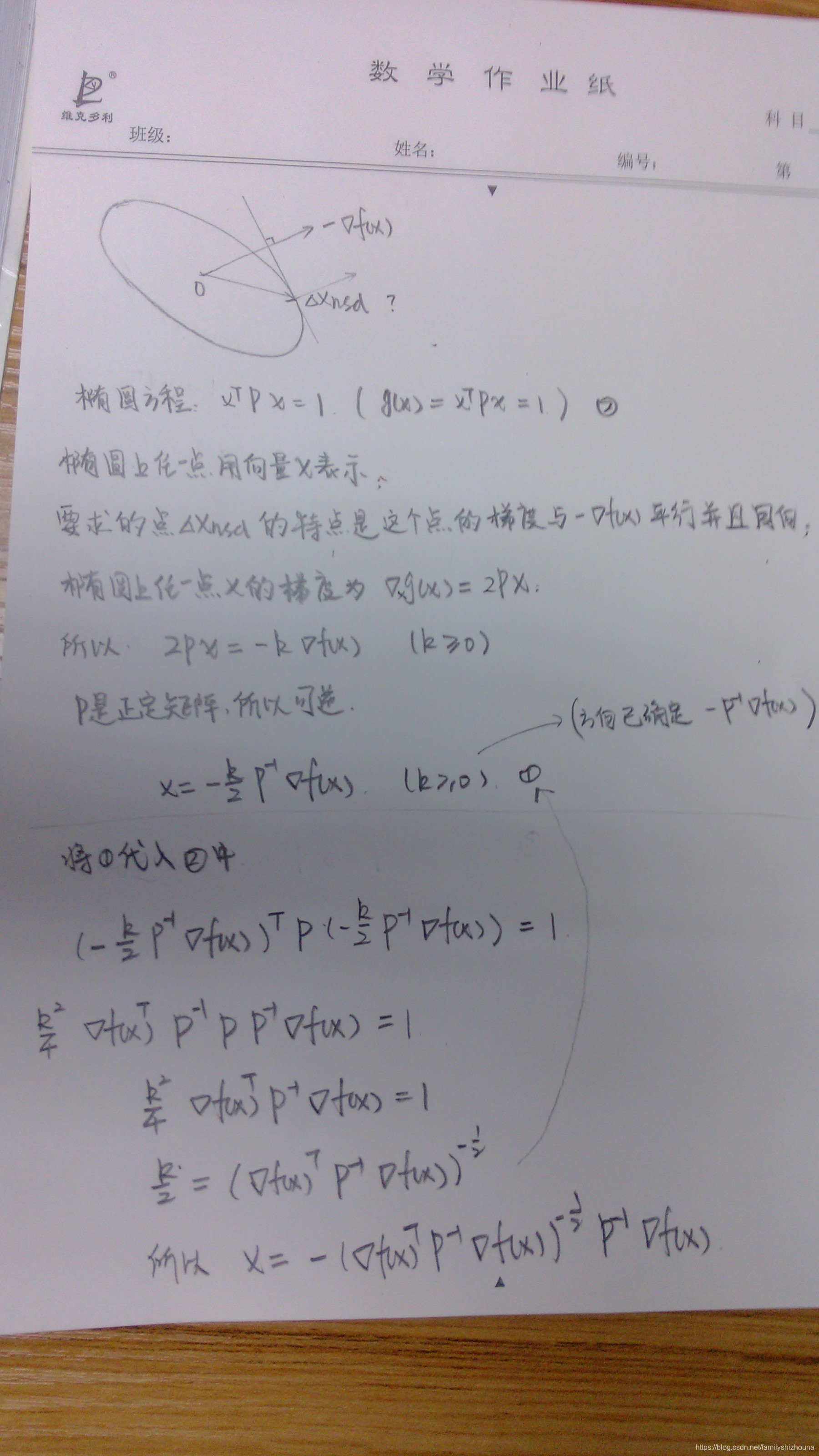

Δxnsd=argmin{▽f(x)Tv∣∣∣v∣∣≤1}

Δxsd=∣∣▽f(x)∣∣∗Δxnsd,这是最陡下降法的方向

根据范数的不同有几个不同的方向。

欧几里得范数Euclidean norm

方向就是

Δxsd=−▽f(x)

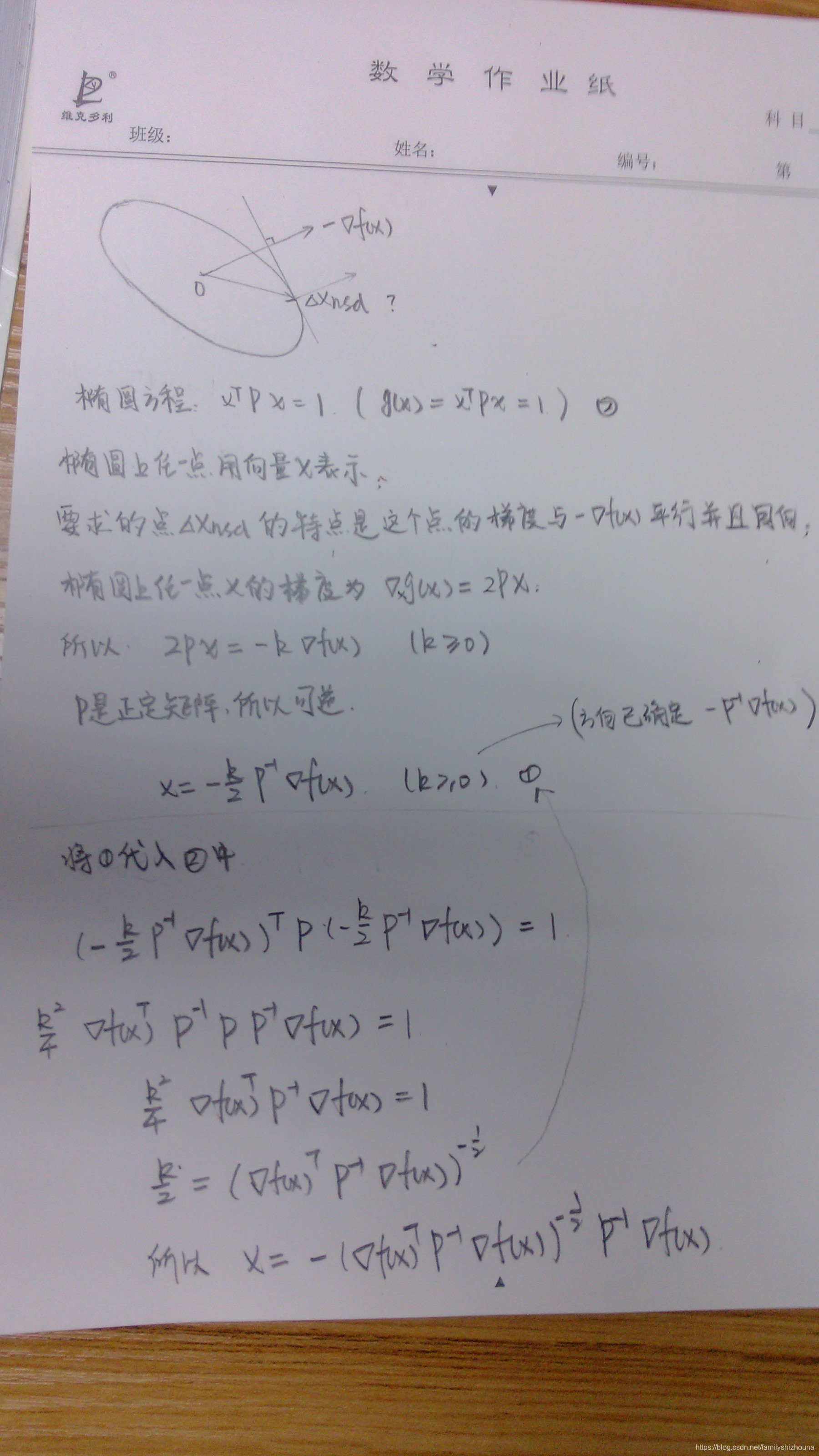

二次范数quadratic norm

方向就是

Δxsd=−P−1▽f(x),下面的图是具体怎么求这个方向的过程。

l-1范数

Δxsd=−∂xi∂f(x)ei,方向是求偏导数的那个方向。

牛顿方法就是二次范数中

P=▽2f(x),Hessian矩阵。当然也可以用泰勒二阶展开式近似,然后求倒求展开式的最小值,也可得到相同的结果。停止准则为

∣∣▽f(x)∣∣▽2f(x)≤η

latex公式大全