决策树

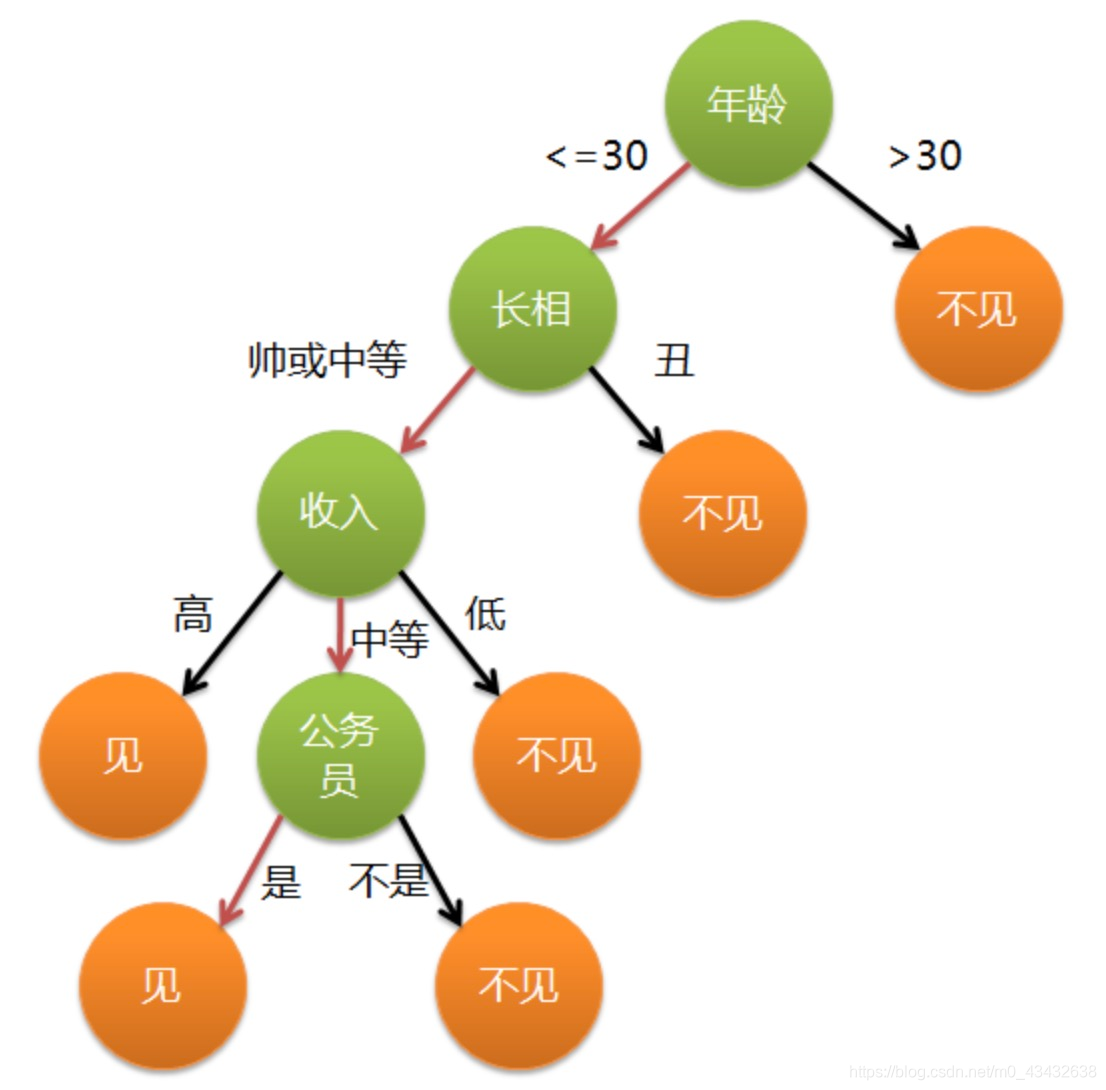

我们直观的通关这个树状图去了解一下决策树的概念,下面这个例子是姑娘相亲见不见的问题

通过上面的图我们可以看到首先这个姑娘是看相亲对象的年龄问题,当年龄大于30岁就不见,小于三十岁就见以此类推形成这个深度为5的树接下来让我们一起复习一下我们以前学过的数据结构关于树的基础知识:

通过上面的图我们可以看到首先这个姑娘是看相亲对象的年龄问题,当年龄大于30岁就不见,小于三十岁就见以此类推形成这个深度为5的树接下来让我们一起复习一下我们以前学过的数据结构关于树的基础知识:

结点:指树中的一个元素;

结点的度:指结点拥有的子树的个数,二叉树的度不大于2;

数的度:指树中的最大结点度数;

叶子:度为0的结点,也称为终端结点;

高度:叶子节点的高度为1,根节点高度最高;

层:根在第一层,以此类推

熵的引入

熵的概念: 但是需要注意的是决策树的结点的选择并不是随意的,比如先以年龄作为首选的根结点,我们需要计算信息增益:

但是需要注意的是决策树的结点的选择并不是随意的,比如先以年龄作为首选的根结点,我们需要计算信息增益:

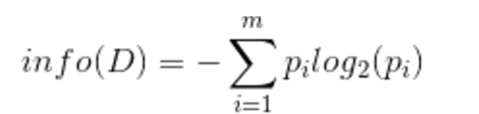

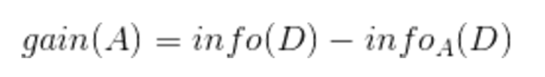

1.先计算总熵

2.其次分别计算每个属性的信息增益

先计算A对D的期望信息

再用总熵减去A对D的期望信息就得该属性的信息增益

现在小伙伴可能还不太理解一会就具体例子就会秒懂了!

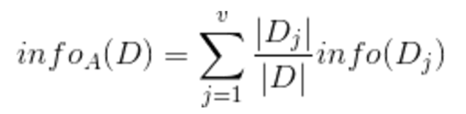

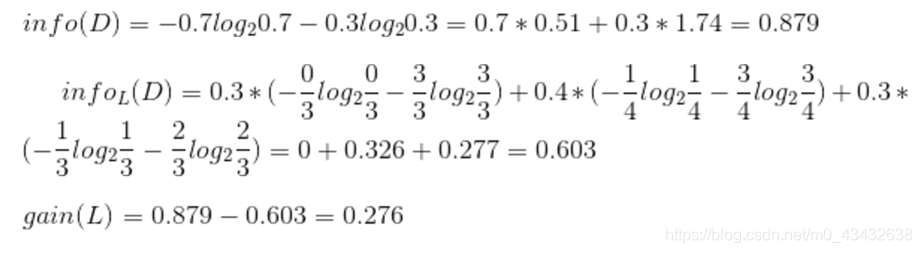

简单的说一下第二行的计算过程0.3就是对应日志密度的l所占的概率,括号里面就是利用计算总熵的那个公式计算l在yes和no的熵,我们看表可以看到l全部都是yes所以no没有为0/3,相反yes为3/3其他都是这样子算的。

简单的说一下第二行的计算过程0.3就是对应日志密度的l所占的概率,括号里面就是利用计算总熵的那个公式计算l在yes和no的熵,我们看表可以看到l全部都是yes所以no没有为0/3,相反yes为3/3其他都是这样子算的。

该计算是对日志密度进行的信息增益计算,其他属性也是一样的步骤。

最后我们选取信息增益最大的属性最为树的结点,递归下去形成一个决策树。