本篇笔记是RL学习的入门,介绍N-armed Bandit问题和解决算法。

N-armed Bandit问题

N-armed Bandit问题出自赌场中的多臂老虎机,在每一步你都有n种选择,每一个选择会给你一定的回报,目标是尽量获得最高的收益。

先定义估计值 ,即为在t步中选择a获得收益的均值。

解决方法分为两类,exploitation和exploration方法。

Exploitation

Greedy方法就是每次取估计值最大的选择,好处是简单,坏处是由于估计值与真实值不相等,所以往往选择的是次优的选择,而且greedy方法没有跳出机制,即会一直困在当前次优选择上,无法选择到最优值。

Exploration

我们将greedy结合一个跳出的机制,即为

方法,每次以

的概率取估计值最大的选择,以

的概率随机取一个选择。当时间足够长的时候,这种方法表现会比greedy要好。

较大时收敛较快,但收敛的值会稍小于optimal value,较小时收敛较慢,但收敛的值会更趋近于optimal value。

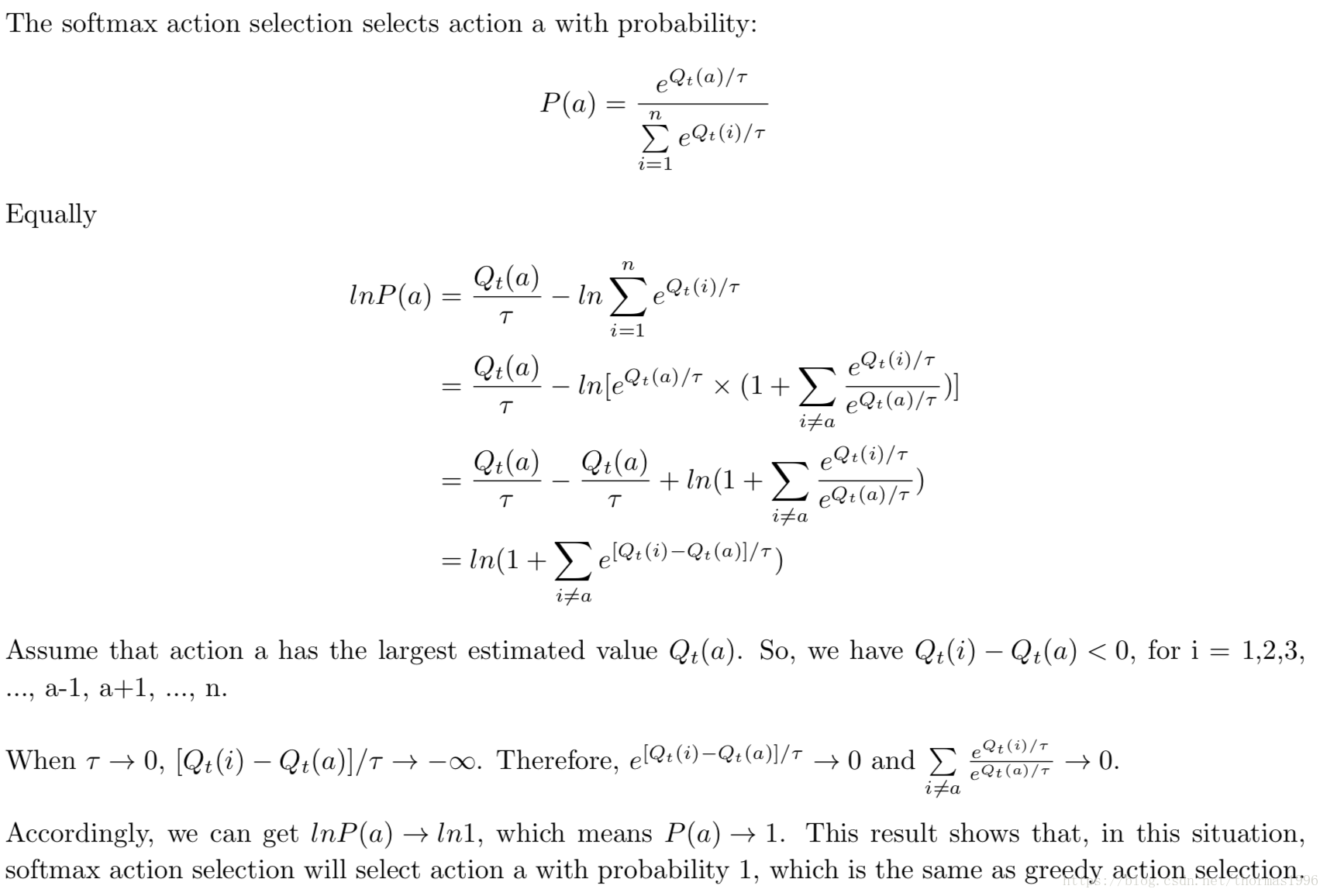

另一种结合Exploitation和Exploration的是softmax方法。在t步选择a的概率为

当

趋近1时,softmax变为随机等概率选择;当

趋近0时,softmax变为greedy选择。

证明

趋近0时,softmax变为greedy选择:

softmax和 好坏取决于具体情况。

其他还有很多种方法,例如UCB等等,具体不详细介绍了。