https://arxiv.org/pdf/1711.06396.pdf https://github.com/jeasinema/VoxelNet-tensorflow

摘要

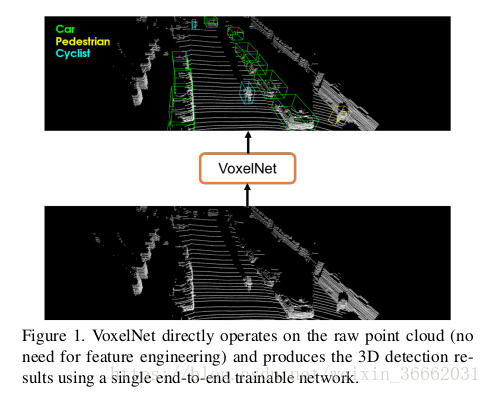

3D点云中物体的精确检测是许多应用中的一个核心问题,如自主导航、室内机器人和增强/虚拟现实。为了将高度稀疏的激光雷达点云与区域建议网络(RPN)进行接口,大多数现有的努力都集中在手工制作的特征表示上,例如,鸟瞰投影。在这项工作中,我们不需要人工特征工程的3D点云,并提出VoxelNet,一个通用的3D检测网络,统一特征提取和包围盒预测到一个阶段,端到端可训练的深网络。具体而言,VoxelNet将点云划分为等间距的三维体素,并通过新引入的体素特征编码(VFE)层将每个体素中的一组点变换为统一的特征表示。以这种方式,点云被编码为描述性的体积表示,然后将其连接到RPN以产生检测。KITTI车辆检测基准的实验表明,VoxelNe比现有的基于LIDAR的3D检测方法大幅度地优于现有的基于LIDAR的3D检测方法。此外,我们的网络学习一个有效的歧视性表示的对象具有不同的几何形状,导致令人鼓舞的结果,在3D检测行人和骑自行车者,仅基于激光雷达。

介绍

基于点云的3D物体检测是各种真实世界应用的一个重要组成部分,如自主导航(11, 14)、管家机器人(26)和增强/虚拟现实(27)。与基于图像的检测相比,激光雷达提供可靠的深度信息,可以用于精确定位物体并表征它们的形状[21, 5 ]。然而,与图像不同的是,激光雷达点云稀疏且具有高度可变的点密度,这是由于3D空间的非均匀采样、传感器的有效范围、遮挡和相对姿态等因素造成的。为了应对这些挑战,许多方法手工制作用于三维物体检测的点云的特征表示。几种方法将点云投影到透视图中,并应用基于图像的特征提取技术[28, 15, 22 ]。其他方法将点云光栅化为3D体素网格,并用手工制作的特征编码每个体素〔41, 9, 37,38, 21, 5〕。然而,这些手动设计选择引入了一个信息瓶颈,阻止这些方法有效地利用3D形状信息和检测任务所需的不变性。在图像识别(20)和检测(13)任务上的重大突破是由于从手工制作的特征到机器学习的特征。

区域建议网络(RPN)[32 ]是一种高度有效的目标检测算法[17, 5,31,24]。然而,这种方法需要数据密集和组织在张量结构(例如,图像,视频),这不是典型的激光雷达点云的情况。在本文中,我们关闭了点集特征学习和RPN之间的差距3D检测任务。

我们提出了一个通用的3D检测框架VoxelNETE,它同时学习点云的判别特征表示,并以端到端的方式预测精确的3D包围盒,如图2所示。我们设计了一种新的体素特征编码(VFE)层,它能够在体素中实现点间交互,通过将点特征与局部聚集特征相结合。 堆叠多个VFE层允许学习复杂特征以表征局部3D形状信息。具体而言,VoxelNet将点云划分为等间距的三维体素,通过堆叠的VFE层编码每个体素,然后3D卷积进一步聚集局部体素特征,将点云转换为高维体积表示。最后,RPN消耗体积表示并产生检测结果。这种有效的算法既有利于稀疏点结构,又有利于体素网格的有效并行处理。

我们评估VoelLeNET在鸟瞰视图检测和完整的3D检测任务,由KITTI基准(11)提供。实验结果表明,VoxelNET:大大优于现有的基于激光雷达的3D检测方法。我们还证明,VoxelNETs在激光雷达点云检测行人和骑自行车者方面取得了非常令人鼓舞的结果。

1.1. Related Work

3D传感器技术的快速发展促使研究者开发有效的表示来检测和定位点云中的物体。用于特征表示的早期方法中有一些是[39, 8, 7,19, 40,33,6,25, 1, 34,2 ]。当丰富和详细的3D形状信息可用时,这些手工制作的特征会产生令人满意的结果。然而,它们无法适应更复杂的形状和场景,并且从数据中学习所需的不变性,从而导致不受控制的场景(例如自主导航)的有限成功。

考虑到图像提供了详细的纹理信息,许多算法从2D图像推断出3D包围盒〔4, 3, 42,43, 44, 36〕。然而,基于图像的3D检测方法的精度受到深度估计精度的限制。

一些基于激光雷达的3D物体检测技术利用体素网格表示。〔41, 9〕用从体素中包含的所有点导出的6个统计量来编码每个非空体素。〔37〕融合多个局部统计数据来表示每个体素。〔38〕计算体素网格上的截断符号距离。〔21〕使用三维体素网格的二进制编码。〔5〕通过在鸟瞰图中计算多通道特征图和在正面视图中的圆柱坐标,介绍了一种激光雷达点云的多视图表示方法。其他一些研究将点云投影到透视图上,然后使用基于图像的特征编码方案〔28, 15, 22〕。

还存在多种结合图像和激光雷达的多模态融合方法以提高检测精度[10, 16, 5 ]。这些方法与仅激光雷达的3D检测相比,提供了改进的性能,特别是对于小物体(行人、骑自行车者)或物体远时,因为摄像机提供比激光雷达更大数量级的测量。然而,需要与激光雷达进行时间同步和校准的附加摄像机限制了它们的使用,并且使得该解决方案对传感器故障模式更加敏感。在这项工作中,我们专注于激光雷达仅检测。

1.2. Contributions

我们提出了一种新的端到端可训练的深架构,基于点云的3D检测,VoxelNet,直接操作在稀疏的3D点,并避免信息瓶颈由手动特征工程引入。

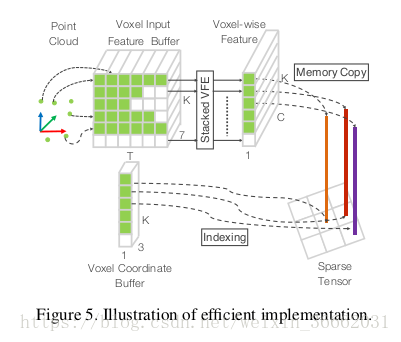

我们提出了一种有效的实现VoxelNETs的方法,它既有利于稀疏点结构,又有利于体素网格上的高效并行处理。

我们在KITTI基准上进行实验,并表明VoxelNETs在基于激光雷达的汽车、行人和骑自行车检测基准中产生了最先进的结果。

2. VoxelNet

在这一节中,我们解释了VoxelNETs的架构,用于训练的损失函数,以及实现网络的有效算法。

2.1. VoxelNet Architecture

所提出的VoxelNetwork由三个功能块组成:(1)特征学习网络,(2)卷积中间层,和(3)区域建议网络[32 ],如图2所示。我们在下面的章节中详细介绍了VoxelNET.

2.1.1 Feature Learning Network

体素划分给定点云,我们将3D空间细分成等距的体素,如图2所示。假设点云包含沿z、y、x轴分别具有d、h、w的三维空间。我们定义每个体素的大小V D,V H,和V W相应。得到的三维体素网格大小为D=D/V D,H=H/V H,W=W/V W。这里,为了简单起见,我们假设D、H、W是V D、V H、V W的倍数。

分组我们根据它们驻留的体素来分组点。由于距离、遮挡、物体相对姿态和非均匀采样等因素,激光雷达点云稀疏,在整个空间中具有高度可变的点密度。因此,在分组之后,体素将包含可变数量的点。图2显示了一个例子,其中Voxel-1比Voxel-2和Voxel-4具有更多的点,而Voxel-3不包含任何点。

随机抽样典型地,高分辨率激光雷达点云由100K点组成。直接处理所有的点不仅增加了计算平台上的内存/效率负担,而且在整个空间中高度可变的点密度可能会偏置检测。为此,我们随机地从包含多于T点的体素随机采样固定点T。该采样策略有两个目的,(1)计算节省(参见细节2.3节);和2)减少体素之间的点的不平衡,减少采样偏倚,并且增加训练的变化。

堆叠体素特征编码关键的创新是VFE层的链。为了简单起见,图2示出了一个体素的分层特征编码过程。在不损失一般性的情况下,我们使用VFE层-1来描述下面段落中的细节。图3显示了VFE层-1的体系结构。

表示V={P i=[x i,y i,z i,r i] t r r 4 } i=1…t作为含有t个t激光雷达点的非空体素,其中p i包含第i个点的XYZ坐标,R i是接收的反射率。我们首先计算局部均值作为V中的所有点的质心,表示为(v x,v y,v z)。然后用相对偏移W.R.T.质心得到每个点P i,得到输入特征集V={πi=[x i,y i,z i,r i,x i i,v x,y i i v y,z i v z z ] t r r 7 } i=1…t。接着,i通过全连通网络将每个P(FCN)变换为特征空间,在这里我们可以从点特征f i r m集合信息来编码包含在体素中的表面的形状。FCN由线性层、批量归一化(BN)层和整流线性单元(Relu)层组成。在获得逐点特征表示之后,我们使用元素相关的最大池遍历所有与V相关的f i以获得局部聚合特征f fm m。最后,我们用f来增加每个f i以形成点i级联特征,如f i out=[f i t,f ft] tr r2m。 . 因此,我们得到输出特征集V out={F I out } I…t。所有非空体素以相同的方式编码,并且它们在FCN中共享相同的参数集。

我们使用VFE-I(C in,C out)来表示将维度C的输入特征转换为维度C out的输出特征的第i个VFE层。线性层在C(C out/2)中学习大小C的矩阵,逐点级联产生尺寸C out的输出。

由于输出特征结合了点特征和局部聚集特征,堆叠VFE层编码体素内的点相互作用,并且使得最终特征表示能够学习描述性形状信息。体素明智的特征是通过将VFE-N的输出通过FCN转换成R C,并应用元素Max池,其中C是体素特征的维度,如图2所示。

稀疏张量表示通过只处理非空体素,我们得到体素特征的列表,每个体素与特定的非空体素的空间坐标唯一相关。获得的体素特征列表可以表示为一个稀疏的4D张量,大小为C×D××H×W,如图2所示。虽然点云包含100K点,但超过90%的体素通常是空的。表示非空体素特征作为稀疏张量极大地减少了在反向传播期间的内存使用和计算成本,并且它是我们高效实现的关键步骤。

2.1.2 Convolutional Middle Layers

2.1.3 Region Proposal Network

2.2. Loss Function

2.3. Efficient Implementation

3. Training Details

3.1. Network Details

Car Detection

Pedestrian and Cyclist Detection

3.2. Data Augmentation

4. Experiments

在KITTI 3D目标检测基准(11)中,我们对VoxelNETs进行了评估,其中包含7481个训练图像/点云和7518个测试图像/点云,覆盖了三类:汽车、行人和骑自行车的人。对于每一类,检测结果基于三个难度级别:容易、适度和硬来评估,这是根据对象大小、遮挡状态和截断级别确定的。由于测试集的真实性是不可用的,并且对测试服务器的访问是有限的,所以我们使用[4, 3, 5 ]中描述的协议进行综合评估,并将训练数据细分为训练集和验证集,从而产生TRAI的3712个数据样本。宁和3769个数据样本进行验证。分裂避免了来自相同序列的样本被包含在训练和验证集(3)中。最后,我们还提出了使用KITTI服务器的测试结果。

对于CARS类别,我们将所提出的方法与几种最先进的算法进行比较,包括基于图像的方法:MUN3D(3)和3DOP(4);基于LIDAR的方法:VeloFCN(22)和3D-FCN(21);以及多模态方法MV[5 ]。MUN3D(3)、3DOP(4)和MV(5)使用预先训练的模型进行初始化,而我们只使用KITTI中提供的激光雷达数据从头开始训练VoxelNET.

为了分析端到端学习的重要性,我们实现了来自VoxelNETS架构的强基线,但是使用手工制作的特征而不是所提出的特征学习网络。我们称这个模型为手工制作的基线(HC基线)。HC基线使用在[1]中描述的鸟瞰图特征,其特征是以0.1m分辨率计算。与〔5〕不同,我们将高度通道的数目从4增加到16,以捕获更详细的形状信息-进一步增加高度通道的数量并不能导致性能改善。我们用类似大小的2D卷积层代替卷积中间层的VoxelNETs,这是VAR2D(16, 32, 3,1, 1),VAR2D(32, 64, 3,2, 1),VAR2D(64, 128, 3,1, 1)。最后,RPN在VoxelNet和HC基线上是相同的。HC基线和VoxelNet中的参数的总数非常相似。我们使用相同的训练程序和第3节中描述的数据增强训练HC基线。

4.1. Evaluation on KITTI Validation Set

Metrics

我们遵循官方KITTI评估协议,其中IOU阈值为0.7级车,是0.5级的行人和骑自行车。IOU阈值对于鸟瞰图和全3D评价是相同的。我们使用平均精度(AP)度量的方法进行比较。

Evaluation in Bird’s Eye View

表1所示。VoxelNET始终优于所有竞争的方法在所有三个难度级。HC-BASIC也取得了令人满意的性能相比,国家的最先进的[ 5 ],这表明我们的基础区域建议网络(RPN)是有效的。对于行人和骑自行车的检测任务,在鸟瞰图中,我们比较建议的VoxelNET与HC基线。对于这些更具挑战性的类别,VoxelNE比HC基线产生更高的AP,这表明端到端学习对于基于点云的检测是必不可少的。

我们要注意的是,[21 ]分别报告了88.9%、77.3%和72.7%的容易、中等和硬水平,但是这些结果是基于6000个训练帧和1500个验证帧的不同分割得到的,并且它们与表1中的算法没有直接的可比性。因此,我们不将这些结果包含在表中。

与仅需要精确定位2D平面中的物体的鸟瞰检测相比,3D检测是一个更具挑战性的任务,因为它需要在3D空间中更精细地定位形状。表2总结了比较。对于类车来说,VoxelNETs在所有难度级别上都显著优于AP中的所有其他方法。特别地,仅使用激光雷达,VoxelNETs显著地优于基于LIDAR +RGB的最新的方法MV(BV+FV+RGB)[5 ],分别在容易、中等和硬水平分别为10.68%、2.78%和6.29%。HC基线达到MV〔5〕方法的相似精度。

在鸟瞰评价中,我们还比较了3D行人和骑自行车检测中的Vox和HC基线。由于3D姿态和形状的高变化,这两个类别的成功检测需要更好的3D形状表示。如表2所示,VoxelNETs的改进性能强调了更具挑战性的3D检测任务(从鸟瞰图的8%改进到3D检测的12%改进),这表明VoxelNet比手工制作的特征更有效地捕获3D形状信息。物件。

4.2. Evaluation on KITTI Test Set

我们通过向官方服务器提交检测结果来评估KoTI测试集上的VoxelNET.结果汇总在表3中。VoxelNet,在所有的任务(鸟瞰图和3D检测)和所有的困难中,显著优于先前公布的最先进的[ 5 ]。我们要注意的是,在KITTI基准中列出的许多其他主要方法都使用RGB图像和激光雷达点云,而VoxelNETs仅使用激光雷达。

我们在图6中给出了几个3D检测实例,为了更好的可视化,使用激光雷达探测到的3D盒子被投影到RGB图像上。如图所示,VoxelNETE在所有类别中提供高度精确的3D包围盒。

Voxelnet的推理时间为225ms,体素输入特征计算为5ms,特征学习网为20ms,卷积中间层为170ms,区域建议网在Tyxx GPU和1.7GHz CPU上采用30ms。

5. Conclusion

大多数现有的基于激光雷达的3D检测方法依赖于手工制作的特征表示,例如,鸟瞰投影。在本文中,我们去除了人工特征工程的瓶颈,并提出了一种基于点云的3D检测的端到端可训练的深层结构VoxelNet。我们的方法可以直接操作在稀疏的3D点,并有效地捕获3D形状信息。我们还提出了一个有效的实现VoxelNET-受益于点云稀疏和并行处理的体素网格。我们的KITTI车检测任务的实验表明,VoxelNETs远远优于现有的最先进的基于激光雷达的3D检测方法。在更具挑战性的任务,如行人和骑自行车者的3D检测,VoxelNet也展示了令人鼓舞的结果表明,它提供了更好的3D表示。未来的工作包括扩展用于联合激光雷达和基于图像的端到端3D检测的VoxelNETE,以进一步提高检测和定位精度。

Acknowledgement: We are grateful to our colleagues Russ Webb, Barry Theobald, and Jerremy Holland for their

valuable input.

References

[1] P. Bariya and K. Nishino. Scale-hierarchical 3d object recog-

nition in cluttered scenes. In 2010 IEEE Computer Soci-

ety Conference on Computer Vision and Pattern Recognition,

pages 1657–1664, 2010. 2

[2] L. Bo, X. Ren, and D. Fox. Depth Kernel Descriptors for

Object Recognition. In IROS, September 2011. 2

[3] X. Chen, K. Kundu, Z. Zhang, H. Ma, S. Fidler, and R. Urta-

sun. Monocular 3d object detection for autonomous driving.

In IEEE CVPR, 2016. 2, 5, 6, 7

[4] X. Chen, K. Kundu, Y. Zhu, A. Berneshawi, H. Ma, S. Fidler,

and R. Urtasun. 3d object proposals for accurate object class

detection. In NIPS, 2015. 2, 5, 6, 7

[5] X. Chen, H. Ma, J. Wan, B. Li, and T. Xia. Multi-view 3d

object detection network for autonomous driving. In IEEE

CVPR, 2017. 1, 2, 3, 4, 5, 6, 7, 8

[6] C. Choi, Y. Taguchi, O. Tuzel, M. Y. Liu, and S. Rama-

lingam. Voting-based pose estimation for robotic assembly

using a 3d sensor. In 2012 IEEE International Conference

on Robotics and Automation, pages 1724–1731, 2012. 2

[7] C. S. Chua and R. Jarvis. Point signatures: A new repre-

sentation for 3d object recognition. International Journal of

Computer Vision, 25(1):63–85, Oct 1997. 2

[8] C. Dorai and A. K. Jain. Cosmos-a representation scheme for

3d free-form objects. IEEE Transactions on Pattern Analysis

and Machine Intelligence, 19(10):1115–1130, 1997. 2

[9] M. Engelcke, D. Rao, D. Z. Wang, C. H. Tong, and I. Posner.

Vote3deep: Fast object detection in 3d point clouds using

efficient convolutional neural networks. In 2017 IEEE In-

ternational Conference on Robotics and Automation (ICRA),

pages 1355–1361, May 2017. 1, 2

[10] M. Enzweiler and D. M. Gavrila. A multilevel mixture-of-

experts framework for pedestrian classification. IEEE Trans-

actions on Image Processing, 20(10):2967–2979, Oct 2011.

3

[11] A. Geiger, P. Lenz, and R. Urtasun. Are we ready for au-

tonomous driving? the kitti vision benchmark suite. In

Conference on Computer Vision and Pattern Recognition

(CVPR), 2012. 1, 2, 5, 6

[12] R. Girshick. Fast r-cnn. In Proceedings of the 2015 IEEE

International Conference on Computer Vision (ICCV), ICCV

’15, 2015. 5, 6

[13] R. Girshick, J. Donahue, T. Darrell, and J. Malik. Rich fea-

ture hierarchies for accurate object detection and semantic

segmentation. In Proceedings of the IEEE conference on

computer vision and pattern recognition, pages 580–587,

2014. 1

[14] R. Gomez-Ojeda, J. Briales, and J. Gonzalez-Jimenez. Pl-

svo: Semi-direct monocular visual odometry by combining

points and line segments. In 2016 IEEE/RSJ International

Conference on Intelligent Robots and Systems (IROS), pages

4211–4216, Oct 2016. 1

[15] A. Gonzalez, G. Villalonga, J. Xu, D. Vazquez, J. Amores,

and A. Lopez. Multiview random forest of local experts com-

bining rgb and lidar data for pedestrian detection. In IEEE

Intelligent Vehicles Symposium (IV), 2015. 1, 2

[16] A. Gonzlez, D. Vzquez, A. M. Lpez, and J. Amores. On-

board object detection: Multicue, multimodal, and multiview

random forest of local experts. IEEE Transactions on Cyber-

netics, 47(11):3980–3990, Nov 2017. 3

[17] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning

for image recognition. In 2016 IEEE Conference on Com-

puter Vision and Pattern Recognition (CVPR), pages 770–

778, June 2016. 2, 6

[18] A. G. Howard. Some improvements on deep convolu-

tional neural network based image classification. CoRR,

abs/1312.5402, 2013. 6

[19] A. E. Johnson and M. Hebert. Using spin images for efficient

object recognition in cluttered 3d scenes. IEEE Transactions

on Pattern Analysis and Machine Intelligence, 21(5):433–

449, 1999. 2

[20] A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet

classification with deep convolutional neural networks. In

F. Pereira, C. J. C. Burges, L. Bottou, and K. Q. Weinberger,

editors, Advances in Neural Information Processing Systems

25, pages 1097–1105. Curran Associates, Inc., 2012. 1, 6

[21] B. Li. 3d fully convolutional network for vehicle detection

in point cloud. In IROS, 2017. 1, 2, 5, 7

[22] B. Li, T. Zhang, and T. Xia. Vehicle detection from 3d lidar

using fully convolutional network. In Robotics: Science and

Systems, 2016. 1, 2, 5, 7

[23] T. Lin, P. Goyal, R. B. Girshick, K. He, and P. Doll ́ar. Focal

loss for dense object detection. IEEE ICCV, 2017. 4

[24] W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C.-Y.

Fu, and A. C. Berg. Ssd: Single shot multibox detector. In

ECCV, pages 21–37, 2016. 2

[25] A. Mian, M. Bennamoun, and R. Owens. On the repeata-

bility and quality of keypoints for local feature-based 3d ob-

ject retrieval from cluttered scenes. International Journal of

Computer Vision, 89(2):348–361, Sep 2010. 2

[26] Y.-J. Oh and Y. Watanabe. Development of small robot for

home floor cleaning. In Proceedings of the 41st SICE Annual

Conference. SICE 2002., volume 5, pages 3222–3223 vol.5,

Aug 2002. 1

[27] Y. Park, V. Lepetit, and W. Woo. Multiple 3d object tracking

for augmented reality. In 2008 7th IEEE/ACM International

Symposium on Mixed and Augmented Reality, pages 117–

120, Sept 2008. 1

[28] C. Premebida, J. Carreira, J. Batista, and U. Nunes. Pedes-

trian detection combining RGB and dense LIDAR data. In

IROS, pages 0–1. IEEE, Sep 2014. 1, 2

[29] C. R. Qi, H. Su, K. Mo, and L. J. Guibas. Pointnet: Deep

learning on point sets for 3d classification and segmentation.

Proc. Computer Vision and Pattern Recognition (CVPR),

IEEE, 2017. 1

[30] C. R. Qi, L. Yi, H. Su, and L. J. Guibas. Pointnet++: Deep

hierarchical feature learning on point sets in a metric space.

arXiv preprint arXiv:1706.02413, 2017. 1

[31] J. Redmon and A. Farhadi. YOLO9000: better, faster,

stronger. In IEEE Conference on Computer Vision and Pat-

tern Recognition (CVPR), 2017. 2

[32] S. Ren, K. He, R. Girshick, and J. Sun. Faster r-cnn: To-

wards real-time object detection with region proposal net-

works. In Advances in Neural Information Processing Sys-

tems 28, pages 91–99. 2015. 2, 3, 4, 5

[33] R. B. Rusu, N. Blodow, and M. Beetz. Fast point feature

histograms (fpfh) for 3d registration. In 2009 IEEE Interna-

tional Conference on Robotics and Automation, pages 3212–

3217, 2009. 2

[34] J. Shotton, A. Fitzgibbon, M. Cook, T. Sharp, M. Finoc-

chio, R. Moore, A. Kipman, and A. Blake. Real-time human

pose recognition in parts from single depth images. In CVPR

2011, pages 1297–1304, 2011. 2

[35] K. Simonyan and A. Zisserman. Very deep convolu-

tional networks for large-scale image recognition. CoRR,

abs/1409.1556, 2014. 6

[36] S. Song and M. Chandraker. Joint sfm and detection cues for

monocular 3d localization in road scenes. In IEEE Confer-

ence on Computer Vision and Pattern Recognition (CVPR),

pages 3734–3742, June 2015. 2

[37] S. Song and J. Xiao. Sliding shapes for 3d object detection in

depth images. In European Conference on Computer Vision,

Proceedings, pages 634–651, Cham, 2014. Springer Interna-

tional Publishing. 1, 2

[38] S. Song and J. Xiao. Deep Sliding Shapes for amodal 3D

object detection in RGB-D images. In CVPR, 2016. 1, 2, 4,

5

[39] F. Stein and G. Medioni. Structural indexing: efficient 3-d

object recognition. IEEE Transactions on Pattern Analysis

and Machine Intelligence, 14(2):125–145, 1992. 2

[40] O. Tuzel, M.-Y. Liu, Y. Taguchi, and A. Raghunathan. Learn-

ing to rank 3d features. In 13th European Conference on

Computer Vision, Proceedings, Part I, pages 520–535, 2014.

2

[41] D. Z. Wang and I. Posner. Voting for voting in online point

cloud object detection. In Proceedings of Robotics: Science

and Systems, Rome, Italy, July 2015. 1, 2

[42] Y. Xiang, W. Choi, Y. Lin, and S. Savarese. Data-driven

3d voxel patterns for object category recognition. In Pro-

ceedings of the IEEE International Conference on Computer

Vision and Pattern Recognition, 2015. 2

[43] M. Z. Zia, M. Stark, B. Schiele, and K. Schindler. De-

tailed 3d representations for object recognition and model-

ing. IEEE Transactions on Pattern Analysis and Machine

Intelligence, 35(11):2608–2623, 2013. 2

[44] M. Z. Zia, M. Stark, and K. Schindler. Are cars just 3d

boxes? jointly estimating the 3d shape of multiple objects.

In 2014 IEEE Conference on Computer Vision and Pattern

Recognition, pages 3678–3685, June 2014. 2