一、准备阶段

1.首先安装好四台虚拟机分别作为一台nameNode与三台dataNode,最好规范命名方便操作,例如node01、node02等

2.将四台虚拟机的IP配置好,让其使用固定的静态IP,以防动态分配IP,方法为:

首先进入 cd /etc/sysconfig/network-scripts/

vi ifcfg-eth0 修改文件

修改:ONBOOT=yes BOOTPROTO=none

新增:

IPADDR=***.***.***.*** (将ifconfig查出的IP放在此处

PREFIX=24

GATEWAY=***.***.***.2(只修改主机号为2

DNS1=8.8.8.8

重启网络服务 : service network restar

二、搭建步骤

(1)时间同步

①各个节点安装ntp命令yum install ntp

②上网查找最新的时间服务器ntp1.aliyun.com

③同步时间ntpdate ntp1.aliyun.com

(2)配置免密登录

node01->node01 node01->node02 node01->node03 node01->node04

①所有节点执行 ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

②在node01节点执行,将node01的公钥加入到其他节点的白名单中

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node02

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node03

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node04

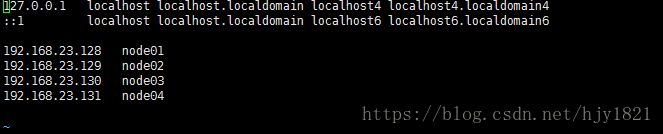

在此之前一定要配置好hosts文件,确保通过主机名能正常访问,四台机器都需要配置

(3)所有节点配置JDK,四台节点都要配置

① export JAVA_HOME=/opt/software/jdk/jdk1.8.0_151

② export PATH=$PATH: $JAVA_HOME/bin

修改好profile,配置好环境,一般情况下安装的虚拟机都会自带其他版本jdk,需手动删除,具体操作参照我另一篇伪分布式搭建方法中的操作。

(4)修改hdfs-site.xml配置文件

<property>

<name>dfs.replication</name>

<value>3</value> --》从节点的个数

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:50090</value> --》namenode的http访问地址

</property>

(5)修改core-site.xml配置文件

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/var/abc/hadoop/cluster</value> -->设置生成文件与数据的存放目录,出问题就删除

</property>

(6)修改hdoop-env.sh配置文件

将语句 export JAVA_HOME=$JAVA_HOME

修改为 export JAVA_HOME=/opt/software/jdk/jdk1.8.0_151

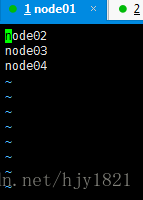

(7)修改slaves配置文件

修改为node02 node03 node04,**一定要写为一列**

(8)将配置好的安装包分发到其他节点上(一定要设置好文件的目录信息)

scp -r hadoop-2.6.5 root@node02:/opt/software/hadoop/

scp -r hadoop-2.6.5 root@node03:/opt/software/hadoop/

scp -r hadoop-2.6.5 root@node04:/opt/software/hadoop/

(7)格式化NameNode(创建目录以及文件) hdfs namenode -format

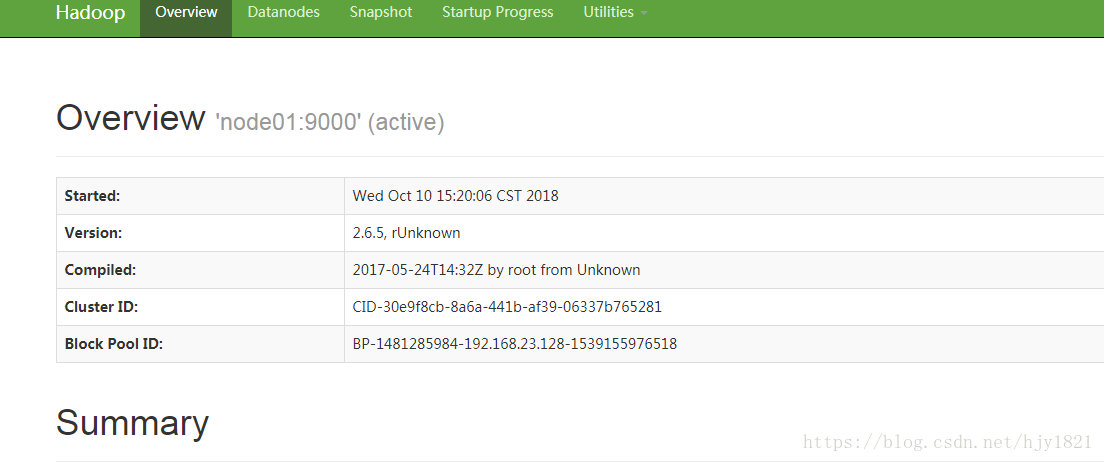

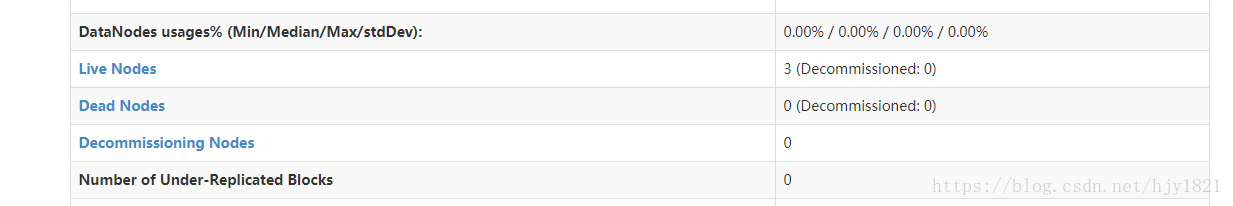

(8)启动HDFS start-dfs.sh

通过jps命令可查看每个节点上的进程情况

成功启动后:

三、注意事项

1.在格式化之前必须停止所有HDFS相关的进程 stop-dfs.sh

2.启动集群后出现问题纠错后必须严格按照以下步骤重新启动:

1) 停止所有节点

2)删除所有节点生成的目录信息cluster

3)格式化

4)启动 start-dfs.sh

3.关闭所有节点的防火墙

chkconfig iptables off 重启永久生效

service ipables status 查看防火墙状态