来源 | 新智元

编辑 | 大明

【新智元导读】MIT团队打造“密集目标网络”(DON)的机器人系统,能够让抓取机器人真正“读懂”目标,该系统将目标处理生成三维“视觉路线图”的点集合,让机器人真正在视觉上理解目标。利用这一系统,科学家们不必再像过去的计算机视觉研究一样,繁琐地对大量数据集中的数据进行标记了。

长期以来,人类一直以灵巧著称,这种特点在很大程度上要归功于我们的眼睛。不过现在,机器人也逐步迎头赶上。经过几十年的发展,现在用于生产线等受控环境中的机器人已经能够一次又一次地拾起同一个目标了。

最近在计算机视觉方面的突破,让机器人也能区分出不同的目标。不过即使这样,机器人还是无法真正理解物体的形状,因此在拾取目标后,几乎无法再做什么别的事。

近日,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员在一篇新论文中表示,他们已在这个领域取得了一项重要进展:他们打造的机器人系统可以识别出之前未见过的随机目标,并能够在视觉上“理解”这些目标,以完成更丰富的任务。

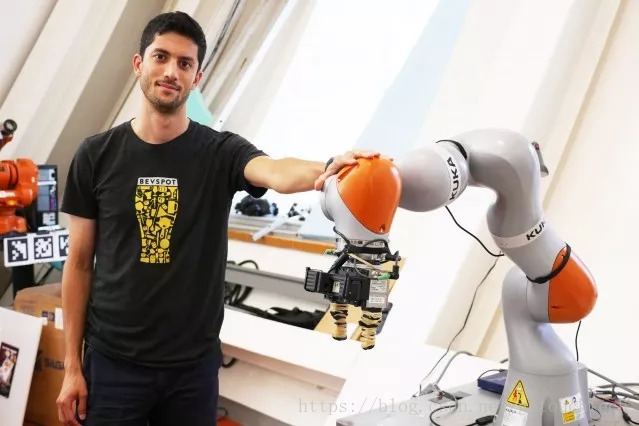

研究人员使用KUKA机器人抓起一只杯子

“密集对象网络”:让机器人读懂抓取目标

该系统名为“密集对象网络”(DON),该网络将对象视为点的集合,当作“视觉路线图”来使用。这种方法可以让机器人更好地理解和抓取目标,最重要的是,机器人能够在大量类似目标中挑出特定的目标。亚马逊和沃尔玛等公司在其仓库中使用的机器就具备类似的技能。

比如,有人可能会使用DON系统让机器人抓住目标上的特定位置,比如鞋舌头。之后,它就能够看到之前从未见过的鞋子,并成功抓住鞋舌头。

参与该研究的博士生Lucas Manuelli说道:“许多控制系统和识别方法都无法识别朝多个方向放置的目标的特定部分。”他与该论文另一作者、博士生Pete Florence和MIT教授Russ Tedrake一起撰写了该论文。 “比如,现有的算法就无法抓住马克杯的杯柄,尤其是在马克杯朝多个方向放置的情况下,比如直立或侧放。”

该团队认为,该技术不仅能用于工业制造,还能走入家庭的日常生活。比如,给系统展示一座整洁的房子的图像,让机器人在你工作时打扫房间,或向机器人展示菜肴的图像,让机器人在你度假时把你的餐桌上的盘子收拾好。

DON抓取算法:训练无需标注数据集,省时省力

值得注意的一点是,没有任何数据事先被人类标记过。这个系统是“自我监督的”,因此不需要任何来自人类的数据标注。

机器人抓取目标的两种常见方法是,创建特定任务的机器学习,创建通用的抓取算法。这两种技术都存在障碍:基于特定任务的方法很难推广到其他任务,而通用的抓取算法不够具体,无法顾及处理特定任务时的细微差别,比如将目标放到特定的位置上。

而DON系统基本上是在给定目标上创建一系列坐标,作为基于目标的一种“视觉路线图”,使机器人更好地理解自己需要抓取哪些目标,目标在何处等。

该团队训练系统将对象视为构成较大坐标系的一系列点。然后将不同的点映射到一起,显示出对象的三维形状,这种方式和使用多张照片拼接全景照片的方式有些类似。在训练之后,如果指定目标上的一个点,机器人可以拍摄该物体的照片,并一系列的点进行识别和匹配,然后就可以指定点拾取目标。

下面是一段演示视频,一起来看看!

https://v.qq.com/x/page/n1348amrk6z.html

这个系统与加州大学伯克利分校的DexNet系统有所不同,伯克利的系统可以抓取许多不同的目标,但不能满足抓取特定目标的要求。就好比一个一岁半的婴儿,他不明白你想要他玩哪个玩具,但仍然可以抓起很多不同的玩具,而一个四岁的孩子,就可以准确地回应“去抓住那辆红色小卡车的车尾”的要求。

在形状对称毛绒玩具上进行的一组测试中,由DON驱动的Kuka机器人手臂可以从一系列不同的目标位置抓住玩具的右耳。这表明系统具有在对称物体上区分左右的能力。

在利用不同棒球帽进行测试时,DON可以选择特定的目标帽子,尽管所有的帽子的设计都非常相似,机器人在之前从未在训练数据中看到过帽子的照片。

未来,团队希望将系统进行改进,让其具备执行特定任务的能力,同时能够更深入地了解相应的目标,例如学习如何抓住目标,并将其移动到最终位置等。

团队将于下个月在瑞士苏黎世举行的机器人学习会议上发表这一成果。

参考链接:

https://www.eurekalert.org/pub_releases/2018-09/miot-rcp090418.php

https://www.csail.mit.edu/news/robots-can-now-pick-any-object-after-inspecting-it

论文地址:

https://arxiv.org/abs/1806.08756

Github资源:

https://github.com/RobotLocomotion/pytorch-dense-correspondence