损失函数

|yi−f(xi)|

,一般是针对单个样本 i

代价函数

1/N.∑Ni=1|yi−f(xi)|

, 一般是针对总体

目标函数

1/N.∑Ni=1|yi−f(xi)|

+ 正则化项

经验风险最小化可表示为最优化问题:

min1N∑i=1NL(yi,f(xi))

而结构风险最小化可表示为最优化问题:

min1N∑i=1NL(yi,f(xi))+λJ(f)

在结构风险最小化中,经验风险只是被优化的一部分,此时并不能称经验风险最小化。

0-1损失函数

L(Y,f(X))={1,Y≠f(X)0,Y=f(X)

可以看出,该损失函数的意义就是,当预测错误时,损失函数值为1,预测正确时,损失函数值为0。该损失函数不考虑预测值和真实值的误差程度,也就是只要预测错误,预测错误差一点和差很多是一样的。

对数损失函数(logarithmic loss function)

L(Y,P(Y|X))=−logP(Y|X)

这个损失函数就比较难理解了。事实上,该损失函数用到了极大似然估计的思想。P(Y|X)通俗的解释就是:在当前模型的基础上,对于样本X,其预测值为Y,也就是预测正确的概率。由于概率之间的同时满足需要使用乘法,但是乘法直接求导比较困难,所以需要将其转化为加法,我们将其取对数。最后由于是损失函数,所以预测正确的概率越高,其损失值应该是越小,因此再加个负号取个反。

逻辑回归中使用对数损失函数,最后得到的损失函数如下:

扫描二维码关注公众号,回复:

39953 查看本文章

J(w,b)=−1m∑D(yi,pi)

其中

D(y,p)=ylog(p)+(1−y)(1−log(p))

公式中的p为逻辑回归预测的概率值。

p=h(w,b)=softmax(wx+b)

所以损失函数等价于

J(w,b)=−1m∑i=1m[y(i)logy^(i)+(1−y(i))log(1−y^(i))]

平方损失函数(最小二乘法, Ordinary Least Squares )

L(Y,f(X))=(Y−f(X))2

该损失函数的意义也很简单,就是取预测差距的平方。

最小二乘法是线性回归的一种,OLS将问题转化成了一个凸优化问题。在线性回归中,它假设样本和噪声都服从高斯分布。最后通过极大似然估计(MLE)可以推导出最小二乘式子。最小二乘的基本原则是:最优拟合直线应该是使各点到回归直线的距离和最小的直线,即平方和最小。

绝对值损失函数(absolute loss function)

L(Y,f(X))=|Y−f(X)|

该损失函数的意义和上面差不多,只不过是取了绝对值而不是求绝对值,差距不会被平方放大。

指数损失函数

L(y,f(x))=exp[−yf(x)]

指数损失函数是0,1损失函数的变形

Adaboost的目标函数就是指数损失,在给定n个样本的情况下,Adaboost的损失函数为

L(y,f(x))=1n∑i=1nexp[−yif(xi)]

Hinge损失函数(SVM)

minL(w)=1n∑i=1nH(yif(xi,w)),whereH(t)={−t+10t<1t≥0

其含义为,y的值在-1到1之间就可以了,并不鼓励,即并不鼓励分类器过度自信,让某个可以正确分类的样本距离分割线的距离超过1并不会有任何奖励。从而使得分类器可以更专注整体的分类误差

优点:稳定的分类面,凸函数。对分对的但又不是很对的样本也进行惩罚(0-1之间),可以极大化分类间隔。

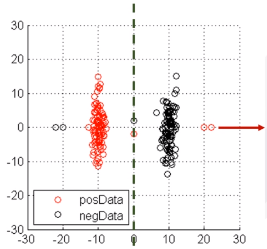

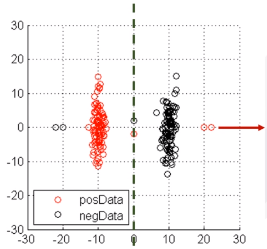

感知机损失函数(L1 margin cost)

minL(w)=1n∑i=1nH(yif(xi,w)),whereH(t)={−t0t<0t≥0

在t=0处不连续,所以不可导,但是可以求次梯度(导数)。

优点:稳定的分类面,次梯度可导

缺点:二阶不可导,有时候不存在唯一解

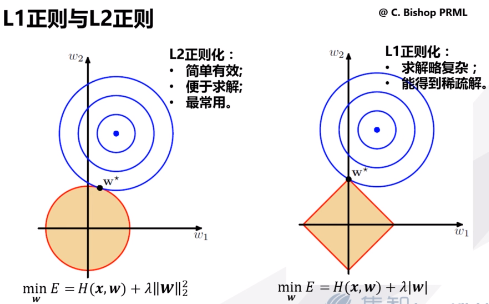

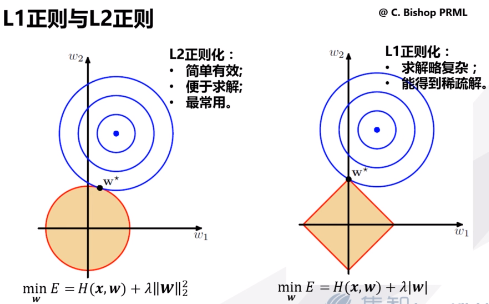

L1和L2正则化

L1正则化假设了模型的先验概率分布服从拉普拉斯分布;L2正则化假设了模型的先验概率分布服从高斯分布。