简评:一些法律学者认为,道德规范过于主观,无法指导人工智能的使用。

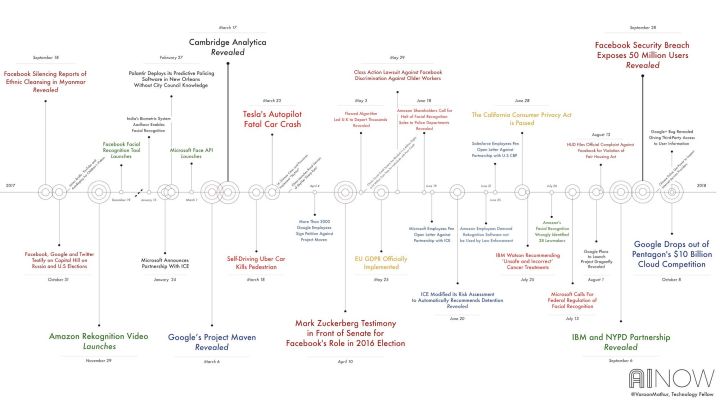

AI Now 2018 技术沙龙活动时间表

在过去的六年中,纽约市警察局编制了一个庞大的数据库,包含了 17500 多个被认为参与了犯罪团伙者的名字和个人信息,并使用面部识别技术与数据库结合的手段来寻找罪犯。

这个行为一直被民权活动人士批评,他们认为这种做法非常不准确且具有明显的歧视性。

专家学者们常常强调在人工智能系统的设计和运行中需要设定道德规范,但他们忽略了一个问题:谁来定义这些道德,谁又来执行它们?过于主观的道德规范往往很难指导人工智能的使用。

Sherrilyn Ifill (NAACP Legal Defense Fund), Timnit Gebru (Google), and Nicole Ozer (ACLU) in conversation at the AI Now 2018 Symposium

实际上,技术往往突出了人们不同的道德标准。为了观察人们的原则有多么不同,MIT 的研究人员创建了一个「道德机器」的测试,用以观察人们对自动驾驶应遵循的道德决策的观点。然而结果显示不同文化之间的答案存在巨大差异。

与此同时,建立道德标准也未必能改变行为。例如,今年年中 Google 制定了一套新的道德原则来指导其参与的 AI 项目,然而几个月后,Google 的员工认为这些原则已经被公司搁置。

纽约大学法学院的国际法律学者 Philip Alston 提出了解决道德模糊的解决方案 —— reframing AI-driven consequences in terms of human rights.(重新定义人工智能驱动的人权后果)他解释道,如果人工智能系统剥夺了人们的基本权利,那就不应该被接受了。

原文链接:Establishing an AI code of ethics will be harder than people think