学习笔记,详情请点击此处。

0、前言

NER又称作专名识别,是自然语言处理中的一项基础任务,应用范围非常广泛。命名实体一般指的是文本中具有特定意义或者指代性强的实体,通常包括人名、地名、组织机构名、日期时间、专有名词等。NER系统就是从非结构化的输入文本中抽取出上述实体,并且可以按照业务需求识别出更多类别的实体,比如产品名称、型号、价格等。实体这个概念可以很广,只要是业务需要的特殊文本片段都可以称为实体。

学术上NER所涉及的命名实体一般包括3大类(实体类,时间类,数字类)和7小类(人名、地名、组织机构名、时间、日期、货币、百分比)。

实际应用中,NER模型通常只要识别出人名、地名、组织机构名、日期时间即可,一些系统还会给出专有名词结果(比如缩写、会议名、产品名等)。货币、百分比等数字类实体可通过正则搞定。另外,在一些应用场景下会给出特定领域内的实体,如书名、歌曲名、期刊名等。

NER也是关系抽取、事件抽取、知识图谱、机器翻译、问答系统等诸多NLP任务的基础。

命名实体识别的目前状态:只是在有限的文本类型(主要是新闻语料中)和实体类别(主要是人名、地名、组织机构名)中取得了不错的效果;与其他信息检索领域相比,实体命名评测语料较小,容易产生过拟合;命名实体识别更侧重高召回率,但在信息检索领域,高准确率更重要;通用的识别多种类型的命名实体的系统性能很差。

1、如何进行命名实体识别

(1)BiLSTM-CRF

传统方法 :直接由Embedding层+RNN:将token从离散one-hot表示映射到低维空间中成为稠密的embedding,随后将句子的embedding序列输入到RNN中,用神经网络自动提取特征,Softmax来预测每个token的标签。

这种方法的一个缺点是对每个token打标签的过程是独立的进行,不能直接利用上文已经预测的标签(只能靠隐含状态传递上文信息),进而导致预测出的标签序列可能是无效的,例如标签I-PER后面是不可能紧跟着B-PER的,但Softmax不会利用到这个信息。

在神经网络的输出层接入CRF层(重点是利用标签转移概率)来做句子级别的标签预测,使得标注过程不再是对各个token独立分类。

改进 :

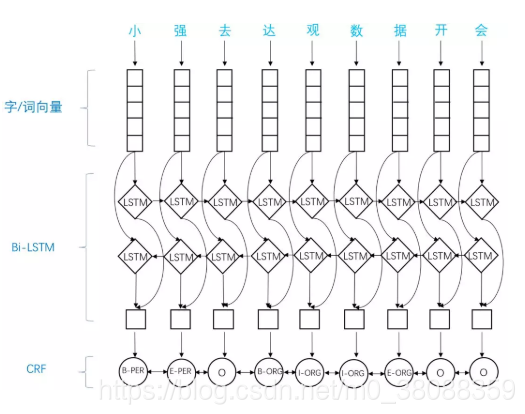

由Embedding层(主要有词向量,字向量以及一些额外特征),双向LSTM层,以及最后的CRF层构成。原理如下图:

(2)IDCNN-CRF

由于句子本身是一个长序列,会有长距离依赖,我们是要捕捉到整个序列的特征信息,如果用CNN来做的话,末层神经元可能只获得原始输入的一小块信息,所以为了覆盖全部的输入信息就需要更多的卷基层,层数越多,参数也会越来越多,当参数越多模型就会越复杂越容易过拟合,我们就要加入Dropout之类的正则化,带来更多的超参数,如此下来模型就很难训练。

而因为CNN能利用GPU的并行计算,这样的效率会快许多,我们就不得不对CNN进行改进。

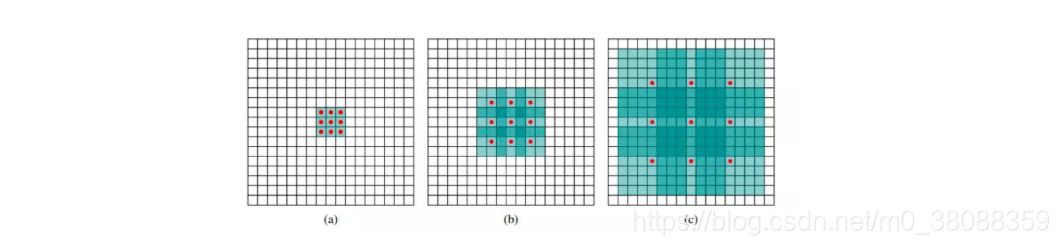

Fisher Yu and Vladlen Koltun 2015 提出了dilated CNN模型,意思是“膨胀的”CNN。dilated CNN为这个filter增加了一个dilation width,作用在输入矩阵的时候,会skip所有dilation width中间的输入数据;而filter本身的大小保持不变,这样filter获取到了更广阔的输入矩阵上的数据,看上去就像是“膨胀”了一般。

dilated width会随着层数的增加而指数增加。这样随着层数的增加,参数数量是线性增加的,而receptive field却是指数增加的,可以很快覆盖到全部的输入数据。

感受域随着步长的扩大而变化。

过程 :

(1)原始感受域位于中心11区域,大小为11。

(2)感受域按步长为1向外扩散,得到8个11的感受域构成的新感受域,并且总大小为33。

(3)以中心点按照步长为2继续向外扩散,感受域总大小扩大为7*7。

(4)经步长为4的扩散,原7x7的感受域扩大为15x15的感受域。

可以看到:每一层的参数数量是相互独立的。感受域呈指数扩大,但参数数量呈线性增加。

2、数据增强

对于深度学习方法,一般需要大量标注语料,否则极易出现过拟合,无法达到预期的泛化能力。

方法 :

(1)对原语料进行分句,然后随机地对各个句子进行bigram、trigram拼接,最后与原始句子一起作为训练语料。

(2)利用收集到的命名实体词典,采用随机替换的方式,用其替换语料中同类型的实体,得到增强语料。

补充:IDCNN-CRF的收敛速度基于GPU会远超过BiLSTM-CRF。