前记:本篇是对手机双摄原理及应用现状,未来布局的汇总。

为什么会出现双摄像头手机?

智能手机市场一直都是群雄争霸,竞争非常激烈。随着时代的发展,各大手机厂商的竞争焦点从以前的硬件军备竞赛逐渐延伸到影音娱乐领域,尤其越来越注重手机的拍照性能。随着手机的快速迭代,单摄像头手机的拍照性能在一定程度上达到极限,要想在拍照领域再度有所突破,必须要借助双摄像头,甚至摄像头阵列才能实现更多的应用。近两年,不少手机厂商推出了双摄像头(简称双摄)手机,摄像头从一个变成两个,到底是个噱头,还是真的物有所值,我们来探讨一下吧。

什么是双摄手机?

通俗的讲,双摄手机是指一个智能手机某一面(一般是背面,也可能在前面)上有两个并排(横排或者竖排)的摄像头;如果学术一点讲的话,可以称为立体相机(stereo camera)。这两个相机可以模拟人眼双目视觉原理,利用立体摄影(stereo photography)算法获得三维信息。双摄手机发展简史

事实上,双摄手机并不是最近一两年才出现的新鲜玩意儿。早在2011年,如日中天的HTC推出了首款配备两颗500万像素摄像头机型G17,然而第一个吃螃蟹的人往往成为先烈,当时双摄像头的配置并未能打入主流市场。主要有两个原因:一是500万像素画质过低,先拍照后对焦后画质并没有得到提升;二是因为缺乏3D应用,让双摄像头成为鸡肋。随着手机硬件和相关算法的发展,具有双摄配置的手机又重新杀入市场,搅起了手机业新一轮的惊涛骇浪。2014年12月,华为荣耀6plus双摄手机发布,后置两个平行的800万像素摄像头。随后中兴、乐视、酷派、360、小米等多家公司相继推出双摄手机。手机业界风向标苹果公司也坐不住了,于2016年9月推出了iPhone 7 plus,后置1200万像素双摄手机,此次iPhone 7 Plus的双摄像头升级是iPhone问世以来在摄像头方面最大的一次飞跃。下图是iPhone 7 Plus的双摄配置。

为什么双摄像头配置会东山再起?

第一个原因是,用户需求的转变。从单纯追求高分辨率转到更多元化的应用需求。以前手机用户对拍照的需求主要体现在追求更高的分辨率上,比如Nokia曾经发布了高达4100万像素的手机,但这条路明显走偏了, 用户发现自己并不需要手机实现这么高的像素,反而需要更快的对焦速度、光学变焦、夜拍降噪、提高画质、提高动态范围、甚至三维重建等功能。而这些光靠单摄像头,即使利用复杂的图像处理算法也难以完全实现。而利用双摄像头搭配相关的算法,可以比较轻松地实现上述功能。

第二个原因是:手机厚度的限制。

摄像头模组的厚度决定了手机的整体厚度。一方面用户希望手机越薄越好,另一方面拍照性能的提高需要更复杂更厚的镜头模组。比如智能手机用单个摄像头实现光学变焦是一件非常困难的事情,要想实现光学变焦需要复杂的镜头组合设计,这样设计出来的镜头模组就比较厚。所以这两者是不可调和的矛盾。即便是行业翘楚的苹果手机,也没办法很好的解决这一问题,这也是iPhone 6摄像头突出的主要原因。从手机外观设计的角度来说,要解决颜值问题,必须要采用双摄像头。

双摄手机有什么用?

按照双摄手机两个摄像头之间的距离来做个简单分类:两个摄像头之间离得比较近,两个摄像头取景范围相差很小,这样在两张图片进行融合的时候就不会因为错位产生不良的影响,可以利用两个摄像头不同的曝光和色彩信息进行融合,展现更真实的色彩,更丰富的细节,从而大幅提升成像质量。可以用来做夜景/暗光拍照增强、增加动态范围等应用。两个摄像头之间离得比较远,得到的两张图之间相差足够大,可以用算法来取得景深信息,然后利用景深来做背景虚化,物体分割,三维重建,辅助对焦,动作识别等应用。

下面列举几个常见的应用。

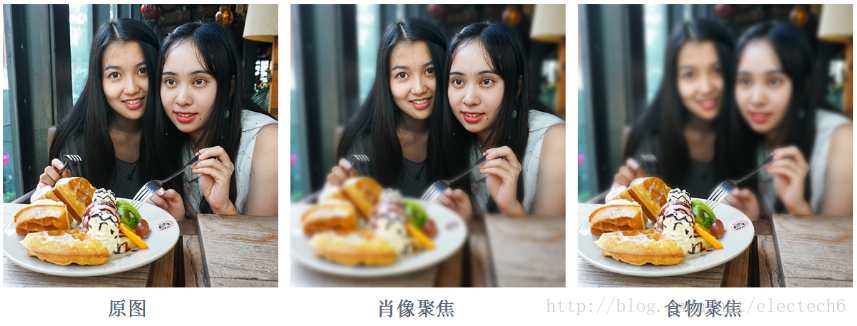

1、背景虚化

背景虚化是一种常用的功能,很多人都对单反相机的大光圈背景虚化效果非常着迷。如下图右是原图,左图是iPhone 7 plus 背景虚化的效果。

2、重对焦

利用计算得到的景深信息,可以实现先拍照后对焦。

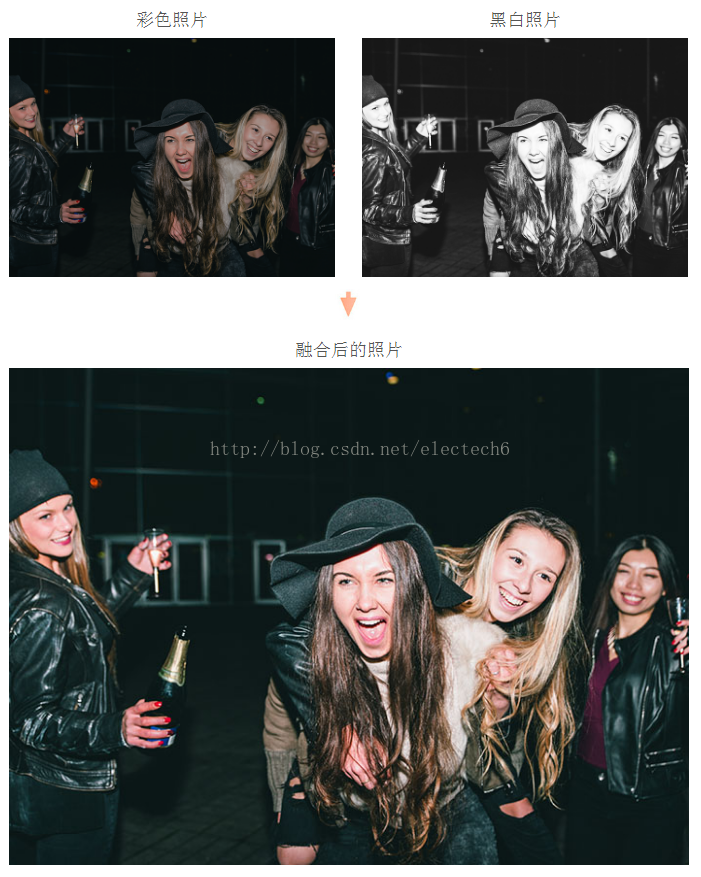

3、夜景/暗光拍照增强

以华为P9为例,其配置一个彩色镜头一个黑白镜头。黑白镜头的大光圈保证了足够的进光量,让画面景物细节轮廓凸显,彩色镜头负责捕捉色彩,经过算法合成后可以呈现较好的夜景拍照效果。

4、光学变焦

通过广角和长焦的双摄像头搭配,可以让相机拥有更远的光学变焦。

如下图左边是iPhone 7 Plus广角相机拍摄的图片,右边是长焦相机拍摄的图片。

5、提高动态范围(HDR)

单摄像头实现HDR的方法通常是修改不同的曝光时间来得到不同曝光环境下的图片,然后进行合成,这样图像处理的时间比较长。这不仅导致用户体验很差,而且当场景中有运动物体或者相机有移动的话会导致鬼影的问题。利用双摄像头就可以解决这个问题,只需要对两个摄像头设置不同的曝光参数,然后对结果进行合成就可以实现。如下图,上面是两个摄像头拍摄的不同曝光参数的图片,下面是HDR合成结果。

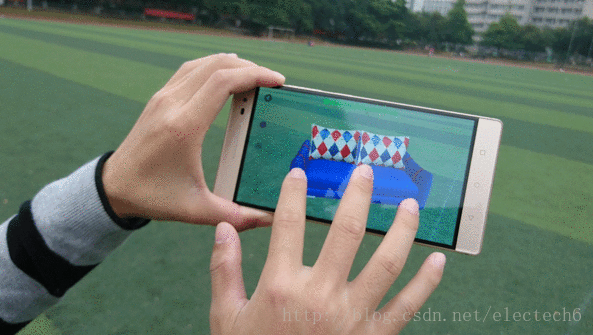

6、三维应用

因为通过双摄像头可以计算出景深信息,所以双摄在三维应用上将会有很多有趣的应用。比如可以测算物体的物理尺寸和距离,用来做三维测量;可以通过扫描来对真实物体进行三维建模;可以实现逼真的互动性很强的增强现实游戏等。这将大大拓展手机的应用价值。

总结:

双摄手机虽然有以上介绍的优势,但仍然存在不少问题:由于目前大部分双摄手机基线(两个摄像头的距离)较短,无法计算较远处的景深。所以背景虚化、重对焦等功能仍然和单反相机有很大差距,有许多槽点可以吐。三维应用也还处于起步阶段,有很多功能有待挖掘。

双摄手机的出现是行业发展瓶颈催生的必然结果,随着双摄手机越来越普及,双摄功能正趋于成熟,相信最近两年双摄技术会带来越来越多的有用有趣的应用。

双摄技术方案:

由于双摄技术的快速发展,目前已经衍生出了几种不同的双摄硬件和算法配置解决方案。不同手机厂商可能有不同的双摄配置,比如华为荣耀P9采用的就是黑白相机+彩色相机的硬件配置,而iPhone 7 plus采用的就是广角+长焦的配置。此外,随着技术的演化,同一厂商也可能推出多种不同的配置。比如,华为2014年底推出第一款双摄手机是荣耀6plus,后置两个相同的彩色相机平行排列,2016年推出的年度旗舰产品荣耀P9则是黑白相机+彩色相机的配置。

因此介绍原理之前,先对目前双摄的配置进行粗糙的分类。双摄手机一般包括一个主摄像头和一个辅助摄像头。根据不同的应用需求和侧重点,目前双摄手机通常有以下几种不同的组合形式:

1、彩色相机 + 彩色相机(RGB + RGB),主要用于计算景深,实现背景虚化和重对焦

2、彩色相机 + 黑白相机(RGB + Mono),主要提升暗光/夜景影像拍摄质量

3、广角镜头 + 长焦镜头(Wide + Tele),主要用于光学变焦

4、彩色相机 + 深度相机(RGB + Depth),主要用于三维重建

以上1、2、3的组合本质上是一种“叠加”。即把两个镜头拍摄的图像叠加融合,来达到提升拍摄质量、背景虚化、光学变焦等功能。这种应用双摄像头拍摄的图像差距越小越好,这样算法进行“叠加”的时候才能更精确。理论上两个摄像头离的越近越好,目前大部分双摄手机都是基于这样的配置,两个镜头之间的基线(两个镜头的间距)很短,一般都是10mm左右。而人类双眼的基线均值是64mm,相比之下目前的双摄手机基线太短,只能计算较近物体的景深(浅景深)。

1、彩色相机 + 彩色相机

单反相机让人为之着迷的一点便是通过调整不同光圈值,拍出如梦似换的背景虚化效果。我们知道,单反相机通过增大镜头光圈可以缩小拍照时的合焦范围。如下图,黑色的小人代表了拍摄的清晰范围,当采用较大光圈时,只有在对焦点附近的小人是清晰的,对焦点前后的小人都被模糊掉了。

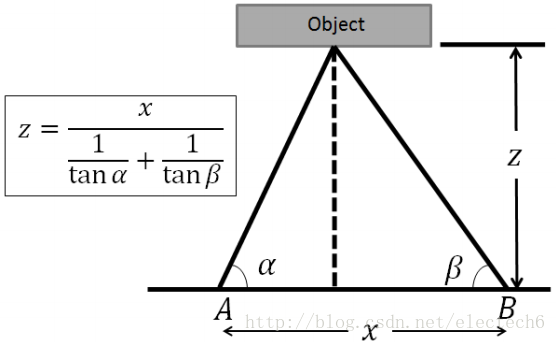

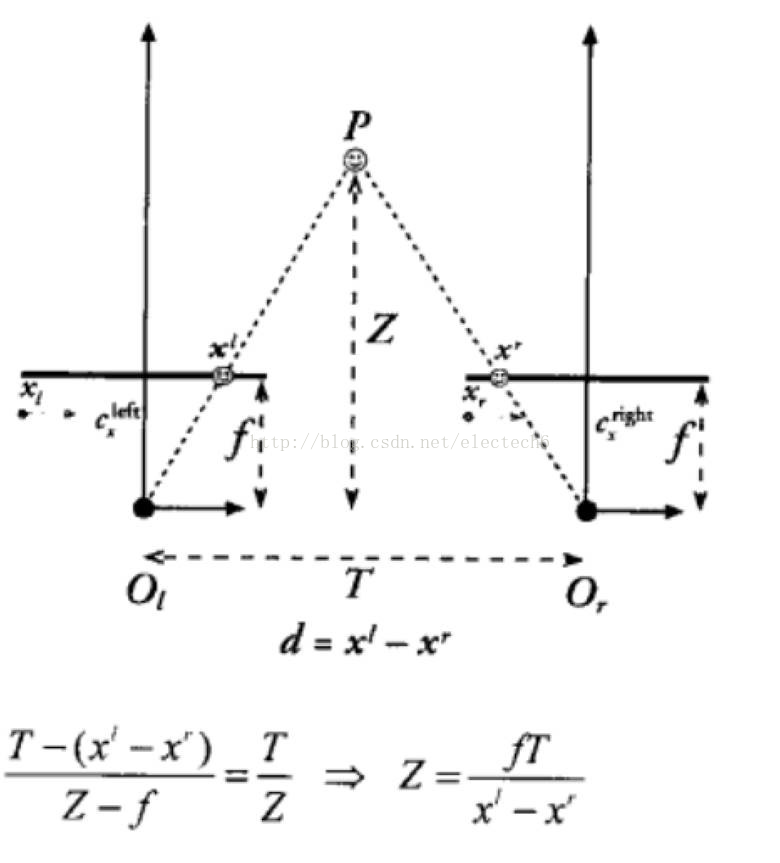

为了模拟这种虚化效果,双摄手机利用人眼三角定位原理来计算被摄物体距离摄像头的距离Z。如下图所示。

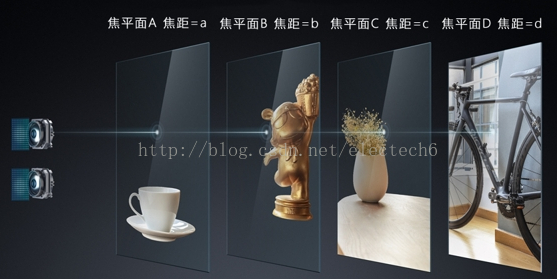

得到拍照场景中每一个像素点距离相机的远近后,通过算法保留对焦平面内景物清晰度,将其余部分根据其相对于摄像头的远近距离进行模糊处理,就可以模拟出光圈虚化效果。如下所示不同焦距对应不同焦平面。

来一张养眼的背景虚化图片吧:

虽然理论上可行,但实际使用中,要想在不同场景下实现类似于单反一般"焦内锐利,焦外奶油"的效果,让人物主体对焦锐利突出,层次线条分明,还需要强大的算法保障(以后会介绍该领域的算法公司)。

单反相机可以通过调节光圈大小,来改变照片的虚化程度,双摄手机也可模拟单反相机调节光圈。通过重新调用照片中物体的景深信息,可以实现先拍照后对焦的功能,实现之前只有光场相机才能实现的重对焦功能。

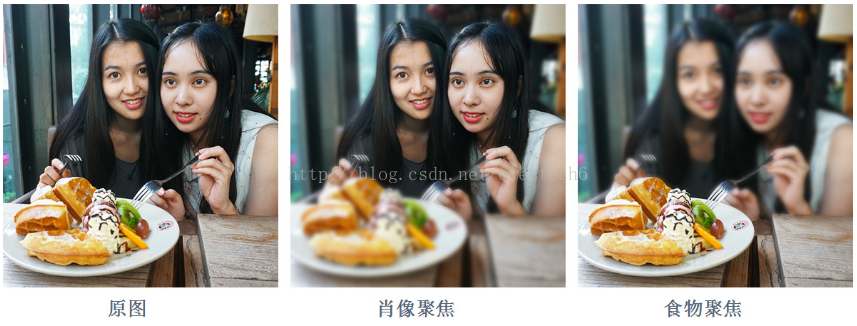

如下图是利用双摄手机处理得到的重对焦效果:

典型手机代表:

红米Pro、vivo x9

特别提示:

vivo x9官网的双摄介绍: 前置采用2000W索尼定制传感器 + 800W专业景深摄像头

红米Pro官网的双摄介绍:1300 万像素后置相机 + 500 万像素辅助深度相机

上述两款手机官网介绍中副摄像头标榜为景深相机或辅助深度相机,其实并不恰当。它们并非真的可以单独用来测量距离,其实只是普通的RGB彩色相机。只不过对成像质量贡献很小,主要用于和主摄像头一起提供立体视差从而计算景深。总结一下,景深信息实际是通过主副两个相机的视差共同计算的,单个RGB相机是无法直接得到景深的。所以我个人认为,红米pro和vivo x9在双摄的副摄像头宣传上使用了误导性的不恰当的术语。

2、彩色相机(RGB) + 黑白相机(Mono)

提高暗光拍照质量一般有三种办法:延长曝光时间、提高ISO感光度、增大光圈。延长曝光时间会带来手抖的问题,于是手机厂商纷纷搬来了光学防抖;提高ISO感光度则必然会增加噪点影响画面纯净度,在手机体积和厚度限制下又不大可能再把传感器尺寸放大;手机光圈一般都是固定的无法调整。于是算法工程师们想到了借助黑白世界的力量。

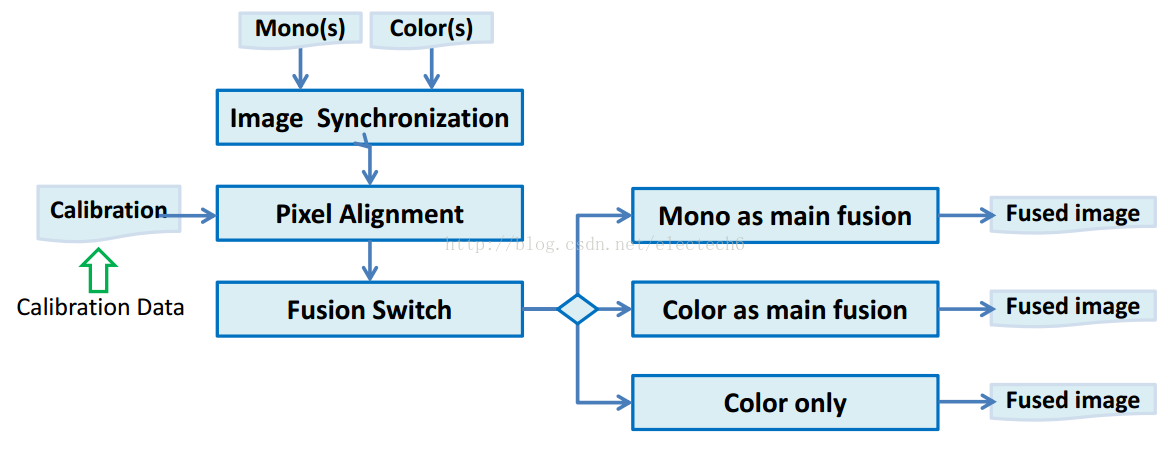

下面参考altek公司的一个简要的技术报告来解释一下该技术的原理。下图是一个简要的算法流程图。

-

黑白和彩色相机拍摄的图像首先要保证图像同步和像素级对齐操作,通俗的说就是要保证两个相机在同一个时刻拍摄同一个场景下的物体,由于两个相机之间有一定的距离,所以拍摄的场景虽然是同一时间,但内容会有移位,所以需要根据两个相机交叠的部分来使得黑白和彩色图片中相同的像素一一对应。这一部分需要用到两个相机事先标定好的数据来做计算。相机标定可以简单的理解为测算两个相机的物理位置关系和相机本身的参数,在此不多做介绍。

-

图像融合部分是可以加开关进行控制的,根据不同应用的需要黑白和彩色图片都可以作为主要的融合参考,也可以分开使用。

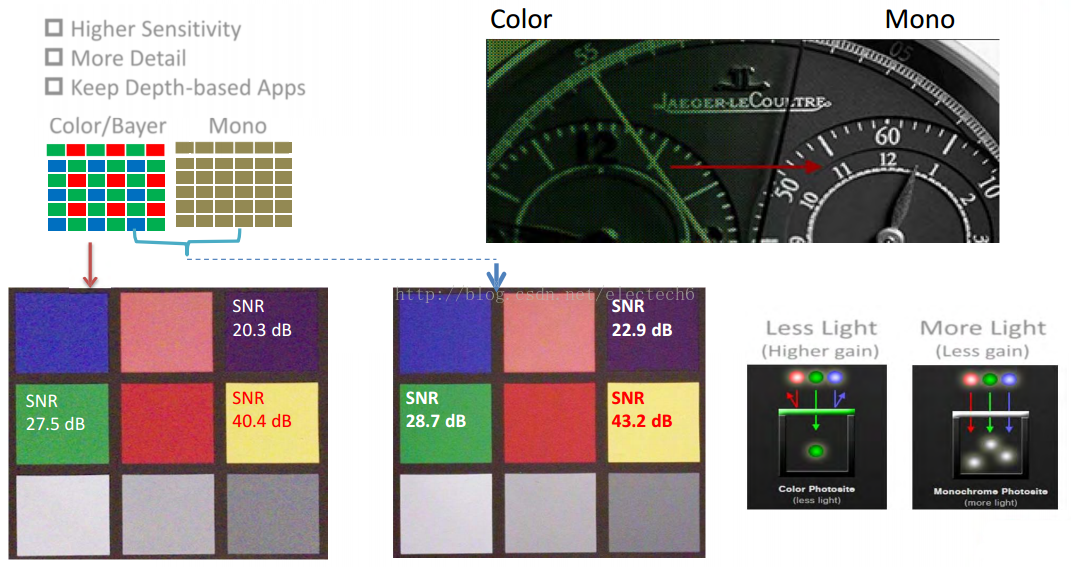

下面来看看为什么要把黑白图片和彩色图片进行融合,是否融合后1+1>2?

我们知道自然光是由赤橙黄绿青蓝紫等不同颜色组成的,我们小时候玩的三棱镜就可以看到光的色散。如下图。

我们日常生活中的数码相机,显示器、扫描仪等大部分显示或打印的颜色都是通过红(Red)、绿(Green)、蓝(Blue)三原色按照不同的比例合成的,称为RGB颜色模型。这个比较容易理解。

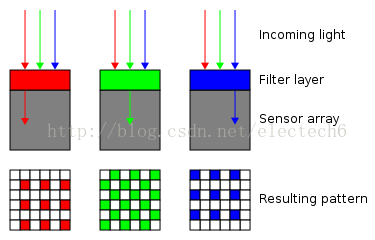

接下来介绍一个复杂一点概念:拜尔滤色镜。它其实是一种将RGB滤色器排列在光传感组件方格之上所形成的马赛克彩色滤色阵列。如下图,入射的自然光经过不同的拜尔滤色镜后就得到了相应的颜色。

其中绿色占一半,红蓝各占四分之一,这样的设置是因为人的眼睛对绿色最敏感。最终每个像素点的颜色信息是经过插值处理得到的。插值的方法有很多种,最简单的一种就是线性插值。比如下图位于九宫格的绿色像素点G,它的RB值是通过周围四格的平均值得到的。

对于红色像素点R或蓝色的B,插值的方法会稍微复杂一些,在此不赘述。

而黑白相机没有拜尔滤色镜,所有的光都入射进来(下图右下角),所以和具有拜尔滤色镜的彩色相机相比可以获得更大的进光量,光学传感器的灵敏度也更高。因此黑白相机相对彩色相机,图像更加明亮,细节信息能够保留的更好。下图左下角是彩色相机的信噪比SNR(全称Signal Noise Ratio,可以理解为有用信息和噪音的比值,越大越好)。右侧是彩色、黑白图像融合后的结果,可以看到,融合后信噪比明显提升了。

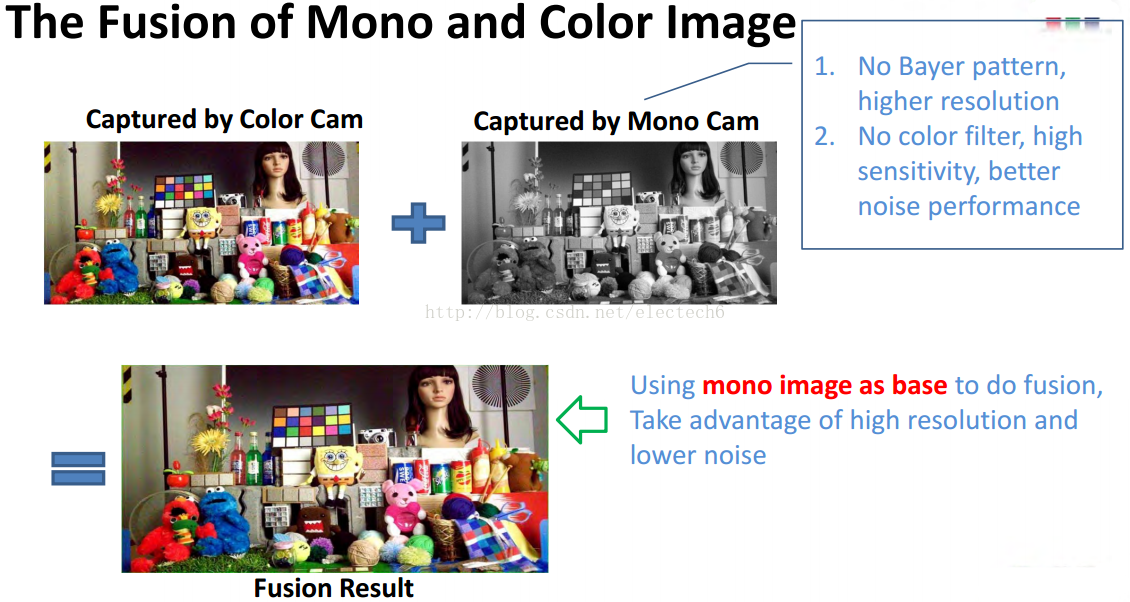

综上,由于黑白相机的细节更丰富、信噪比更高等优势,以黑白图像作为基准和彩色图像进行融合后,图像的整体效果会有比较明显的提升(尤其是在暗光环境下)。

下图可以直观的看到黑白+彩色的双摄模式在提升细节方面的效果。下图中间是左边彩色图像和右边黑白图像融合的结果,可以明显的看到,细节更加清晰,图像质量更好。

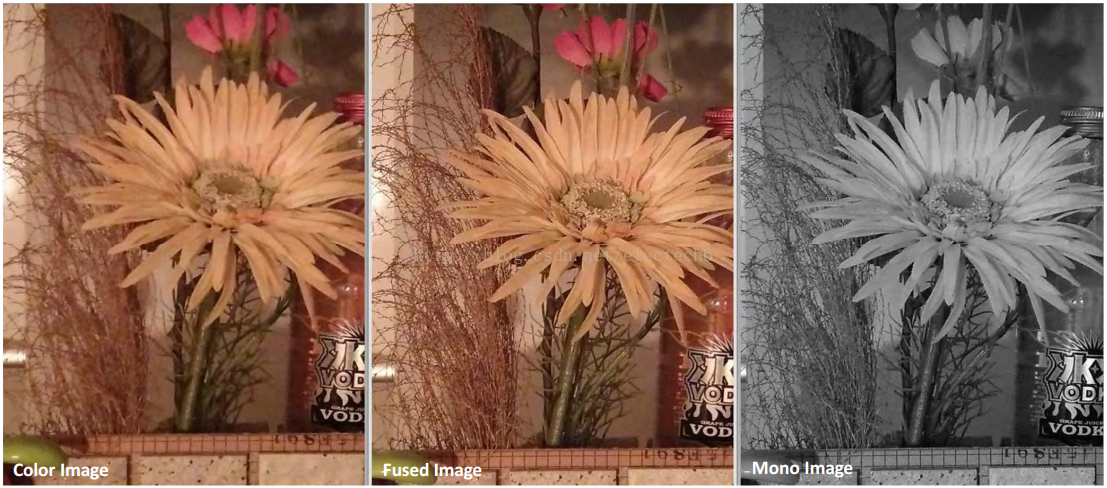

下图可以直观的看到,黑白+彩色的双摄模式可以显著提高暗光场景下的图像亮度,减少噪点,显示其在夜景拍照上的独特优势。

典型代表手机是:

360手机奇酷旗舰版、华为荣耀P9。

3.广角+长焦

这种组合最大的优势是光学变焦(optical zoom)。光学变焦镜头通常是由多组独立的凸/凹透镜组成的,有的透镜是固定的,有的是可以沿光轴前后滑动的。复杂的变焦镜头可以包含多达三十多个独立的透镜以及多个移动部件。

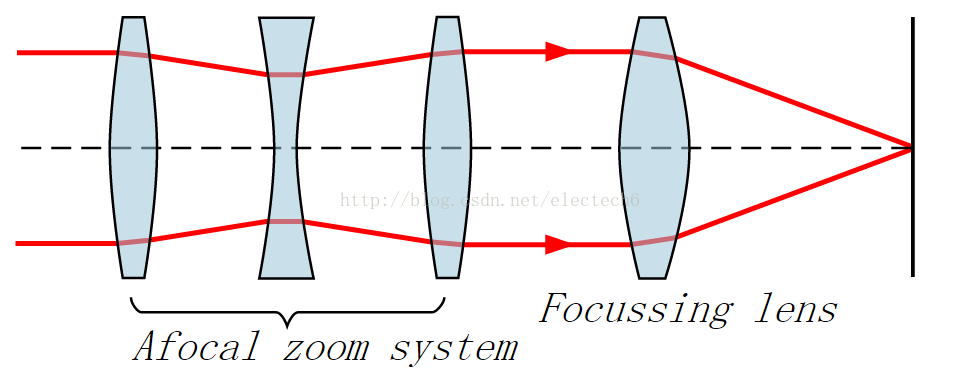

虽然变焦镜头的组成比较复杂,但是可以按照功能划分为两部分:无焦变焦系统( afocal zoom system)和聚焦透镜(focusing lens)。如下图所示。

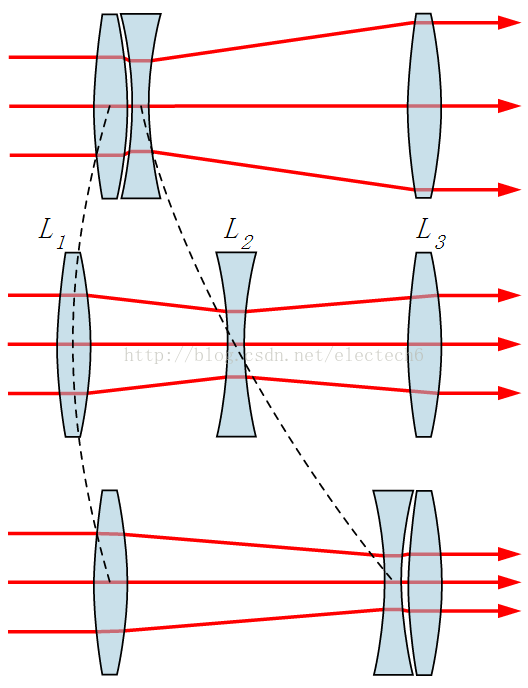

变焦的功能主要通过改变无焦变焦系统来实现,它由多个固定的和可移动的透镜组合而成,但是并不进行聚焦,它通过改变光束穿过透镜的位置来达到变焦的目的。以三个镜头为例进行说明。下图中L1,L3是凸透镜,用来汇聚光线,L2是凹透镜,用来发散光线。其中L3是固定的。L1,L2是可以沿着光轴移动的,这种移动非常微小,一般通过齿轮凸轮等传统的机械传动方式实现,或者更高级的私服系统来实现。下图中L2透镜从左向右移动,靠近L3,同时L1透镜先向左移动再向右移动。从图中可以看到这种组合移动的结果放大了透镜组的视场角,从而改变了整个透镜组的焦距。

如果有点蒙圈,参看下面这个简化版的变焦动态图,可能更容易理解。

说到了光学变焦,不得不提一下数字变焦。

数字变焦(digital zoom)和光学变焦(optical zoom)有着本质的不同,可以简单的认为数字变焦为“假变焦”。为什么说它假呢?粗糙的类比一下,数字变焦相当于你把照片放在一个图像编辑软件里,裁掉周围的一部分图像,然后把剩下的一部分放大。所以你看,数字变焦仅仅是一个类似放大的效果,并不能真正的起到变焦作用,所以数字变焦的结果通常噪点较多,图像比较模糊。下图是光学变焦和数字变焦的直观对比:

一直以来绝大多手机对于变焦(或者说远距离拍摄)的需求,都是通过严重压缩画质的数字变焦来完成。因此光学变焦是目前用户对于手机拍照功能的主要诉求点之一。但如前面所述,变焦镜头非常依赖于光学透镜的组合设计,因此想在单摄像头上实现光学变焦对于手机摄像头模组的厚度、复杂度和整体外观设计带来巨大的挑战。限于手机机身厚度,想做出不伸出机身外的变焦摄像头几乎不可能。

但是老话说的好,条条大路通罗马,何必吊死一棵树。单镜头既然不行,用两个镜头是不是可以呢?

双摄像头的理论基础,就是把原本要求纵向空间的光学体系,在横向空间里宽裕的机身平面上铺开。现今手机厚度已经不可逆转的向7mm甚至更薄发展,但横向看机背上与屏幕平行的平面的空间是足够的。说白了,比起把镜头做得不突出机身,在机背上多放几个镜头明显要更容易。

经过相机模组厂商和算法提供商的严苛研发和测试,目前广角+长焦的双摄像头的组合变焦方案逐渐被业界广泛接纳。这其实是一种非常朴素的变焦思路:用两个焦距不同的摄像头搭配,宽视角的广角镜头可以“看”的很广,但是“看”不清远处的物体,而窄视角的长焦镜头虽然“看”的范围不大,但是“看”的更远更清晰。广角和长焦镜头组合搭配,在拍照时通过镜头切换和融合算法就能实现相对平滑的变焦。法子虽然笨点,效果的确不错。高像素的长焦镜头能保证广角镜头因变焦而损失的图像信息远低于单摄像头的假变焦,从而大幅提高手机的变焦性能。该组合方式可以得到较好的光学变焦体验。下图是广角+长焦的融合效果:

典型代表手机是:LG G5、iPhone 7 plus

LG G5后置摄像机有两个,主摄像头1600万像素,视场角78°,f/1.8大光圈,暗光拍照效果比较好;辅摄像头800万像素,具有135°的超广角,这个是LG G5的杀手锏。LG G5的光学变焦方案就是在拍照时切换不同的镜头来实现光学变焦。但是这个135°的镜头已经算是鱼眼的范畴,它拍摄的图像边缘会出现畸变,并且还不是大家印象中鱼眼镜头那种由画面中心到四周均匀的光学性畸变,而是中间大部分画面正常而四周部分跳跃性的出现畸变。如下图所示。

LG G5拍摄图片,跑道可以看出横向上明显的不规则畸变

相比之下,后来者iPhone 7 Plus的配置更为合理。iPhone 7 plus的双摄像头升级是iPhone问世以来在摄像头方面最大的一次飞跃。

其配置如下:

-

广角镜头:1200 万像素,ƒ/1.8 光圈,焦距28毫米

-

长焦镜头:1200 万像素,ƒ/2.8 光圈,焦距56毫米

-

2 倍光学变焦;最高可达 10 倍数码变焦

通常来说焦距在85mm至300mm区域内的才可称为长焦镜头,而iPhone 7 plus的长焦镜头焦距只有56mm,只不过焦距比28毫米的镜头多了一倍,不过苹果也将其称为长焦镜头。

iPhone 7 plus的镜头组合并不像LG G5那样极端,可以避免出现边缘畸变。如下图左边是iPhone 7 plus广角相机拍摄的图片,右边是其长焦相机拍摄的图片:

这种广角+长焦镜头的光学变焦方案有什么问题呢?

这类双镜头搭配方案的光学变焦,本质和单反相机不同,更准确一点的话,应该称为双焦距。拿单反相机和iPhone 7 plus为例,我们来分析一下它们的2倍光学变焦有什么不同。

单反相机上的2倍光学变焦镜头,是可以实现无级光学变焦的,也就是可以实现1倍到2倍之间所有的焦距。用数学语言来说,就是可以实现[1,2]区间内任意实数倍的光学变焦倍数。这种光学变焦是平滑的。

而iPhone 7 plus的2倍光学变焦,实际是56毫米镜头在28毫米镜头数字变焦达到最远的时候切换到56毫米镜头,接过变焦的任务,这样使用起来就像是整体光学变焦能力提升了一倍。它是无法实现1倍到2倍之间的任意光学变焦的,其光学变焦只能取1和2两个值。这种光学变焦方式并不“平滑”。

那么就有人问了,为什么我使用iPhone 7 plus的时候感觉变焦很平滑啊,这是因为,苹果公司一向非常注重图像处理算法,所以iPhone系列手机摄像头通常在硬件上不是最先进的,但在拍照效果却一直非常出色。虽然iPhone 7 plus的双摄镜头光学变焦并非真正的平滑变焦,但在其强大的双摄图像处理算法的帮助下,实际使用时还是非常顺畅的,并不会出现变焦挫顿,仍然可以实现比单摄像头好的多的变焦效果和成像质量。

4.RGB +Depth

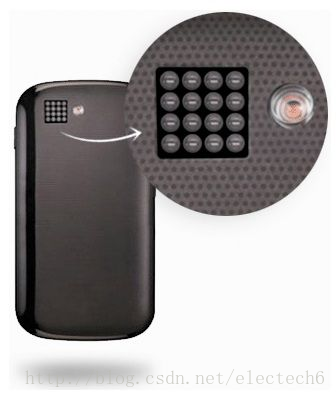

顾名思义,深度相机就是可以直接获取场景中物体距离摄像头物理距离的相机。根据原理不同,主要有飞行时间(TOF)、结构光、激光扫描几种方式(注:有些地方将双目立体视觉相机也列为深度相机的一种,它是单纯依靠算法计算得到的深度信息)。目前使用较多的是TOF相机。目前主流的TOF相机厂商有PMD、MESA、Optrima、微软等几家,其中MESA在科研领域使用较多;PMD是唯一在室内/外都能使用的TOF相机厂商,多用于科研、工业等各种场合;Optrima、微软则主要面向家庭、娱乐应用,价位较低。

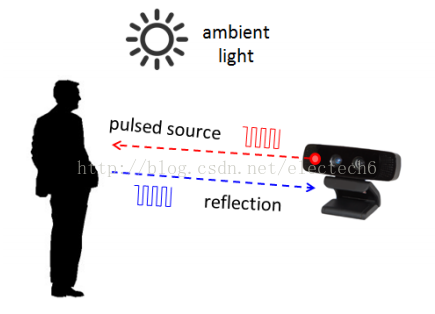

因为TOF相机使用的较为广泛,在此主要介绍一下TOF相机的原理。

TOF(Time of flight)直译为“飞行时间”。其测距原理是通过给目标连续发送光脉冲,然后用传感器接收从物体返回的光,通过探测光脉冲的飞行(往返)时间来得到目标物距离。这种技术跟3D激光传感器原理基本类似,只不过3D激光传感器是逐点扫描,而TOF相机则是同时得到整幅图像的深度(距离)信息。

TOF组成:

TOF相机采用主动光探测,通常包括以下几个部分:

1、照射单元

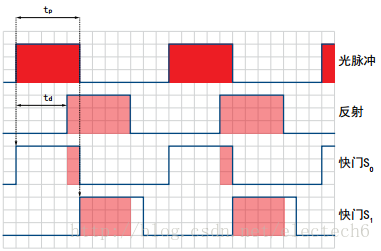

照射单元需要对光源进行脉冲调制之后再进行发射,调制的光脉冲频率可以高达100MHz。因此,在图像拍摄过程中,光源会打开和关闭几千次。各个光脉冲只有几纳秒的时长。相机的曝光时间参数决定了每次成像的脉冲数。

要实现精确测量,必须精确地控制光脉冲,使其具有完全相同的持续时间、上升时间和下降时间。因为即使很小的只是一纳秒的偏差即可产生高达15 c m的距离测量误差。

如此高的调制频率和精度只有采用精良的LED或激光二极管才能实现。

一般照射光源都是采用人眼不可见的红外光源。

2、光学透镜

用于汇聚反射光线,在光学传感器上成像。不过与普通光学镜头不同的是这里需要加一个带通滤光片来保证只有与照明光源波长相同的光才能进入。这样做的目的是抑制非相干光源减少噪声,同时防止感光传感器因外部光线干扰而过度曝光。

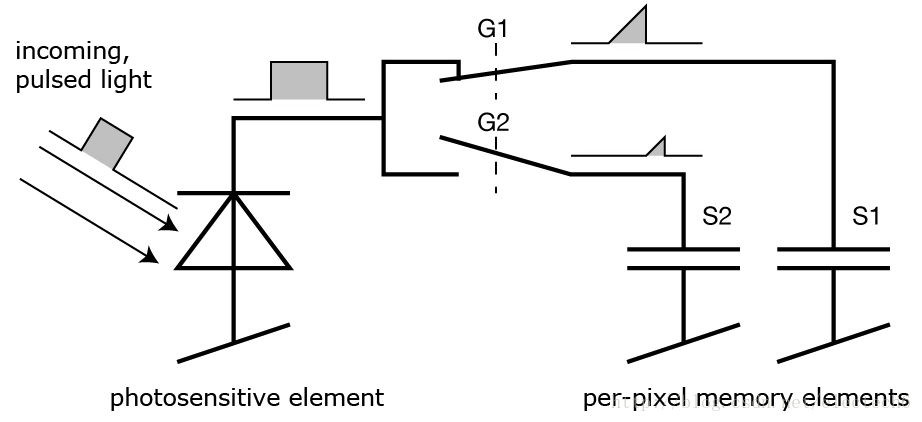

3、成像传感器

是TOF的相机的核心。该传感器结构与普通图像传感器类似,但比图像传感器更复杂,它包含2个或者更多快门,用来在不同时间采样反射光线。因此,TOF芯片像素比一般图像传感器像素尺寸要大得多,一般100um左右。

4、控制单元

相机的电子控制单元触发的光脉冲序列与芯片电子快门的开/闭精确同步。它对传感器电荷执行读出和转换,并将它们引导至分析单元和数据接口。

5、计算单元

计算单元可以记录精确的深度图。深度图通常是灰度图,其中的每个值代表光反射表面和相机之间的距离。为了得到更好的效果,通常会进行数据校准。

TOF测距原理:

照射光源一般采用方波脉冲调制,这是因为它用数字电路来实现相对容易。深度相机的每个像素都是由一个感光单元(如光电二极管)组成,它可以将入射光转换为电流,感光单元连接着多个高频转换开关(下图的G1,G2)可以把电流导入不同的可以储存电荷(下图S1,S2)的电容里。

相机上的控制单元打开光源然后再关闭,发出一个光脉冲。在同一时刻,控制单元打开和关闭芯片上的电子快门。由光脉冲以这种方式产生的电荷S0存储在感光元件上。然后,控制单元第二次打开并关闭光源。这次快门打开时间较晚,即在光源被关闭的时间点打开。现在生成的电荷S1也被存储在感光元件上。

因为单个光脉冲的持续时间非常短,此过程会重复几千次,直到达到曝光时间。然后感光传感器中的值会被读出,实际距离可以根据这些值来计算。记光的速度为c,tp为光脉冲的持续时间, S0表示较早的快门收集的电荷, S1表示延迟的快门收集的电荷,那么距离d可以由如下公式计算:

最小的可测量距离是:在较早的快门期间S0中收集了所有的电荷,而在延迟的快门期间S1没有收集到电荷,即S1 = 0。代入公式会得出最小可测量距离d=0。

最大的可测量的距离是:在S1中收集了所有电荷,而在S0中根本没有收集到电荷。然后,该公式得出d= 0.5 x c × tp。因此最大可测量距离是通过光脉冲宽度来确定的。例如,tp = 50 ns,代入上式,得到最大测量距离d = 7.5m。

TOF相机影响因素:

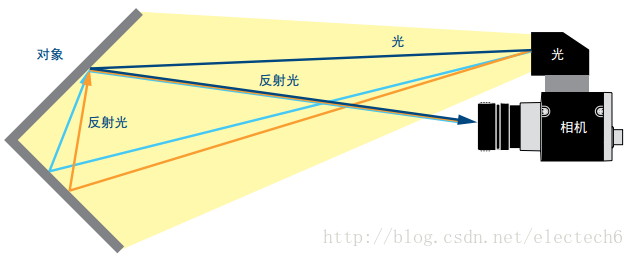

1、多重反射。

距离测量要求光只反射一次。但是镜面或者一些角落会导致光线的多次反射,这会导致测量失真。如果多重反射使得光线完全偏转,则没有反射光线进入相机,从而无法正确测量反射面的距离。反之,如果其他方向的光通过镜面反射进入芯片,则可能会发生过度曝光。

2、散射光

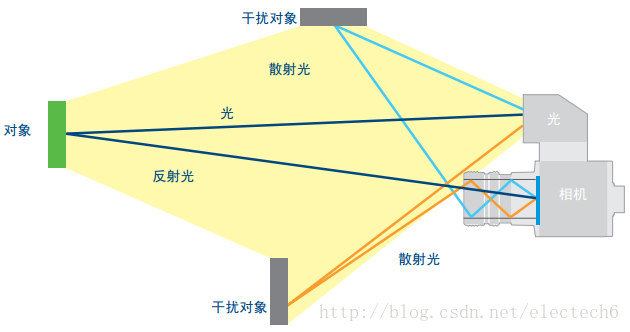

在镜头内或在镜头后面发生多余反射会出现散射光,如下图所示,散射光会导致图像褪色,对比度下降等不良影响。所以要避免在相机正前方有强烈反光的物体存在。

3、环境光

前面说过,深度相机镜头上会有一个带通滤光片来保证只有与照明光源波长相同的光才能进入,这样可以抑制非相干光源提高信噪比。这种方式确实能够比较有效地过滤掉人造光源,但是,我们常见的日光几乎能够覆盖整个光谱范围,这其中包括和照明光源一样的波长,在某些情况下(如夏天的烈日)这部分光强可以达到很大,会导致感光传感器出现过度曝光。因此相机如果想在这种条件下正常工作,仍然需要额外的保护机制。

4、温度

电子元件的精度受温度的影响。所以当温度波动时会影响电子元件的性能,从而影响到脉冲调制的精度。前面说过一纳秒的脉冲偏差即可产生高达15 c m的距离测量误差,因此相机要做好散热,这样才能保证测量精度。

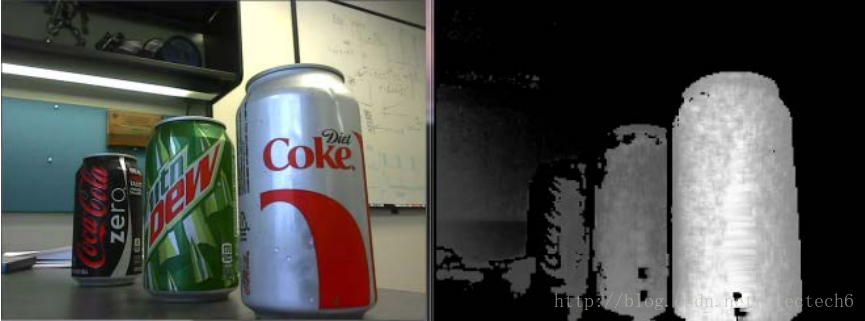

TOF相机输出:

TOF相机内部每个像素经过上述过程都可以得到一个对应的距离,所有的像素点测量的距离就构成了一幅深度图,如下图所示。左边是原图,右边是对应的深度图。

可以看到深度图其实是一张灰度图,它是一张三维的图:水平垂直坐标对应像素位置,该位置的灰度值对应的是该像素距离摄像头的距离。所以深度图中的每个像素可以表示空间中一个点的三维坐标,所以深度图中的每个像素也称为体像素(voxel)。

深度信息融合

当我们获得了深度图后,下一步就是要把深度信息融合到普通RGB相机拍摄的彩色图片。这一步并非我们想象的那么容易,需要强大的算法来保障。在此列举两个因素为例进行说明:

1、深度相机的分辨率目前还比较低,一般都是VGA(640 x 480)以下。而现在普通的RGB相机分辨率都已经到千万像素级以上了,是深度相机分辨率的几十倍甚至上百倍。因此需要将低分辨的深度图变成和RGB相机一致的高分辨率,这种“从无到有”的分辨率提升需要利用彩色图中物体的纹理、边界等内容信息,这个过程要想保持细节是比较困难的。

2、深度相机和彩色相机融合时还需要知道两个相机的畸变系数、光学中心、相对旋转/平移量等一系列参数,这就需要对两个相机进行相机标定工作。而深度相机的低分辨率对于相机标定工作也是一个较大的挑战。

TOF Vs 双目视觉

读者可能会有疑问,现在双摄手机上的两个普通的彩色相机不就可以计算深度吗?和这个深度相机测距有何不同?

双目立体视觉测距的原理和人眼类似,通过计算空间中同一个物体在两个相机成像的视差就可以根据如下三角关系计算得到物体离相机的距离:

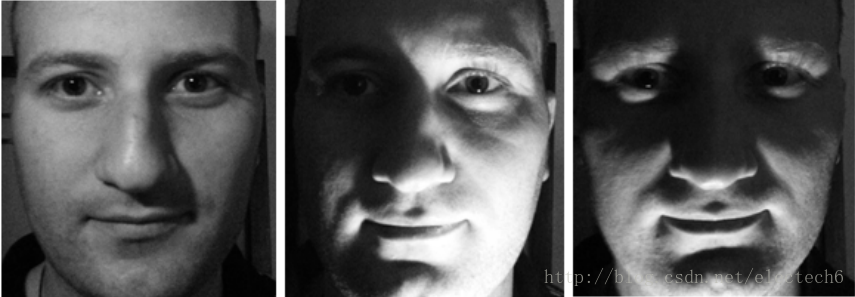

但是说起来容易,算法实现比较困难,双目立体视觉测距算法的核心就是寻找对应关系。可以理解为给定一个相机拍摄的图片中的任意一个像素点,如何在另外一个相机拍摄的图像中找到和它对应的像素点,这个过程需要特征提取、特征匹配等一系列复杂的算法。但是由于光照变化、光线明暗等外在因素的影响,拍摄的两张图片差别可能比较大,这会对特征匹配算法提出很大的挑战。如下图是在不同光照条件下拍摄的图片:

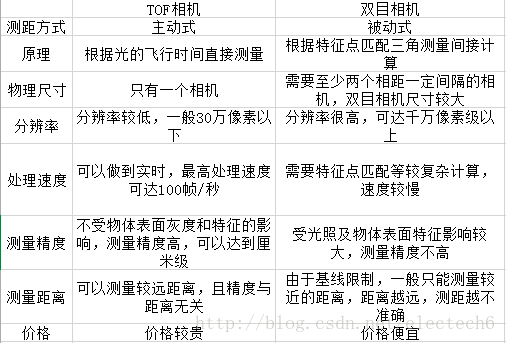

另外,如果拍摄的物体缺乏纹理和细节(比如拍摄一张白纸)的话,也很难进行特征匹配。这些都对算法的鲁棒性提出了很大的挑战。虽然TOF相机和双目立体视觉都能实现测距的功能,但是它们还是有很大不同,在此我做了了简单的表格如下:

结构光

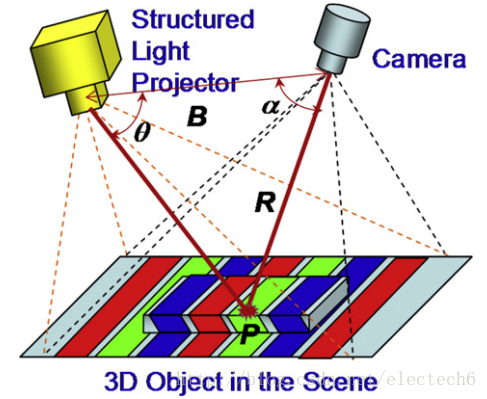

结构光技术就是使用提前设计好的具有特殊结构的图案(比如离散光斑、条纹光、编码结构光等),然后将图案投影到三维空间物体表面上,使用另外一个相机观察在三维物理表面成像的畸变情况。如果结构光图案投影在该物体表面是一个平面,那么观察到的成像中结构光的图案就和投影的图案类似,没有变形,只是根据距离远近产生一定的尺度变化。但是,如果物体表面不是平面,那么观察到的结构光图案就会因为物体表面不同的几何形状而产生不同的扭曲变形,而且根据距离的不同而不同,根据已知的结构光图案及观察到的变形,就能根据算法计算被测物的三维形状及深度信息。

业界比较有名的就是以色列PrimeSense公司的Light Coding的方案,该方案最早被应用于Microsoft的明星产品Kinect上。目前该公司被苹果公司收购,可见苹果公司也将在深度相机领域有所动作。

结构光技术受环境光源影响较大,更适合室内的应用场景,而且帧率较低,所以更适合静态场景或者缓慢变化的场景。其优势就是能够获得较高分辨率的深度图像。

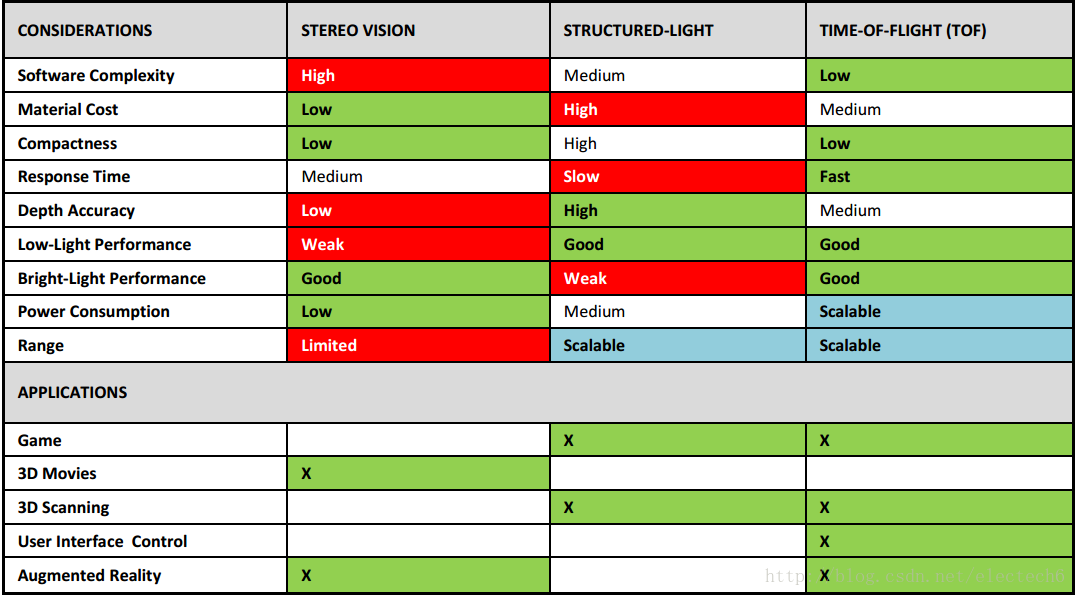

TOF方案具有响应速度快,深度信息精度高,识别距离范围大,不易受环境光线干扰等优势。因此想要在移动端直接实现深度的测量,最有竞争力的就是TOF方案了。三者的区别:

典型手机

典型代表手机:联想Phab 2。

目前可以买到的具备直接深度测量的智能手机只有Google和联想合作的联想Phab 2,2016年11月推出,是全球首款支持Google Project Tango技术的手机,其深度相机采用TOF技术方案,由PMD公司提供。

华硕也宣布将在2017年会推出带深度相机的手机Zenfone AR,号称是全球首款同时支持Google Project Tango(AR)和Daydream(VR)的手机。

深度相机应用

深度相机的应用在智能人机交互、人脸技术、三维重建、机器人、AR等领域全面开花,目前商用深度相机最成熟的应用就是移动终端上基于人脸技术的多种有趣应用。

人脸技术

二维人脸技术发展了几十年虽然已经比较成熟,但是人脸关键点检测在各种大角度、多表情、复杂光照、面部遮挡等情况下,想要实现实时鲁棒的高精度检测仍然比较困难。而高精度深度相机的出现极大的推动了人脸技术的发展,从二维直接跃升到三维。不得不说,iPhoneX的前置深度相机可谓是把三维人脸技术提升到了一个新的高度。它不受制于自然光照,即使前景和背景颜色相近也能实现完美的分割,在复杂头部姿态下的表现大大优于二维人脸技术。基于结构光的深度相机通过3万个红外散斑重建的三维人脸模型非常精细。

有了精细的三维人脸模型,可以发展出一系列超级实用、好玩的应用。下面的应用场景有些是刚刚商用的,有些还在萌芽状态。

1、更加精细自然的背景虚化

相比于双摄的背景虚化,深度相机能够重建高精度的三维人脸模型,虚化效果层次感更强,细节更加丰富,人像更加立体自然。

2、人像光效

人像光效的功能可以模仿专业人像摄影时的打光效果,营造出让人赞叹的影棚级效果。

3、动画表情

动画表情可以将人脸表情实时转移到玩偶上,是一个非常有趣的应用,正是得益于深度相机获取的精细的 三维人脸模型,才能实现如此精细的表情捕捉。

4、三维美颜

可以不夸张的说,三维美颜是对二维美颜的降维打击。二维美颜效果一般比较夸张,丢失了人脸本身的很多特征,导致常常“认不出来自己”的尴尬。而三维美颜更强调真实和立体,不仅能够全面继承二维美颜的效果,还可以根据三维的脸型进行定制化“微整容”,如隆鼻、丰唇、削掉高颧骨,去掉双下巴,调整五官比例等;此外还可以增加光影效果,如增加鼻子、脸颊两侧的阴影,使得人脸看起来更有立体感和真实感。

5、三维人脸活体识别

三维人脸识别是真正安全的人脸识别,可以有效的避免照片/屏显图片、换脸算法、戴面具/3D人脸模型等破解方法。非常适合于活体检测。

6、人眼视线校正

很多时候我们拍美照时并没有直视镜头,回看时懊悔不已。其实这个可以通过算法进行校正。根据人脸三维模型,结合人的面部朝向,我们可以将视线的方向调整到正对摄像头的方向,产生的视觉效果更有冲击力。

当然,这只是一个典型的应用。理论上来说,我们可以任意操纵眼球的转动,基于此可以开发一些好玩(奇怪)的应用。

智能人机交互

1、人体骨架提取和跟踪

Microsoft推出的Kinect系列深度相机就是专门为体感游戏而生的。

体感交互背后的关键技术就是人体骨架提取和跟踪。传统基于RGB图像的骨架提取跟踪技术在有多人交叠的情况下性能下降很快,而深度相机生成的深度图可以很方便的区分不同远近的人体和背景,这非常有利于多人交叠下不同人体骨架的提取。

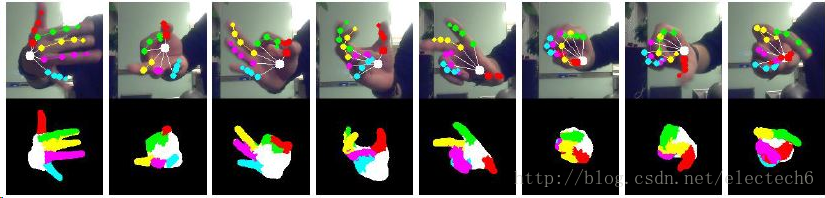

2、手势识别跟踪

和人体骨架提取和跟踪类似,手势识别跟踪也属于自然肢体语言。相较于RGB相机,深度相机可以更快速更准确的实现手指关键点的提取和跟踪。

基于手势识别跟踪可以开发很多实用、有趣的应用。第一个广泛的应用就是游戏娱乐:比如在射击类游戏中,你只要把手握成手枪状,食指扣动就可以“放枪”,这种从孩童时期就很熟悉的身体语言被运用到游戏中,让用户感觉自然而亲切。第二个就是在环境苛刻或比较危险的特殊行业,有极大的应用需求:比如通过手势可以非接触式的操控无尘车间机器或者危险区域工作的设备,可以解决很多实际问题。

三维重建 & 机器人

1、三维空间测绘

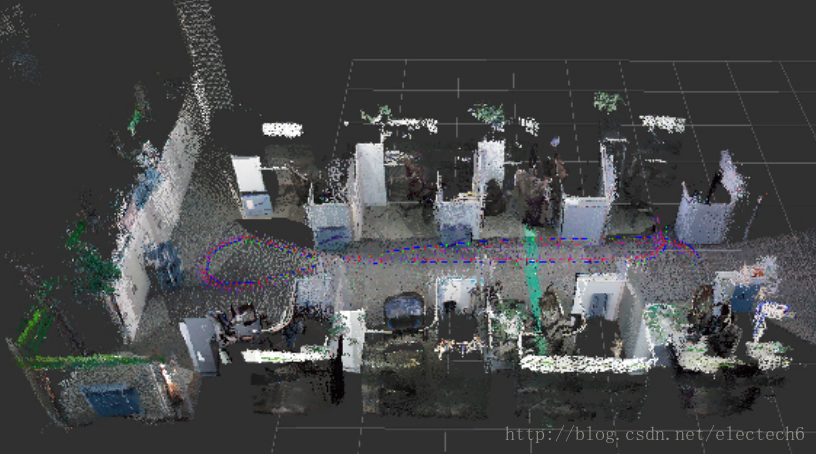

深度相机本身就可以直接测距,下图是Phab2 pro手机后置TOF深度相机在三维空间测量示意图。

2、物体三维重建

以前对人体或者物体进行三维重建需要复杂的激光扫描设备,距离消费级应用还很遥远。随着技术的发展,高精度、小型化的深度相机可以方便快速的完成扫描和三维重建工作。这可以极大的促进虚拟试衣,三维打印等技术的发展。

3、大尺度三维空间地图重建

和小尺度的物体重建不同,较大尺度的三维空间地图重建难度更高,一直都是学术研究的前沿,其中关键技术称为即时定位与地图构建(SLAM,参考文章《SLAM初识》)。SLAM是智能机器人和AR的核心技术之一。基于RGB-D深度相机的SLAM也一直是研究热点,随着深度相机性能的提升及算法的迭代,高精度实时鲁棒的SLAM技术正越来越成熟。

4、机器人自主导航

深度相机的水平视场角能够直接探测障碍物的距离,垂直视场角可以探测地面凸起或者上方障碍物,这极大提升了机器人利用视觉避障的能力。

在自身定位及地图重建导航方面,三维的视觉SLAM应用明显优于二维视觉SLAM。但三维视觉SLAM距离商用还有一段路要走,主要的原因有两个:一是深度相机的远距离测量精度还不够理想,它比激光雷达测到的平面数据在精度和稳定性都要差一些;二是RGB-D SLAM的算法和应用还需进一步发展完善,其性能效果和计算资源的消耗尚无法满足成熟商用需求。

AR

AR大规模商用离我们越来越近了。想要实现实时的、身临其境的AR体验离不开高帧率、高鲁棒的深度图。AR互动核心技术之一是实时精准的SLAM技术,基于深度相机的SLAM方案是一个比较靠谱的解决方案。

总结

目前深度相机在移动端的应用需求非常强烈,但是大部分的消费级深度相机仍存在:体积较大,成本较高,精度及鲁棒性不足的问题。因此适用于移动端的深度相机模组、计算机视觉算法资源比较稀缺。不过,受苹果的影响,目前整个安卓手机产业链正在快马加鞭,快速跟进适用于手机端的深度相机解决方案。

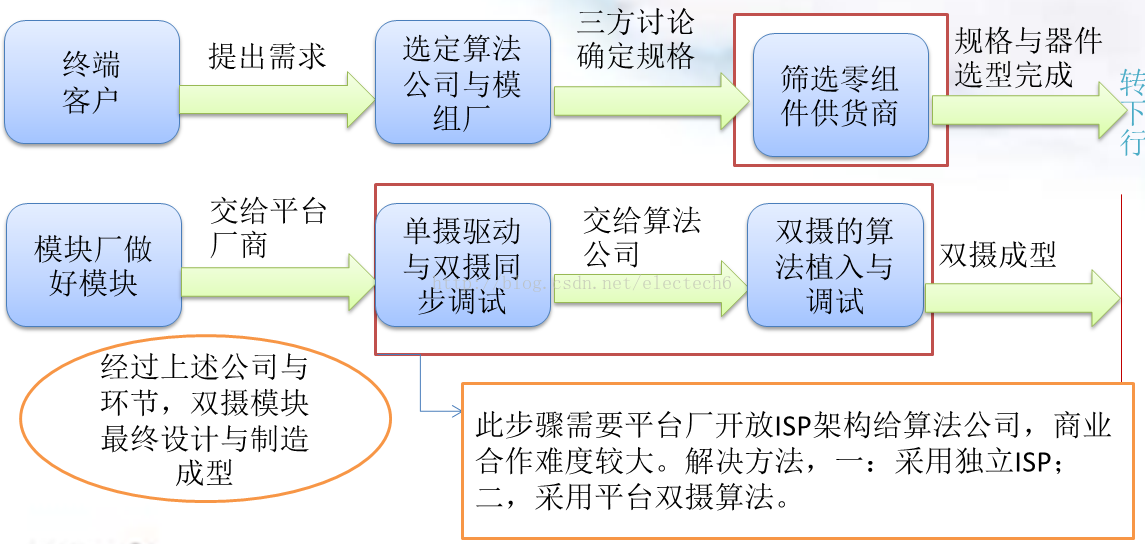

智能手机双摄像头产业链

随着近两年手机双摄技术的发展,双摄像头技术在夜拍降噪、快速对焦、光学变焦、景深应用等方面已经展示出了较好的效果。这离不开从底层的图像传感器芯片到中层的双摄处理算法再到顶层的手机厂商的一系列的努力。今天来说一说和手机双摄有关的产业链。双摄像头市场由终端客户,算法公司,模组厂,零组件供货商,平台厂等共同组成。

双摄技术的难点

1、算法资源稀缺。

目前全球核心的双摄算法公司仅有Arcsoft、Corephotonics、Altek、Linx(已被苹果收购)、平台厂等几家。而产品应用与设计都是基于算法基础展开的。

2、制造难度大、产业规模化投资大。

双摄模组相较于普通的单摄模组,对制造精度有着更严格的要求,因此制造难度较大,对技术和设备都有非常高的要求。对这个问题,行业做出不仅一次的探讨,最终找到解决办法:引进AA制程。但引进AA制程的过程中,产业也仍需要再次面临高成本、高技术等新问题。

双摄算法公司

算法是双摄应用与技术的基础,选择的算法方案决定了技术设计方案,配合的硬件选型,制造难度等。目前能提供成熟算法的公司屈指可数,各家所擅长的领域又各有不同。全球范围内知名的双摄算法公司主要有:

虹软(ArcSoft)1994年在美国硅谷成立,目前主要研发中心设在中国大陆的杭州、上海、和南京。虹软的强项是光学变焦、暗光拍照、HDR、重对焦等。手机合作厂商有:三星、LG、小米、vivo等。

一家以色列的公司。其算法的优势主要在光学变焦(optical zoom)和夜景拍摄(nightshot)、光学防抖(optical image stablization)、光学焦外成像(optical bokeh)。手机合作厂商有:三星、OPPO等。

华晶科技是1996年成立的一家台湾的公司,在距离应用,光学变焦和暗光补偿都有所建树。

Linx由三星算法团队前负责人和以色列国防公司Rafael Advanced Defense Systems的高级光学专家在2011年所共同创建,2015年被苹果公司收购。其技术已经用在了iPhone7 Plus的双摄中。

此外,平台厂商高通、联发科、华为海思、上海兴芯微(X-Chip)都有自己的ISP(图像处理器),也在开发自己的双摄算法。

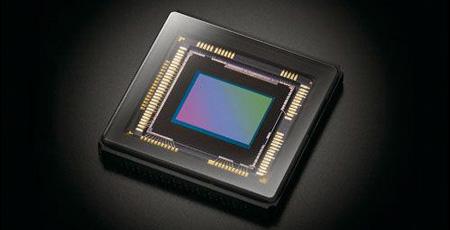

双摄图像传感器供应商

双摄图像传感器供应商主要有:Sony、Samsung,OmniVision,格科微。其中Sony具有霸主地位,得益于它在高像素领域的技术领先地位,其图像传感器已经成为中高端手机的标配。主要客户为苹果、Samsung、OPPO、Vivo等手机大厂。

双摄 模组供应商

双摄模组厂具有较高的技术、资金、客户资源壁垒。目前主要的双摄模组供应商按照地区分如下:

-

韩国:三星电机(SEMCO),LG Innotek(iPhone 7 plus)、Namuga

-

日本:夏普(Sharp)、索尼(Sony)

-

大陆:浙江余姚舜宇光学(Sunny)、深圳欧菲光(O-Film)、江苏昆山丘钛(Q-Tech)

-

台湾:光宝(Liteon)、富士康

-

香港:信利(Truly)

其中比较有竞争力的主要有:光宝,舜宇、信利、三星机电、Namuga。这里我们重点说明大陆的模块厂商表现。

舜宇作为大陆最老牌的模块厂,技术积淀最为深厚。在双摄上达到自研AA设备的水平。2015年舜宇宣布双摄研制成功,2016年成为华为P9双摄的主供货商。舜宇目前是大陆双摄最受益厂商。

欧菲光2012年成立,作为模块厂的后来者,在人才与设备引进上从不吝啬,发展势头惊人,2015年下半年出货量跃居国内首位。小米是其走量最大的客户,同时依靠和小米的合作,欧菲光实现双摄的量产。

丘钛作为大陆第三大的模块厂,在双摄上投入巨资购入AA设备。为了抢夺双摄订单,丘钛在市场上报价相对偏低。依靠红米PRO,成功量产双摄,并独家供应乐视酷派COOL1。红米与COOL1都是主打性价比的千元机,利润有限。丘钛要想向上突围还需努力。

双摄镜头厂商

双摄技术对镜头的一致性、FOV(Field Of Vision)等要求比较高,市场领头羊是位于台湾的大立光电(Largan)。随后就是中国大陆的舜宇光学。另外像日本的康达智株式会社(kantatsu),韩国Sekonix等公司技术实力也比较强,但要被陆厂大规模采用不太现实。

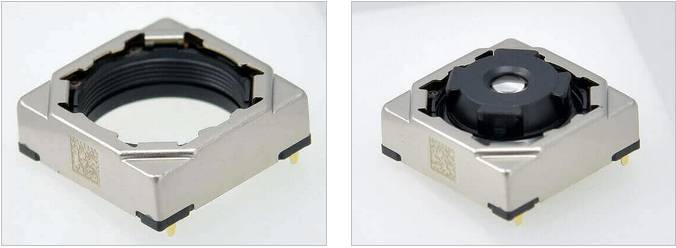

双摄马达供应商

双摄一般采用音圈马达(Voice Coil Motor,简称VCM),市场选型集中在:日本的TDK株式会社、三美电机株式会社(Mitsumi)、韩国的Jahwa几个厂商。

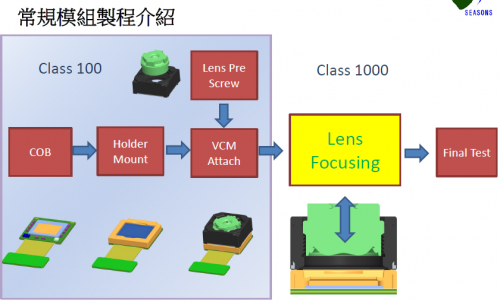

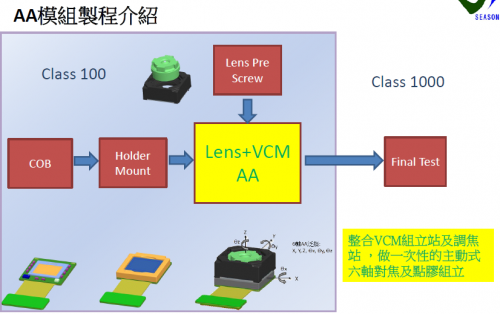

双摄AA制程

AA(Active Alignment)制程,即主动对准技术,是一项确定零配件装配过程中相对位置的技术。

在摄像头封装过程中,涉及到图像传感器、镜座、马达、镜头、线路板等零配件的多次组装,传统的封装设备均是根据设备调节的参数进行零配件的移动装配的,因此零配件的叠加公差越来越大,最终表现在摄像头上的效果是拍照画面最清晰位置可能偏离画面中心、四角的清晰度不均匀等。

传统常规制程和AA制程的区别如下:

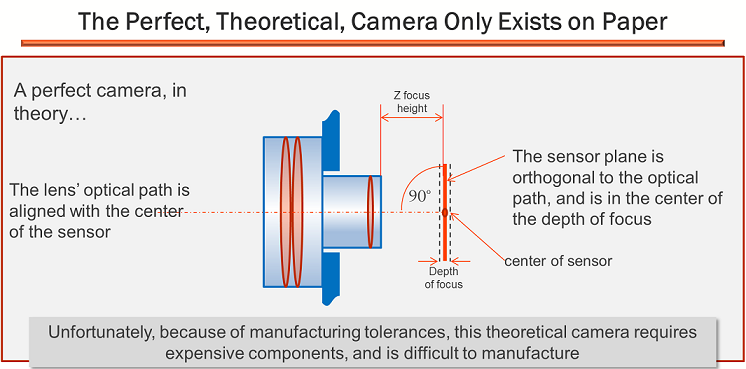

具体说来,理想的封装结果如下:

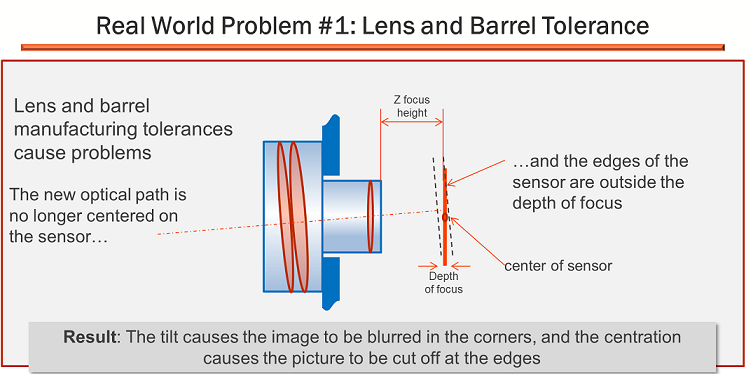

但是理想很丰满,现实却很骨感。实际操作时很可能会出现镜头有装配误差的情况:

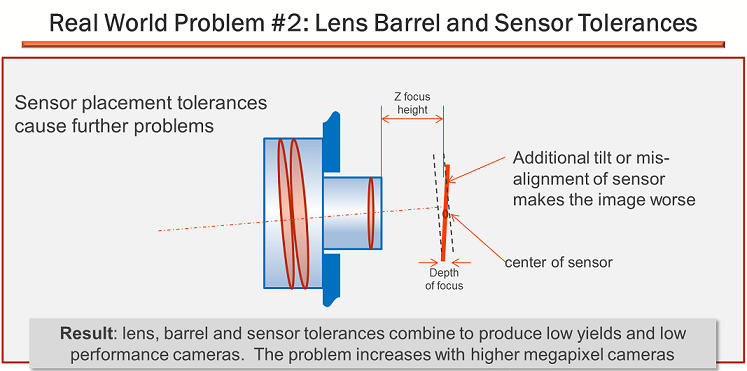

实际操作时也可能会出现镜头和图像传感器都有装配误差的情况:

而在图像传感器的分辨率不断增加和单像素尺寸不断减小的情况下,镜头组装到传感器的相对定位的准确性要求越来越高,传统的封装设备已经不能满足。

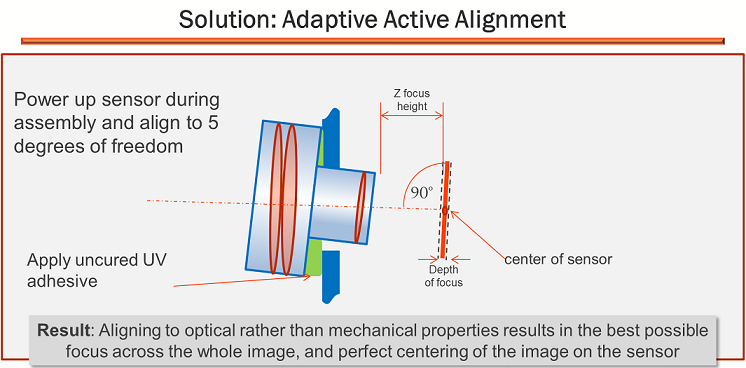

而AA制程采用了不同的思路,不再要求每个零配件的组装都达到局部最优,而是采用了更灵活的全局最优策略。AA制程设备在组装每一个零配件时,首先检测被组装的半成品,并根据被组装半成品的实际情况主动对准,然后将下一个零配件组装到位,这种方式可有效的减小整个模组的装配公差。AA制程主动校准技术,可调节镜头对准至6个自由度。通过调节相对位置和镜头倾斜,可确保拍照画面中心最清晰,使得画面四角具有均匀的清晰度,有效的提升摄像头产品一致性。这在对产品封装要求更高的双摄像头中尤为重要。

AA制程说起来很简单,就是六个自由度来对模组的装配进行调整,从而找到正确的对焦位置,但是实行起来却并不是一件容易的事。可以用“高技术、高投资、高品质”这“三高”来形容AA制程的门槛。

先来说高技术,并不是所有的模组都适合做AA,AA模组必须要做特别的结构设计,并且在生产中要有特别的夹具来配合。再说高投资,目前的AA机台都是比较贵的,每台价值30-40万美金。最后说高品质,AA机台除了要高效外,还要保证模组调度效率的一致性、稳定性和平衡性。

能提供AA机台的设备公司主要有香港先进太平洋科技(ASM)、日本Pioneer、韩国hyvision几家公司。此外,中国大陆的舜宇光电从2011年开始就在双摄模组开始投入,目前已经自主开发有自己知识产权的AA机台设备,在此轮双摄像头的竞争开始阶段跑在了前面。无论是量产经验还是规模,都将其他厂商抛在了身后。

总结

目前双摄已经是众多旗舰机的标配,双摄已成燎原之势,其在拍照技术上的提升也逐渐得到了市场的认可,预计未来会逐渐普及到低端机。同时未来双摄如果能在深度相机上有所突破,必然是对产业链的一次重大变革。

未来智能手机摄像技术发展趋势:硬件

1、双摄像头基线增大

最近两年双摄像头逐渐在许多高端旗舰机上出现,由于双摄技术在暗光拍照、重对焦、光学变焦、背景虚化等方面都展现了较好的效果,已经逐渐由“噱头”变成了标配。随着技术的成熟和成本的降低,预计未来会很快普及到普通智能手机。

目前手机双摄配置一般是平行放置,也有少部分是竖直放置。但是两个摄像头中心距离(基线)比较近,一般是10mm左右。一个原因是因为目前的双摄应用还是倾向于通过融合两个摄像头的图像来实现画质增强的效果,这种情况下两个摄像头离的近,取景范围相差很小,这样在两张图片进行融合的时候就不会因为错位产生不良的影响。另一个原因就是目前很多双摄模组都是共基板式结构,如下图所示,两个摄像头传感器共同放在同一个基板上,然后FPC连接线从此基板上引出来。

另外一种双摄模组结构是共支架结构。如下图所示,两个单摄像模块通过支架固定住,每个单摄像头模块有自己的基板和自己的连接线。

由于目前的双摄像头基线较小(1cm左右),所以视差也很小,只能计算较近的景深,因此与景深密切相关的三维应用还有很大的发展空间。所以,笔者认为与此有关的用户需求会催生出大基线的双摄像头配置,两个摄像头之间离得比较远,得到的两张图之间相差足够大,就能计算出较远物体的景深。

那么多少的双摄基线比较合适?

笔者认为未来双摄大基线很可能和人双眼的瞳距比较接近,毕竟这更符合人类观察世界的方式。人类双眼瞳距平均为6.3cm左右,因此如果双摄镜头中心基线为6.3cm的话,加上镜头的直径(1cm),保守估计双摄最左到最右至少需要7.3cm以上(不考虑弧形边缘影响)。

iPhone 7 的屏幕是4.7英寸,手机长宽尺寸是 138.3mm×67.1mm。

iPhone 7 plus 的屏幕是5.5英寸,手机长宽尺寸是158.2mmx77.9mm。

所以如果采用大基线的双摄配置,未来的大屏幕手机可能会采用如下图左的双摄配置,小屏幕手机可能会出现下图中的双摄配置。如果既想保持小基线双摄在图像融合增强画质方面的能力,又想利用大基线双摄增大视差来获得更远的景深的优势,可能会出现下图右的上下两个双摄配置。

大基线双摄虽然间距增大,但要想展现双摄的优势,两摄像头并不能独立工作,必须同步协调工作。这会给上下游产业链带来一系列难题,比如大基线双摄模组如何连接固定,如何同步信号,多摄像头如何标定,如何提高多摄的处理速度等。不过相信随着技术的发展,这些问题应该可以得到很好的解决。

2、深度相机即将爆发

深度相机并不是一个新鲜玩意儿。现在的双摄像头技术也可以利用双目立体视觉算法间接计算出被摄物体距离镜头的距离。但是如前所述,由于目前双摄的基线太短,对于较远距离外的物体算法并不能给出很准确的结果。而且由于算法需要进行两张图的特征点匹配,所以该方案对于纹理较少的场景(天空、白墙等)效果并不太理想。还有就是由于根据立体视差计算深度信息严重依赖算法,计算量比较大,处理速度就比较慢。那有木有性能比较鲁棒、响应速度又比较快的深度相机呢?

这个必须有,常见的有TOF(time of flight)技术和结构光技术。一般这样的相机物理尺寸都比较大,随着硬件厂商的技术迭代,目前已经出现适合智能手机的深度相机。

这里不得不提一下全球首款搭载了Google Tango技术的联想手机Phab 2 Pro。它装备了两个RGB相机(一个鱼眼运动追踪相机一个大尺寸感光相机)和一个TOF深度相机(PMD公司提供)。这是市面上目前唯一搭载TOF深度相机的手机。

具备了深度相机有什么用呢?

TOF深度相机具有实时响应速度、深度信息精度高、识别距离范围大、不易受环境光线干扰等优势。二维图像再叠加一维的距离信息,就可以像人眼一样实时的用三维的视角观察世界。这将极大促进对实时性和距离精度要求较高的三维应用。

3、更高倍数的光学变焦

在手机上实现光学变焦而又不使得镜头突出来是件很困难的事,目前手机上实现光学变焦一般都是通过一个广角镜头加一个长焦镜头的双摄组合技术方案。这种光学变焦方式实际上是一种双焦距,一般只能达到2倍的光学变焦。

但在2017年初的MWC全球移动通信大会上,OPPO的潜望式5倍光学变焦原型机赚足了眼球。如下图所示:

该方案在行业内实属首例,它的主摄像头是普通平置的广角镜头,副摄像头的设计非常大胆,将原来需要长通道的长焦镜头沿垂直屏幕的方向横置摆放,再通过特制的光学棱镜,让画面光线折射到长焦镜头里的图像传感器,这一设计将本来必须突出的镜头隐藏在手机内部,可以在保证手机轻薄的同时,实现较高的光学变焦倍数。

此外,长焦镜头还具有光学防抖功能保障成像质量。这是因为,外部光线首先需要经过一个折射棱镜才能进入长焦镜头最终成像,这一过程要保证光路具有较高的精度,如果没有光学防抖,光路的一点偏移就会被放大,对成像质量造成致命影响。其光学防抖示意图如下:

当然,OPPO的这种方案对供应链中的模组厂商、镜头厂商、音圈马达、算法提供商等都提出了巨大的挑战,想要保证良品率实现量产还有很多路要走。

智能手机的摄像功能越来越向单反相机看齐,单反有大光圈背景虚化,智能手机的双摄背景虚化也做的了(效果和单反差距仍很大);单反可以轻松实现10倍光学变焦,潜望镜式双摄也能做到5倍。你单反个子大,可是我兄弟多(多个摄像头),三个臭皮匠还顶个诸葛亮呢!相信未来借助更多的新技术,在智能手机实现高倍光学变焦不是梦,不是梦~

4、阵列相机或将复出

早在2013年,Nokia和Pelican公司合作开发由16个镜头组成的4×4阵列式摄像头。每个摄像头都可以单独捕捉图像,然后通过算法合成渲染成一张照片。

阵列相机的优势是它不需要音圈马达;拍摄时不需要对焦,它抓取全景深的图像,通过处理器的后处理来实现任意对焦需求。相比传统相机,阵列相机能够拍摄出更大的景深空间,甚至能够呈现出3D效果。

但Nokia的这款阵列相机没有发展起来,主要有两个原因:第一是当时手机芯片的运算能力还达不到要求,处理速度太慢;第二是当时单个摄像头的分辨率不高,没办法显著提升画质。

但技术的发展是突飞猛进的,随着双摄技术的成熟发展,产业链上下游已经积累了很多多摄的经验,阵列相机存在的瓶颈将得到解决。想象一下未来一个阵列相机中若集合了高分辨率RGB相机、黑白相机、广角/鱼眼镜头相机、长焦镜头相机、TOF深度相机该会是多么的强大!随着更多摄像头的加入,将会给手机带来更多更新的应用和商业模式。

也许,不久的将来,你的手机将会搭载如同蜜蜂一样的仿生复眼相机阵列,既有广阔的视野又能够像高倍望远镜一样望远,同时又能感知和理解三维世界,这必将重新定义手机的价值。

未来智能手机摄像技术发展趋势:应用

最近几年手机摄像头的分辨率越来越高,目前最高可以达到几千万分辨率。这对于大部分的拍照场景其实已经足够。早先的手机摄像技术主要关注如何呈现更清晰的画质,如何把人物拍的更好。随着摄像头硬件的发展逐渐进入成熟期,笔者认为手机影像下一步发展的重点就是如何更加有效、有趣地使用好这些图片和视频。未来手机摄像技术的发展将越来越重视两个因素:计算机视觉算法和人工智能。

下面结合计算机视觉技术和人工智能的发展趋势,从个人的角度预估一下即将爆发的以及未来可能出现的一些应用场景。

1、实时三维空间应用

当智能手机的深度相机发展起来后,就可以实时获取比较精确的环境深度图,这将会解锁一大批三维相关应用,比如空间测量、人体三维建模、大场景实时三维重建等。

比如你在艺术馆看到一座非常喜欢的雕塑,就可以利用手机对它扫描一周,结合相应的算法就可以生成该雕塑的三维模型数据,利用三维打印机就可以方便的打印出一个三维的雕塑复制品出来。

而大尺度实时三维重建的应用更广,可以广泛用于机器人自主导航、无人机侦查、古建筑保护、建筑设计等场景。其中最有可能先发展起来的就是机器人自主导航,目前基于RGBD相机的SLAM(即时定位与地图构建)技术是主流研究方向。

2、三维立体美颜美体

美颜一直是手机用户的一个刚性需求。现在磨皮、瘦脸、美妆已经是大部分女生发自拍照的标配。

前段时间美图推出的“一秒变手绘”已经在朋友圈火了一把。据官方介绍该手绘特效技术基于人工智能深度学习技术,并融合人脸识别、美颜技术、头发渲染等多种技术,过去传统画师用几天时间才能绘制的手绘画像,机器学习可以一秒钟就满足用户的需求。下图就是手绘的效果图,不得不承认效果非常赞。

目前图片美颜技术已经比较成熟,视频美颜处于初级发展阶段,目前比较流行的就是美拍的face sticker功能,如下图所示。虽然只是对视频增加了一些小小的饰物和特效,但是很多女生已经彻底离不开它了。足见用户对美颜的需求是多么的旺盛。

但是你以为这就可以满足爱美的女生了吗?

图样图森破,她们对美的追求是永无止境的,他们需要的是360°无死角的美!当手机摄像技术结合了实时三维深度信息后,未来美颜也将美出新高度:三维立体美颜和美体。

三维美颜和美体是对二维美颜的全面升级,当二维图片美颜日趋成熟时,美颜的主战场将进入视频领域。由于能够实时获取较精准的三维空间信息,对人的五官轮廓建模将会变的比较容易。基于视频的三维人体瘦脸、嫩肤、隆鼻、双眼皮、美发等三维美颜统统小菜一碟,而像丰胸、A4腰瘦身、优化身材比例等这种全方位立体化的美体技术也会大量出现。这些将在视频聊天、视频直播、影视制作等场合有较多的应用。

未来的美颜技术核心是能够在美颜的同时保持个体的独特特征,不会美的千篇一律,要有真实感。想一想将来不需要化妆、不需要整形,就能在视频里呈现出天使一般的容颜和魔鬼一样的身材,这个市场一定大的惊人。

3、三维人脸活体识别

今年央视315晚会上,人脸识别技术被曝存在安全隐患。主持人在现场技术人员支持下,仅凭两部手机、一张随机正面照片及一个换脸APP,分别就一张”眨眨眼”的照片和一段”活体检测”场景模拟,成功“攻破”人脸识别系统。

目前人脸识别技术常见的攻击方法有:PS换脸、屏幕翻拍、戴面具、建模驱动等。

而传统的人脸活体检测一般通过指定用户的动作来作为防伪线索,例如:眨眼、张嘴、点头、摇头、微笑等动作。这种方法存在一定的漏洞,正如315晚会所示,该方法难以防止真人视频翻拍或者换脸算法合成的视频的攻击。

315晚会后不少高科技公司(如百度、腾讯、旷视科技、商汤科技等)都第一时间从自己技术方面进行了回应,号称可以规避这些风险。但是笔者总结了一下他们的解决方案,基本都是使用更加复杂的随机唇语、语音图像同步检测、人脸纹理分析、面具检测、视频防翻拍等多维度防护手段,并将所有这些手段进行交叉融合来实现防护的。这些在当下可能确实起到一定防护效果,但是笔者认为道高一尺魔高一丈,这些是治标不治本的方法。看看下面这个例子就知道了。

2016年美国斯坦福大学的研究团队研发出一款人脸跟踪软件Face2Face,它可以通过摄像头捕捉用户的动作和面部表情,然后该软件可以驱动视频中的目标人物做出一模一样的动作和表情,效果极其逼真。你可以控制普京这样大人物在视频中做出任何你想要的表情,像这样:

这种黑科技做的简直天衣无缝,连我们人类都能轻易骗过。可见人脸验证防伪工作任重道远。

不过,笔者认为基于三维空间的人脸活体检测或许可以从根本上改善这一现象。因为目前所有的防伪验证摄像头采集的都是二维图片/视频信息,正是由于缺失了最重要的空间信息才使得各种合成的图像或视频有了可趁之机。

笔者认为未来的三维人脸活体识别技术除了使用传统的RGB相机采集信息外,还会增加深度相机。不管你合成的图像或视频多么逼真(比如Face2Face),它只能在屏幕上以二维的影像显示。缺失了空间信息,注定是无法通过三维人脸活体检测的。

4、更丰富真实的AR体验

未来借助手机摄像头和手机屏幕,结合地理位置定位、计算机视觉、大数据等技术可以轻松便捷的实现手机上丰富多彩的AR(扩展现实)体验。在此列举几个。

(1)更真实的游戏体验

结合了实时三维信息的AR游戏形象能够感知周围环境,它能够感知高低、远近、前后景等实景信息,从而可以做出遇到不同高度平面边缘跳跃,躲藏到障碍物后面等一系列非常真实的效果。也许以后隔着手机屏幕你都无法分辨真实世界和虚拟世界了。

(2)更便捷的出行指南

比如未来我们到一个陌生的地方,需要寻找餐厅、咖啡馆甚至厕所,不需要再像以前那样麻烦了,直接掏出手机,打开摄像头对着街道,会自动出现如下的AR内容介绍,妈妈再也不用担心我找不到地方啦!

(3)更高效的教育培训

基于智能手机的AR可以用于课程学习、操作培训,降低学习和工作的成本,提高学习工作效率和安全性。以后学习一项新的技能将会越来越容易。

(4)更丰富的广告传媒

AR 技术可以在传统纸质图书、墙纸广告、美术馆展品等平面图像上叠加虚拟信息,在手机屏幕上可以看到对应的视频、背景信息等扩展内容,带来全新的阅读、观赏体验。

(5)更便捷的空间应用

将三维测量、三维模型和AR结合起来会产生更多的玩法。以家居装修为例,具备了三维测距功能的手机可以对房屋空间尺寸实时测量,利用家具厂商提供的每个家具的三维空间模型(包括物理尺寸、花纹、配色等),只需要用手机点一点,用户就能在手机屏幕上看到家具摆放在家里的真实位置和尺寸。而且AR呈现出来的家具都是三维的,用户拿着手机旋转角度,就可以看到这件家具摆放在家里的任何角度,就像真的家具摆在那里一样,从而判断该家具尺寸是否合适,装修风格是否统一等。以后买家具再也不用带着尺子量了,也不用担心买回去颜色不搭了。

5、更人性的人机交互

在此主要是指三维手势识别。三维手势识别与二维手势识别的最根本区别就是增加了一维的深度信息。目前的二维手势识别只能做到一些比较简单的操作,比如控制视频播放开始和暂停、浏览照片等。但是对于更加复杂的体育类游戏或者VR来说,目前的二维手势识别还不够。未来智能手机深度信息能够极大促进三维手势识别的普及和应用,这也许会带来比触摸屏交互更加接近人类方式的交互体验。

参考:

http://blog.csdn.net/electech6/article/details/78349107

http://blog.csdn.net/electech6/article/category/6199262

http://www.sohu.com/a/155051355_468626