一、简介

Hive由Facebook开源用于解决海量结构化日志的数据统计。Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类Sql查询的功能。

hive本质是将HQL转化为MapReduce的程序

-

hive处理的数据存储在HDFS

-

hive分析数据低层的实现是MapReduce

-

执行程序运行在YARN上

二、Hive的优缺点

1.优点:

-

操作接口采用类sql语法,提供快速开发的能力

-

避免去写MapReduce,减少开发人员的学习成本。

-

Hive的执行延迟比较高,因此Hive常用于数据分析,对实时性要求不高的场合。

-

Hive优势在于处理大数据,对于处理小数据没有优势,应为Hive的数据延迟比较高。

-

Hive支持用户自定义函数,用户可以根据自己的需求来实现自己的函数

2.缺点:

-

Hive的HQL表达能力有限

-

迭代式算法无法表达

-

数据挖掘方面不擅长

-

-

hive的效率较低

- Hive自动生成MapReduce作业,通常情况下不够智能化

-

Hive调优比较困难,粒度较粗

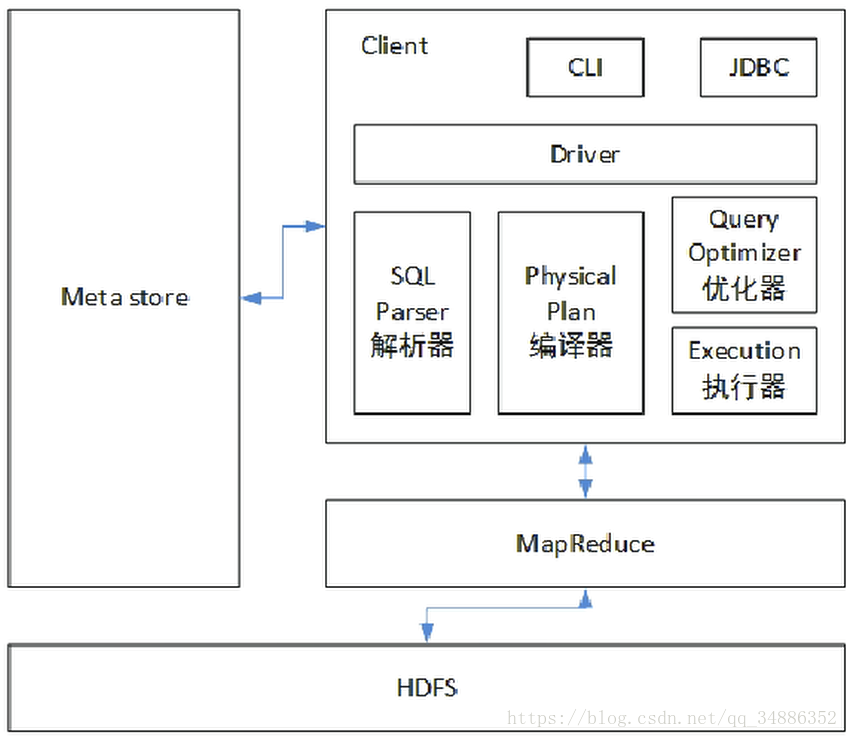

三、hive架构原理

Hive通过给用户提供的一系列交互接口,接收到用户的指令(SQL),使用注解的Drive,结合元数据(MetaStore),将这些指令翻译成MapReduce,提交到Hadoop中执行,最后,将执行返回的结果输出到用户交互接口。

1.用户接口:Client

CLI(hive shell)、JDBC/ODBC(java访问Hive)、WEBUI(浏览器访问hive)

2.元数据:Metastore

元数据包括:表名、表所属的数据库(默认是default)、表的拥有者、列/分区字段、表的类型(是否是外部表)、表的数据所在目录等;

默认存储在自带的derby数据库中,推荐使用Mysql存储Metastore

3.Hadoop

使用HDFS进行存储,使用MapReduce进行计算。

4.驱动器:Driver

-

解析器(SQL parser):将SQL字符串转换成抽象语法树AST,这一步一般都用第三方的工具完成。

-

编译器(Physical Plan):将AST编译生成逻辑执行计划。

-

优化器(QUery Optimizer):对逻辑执行计划进行优化

-

执行器(Execution):把逻辑执行计划转换成可以运行的物理计划。对于Hive来说就是MR/Spark

四、Hive和数据库比较

Hive采用了类似Sql的查询语言HQL(Hive Query Language),因此很容易将Hive理解为数据库。从结构上来看,Hive和数据库除了拥有类似的查询语言,再无类似之处。数据库可以用于Online的应用,但是Hive是为数据仓库而设计的,清楚这一点,有助于从应用角度理解Hive的特效

1.查询语言

Sql被广泛的应用在数据仓库中,因此,专门针对hive的特性设计了类sql的查询语言HQl。熟悉Sql的开发者可以很方便的使用Hive进行开发。

2.数据存储位置

Hive是建立在Hadoop之上的,所有hive的数据都是存储在HDFS中,而数据库则可以将数据保存在块设备或者本地文件系统中。

3.数据更新

由于Hive是针对数据仓库应用设计的,而数据仓库的内容是读多写少的。因此,Hive中不支持对数据的改写和添加,所有的数据都是加载的时候确定好的。而数据库中的数据通常是需要经常进行修改的,因此可以修改数据。

4.索引

Hive在加载数据的过程中不会对数据进行任何处理,甚至不会对数据进行扫描,因此也没有对数据中的某些key简历索引,Hive要访问数据中满足条件的特定值式,需要暴力扫描整个数据,因此访问延迟较高。有与MapReduce的引入,Hive可以并行访问数据,因此即使没有索引,对于大数据量的访问,Hive仍然可以体现出优势。数据库中,通常会针对一个或者几个列建立索引,因此对于少了的特定数据的访问,数据库可以有很高的效率,较低的延迟。数据的访问延迟修改较高,决定了Hive不适合在线数据查询

5.执行

Hive中大多数查询的执行是通过Hadoop提供的MapReduce来实现的。而数据库通常有自己的执行引擎

6.执行延迟

Hive在查询数据的过程,由于没有索引,需要扫描整个表,因此延迟较高。另外一个导致Hive执行延迟高的因素是MapReduce框架。由于MapReduce本身具有较高的延迟,因此在利用MapReduce执行Hive查询时,也会有较高的延迟。相对的,数据库的执行延迟较低。当热,这个低是有条件的,数据规模要较小,当数据规模大到超过数据库的处理能力的时候,Hive的并行计算显然能体现出优势。

7.可扩展性

由于Hive是建立在Hadoop之上的,因此Hive的可扩展性是和Hadoop的可扩展性是一致的,而数据库由于ACID语义的严格限制,扩展性非常有限。(2009年的Yahoo的hadoop集群已经达到4000台,而同期的Oracle数据库理论扩展上线只有100台左右)

8.数据规模

Hive利用MapReduce进行并行计算,可以支持很大规模的数据,而普通的数据库可以支持的数据规模就要小很多。

五、Hive安装环境准备

1.Hive安装地址说明

-

Hive官网地址:http://hive.apache.org

-

下载地址:http://archive.apache.org/dist/hive

-

需要安装hadoop,并配置好环境

2.Hive安装部署(这里演示1.2.1版本,2.x.x版本安装方式并不一样)

-

把apache-hive-1.2.1-bin.tar.gz上传到linux服务上

-

解压tar包

-

tar -zxvf apache-hive-1.2.1-bin.tar.gz

-

-

将解压出来的文件夹转移到/usr/local目录下并重命名为hive

-

mv apache-hive-1.2.1-bin /usr/local/hive

-

-

进入/usr/local/hive/conf目录下,将hive-env.sh.template更名为hive-env.sh

-

mv hive-env.sh.template hive-env.sh

-

-

进入hive-env.sh文件,并配置HADOOP_HOME和HIVE_CONF_DIR路径

-

vim hive-env.sh

-

export HADOOP_HOME=/usr/local/hadoop(这里填写自己的hadoop路径)

-

export HIVE_CONF_DIR=/usr/local/hive/conf(hive目录的conf文件地址)

-

3.Hadoop集群配置(条件有限这里的hadoop使用的是伪分布式)

-

进入hadoop目录下的sbin目录,并启动hdfs和yarn

-

hadoop-daemon.sh start namenode

-

hadoop-daemon.sh start datanode

- yarn-daemon.sh start resourcemanager

-

yarn-daemon.sh start nodemanager

-

-

在HDFS上创建/tmp和/user/hive/warehouse两个目录,并修改他们的权限为可读可写

-

hadoop fs -mkdir -p /tmp

-

hadoop fs -mkdir -p /user/hive/warehouse

-

hadoop fs -chmod 777 /tmp

-

hadoop fs -chmod 777 /user/hive/warehouse

-

六、hive基础操作

先回到hive目录下

1.启动hive

-

bin/hive

启动成功!

2.查看存在的数据库

-

show databases;(分号别忘了)

3.打开默认的数据库

-

use default;

4.显示数据库的表

-

show tables;

5.创建一张表

-

create table student(id int,name string);

6.插入数据

-

insert into student values(1,"zhangsan");

7.查看数据

-

select * from student;

8.退出数据库

-

quit;