目录

贝叶斯决策论“”

现实任务中,机器学习所要实现的是基于有限的样本集尽可能准确地估计出后验概率,有两种策略:

- 给定样本 x,可通过直接建模

来预测类别 c,这样得到的是“判别式模型”;

- 也可先对概率分布

(联合概率)建模,然后再由此获得

,这样得到的是“生成式模型”;

- LR,LDA,SVN,DT,条件随机场(CRF)等都是判别式模型,生成式模型有隐马尔可夫模型(HMM),Navie Bayes,马尔科夫随机场,knn等;

独立同分布:

在概率统计理论中,指随机过程中,任何时刻的取值都为随机变量,如果这些随机变量服从同一分布,并且互相独立,那么这些随机变量是独立同分布。

一文搞懂HMM 通俗易懂

隐马尔科夫模型:

1、成对、局部、全局马尔科夫性

2、概率无向图模型:

设有联合概率分布P(Y),由无向图G=(V,E)表示,在图G中,结点表示随机变量,边表示随机变量之间的依赖关系。

如果联合概率分布P(Y)满足成对、局部或全局马尔可夫性,就称此联合概率分布为概率无向图模型或马尔可夫随机场。

尽管在给定每个节点的条件下,分配给该节点一个条件概率是可能的,无向图的无向性导致我们不能用条件概率参数化表示联合概率,而要从一组条件独立的原则中找出一系列局部函数的乘积来表示联合概率。

最简单的局部函数是定义在图结构中的团上的势函数,并且是严格正实值的函数形式。

3、团与最大团

无向图G中任何两个结点均有边连接的结点子集称为团,若C是无向图G的一个团,并且不能再加进任何一个G的结点使其称为一个更大的团,则称此C为最大团。

将概率无向图模型的联合概率分布表示为其最大团上的随机变量的函数的乘积形式的操作,成为概率无向图模型的因子分解。

4、HMM解决的三个问题

HMM解决的三个问题:

1:评估问题,已知模型参数 λ= (A, B, π),计算某个观测序列发生的概率,即求P(O|λ)

用前向算法或者后向算法求解此类问题,以前向算法为例

前向算法给出了一个重要的变量---前向变量αt(i)表示在t时刻HMM输出给定观测序列O1O2...Ot,并且状态为Si的概率

2:解码问题,给出观测序列O和模型μ,怎样选择一个状态序列S(s1,s2,...st+1),能最好的解释观测序列O

此问题采用了维特比算法

3:学习问题,如何调整模型参数 λ=(π, A, B), 使得P(O|λ)较大?

此问题面向不同的语料库有不同的方式

a.对于观测序列和状态序列都有的立项预料库,直接用较大似然估计即可获得参数λ

b.对于只知道观测序列的,应用EM算法的实现前向后向算法求解

5、三种问题的概率计算方法

(1)概率计算问题(前向-后向算法):

求P(O|λ);为了方便起见,像隐马尔可夫模型一样,引进前向-后向向量,递归地计算以上概率及期望值,这样的算法称为前向-后向算法;

即:前向概率为 ,给定模型参数 ,在 t 时刻的状态与部分观测序列( t 时刻及之前的观测序列)的联合概率;

从第一个时刻的前向概率开始,往后递推求和求下一个时刻的前向概率;第一个时刻的前向概率 :第一个时刻状态为第 i 号状态的概率是

,在第 i 号状态时得到

这个观测的概率是

,则前向概率为:

=

;

t+1时刻的前向概率:由于状态的不可观测性,我们需要考虑 t 时刻所有可能的状态;先求t时刻的状态转移到t+1时刻状态的总概率: t 时刻的可能状态(q1,q2,...qn)转移到 t+1 时刻且 t+1时刻的状态为 的所有概率求和,然后再乘以由 t+1 时刻的状态 i 得到观测的概率

;

即:t+1 时刻的前向概率为: t 时刻的前向概率对所有可能状态求和 * t+1 时刻的状态得到观测的概率;

P(O|λ)为前向概率之和,P(O|λ) = α1(T) +α2(T) + ... + αn(T),即给定模型参数 和观测序列 O下,观测序列 O 出现的概率P(O|λ)了;具体如下:

前向概率的递推公式:

后向算法是反过来的;

第t时刻有第i个状态的概率 = t时刻的前向概率 * t时刻的后向概率

参考链接:隐马尔可夫(HMM)、前/后向算法、Viterbi算法 再次总结

(2)学习算法(Baum-Welch):

已知观测序列 O,估计模型参数 ,使在该模型下观测序列

最大;用极大似然估计的方法估计参数;这里用了EM算法的思想,对完全数据取对数似然,然后极大化似然函数

求模型参数;

为模型当前的估计值,

为要极大化的隐马尔可夫模型参数;(例如:O 为观测随机变量的数据,

为隐随机变量的数据(状态序列),O和

连在一起称完全数据;O称为不完全数据;)

算法步骤如下:

总结: Baum-Welch算法 就是通过观

(3)预测算法(维比特算法):

条件随机场的预测问题是给定条件随机场P(Y|X)和输入序列(观测序列)x,求条件概率最大的输出序列(标记序列)

维比特算法的思想:

- 先从前向后推出一步步可能的路径,最终会得到从起点到终点的 M 条路径;

- 确定终点之后再反过来选前面的路径;

- 确定最优路径;

条件随机场(CRF)

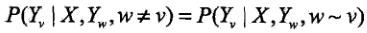

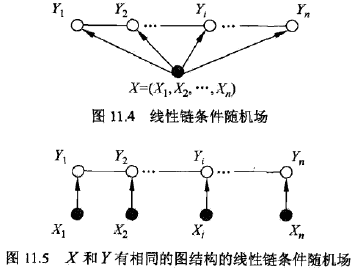

设X与Y是随机变量,P(Y|X)是在给定X的条件下Y的条件概率分布。若随机变量Y构成一个由无向图G=(V,E)表示的马尔可夫随机场。即在给定观察序列X的条件下,每个随机变量 都满足马尔科夫特性,即

那么条件概率分布P(Y|X)就是一个条件随机场(conditional random fields, CRF)。CRF本质就是给定了观测值集合的MRF(马尔可夫随机场);

如果信息是与时间或空间的前后有关联时要考虑到CRF。CRFs非常适用于中文的词性标注;

1、线性链条随机场:

2、线性链CRF的参数化形式

Z是规范因子

3、条件随机场的条件概率推导

tk是定义在边上的特征函数,称为转移特征,它依赖于当前和前一个位置,t(yi-1, yi, x, i)表达“在给定观测x的情况下从上个节点yi-1转移到这个节点yi的情况”。

sl是定义在节点上的特征函数,称为状态特征,依赖于当前位置,表达“当前节点yi是不是标记x的情况”。

它的输出值是0或者1,0表示要评分的标注序列不符合这个特征,1表示要评分的标注序列符合这个特征。

4、如何计算CRF:

CRF 与 HMM 的比较:

CRF是判别式模型,直接构建观测序列(输入)和状态序列(输出)的条件概率分布P(y | x),因为没有y的知识,所以无法生成样本,只能判断分类。CRF并不能像HMM那样通过隐含序列推断最可能是观测序列,因为CRF模型中并没有计算p(x|y),不是生成模型。HMM是生成模型。

CRF是无向图模型,对(y1,y2 | x)建模;HMM是有向图模型。

HMM有三个假设,观测值是独立的,当前状态只与上一状态有关;CRF抛弃了这两个假设,用到了上下文信息,1or2-gram;

HMM:对转移概率和表现概率直接建模,统计共现概率。

MEMM:是对转移概率和表现概率建立联合概率,统计时统计的是条件概率,由于其只在局部做归一化,所以易陷入局部最优。

CRF:在全局范围内统计归一化的概率,不像MEMM是在局部统计归一化概率。是全局最优的解。解决了MEMM中标注偏置的问题。

总结:

隐马尔可夫模型,马尔可夫随机场,条件随机场

随机场:一组随机变量,属于同一个样本空间;

HMM :有向图

生成式模型,直接对观测值和状态值得联合概率建模,求P(x|s),只与状态转移概率,输出观测值概率,状态初始概率有关;

包含两类数据,观测序列(可见),状态序列(隐藏,不可见);

两个假设:1)任意时刻的隐藏状态只依赖于它前一个的隐藏状态;2)任意时刻的观测值只依赖于当前时刻的观测状态;

解决三个基本问题:模型参数,A为状态转移概率,B为给定状态,π为初始概率,解决:

1)给定 λ 下,求P(O|λ);

2)如何调整λ ,使 max P(O|λ);

3)由观测序列反推状态序列,找一个最好解释观测序列的状态序列;

由观测值反求最好的序列 ,涉及到矩阵求最短路径用 维比特算法(动态规划);

缺点:基于它得两个假设,使其不能够更多的考虑上下文信息,ansj中文分词用的就是n-gram+HMM;

MRF(马尔可夫随机场):

是一个马尔可夫网;团:任意两个结点直接都有连接;最大团:如果团加一个结点就破坏了团的性质,称为最大团;我们用将最大团的势函数的乘积来表示联合概率,乘以一个归一化常数Z,Z等于对每个x下的最大团势函数的乘积求和;

MHMM(最大熵隐马尔可夫模型):

考虑了相邻状态之间的依赖关系,也考虑了整个观测序列,再MRF的基础上先归一化,再求团势函数的乘积,所以容易得到局部最优;

CRF(条件随机场):无向图

判别式模型,直接构建观测序列(输入)和状态序列(输出)的条件概率分布P(Y|X);

定义:设 X 和 Y 是随机变量,P(Y|X)是给定 X 条件下 Y 的概率,在给定 x 的条件下,任意随机变量 都满足马尔可夫特性(成对、局部、全局马尔可夫性,直观理解就是这些性质保证了变量的独立性),那么称条件概率分布P(Y|X)是条件随机场;

优点:抛弃了HMM的两个假设,利用了上下文的信息,相比MHMM,在全局范围内统计归一化概率,容易得到全局最优;

应用:分词,词性标注