一、简介

Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

Flannel的设计目的就是为集群中的所有节点重新规划IP地址的使用规则,从而使得不同节点上的容器能够获得“同属一个内网”且”不重复的”IP地址,并让属于不同节点上的容器能够直接通过内网IP通信。

二、Flannel的工作原理

Flannel实质上是一种“覆盖网络(overlay network)”,也就是将TCP数据包装在另一种网络包里面进行路由转发和通信,目前已经支持UDP、VxLAN、AWS VPC和GCE路由等数据转发方式。

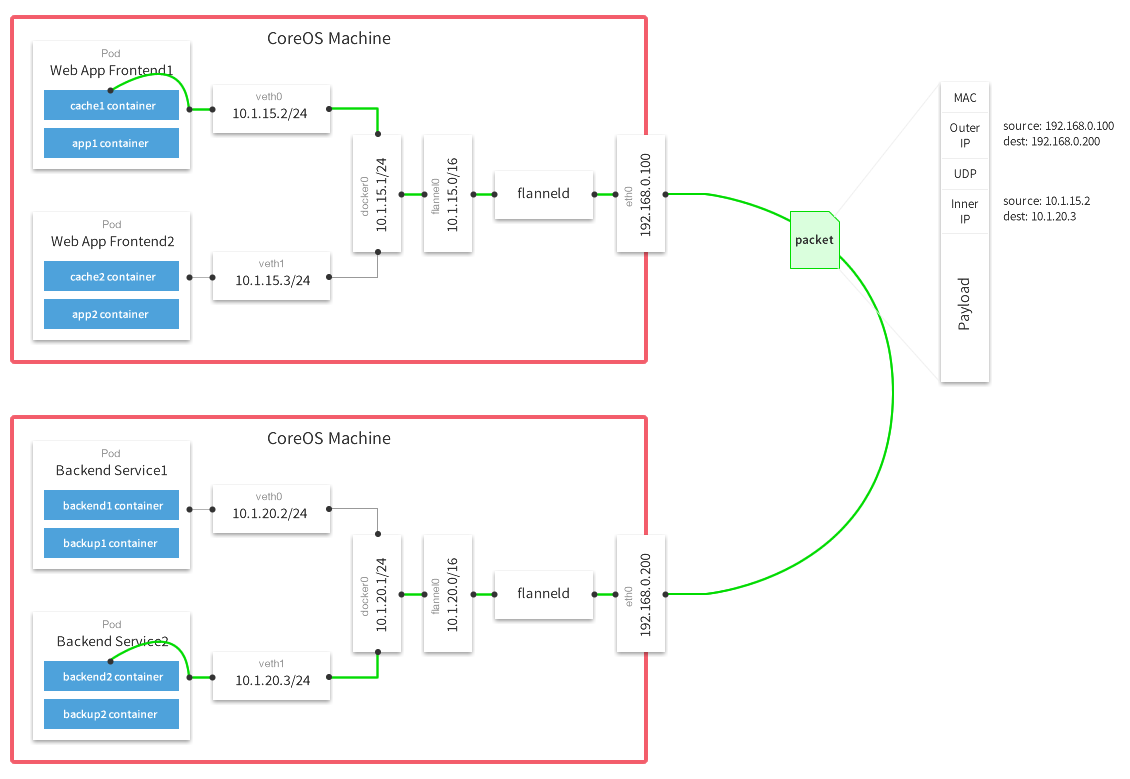

默认的节点间数据通信方式是UDP转发,在Flannel的GitHub页面有如下的一张原理图:

对上图的简单解释:

1)数据从源容器中发出后,经由所在主机的docker0虚拟网卡转发到flannel0虚拟网卡,这是个P2P的虚拟网卡,flanneld服务监听在网卡的另外一端。

2)Flannel通过Etcd服务维护了一张节点间的路由表,在稍后的配置部分我们会介绍其中的内容。

3)源主机的flanneld服务将原本的数据内容UDP封装后根据自己的路由表投递给目的节点的flanneld服务,数据到达以后被解包,然后直接进入目的节点的flannel0虚拟网卡,

然后被转发到目的主机的docker0虚拟网卡,最后就像本机容器通信一下的有docker0路由到达目标容器。

这样整个数据包的传递就完成了,这里需要解释三个问题:

1)UDP封装是怎么回事?

在UDP的数据内容部分其实是另一个ICMP(也就是ping命令)的数据包。原始数据是在起始节点的Flannel服务上进行UDP封装的,投递到目的节点后就被另一端的Flannel服务

还原成了原始的数据包,两边的Docker服务都感觉不到这个过程的存在。

2)为什么每个节点上的Docker会使用不同的IP地址段?

这个事情看起来很诡异,但真相十分简单。其实只是单纯的因为Flannel通过Etcd分配了每个节点可用的IP地址段后,偷偷的修改了Docker的启动参数。

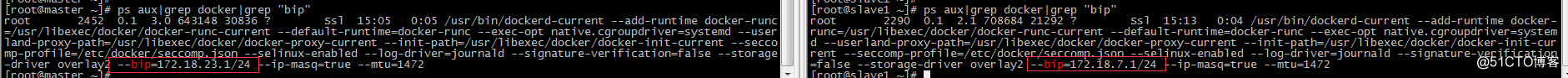

在运行了Flannel服务的节点上可以查看到Docker服务进程运行参数(ps aux|grep docker|grep "bip"),例如“--bip=182.48.56.1/24”这个参数,它限制了所在节

点容器获得的IP范围。这个IP范围是由Flannel自动分配的,由Flannel通过保存在Etcd服务中的记录确保它们不会重复。

3)为什么在发送节点上的数据会从docker0路由到flannel0虚拟网卡,在目的节点会从flannel0路由到docker0虚拟网卡?

例如现在有一个数据包要从IP为172.17.18.2的容器发到IP为172.17.46.2的容器。根据数据发送节点的路由表,它只与172.17.0.0/16匹配这条记录匹配,因此数据从docker0出来以后就被投递到了flannel0。同理在目标节点,由于投递的地址是一个容器,因此目的地址一定会落在docker0对于的172.17.46.0/24这个记录上,自然的被投递到了docker0网卡。

三、搭建服务

1、环境准备(相同配置)

1)系统环境

2)建议暂时关闭防火墙,测试完毕再开启防火墙和相关端口

3)设置主机名及绑定hosts

# vim /etc/hosts

192.168.56.128 master

192.168.56.128 etcd

192.168.56.130 slave1

3)安装docker(再次省略)

2、在master节点配置

2.1、安装etcd服务

1)yum安装

# yum install etcd -y

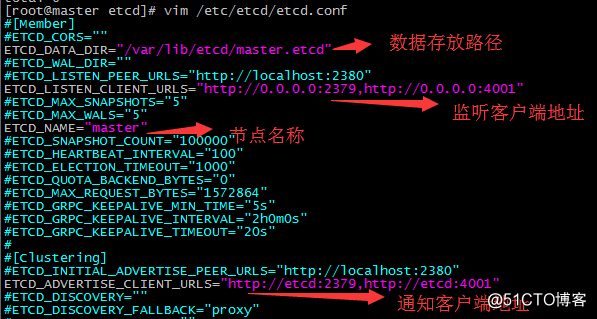

2)修改etcd配置文件

# cp /etc/etcd/etcd.conf /etc/etcd/etcd.conf_bak

3)启动服务

[root@master ~]# systemctl start etcd.service

[root@master ~]# systemctl enable etcd.service

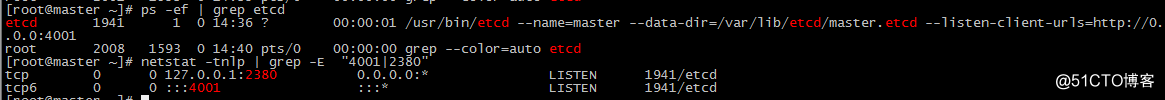

# netstat -tnlp | grep -E "4001|2380"

# ps -ef | grep etcd

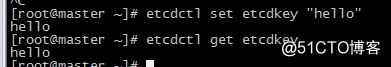

4)验证

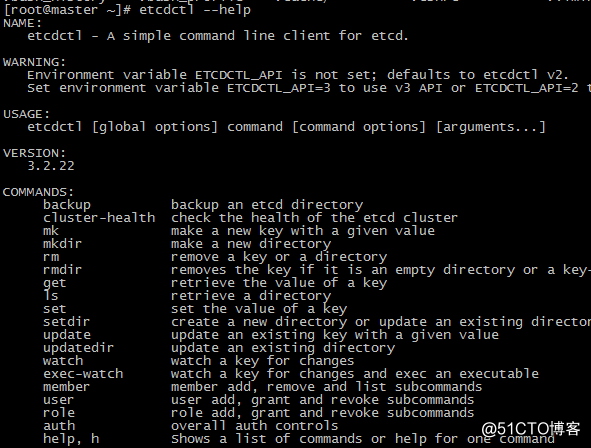

# etcdctl --help

# etcdctl set etcdkey "hello"

# etcdctl get etcdkey

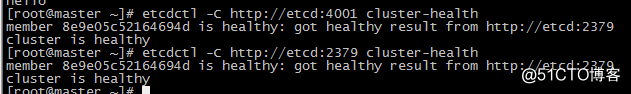

# etcdctl -C http://etcd:4001 cluster-health

# etcdctl -C http://etcd:2379 cluster-health

2.2、安装Flannel服务

1)yum安装flannel

# yum install flannel -y

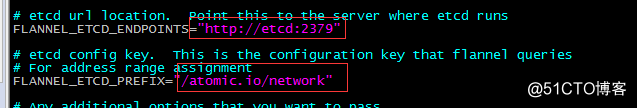

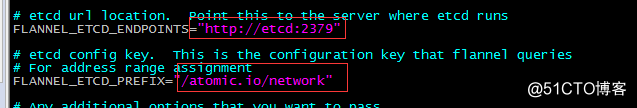

2)配置flannel文件

# cp /etc/sysconfig/flanneld /etc/sysconfig/flanneld_bak

# vim /etc/sysconfig/flanneld

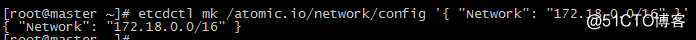

3)配置etcd中关于flannel的key(只能在etcd节点上操作)

Flannel使用Etcd进行配置,来保证多个Flannel实例之间的配置一致性,所以需要在etcd上进行如下配置('/atomic.io/network/config'这个key与上面的/etc/sysconfig/flannel中的配置项FLANNEL_ETCD_PREFIX是相对应的,错误的话启动就会出错):

# etcdctl mk /atomic.io/network/config '{ "Network": "172.18.0.0/16" }'

备注:该ip网段可以任意设定,随便设定一个网段都可以。容器的ip就是根据这个网段进行自动分配的,ip分配后,容器一般是可以对外联网的(网桥模式,只要宿主机能上网就可以)

4)启动服务

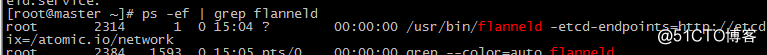

[root@master ~]# systemctl start flanneld.service

[root@master ~]# systemctl enable flanneld.service

重启docker

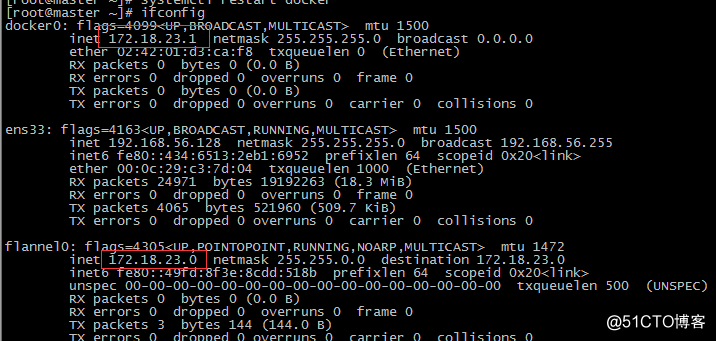

# systemctl restart docker

3、在slave1节点配置

3.1、安装Flannel服务

1)yum安装flannel

# yum install flannel -y

2)配置flannel文件

# cp /etc/sysconfig/flanneld /etc/sysconfig/flanneld_bak

# vim /etc/sysconfig/flanneld

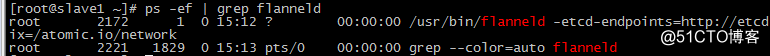

3)启动服务

[root@slave1 ~]# systemctl start flanneld.service

[root@slave1 ~]# systemctl enable flanneld.service

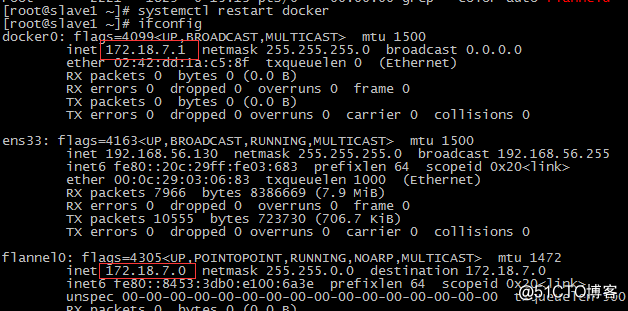

重启docker,获取分配的ip段

4、创建容器,测试网络互联

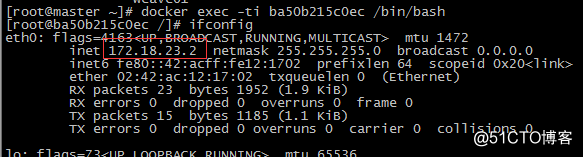

4.1、查看master容器获取的ip

172.18.23.0/24网段

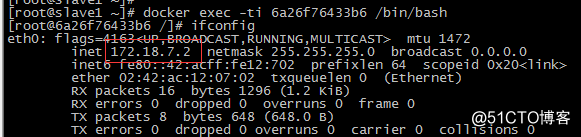

4.2、查看slave1容器获取的ip

172.18.7.0/24网段

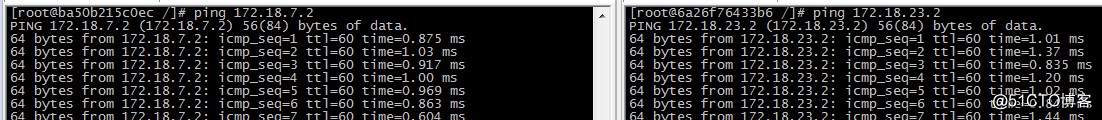

容器之间相互访问

5、查看宿主获取的IP段

# ps aux|grep docker|grep "bip"

“--bip=172.18.23.1/24”这个参数,它限制了所在节点容器获得的IP范围。 该IP范围是由Flannel自动分配的,由Flannel通过保存在Etcd服务中的记录确保它们不会重复。