局部加权回归

局部加权回归原理:

对于一般训练集:

参数系统为:

线性模型为:

线性回归损失函数:J(θ)

局部加权回归的损失函数:

在我们原始的线性回归中,对于输入变量,我们要预测,通常要做:

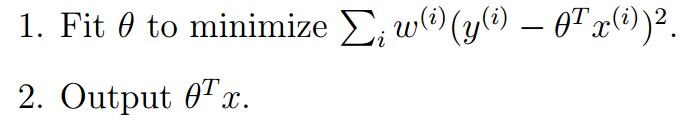

而对于局部加权线性回归来说,我们要做:

扫描二维码关注公众号,回复:

3447752 查看本文章

局部加权回归是一种非参数学习方法,

它的主要思想就是只对预测样本附近的一些样本进行选择,根据这些样本得到回归方程,那么此时我们得到的回归方程就比较拟合样本数据,不会存在欠拟合和过拟合的现象。

与参数学习方法相比,非参数学习方法的不同之处在于:

参数学习方法是用一组训练得到一系列训练参数,然后确定出预测函数h,之后就可以根据新的输入来输出新的预测值,不再依赖之前的训练集了,参数值求解出来后一直是确定的。

而非参数学习方法是在预测新样本值时候每次都会根据预测样本附近的训练集求解新的参数值,即每次预测新样本是都会依赖训练集求解新的参数,所以每次得到的参数值是不确定的。相应的,效率也会比较低。

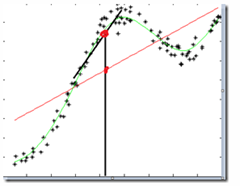

图中红色直线使用线性回归做的结果,黑色直线使用LWR做的结果,可以看到局部加权回归的效果较好。

注:wi的形式跟高斯函数很像,但是它和高斯函数一点关系都没有,公式中的参数是波长参数,越大远距离样本权值下降更快。