转载:https://blog.csdn.net/niuniuyuh/article/details/76922210

论文:http://pdfs.semanticscholar.org/0d97/ee4888506beb30a3f3b6552d88a9b0ca11f0.pdf

CART(Classification And Regression Trees)—分类回归树:

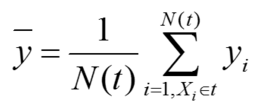

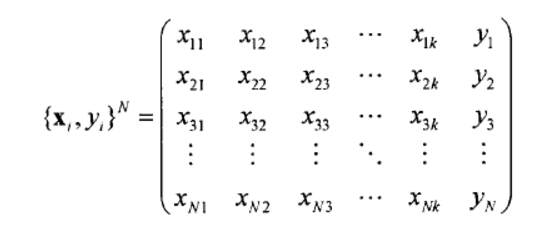

t代表树的某个节点,t中的样本集合为:{(X1,y1),(X2,y2),...},N(t)是节点t中的样本个数。节点t的应变量是实数(回归树),节点t的应变量的均值:

节点t内的平方残差最小化:

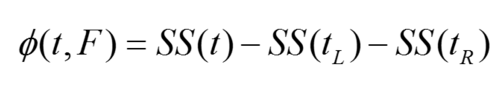

属性F将t划分成左右节点tL和tR:

能最大化上式的就是最佳的属性划分:

扫描二维码关注公众号,回复:

3416057 查看本文章

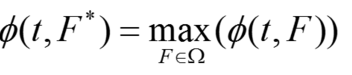

CART_回归树算法步骤是:

一般Boosting算法都是一个迭代的过程,每一次新的训练都是为了改进上一次的结果:

GradientBoost其实是一个框架,里面可以套入很多不同的算法。每一次的计算都是为了减少上一次的残差,为了消除残差,我们可以在残差减少的梯度方向建立一个新的模型,所以说,每一个新模型的建立都为了使得之前的模型残差向梯度方向上减少。它用来优化loss function有很多种。

GradientBoost通用框架:

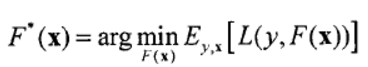

我们的目标是在样本空间上找到最优预测函数F*(x),使x映射到y的损失函数L(y,F(x))达到最小,即:

损失函数的形式为平方误差: