版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/YaboSun/article/details/82389726

主要讲解项目中用到的软件,以及介绍软件的安装目录,不会详细的介绍软件如何安装,具体的安装教程网上很多很详细

这里顺便记录一下老师提到,我也觉着很有用的一个学习习惯:

1、记笔记:把每次课程仔细总结为博客

2、阅读官网、英文 + 阅读github官网项目

3、多尝试、多思考,每个都要自己敲出来结果

环境配置

以一张表格简单记录服务器软件以及对应的版本,因为大数据很多会涉及到版本冲突问题,所以一定要注意版本

| 名称 | 版本 |

|---|---|

| Ubuntu系统 | LTS16.04 |

| Hadoop | Apache2.7.3 |

| IDE | IntelliJIDEA |

| JDK | 1.8.0_161 |

| Scala | 2.11.12 |

| Spark | 2.2.1 |

| Flume | 1.8.0 |

| Kafka | 1.0.0 |

| Zookeeper | 3.4.10 |

安装目录

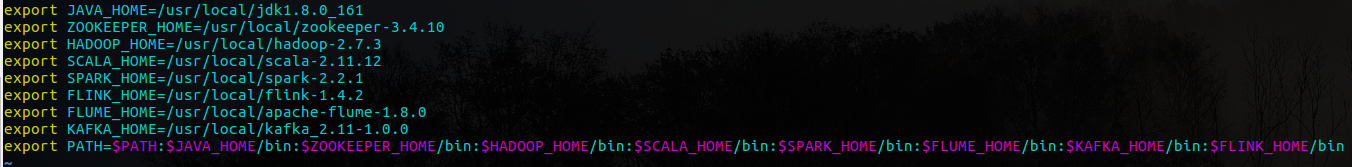

主要说明软件安装所在路径,以环境变量中的配置展示:

export JAVA_HOME=/usr/local/jdk1.8.0_161

export ZOOKEEPER_HOME=/usr/local/zookeeper-3.4.10

export HADOOP_HOME=/usr/local/hadoop-2.7.3

export SCALA_HOME=/usr/local/scala-2.11.12

export SPARK_HOME=/usr/local/spark-2.2.1环境变量的配置文件我是在/etc/profile内容如下:

个人感觉这种配置环境变量的方式很简洁明了,大家可以参考,如果有更好的欢迎给我提出意见

服务器目录

/root 用于存放下载的安装包以及一些安装的命令以及安装测试文件

/etc/profile 环境变量的配置路径

/root/data 存放测试数据

远程登录

这里是通过远程登录集群服务器,然后进行操作,使用ssh登录,ssh的使用教程不做更多的说明,教程很多也比较简单,到此软件的安装以及相关说明就这么多