今天写的博客主要参考了清华大学黄民烈老师团队2018年在IJCAI上发表的paper《Densely Connected CNN with Multi-scale Feature Attention for Text Classification》。

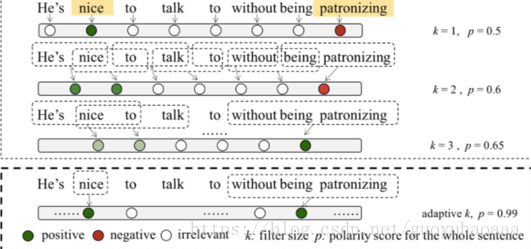

这篇paper其实就是使用基于CNN的网络来进行文本的情感分类,但是它针对的问题是传统的多层次的CNN网络使用static窗口来进行卷积,每次针对句子中提取n-gram feature 都是一样的,如果遇到以下例子,就会影响模型的准确性:

在该样例中,不管是单纯的1-gram还是3-gram都不太合适:针对“nice”这个单词需要1-gram,但是针对“without being patronizing”这个词组需要3-gram。如何设计模型,让其能够自动地识别这种区别,是这篇paper主要解决的问题。

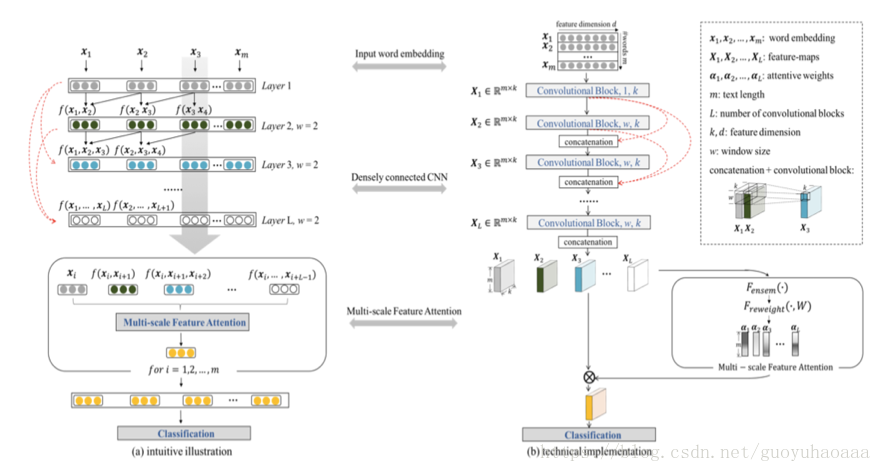

在正式介绍模型之前,作者提出了“a deeper model is more elegant than a wider solution”。因为使用小窗口的deeper model在模型高层次部分,其卷积器真正观测到的原始句子序列中的视野是越来越大的。于是,参照在图像处理中常见的一种结构,作者设计了一种网络结构如下所示:

左边是模型的逻辑运作示意图,右边是模型的真实实现示意图。其实图中最需要关注的就是那几条红线。假设模型的层次一共是

层,那么第

层结果计算公式如下所示:

其中参数矩阵

维度为

,其中w代表了宽度,一个k代表了卷积器的个数,一个k代表了中间词向量的维度。可以看出这里面

,

…

都是维度为

的矩阵,

代表了句子中单词的个数。在使用卷积处理之后,结果依然是

个维度为

结果矩阵,然后使用矩阵的对位相加操作得当最终的

为

。

按照这样的计算方式,最终模型的输出层有

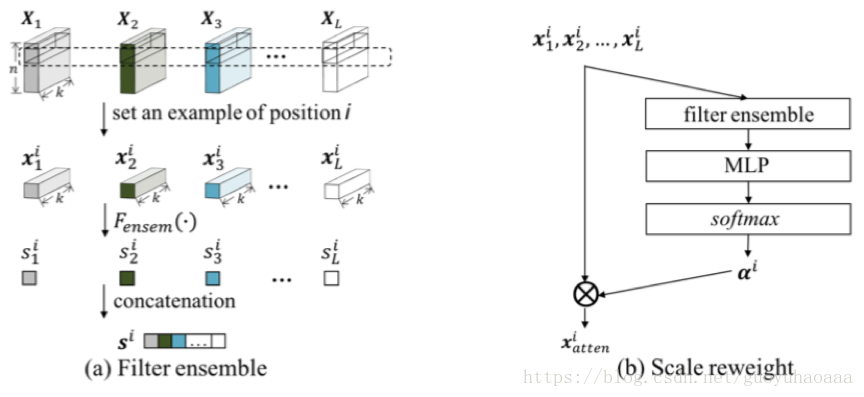

,每一个矩阵的每一行都代表了以该行号为下标的n-gram,接下来就是设计一种attention从中选择对分类最有意义的n-gram。整个过程如下图所示:

假设

代表第l层下标为i的语义向量,设

其中

最终句子的表征为

。接下来得到的

会送入到后续的处理模型中。

感觉这个输入信号直接通过跳层传到后续网络结构中的思想还是很有价值的,和深度残差网络的构造思想很像,以后可以灵活加以应用。