使用spark进行WordCount

1、终端输入命令,创建目录~/pythonwork/ipynotebook/data及复制文件/usr/local/spark/LICENSE(对LICENSE做WordCount)

mkdir -p ~/pythonwork/ipynotebook/data

cp /usr/local/spark/LICENSE ~/pythonwork/ipynotebook/data

2、执行WordCount spark命令

在终端或IPython Notebook键入命令(下面在IPython/Jupyter Notebook 中键入命令):

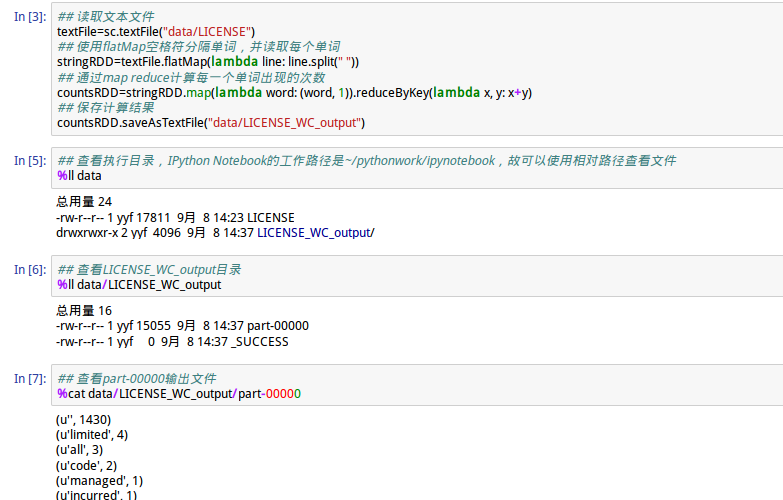

## 读取文本文件

textFile=sc.textFile("data/LICENSE")

## 使用flatMap空格符分隔单词,并读取每个单词

stringRDD=textFile.flatMap(lambda line: line.split(" "))

## 通过map reduce计算每一个单词出现的次数

countsRDD=stringRDD.map(lambda word: (word, 1)).reduceByKey(lambda x, y: x+y)

## 保存计算结果

countsRDD.saveAsTextFile("data/LICENSE_WC_output")

## 查看part-00000输出文件

%cat data/LICENSE_WC_output/part-00000