版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/lihaogn/article/details/82143786

1 spark-shell

1)将hive-site.xml文件复制到spark/conf/中,实现spark访问hive

2)启动spark-shell

spark-shell --master local[2]

or

spark-shell --jars jar包 --master local[2]使用

spark.sql("sql 语句").show4)启动spark-sql

spark-sql --jars jar包 --master local[2]使用:直接输入SQL语句

5)thriftserver/beeline的使用(默认端口为10000)

./start-thriftserver.sh \

--master local[2] \

--jars jar包 \

--hiveconf hive.server2.thrift.port=14000# beeline连接到thriftserver

beeline -u jdbc:hive2://localhost:14000 -n hadoop6)thriftserver和普通的spark-shell/spark-sql有什么区别

- spark-shell,spark-sql 都是一个spark application

- thriftserver, 不管启动多少个客户端(beeline/code),永远都是一个spark application,解决了一个数据共享的问题,多个客户端可以共享数据

2 thriftserver编程

1)pom.xml 添加文件

<!-- jdbc 操作依赖 使用thriftserver-->

<dependency>

<groupId>org.spark-project.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>1.2.1.spark2</version>

</dependency>2)SparkSQLThriftServerApp.scala

package com.lihaogn.spark

import java.sql.DriverManager

/**

* 通过jdbc方式访问

*/

object SparkSQLThriftServerApp {

def main(args: Array[String]): Unit = {

Class.forName("org.apache.hive.jdbc.HiveDriver")

val conn=DriverManager.getConnection("jdbc:hive2://localhost:14000","mac","")

val pstmt=conn.prepareStatement("select name,age,score from student")

val rs=pstmt.executeQuery()

while (rs.next()){

println("name: "+rs.getString("name")+

", age: "+rs.getInt("age")+

", score: "+rs.getDouble("score"))

}

rs.close()

pstmt.close()

conn.close()

}

}

3)启动 thriftserver

start-thriftserver.sh \

--master local[2] \

--jars /Users/Mac/software/mysql-connector-java-5.1.27-bin.jar \

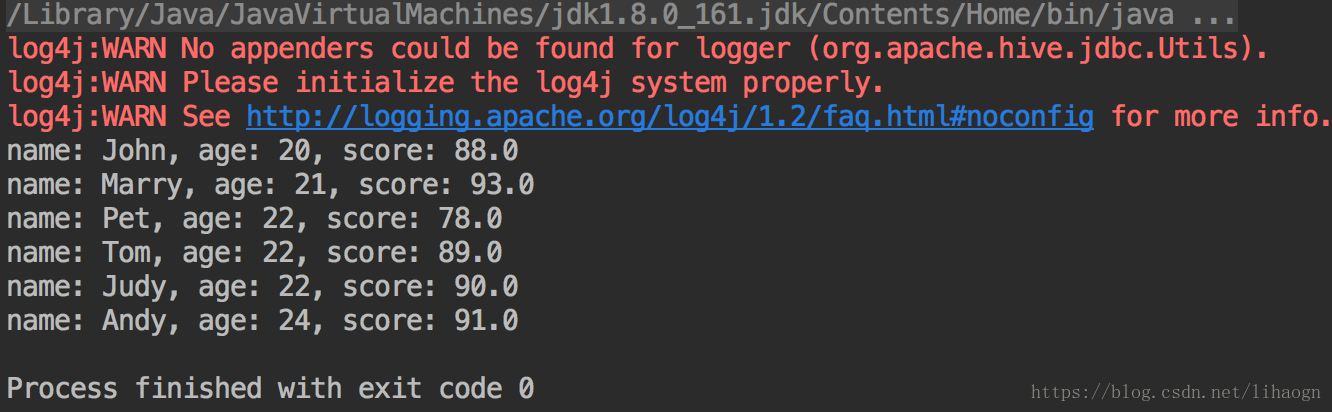

--hiveconf hive.server2.thrift.port=140004)运行程序

5)结果