多任务学习给出多个监督信息(标签),利用任务之间的相关性互相促进。

案例1-人脸识别

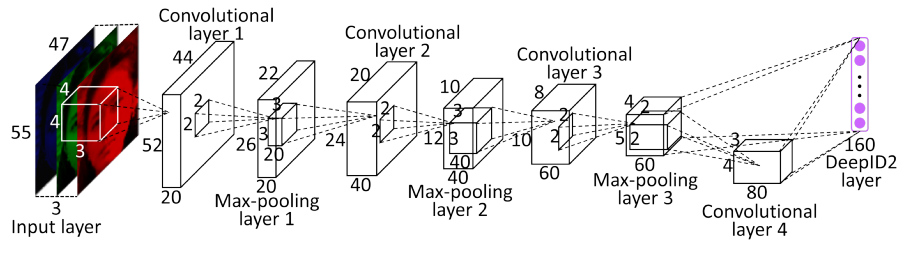

香港中文大学汤晓鸥组发表在NIPS14的论文《Deep Learning Face Representation by Joint Identification-Verification》,提出了一种联合训练人脸确认损失和人脸分类损失的多任务人脸识别网络DeepID2(Deep IDentification-verification features),网络结构如下图所示:

DeepID2中共有两个损失函数,分别为人脸分类损失函数,对应于Caffe中的SoftmaxLoss:

Ident(f,t,θid)=−∑−pilogp^i=−∑p^tIdent(f,t,θid)=−∑−pilogp^i=−∑p^t

Ident(f,t,θid)Ident(f,t,θid)表示分类任务的损失函数,ff为DeepID2特征向量,θidθid为Softmax层参数,pipi为属于第ii类的先验概率,即对于所有类别ii,pi=0pi=0,除了pt=1pt=1,tt为目标类别。

另外一个是人脸确认损失函数,对应于Caffe中的Contrastive Loss:

Verif(fi,fj,yij,θve)={12∥fi−fj∥2,12max(0,m−∥fi−fj∥)2,if yij=1if yij=−1Verif(fi,fj,yij,θve)={12‖fi−fj‖2,if yij=112max(0,m−‖fi−fj‖)2,if yij=−1

Verif(fi,fj,yij,θve)Verif(fi,fj,yij,θve)为度量学习任务的损失函数,fi,fjfi,fj为图片对(i,ji,j)的特征向量。yij=1yij=1表示(i,ji,j)属于同一类。

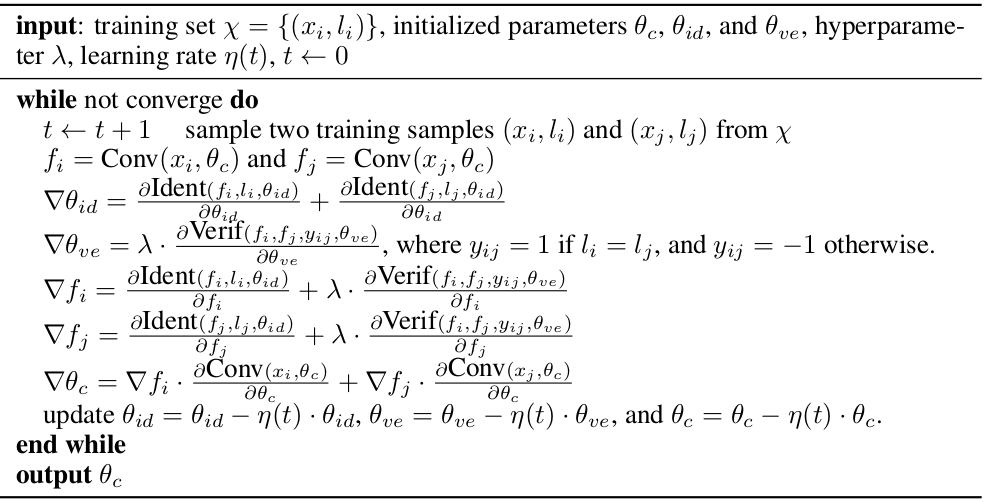

训练过程如下:

补充:

第二次看这篇论文,有了些新的体会:

论文也一直在强调为什么结合分类学习和对比学习效果会更好,论文原话:

“The face identification task increases the inter-personal variations by drawing DeepID2 extracted from different identities apart, while the face verification task reduces the intra-personal variations by pulling DeepID2 extracted from the same identity together”

总结为一句话就是:扩大类间距离和缩小类内距离。

第一次看时不是很理解,现在有了新的看法:

- 分类任务旨在区分不同类,理论上,只要类别不同学习到的特征肯定不同,但是如果类别相同的话就无法保证特征一定相同,可能会出现同一个人脸由于表情不同学习到了不同的特征。

- 验证这个任务从另一个方面提取特征:只要类别相同(即相似),提取到的特征相似,类别不同,特征就不同。但是呢提取到的特征不能用于分类,只能做区分。所以说两个任务具有一定的互补性。

而这篇论文主要目的是为了人脸识别,也就是说验证为主(分类任务是为了进一步提高验证的精度)。所以论文说了这句话:“ while the classification accuracy on identities in the training set is not crucial for us”。

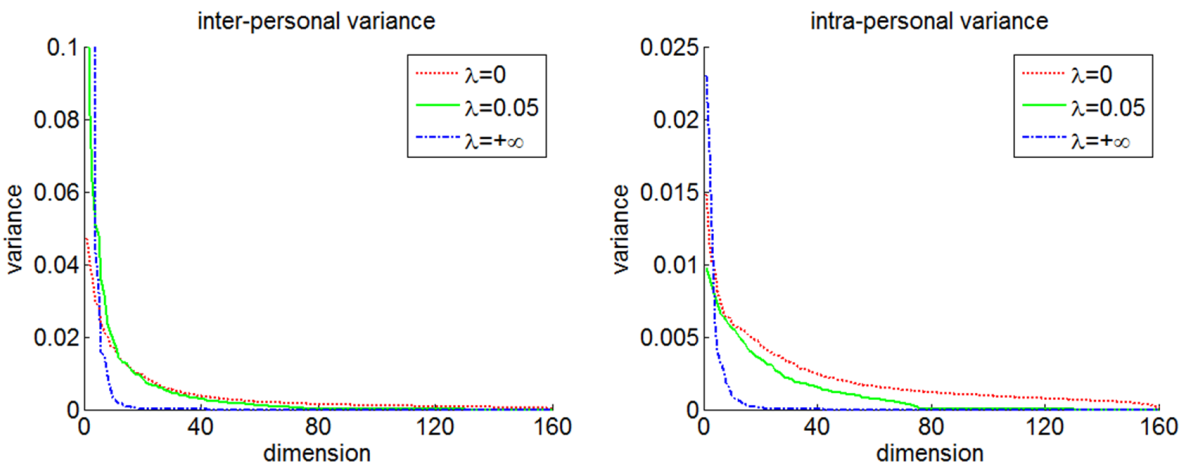

下面实验为证:

λλ是两个任务的比重,λ=0λ=0表示只用了分类任务,λ=+∞λ=+∞表示只用了验证任务,λ=0.05λ=0.05时验证精度最高(即验证任务的比重为5%)。可以看见λ=0λ=0时类间距离最大,同时类内距离同样也很大。λ=+∞λ=+∞时无论类间距离还是类内距离都很小,λ=0.05λ=0.05则做了一个很好的权衡。

案例2-Text-CNN

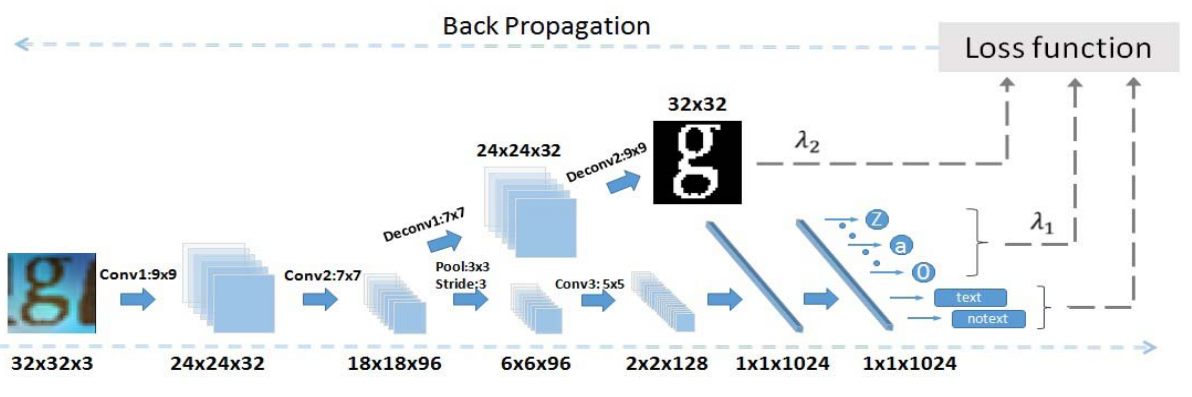

《Text-Attentional Convolutional Neural Network for Scene Text Detection》一文中介绍了TextCNN在传统CNN基础上加上了两个辅任务(auxiliary tasks)。

- 主任务:判断图片块是否含有字符(text/non-text,二分类问题)

- 辅任务1:给图片块中的字符分类(‘0-9,a-z,A-Z’,62类分类问题)

- 辅任务2:用Binary Mask表示字符位置(回归问题)

传统MTL训练过程中将所有任务的重要性视为相同,但是在这个模型中显然三个任务的重要性不同,比如低层的字符区域学习(辅任务2)比主任务的二分类要复杂得多,这会导致学习难度和收敛速率不同,因此引入的重要性因子λλ 。

argminWm,Wa∑i=1NLm(ymi,f(xi;Wm))+∑i=1N∑a∈AλaLa(ya,f(xi;Wa))argminWm,Wa∑i=1NLm(yim,f(xi;Wm))+∑i=1N∑a∈AλaLa(ya,f(xi;Wa))

这里AA表示辅任务集,NN为训练样本数量,LL为损失函数。其中正则项省略了。

损失函数的具体表示(分别对应上述的三个任务):

LB(ybi,f(xi;Wb)=ybilog(p(ybi|xi;Wb)),LB(yib,f(xi;Wb)=yiblog(p(yib|xi;Wb)),

LL(yli,f(xi;Wl)=ylilog(p(yli|xi;Wl)),LL(yil,f(xi;Wl)=yillog(p(yil|xi;Wl)),

LR(yri,f(xi;Wr)=∥yri−f(xi;Wr)∥2.LR(yir,f(xi;Wr)=‖yir−f(xi;Wr)‖2.

其中xi∈R32×32×3xi∈R32×32×3,ybi={0,1}∈R2yib={0,1}∈R2,yli={0...9,a...z,A...Z}∈R62yil={0...9,a...z,A...Z}∈R62,yri={0,1}∈R32×32yir={0,1}∈R32×32

训练过程类似于人眼识别图片中是否含有文字的过程:首先从复杂背景中定位文字区域(where),然后识别文字内容是什么(what),最后判断图片中是否含有文字(whether)。

先联合训练两个辅任务,接着停止训练辅任务2,继续训练辅任务1和主任务。

案例3-细粒度车辆分类

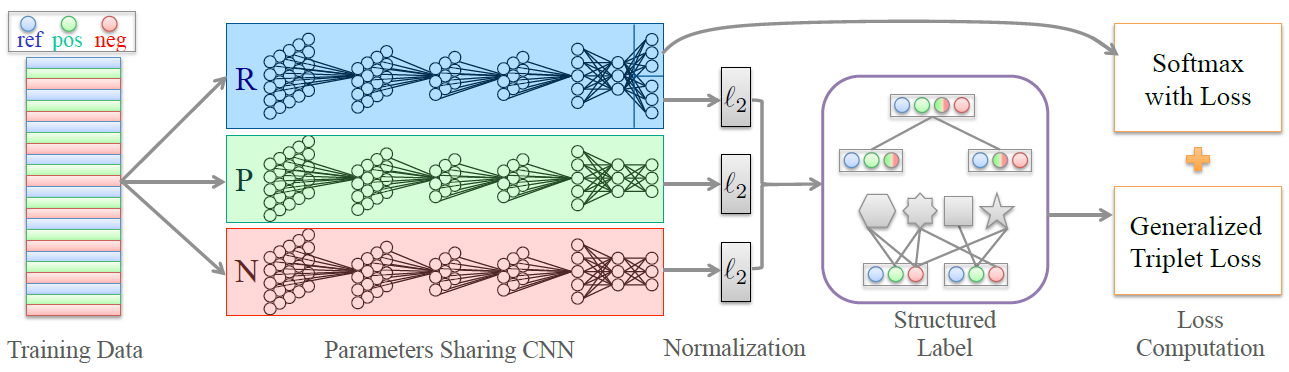

《Embedding Label Structures for Fine-Grained Feature Representation》介绍了将SoftmaxLoss和TripletLoss结合在一个网络中进行多任务训练的方法。

网络结构如下:

提醒注意的是为了计算Tiplet Loss,特征进行了L2范数归一操作。图中涉及到的Structured Label是为了进一步提升分类效果。

SoftmaxLoss:

Es(r;l)=1N∑i=1N−logefs(ri,li)∑Cc=1efs(ri,c)Es(r;l)=1N∑i=1N−logefs(ri,li)∑c=1Cefs(ri,c)

其中fs(ri,c)fs(ri,c)表示最后的全连接层在输入为riri下,第c类的输出。ll为对应输入的类别标签。

TripletLoss:

Et(r,p,n,m)=12N∑i=1Nmax{0,D(ri,pi)−D(ri,ni)+m}Et(r,p,n,m)=12N∑i=1Nmax{0,D(ri,pi)−D(ri,ni)+m}

其中D(.;.)D(.;.)表示两个特征向量f(.)f(.)(L2范数归一后)之间的欧式距离。mm为边距最小边距。

最终的Loss:

E=λsEs(r;l)+(1−λs)Et(r;p;n;m)