单独安装pyspark库在单机上是没法运行的,需要有相应的分布式软件,这里可以是spark+hadoop,配置安装教程链接:spark2.3在window10当中来搭建python3的使用环境pyspark

- 配置pyspark库

之前在安装spark的时候,提到过pyspark库的安装有几种方法,一种方法是直接将spark自带的pyspark库安装到python的库当中去;一种是使用命令pip install pyspark安装;还有一种是单独下载pyspark的安装包,解压以后安装到python库当中去。这几种方法,这里都会进行讲解。

将spark自带的pyspark库安装到python:

以管理员身份打开cmd,按一下键盘上的window键,依次选中Windows 系统,右键命令提示符,点击更多,点击以管理员身份运行

C:\>cd D:\spark\python

C:\>d:

D:\spark\python>

D:\spark\python>python setup.py install

出现这个图时pyspark就安装好了

pip install pyspark命令行方式安装:

同上面打开cmd的方式相同,需要以管理员身份运行,按一下键盘上的window键,依次选中Windows 系统,右键命令提示符,点击更多,点击以管理员身份运行

输入命令 pip install pyspark,等待安装完成,这里需要注意的是,pyspark本身的安装包占用磁盘空间很多,有几百M,这种方式安装需要在线下载pyspark,网速不错的话,是非常推荐的,这种方式最简单,只需要一行命令就行了。

单独下载安装pyspark:

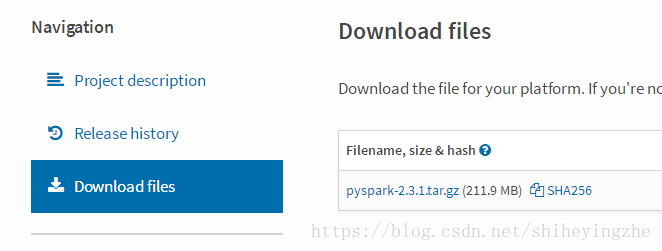

进入pyspark的PyPI的网站,点击左侧的Download files,下载pyspark的安装包,然后解压好,这里解压的路径是D:\pyspark-2.3.1

同上面打开cmd的方式相同,需要以管理员身份运行,按一下键盘上的window键,依次选中Windows 系统,右键命令提示符,点击更多,点击以管理员身份运行

进入解压以后文件夹的目录

D:\pyspark-2.3.1>python setup.py install

以上几种方式都可以安装pyspark,其中最方便的方式是使用命令行 pip install pyspark,pyspark的WordCount示例链接:python中使用jieba分词库编写spark中文版WordCount