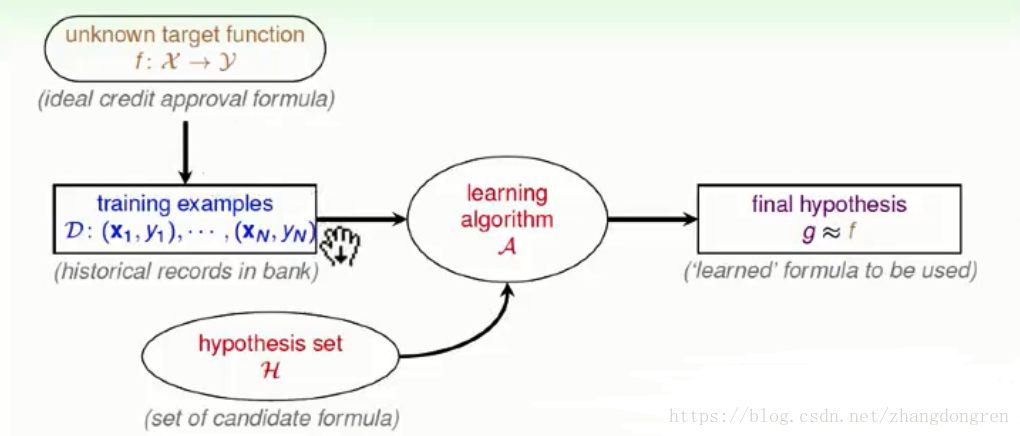

机器学习的流程如下图,我们的目标是找到 f,但是我们不知道 f 长啥样,但是我们有一堆数据D,现在我们要用数据D进行训练,然后会得到一个假设集hypothesis,然后我们再设计一条演算法,该演算法的任务就是从假设集hypothesis中找到一个 g,使得 g≈f

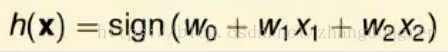

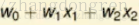

现在回到上一节提到的信用卡发卡问题,我们计算客户是否符合发卡要求的公式是

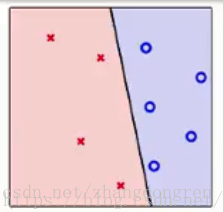

那么如何下手呢?首先我们从一条线开始,令这条线为W0,然后以这条线为基准,不停的旋转修正它,直到把所有的圈圈和叉叉都分在不同的两边为止。

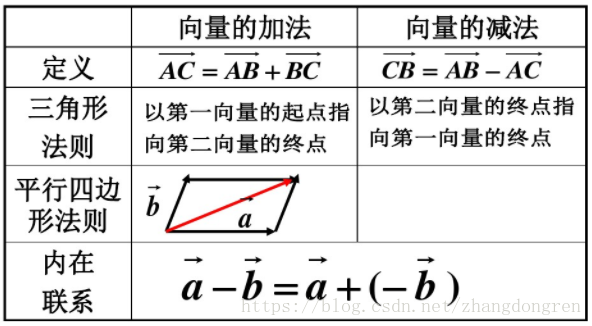

这里我们需要用到向量的加减的相关知识,顺便复习一下。

下面是向量加减法的运算法则:

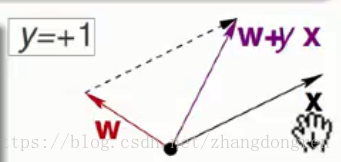

接下来我们就要用上面的数学知识去找到合适的线,直到能够把所有的圈圈叉叉都分在不同的两边。具体的方法如下:

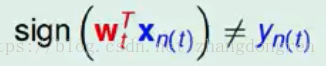

如上图,假设现在我们需要的值是+1,但是我们所拥有的W与X进行sgin(WX)运算后却不等于+1,即

相反,如果我们需要的是-1,而实际上向量W和X之间的夹角又太小,所以我们需要做减法把向量间的夹角变大,如下图:

通过这种方式进行筛选g的算法叫做PLA,即Perceptron Learning AIgorithm.

以下就是在林軒田老师的视频中旋转图的其中一个画面,我这里只拿出一张来解释其中的含义。

但是问题来了,这样的循环什么时候停止?要知道平面上可是有无限多条线!并且,我们真能保证 g≈f 吗?答案是不能!所以下面的课我们要解决这些问题,记住喔,要不然下一节课你又莫名其妙了,无法连贯起来。

=================================================================================

加入我们

估计这一节课会把不少人给绕晕,我现在也还有蛮多疑问,比如在符号函数y=sign(WX)中我们要讨论的向量的积,但为何最后变成讨论向量的加减法,它们之间有什么联系?欢迎大家加入Q群讨论:463255841