所谓回归,就是根据已知数据集及其标签集预测出一个模型,并可以根据这个预测出来的模型预测出未知标签的数据对应的值。常见的回归方法有:线性回归、Lasso回归、Ridge回归、多项式回归、决策树等。

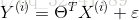

线性回归,就是根据实际数据集

那么,怎么求解最优的拟合直线呢?

根据中心极限定理,可知误差值

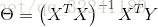

在这里,我们省略极大似然估计过程,直接使用最小二乘法求解。

可知损失函数(目标函数)为:

其中,X,Y分别表示样本的数据集(特征数据)和标签集(实际目标值)。

通过解析的方式可以求得,

但是,由于这种方法需要将数据集和标签集全部转化为矩阵进行乘法运算(点乘)。所以在数据集较大的时候,存在实际程序运行较慢等缺点。

所以这里介绍我们常用的一种方法,梯度下降法。

对于(1)式,对

则其参数θ的更新方法为:

其中,

由于实例的参考较多,这里就不列举了。