GBDT的核心就在于,每一棵树学的是之前所有树结论和的残差,这个残差就是一个加预测值后能得真实值的累加量。

残差向量(-1, 1, -1, 1)都是它的全局最优方向,这就是Gradient。

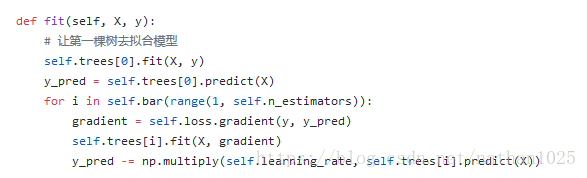

gradient = self.loss.gradient(y, y_pred)

https://github.com/RRdmlearning/Machine-Learning-From-Scratch

https://github.com/bound2020/simple_gbdt/blob/master/gbdt.py