ActiveMQ的消息存储持久化

■概述

ActiveMQ不仅支持 persistent和 non-persistent两种方式,还支持消息的

恢复( recovery)方式

PTP

Queue的存储是很简单的,就是一个FIFO的 Queue

图1-1

PUB/SUB

对于持久化订阅主题,每一个消费者将获得一个消息的复制

图1-2

有效的消息存储

ActiveMQ提供了一个插件式的消息存储,类似于消息的多点传播,主要实现了如下几种:

1:AMQ消息存储-基于文件的存储方式,是以前的默认消息存储

2: KahaDB消息存储-提供了容量的提升和恢复能力,是现在的默认存储方式

3:JDBC消息存储-消息基于JDBC存储的

4:Memory信息存储-基于内存的信息存储

KahaDB Message Store

概述

KahaDB是目前默认的存储方式,可用于任何场景,提高了性能和恢复能力。消息存储使用一个事

务日志和仅仅用一个索引文件来存储它所有的地址。

KahaDB是一个专门针对消息持久化的解决方案,它对典型的消息使用模式进行了优化。在Kaha

中,数据被追加到data logs中。当不再需要log文件中的数据的时候,log文件会被丢弃

KahaDB基本配置例子

<persistenceAdapter>

<kahaDB directory="{activemq.data}/kahadb"/>

</persistenceAdapter>

可用的属性有:

1: director: KahaDB存放的路径,默认值 activemq-data

2: indexWriteBatchsize:批量写入磁盘的索引page数量,默认值1000

3: indexCachesize:内存中缓存索引page的数量,默认值10000

4: enableIndexWriteAsync:是否异步写出索引,默认 false

5: journalMaxFileLength:设置每个消息data1og的大小,默认是32MB

6: enableJournalDiskSyncs:设置是否保证每个没有事务的内容,被同步写入磁盘,JMS持久化的时候需

要,默认为true

7: cleanupInterval: 在检查到不再使用的消息后,在具体删除消息前的时间,默认30000

8: checkpointInterval: checkpoint的间隔时间,默认5000

9: ignoreMissingJournalfiles:是否忽略丢失的消息日志文件,默认fa1se

10: checkForCorruptJournalFiles:在启动的时候,将会验证消息文件是否损坏,默认fa1se

11: checksumJournalFiles:是否为每个消息日志文件提供 checksum,默认 false

12: archiveDatalogs:是否移动文件到特定的路径,而不是删除它们,默认fa1se

13: directoryArchive:定义消息已经被消费过后,移动 data log到的路径,默认nu11

14: databaseLockedWailayDelay:获得数据库锁的等待时间( used by shared master/ slave),默认

10000

15: maxAsyncJobs:设置最大的可以存储的异步消息队列,默认值10000,可以和 concurrent

MessageProducers设置成一样的值

16: concurrentStoreAndDispatchTransactions:是否分发消息到客户端,同时事务存储消息,默认

true

17: concurrentstoreAndDispatchTopics:是否分发 Topic消息到客户端,同时进行存储,默认true

18: concurrentStoreAndDispatchQueues:是否分发 queue消息到客户端,同时进行存储,默认true

在Java中内嵌使用 Broker,使用 KahaDB的例子

package com.mq.test.activeMQ; import java.io.File; import org.apache.activemq.broker.BrokerService; import org.apache.activemq.store.kahadb.KahaDBStore; public class KahaDB { BrokerService createEmbeddedBroker() throws Exception { BrokerService broker =new BrokerService(); File dataFileDir =new File( "target/amg-in-action/kahadb"); KahaDBStore kaha= new KahaDBStore(); kaha.setDirectory (dataFileDir); // Using a bi gger journal file kaha.setJournalMaxFileLength(1024*100); // small batch means more frequent and smaller writes kaha.setIndexWriteBatchSize(100); // do the Andex write in a separate thread kaha.setEnableIndexWriteAsync(true); broker.setPersistenceAdapter(kaha); //create a transport connector broker.addConnector("tcp://localhost:61616"); //start the broker broker.start(); return broker; } }

AMQ Message Store概述

AMQ Message Store是 ActiveMQ5.0缺省的持久化存储,它是一个基于文件、事

务存储设计为快速消息存储的一个结构,该结构是以流的形式来进行消息交互的。

这种方式中, Messages被保存到 data logs中,同时被 reference store进行索

引以提高存取速度。 Date logs由一些单独的 data log文件组成,缺省的文件大小是

32M,如果某个消息的大小超过了 data log文件的大小,那么可以修改配置以增加

data log文件的大小。如果某个 data log文件中所有的消息都被成功消费了,那么这

个 data log文件将会被标记,以便在下一轮的清理中被删除或者归档。

AMQ Message Store配置示例

<broker brokerName=broker persistent=true useShutdownHook="false">

<persistenceAdapter>

<amqPersistenceAdapter directory="${activemq.basel/data" maxFileLength="32mb"/>

</persistenceAdapter>

</broker>

使用JDBC来持久化消息

ActiveMQ支持使用JDBC来持久化消息,预定义的表如下:

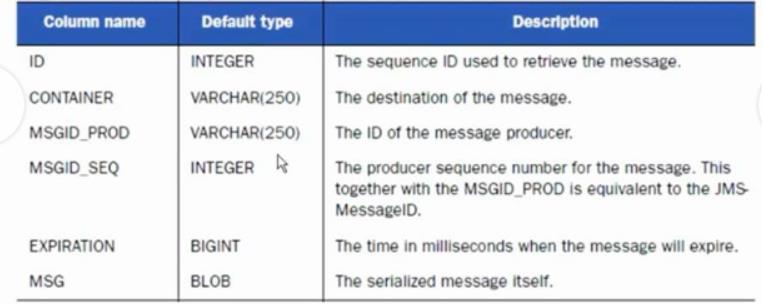

1:消息表,缺省表名为 ACTIVEMQ_MSGS, queue和 topic都存在里面i,结构如下:

图2-1

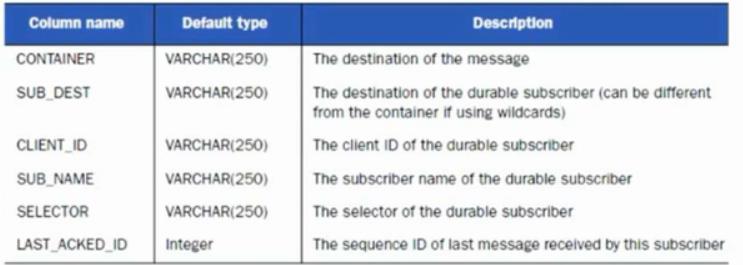

2: ACTIVEMQ_ACKS表存储持久订阅的信息和最后一个持久订阅接收的消息ID,结构如下

图2-2

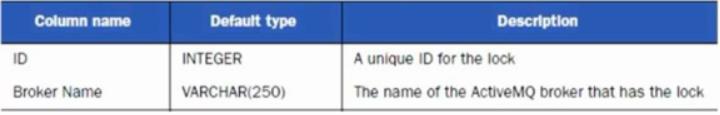

3:锁定表,缺省表名为 ACTIVEMQ_LOCK,用来确保在某一时刻,只能有一个

ActiveMQ broker实例来访问数据库,结构如下:

图2-3

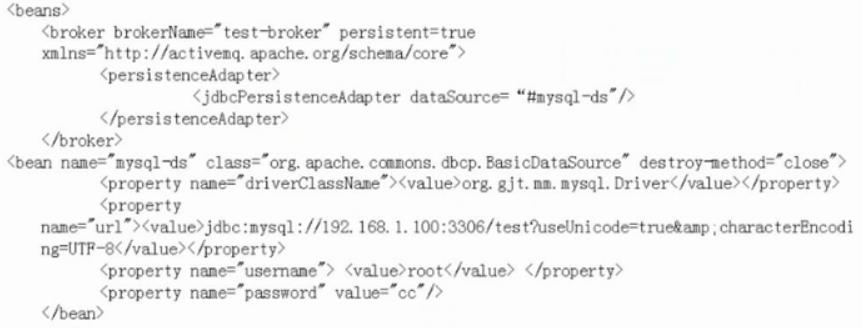

■使用JDBC来持久化消息的配置示例

图2-4

JDBC Message Store with ActiveMQ Journal

这种方式克服了 JDBC Store的不足,用快速的缓存写入技术,大大提高了性能。配置示例如下: