使用nfs作为后端存储:

此处使用OSP1(使用packstack安装的openstack环境) 作为NFS服务器来测试使用。

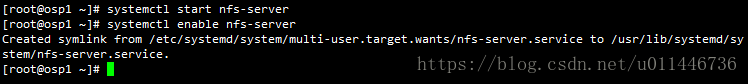

在OSP1上配置NFS:

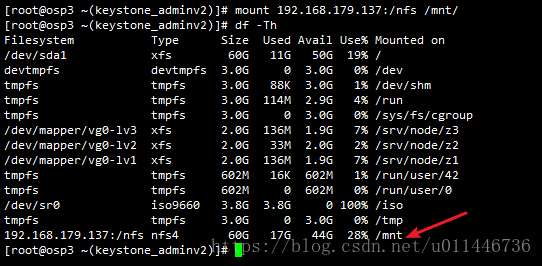

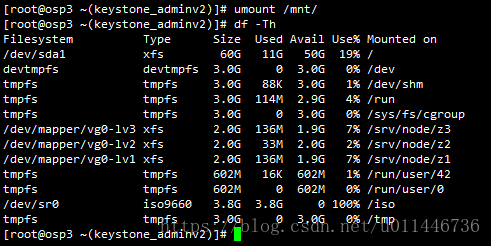

在OSP3上面测试访问NFS成功,如下:

# showmount -e 192.168.179.137

测试挂载成功:

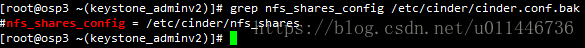

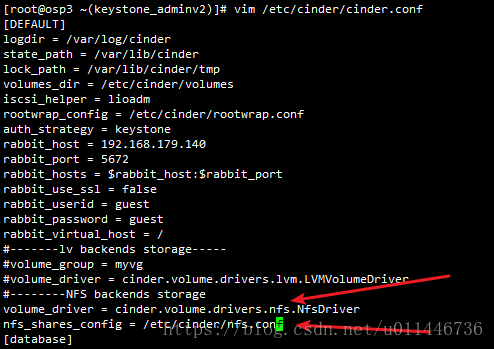

如何配置cinder用NFS作为后端存储:

创建这个nfs.conf文件

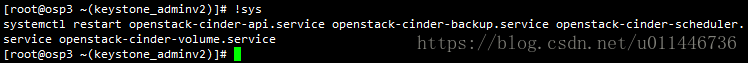

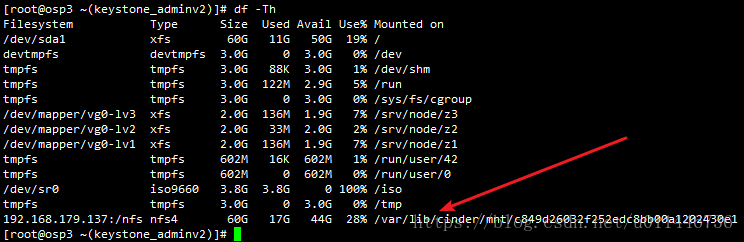

重启服务之后: nfs后端存储自动挂载到指定的配置目录中

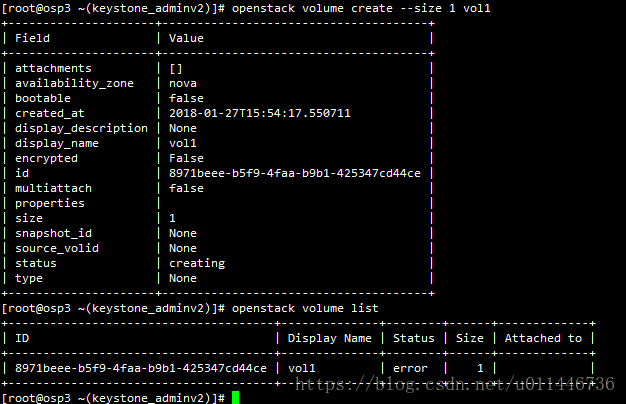

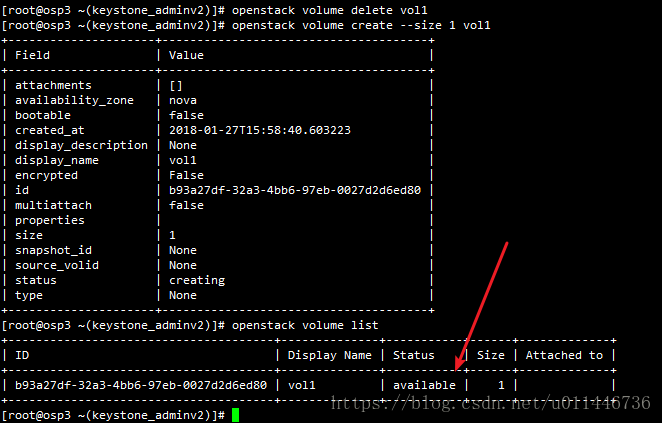

创建volume 测试:

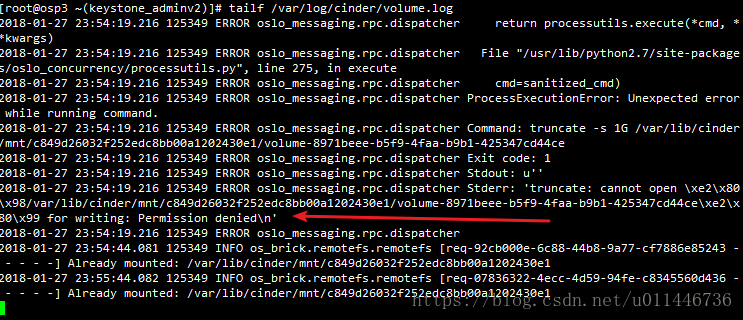

创建失败: 权限的原因

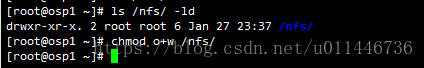

修改NFS server的共享目录的权限:

重新创建成功:

如下所示,是被写入到nfs 作为后端存储

#####################################################################################################################

使用ceph作为后端存储:

使用node1作为ceph的服务器,OSP3作为客户端,配置cinder的ceph后端存储:

创建供cinder使用的pool:

# rados mkpool cinderdisk

# rados lspool

# rados -p cinderdisk ls

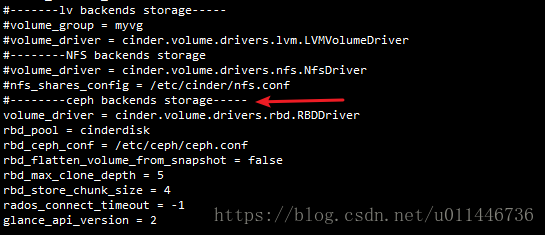

配置ceph作为cinder的后端存储:【查看ceph存储的官方文档】复制并修改cinder.conf如下:

volume_driver = cinder.volume.drivers.rbd.RBDDriver

rbd_pool = cinderdisk

rbd_ceph_conf = /etc/ceph/ceph.conf

rbd_flatten_volume_from_snapshot = false

rbd_max_clone_depth = 5

rbd_store_chunk_size = 4

rados_connect_timeout = -1

glance_api_version = 2

修改admin的密码读取权限: 让cinder用户有读取权限

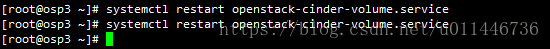

重启volume服务:

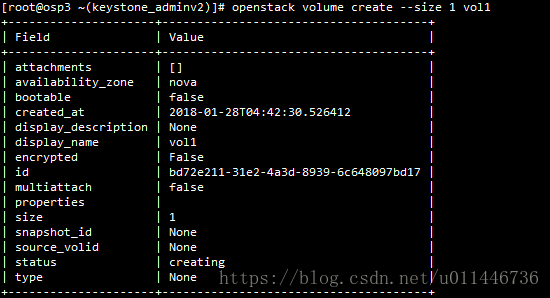

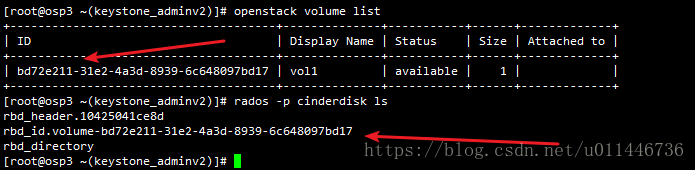

创建volume测试cinder的ceph后端存储:

# openstack volume create --size 1 vol1

创建的新volume存储在ceph的cinderdisk volume中。