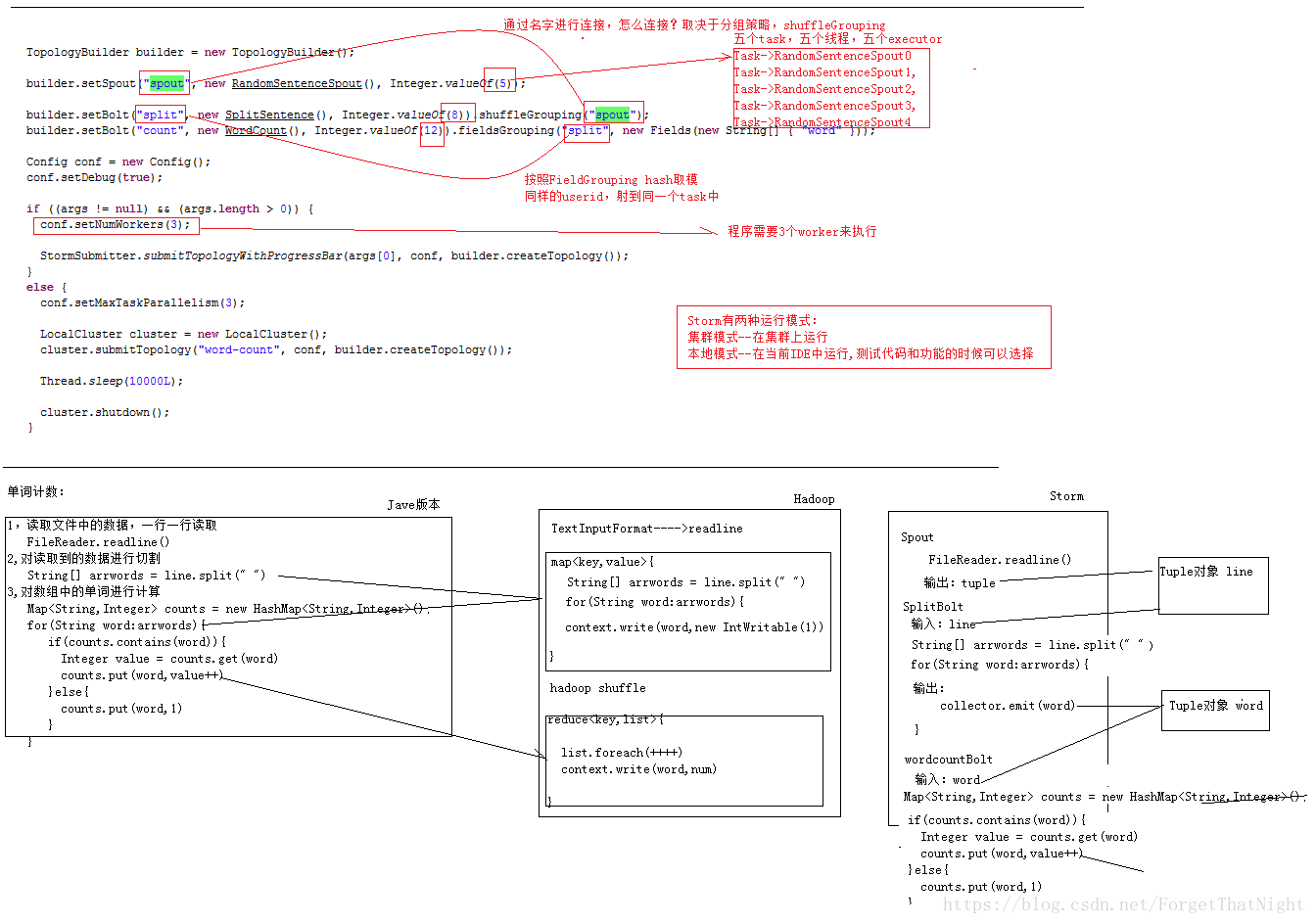

1、编程模型

DataSource:外部数据源

Spout:接受外部数据源的组件,将外部数据源转化成Storm内部的数据,以Tuple为基本的传输单元下发给Bolt

Bolt:接受Spout发送的数据,或上游的bolt的发送的数据。根据业务逻辑进行处理。发送给下一个Bolt或者是存储到某种介质上。介质可以是Redis可以是mysql,或者其他。

Tuple:Storm内部中数据传输的基本单元,里面封装了一个List对象,用来保存数据。

StreamGrouping:数据分组策略

7种:shuffleGrouping(Random函数),Non Grouping(Random函数),FieldGrouping(Hash取模)、Local or ShuffleGrouping 本地或随机,优先本地。

2、并发度

用户指定的一个任务,可以被多个线程执行,并发度的数量等于线程的数量。一个任务的多个线程,会被运行在多个Worker(JVM)上,有一种类似于平均算法的负载均衡策略。尽可能减少网络IO,和Hadoop中的MapReduce中的本地计算的道理一样。

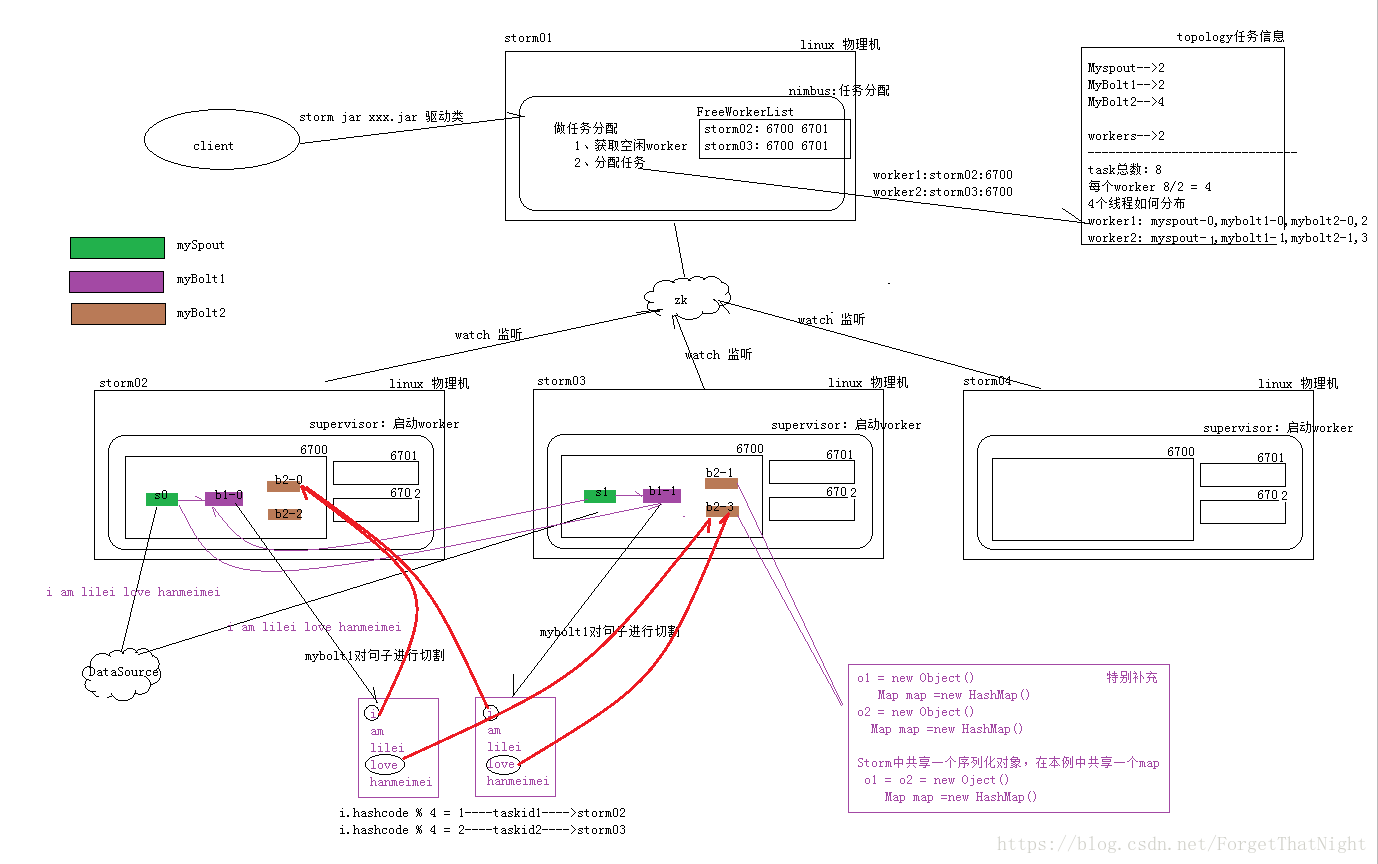

3、架构

Nimbus:任务分配

Supervisor:接受任务,并启动worker。worker的数量根据端口号来的。

Worker:执行任务的具体组件(其实就是一个JVM),可以执行两种类型的任务,Spout任务或者bolt任务。

Task:Task=线程=executor。 一个Task属于一个Spout或者Bolt并发任务。

Zookeeper:保存任务分配的信息、心跳信息、元数据信息。

4、Worker与topology

一个worker只属于一个topology,每个worker中运行的task只能属于这个topology。 反之,一个topology包含多个worker,其实就是这个topology运行在多个worker上。

一个topology要求的worker数量如果不被满足,集群在任务分配时,根据现有的worker先运行topology。如果当前集群中worker数量为0,那么最新提交的topology将只会被标识active,不会运行,只有当集群有了空闲资源之后,才会被运行。

流式计算: http://note.youdao.com/share/?id=c01de32830c84be07c23df110ac262cf&type=notebook

推荐系统: http://note.youdao.com/share/?id=c15c3a7b3fed693f01effeca80378a34&type=notebook

启动命令

DataSource:外部数据源

Spout:接受外部数据源的组件,将外部数据源转化成Storm内部的数据,以Tuple为基本的传输单元下发给Bolt

Bolt:接受Spout发送的数据,或上游的bolt的发送的数据。根据业务逻辑进行处理。发送给下一个Bolt或者是存储到某种介质上。介质可以是Redis可以是mysql,或者其他。

Tuple:Storm内部中数据传输的基本单元,里面封装了一个List对象,用来保存数据。

StreamGrouping:数据分组策略

7种:shuffleGrouping(Random函数),Non Grouping(Random函数),FieldGrouping(Hash取模)、Local or ShuffleGrouping 本地或随机,优先本地。

2、并发度

用户指定的一个任务,可以被多个线程执行,并发度的数量等于线程的数量。一个任务的多个线程,会被运行在多个Worker(JVM)上,有一种类似于平均算法的负载均衡策略。尽可能减少网络IO,和Hadoop中的MapReduce中的本地计算的道理一样。

3、架构

Nimbus:任务分配

Supervisor:接受任务,并启动worker。worker的数量根据端口号来的。

Worker:执行任务的具体组件(其实就是一个JVM),可以执行两种类型的任务,Spout任务或者bolt任务。

Task:Task=线程=executor。 一个Task属于一个Spout或者Bolt并发任务。

Zookeeper:保存任务分配的信息、心跳信息、元数据信息。

4、Worker与topology

一个worker只属于一个topology,每个worker中运行的task只能属于这个topology。 反之,一个topology包含多个worker,其实就是这个topology运行在多个worker上。

一个topology要求的worker数量如果不被满足,集群在任务分配时,根据现有的worker先运行topology。如果当前集群中worker数量为0,那么最新提交的topology将只会被标识active,不会运行,只有当集群有了空闲资源之后,才会被运行。

流式计算: http://note.youdao.com/share/?id=c01de32830c84be07c23df110ac262cf&type=notebook

推荐系统: http://note.youdao.com/share/?id=c15c3a7b3fed693f01effeca80378a34&type=notebook

启动命令

bin/storm jar examples/storm-starter/storm-starter-topologies-0.9.6.jarstorm.starter.WordCountTopology wordcount

上传文件命令rz

mv stormwordcount-1.0-SNAPSHOT.jar myStormApp.jar

storm jar myStormApp.jar xx.xx.xx.驱动类以驱动类WordCountTopology启动,源码如下

依赖-http://search.maven.org/中搜索storm

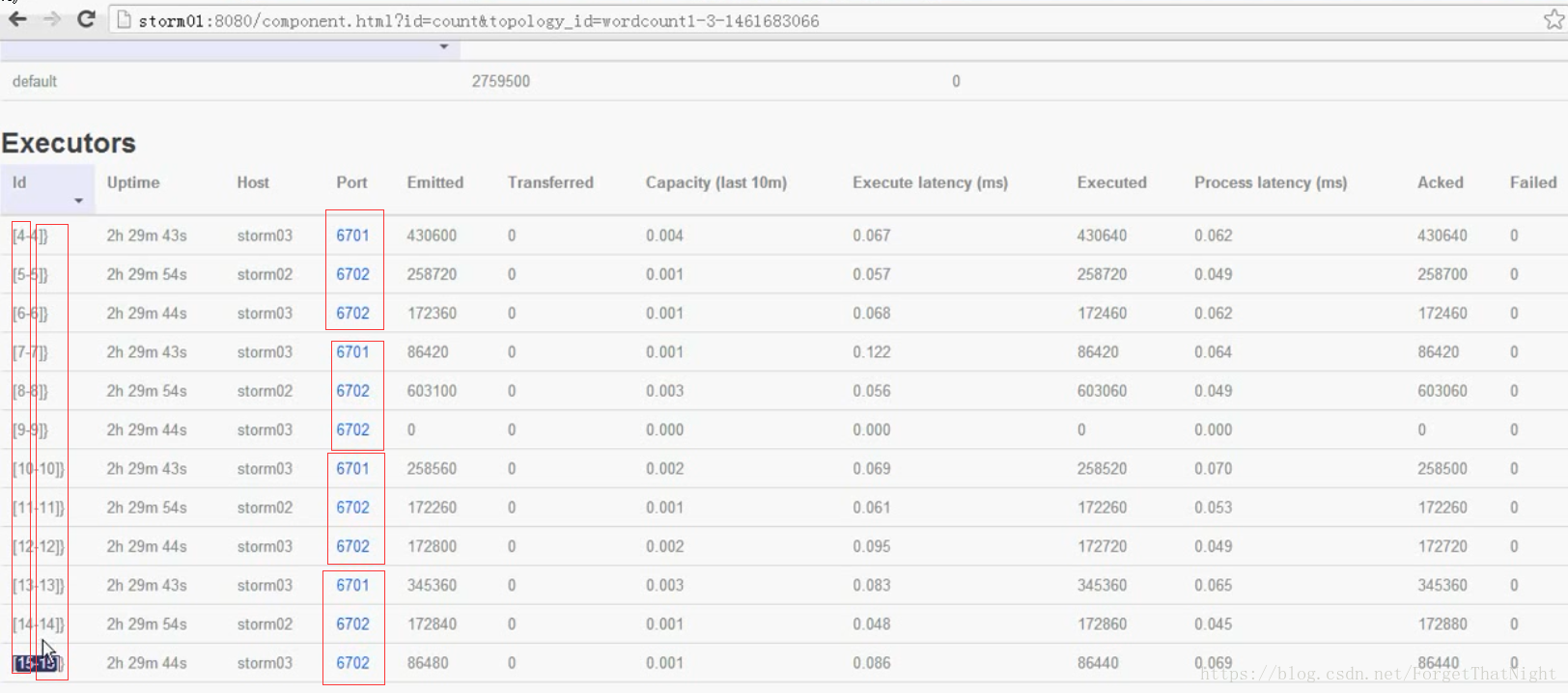

查看Executors的worker运行日志,找到包含端口号的几个日志文件即可

cd /usr/local/src/storm/log其中spout发送到bolt是随机发送到集群中的其他bolt的,而bolt1切分单词后到bolt2是根据key来划分

其中workers分配mybolt2的4个并行度任务时是按照taskID来进行:

WordCountTopologMain

package cn.itcast.storm;

import backtype.storm.Config;

import backtype.storm.LocalCluster;

import backtype.storm.StormSubmitter;

import backtype.storm.generated.AlreadyAliveException;

import backtype.storm.generated.InvalidTopologyException;

import backtype.storm.topology.TopologyBuilder;

import backtype.storm.tuple.Fields;

/**

* Created by maoxiangyi on 2016/4/27.

*/

public class WordCountTopologMain {

public static void main(String[] args) throws AlreadyAliveException, InvalidTopologyException {

//1、准备一个TopologyBuilder

TopologyBuilder topologyBuilder = new TopologyBuilder();

topologyBuilder.setSpout("mySpout",new MySpout(),2);//并发度2

topologyBuilder.setBolt("mybolt1",new MySplitBolt(),2).shuffleGrouping("mySpout");//并发度为2,随机方式发送到task

topologyBuilder.setBolt("mybolt2",new MyCountBolt(),4).fieldsGrouping("mybolt1", new Fields("word"));//并发度为4,按key发送到task

// topologyBuilder.setBolt("mybolt2",new MyCountBolt(),4).shuffleGrouping("mybolt1");

// config.setNumWorkers(2);

/**

* i

* am

* lilei

* love

* hanmeimei

*/

//2、创建一个configuration,用来指定当前topology 需要的worker的数量

Config config = new Config();

config.setNumWorkers(2);

//3、提交任务 -----两种模式 本地模式和集群模式

// StormSubmitter.submitTopology("mywordcount",config,topologyBuilder.createTopology());

LocalCluster localCluster = new LocalCluster();

localCluster.submitTopology("mywordcount",config,topologyBuilder.createTopology());

}

} package cn.itcast.storm;

import backtype.storm.spout.SpoutOutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IRichSpout;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseRichSpout;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Values;

import java.util.Map;

/**

* Created by maoxiangyi on 2016/4/27.

*/

public class MySpout extends BaseRichSpout {

SpoutOutputCollector collector;

//初始化方法

public void open(Map conf, TopologyContext context, SpoutOutputCollector collector) {

this.collector = collector;

}

//storm 框架在 while(true) 调用nextTuple方法

public void nextTuple() {

collector.emit(new Values("i am lilei love hanmeimei"));

}

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("love"));

}

}package cn.itcast.storm;

import backtype.storm.task.OutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IBasicBolt;

import backtype.storm.topology.IRichBolt;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseRichBolt;

import backtype.storm.tuple.Tuple;

import java.util.HashMap;

import java.util.Map;

/**

* Created by maoxiangyi on 2016/4/27.

*/

public class MyCountBolt extends BaseRichBolt {

OutputCollector collector;

Map<String, Integer> map = new HashMap<String, Integer>();

public void prepare(Map stormConf, TopologyContext context, OutputCollector collector) {

this.collector = collector;

}

public void execute(Tuple input) {

String word = input.getString(0);

Integer num = input.getInteger(1);

System.out.println(Thread.currentThread().getId() + " word:"+word);

if (map.containsKey(word)){

Integer count = map.get(word);

map.put(word,count + num);

}else {

map.put(word,num);

}

// System.out.println("count:"+map);

}

public void declareOutputFields(OutputFieldsDeclarer declarer) {

//不輸出

}

}

package cn.itcast.storm;

import backtype.storm.task.OutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IBasicBolt;

import backtype.storm.topology.IRichBolt;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseRichBolt;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Tuple;

import backtype.storm.tuple.Values;

import java.util.Map;

/**

* Created by maoxiangyi on 2016/4/27.

*/

public class MySplitBolt extends BaseRichBolt {

OutputCollector collector;

//初始化方法

public void prepare(Map stormConf, TopologyContext context, OutputCollector collector) {

this.collector = collector;

}

// 被storm框架 while(true) 循环调用 传入参数tuple

public void execute(Tuple input) {

String line = input.getString(0);

String[] arrWords = line.split(" ");

for (String word:arrWords){

collector.emit(new Values(word,1));

}

}

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("word","num"));

}

}