1.SolrCloud介绍

1.1.SolrCloud简介

SolrCloud(solr 云)是Solr提供的分布式搜索方案,当你需要大规模,容错,分布式索引和检索能力时使用 SolrCloud。当一个系统的索引数据量少的时候是不需要使用SolrCloud的,当索引量很大,搜索请求并发很高,这时需要使用SolrCloud来满足这些需求。

SolrCloud是基于Solr和Zookeeper的分布式搜索方案,它的主要思想是使用Zookeeper作为集群的配置信息中心。

它有几个特色功能:

1)集中式的配置信息

2)自动容错

3)近实时搜索

4)查询时自动负载均衡

1.2.Zookeeper简介

Zookeeper直译是 动物园管理员,他是用来管hadoop(大象)、Hive(蜜蜂)、pig(小猪)的管理员, Apache Hbase和 Apache Solr 的分布式集群都用到了zookeeper;zookeeper是一个分布式的、开源的程序协调服务,是hadoop项目下的一个子项目。

1.3.Zookeeper功能

1.3.1.配置管理

在我们的应用中除了代码外,还有一些就是各种配置。比如数据库连接等。一般我们都是使用配置文件的方式,在代码中引入这些配置文件。但是当我们只有一种配置,只有一台服务器,并且不经常修改的时候,使用配置文件是一个很好的做法,但是如果我们配置非常多,有很多服务器都需要这个配置,而且还可能是动态的话使用配置文件就不是个好主意了。这个时候往往需要寻找一种集中管理配置的方法,我们在这个集中的地方修改了配置,所有对这个配置感兴趣的都可以获得变更。比如我们可以把配置放在数据库里,然后所有需要配置的服务都去这个数据库读取配置。但是,因为很多服务的正常运行都非常依赖这个配置,所以需要这个集中提供配置服务的服务具备很高的可靠性。一般我们可以用一个集群来提供这个配置服务,但是用集群提升可靠性,那如何保证配置在集群中的一致性呢? 这个时候就需要使用一种实现了一致性协议的服务了。Zookeeper就是这种服务,它使用Zab这种一致性协议来提供一致性。现在有很多开源项目使用Zookeeper来维护配置,比如在HBase中,客户端就是连接一个Zookeeper,获得必要的HBase集群的配置信息,然后才可以进一步操作。还有在开源的消息队列Kafka中,也使用Zookeeper来维护broker的信息。在Alibaba开源的SOA框架Dubbo中也广泛的使用Zookeeper管理一些配置来实现服务治理。

1.3.2.名字服务

名字服务这个就很好理解了。比如为了通过网络访问一个系统,我们得知道对方的IP地址,但是IP地址对人非常不友好,这个时候我们就需要使用域名来访问。但是计算机是不能识别域名的。怎么办呢?如果我们每台机器里都备有一份域名到IP地址的映射,这个倒是能解决一部分问题,但是如果域名对应的IP发生变化了又该怎么办呢?于是我们有了DNS这个东西。我们只需要访问一个大家熟知的(known)的点,它就会告诉你这个域名对应的IP是什么。在我们的应用中也会存在很多这类问题,特别是在我们的服务特别多的时候,如果我们在本地保存服务的地址的时候将非常不方便,但是如果我们只需要访问一个大家都熟知的访问点,这里提供统一的入口,那么维护起来将方便得多了。

1.3.3.分布式锁

在第一简介中已经介绍了Zookeeper是一个分布式协调服务。这样我们就可以利用Zookeeper来协调多个分布式进程之间的活动。比如在一个分布式环境中,为了提高可靠性,我们的集群的每台服务器上都部署着同样的服务。但是,一件事情如果集群中的每个服务器都进行的话,那相互之间就要协调,编程起来将非常复杂。而如果我们只让一个服务进行操作,那又存在单点。通常还有一种做法就是使用分布式锁,在某个时刻只让一个服务去干活,当这台服务出问题的时候锁释放,立即fail over到另外的服务。这在很多分布式系统中都是这么做,这种设计有一个更好听的名字叫Leader Election(leader选举)。比如HBase的Master就是采用这种机制。但要注意的是分布式锁跟同一个进程的锁还是有区别的,所以使用的时候要比同一个进程里的锁更谨慎的使用。

1.3.4.集群管理

在分布式的集群中,经常会由于各种原因,比如硬件故障,软件故障,网络问题,有些节点会进进出出。有新的节点加入进来,也有老的节点退出集群。这个时候,集群中其他机器需要感知到这种变化,然后根据这种变化做出对应的决策。比如我们是一个分布式存储系统,有一个中央控制节点负责存储的分配,当有新的存储进来的时候我们要根据现在集群目前的状态来分配存储节点。这个时候我们就需要动态感知到集群目前的状态。还有,比如一个分布式的SOA架构中,服务是一个集群提供的,当消费者访问某个服务时,就需要采用某种机制发现现在有哪些节点可以提供该服务(这也称之为服务发现,比如Alibaba开源的SOA框架Dubbo就采用了Zookeeper作为服务发现的底层机制)。还有开源的Kafka队列就采用了Zookeeper作为Consumer的上下线管理。

1.4.SolrCloud结构

SolrCloud为了降低单机的处理压力,需要由多台服务器共同来完成索引和搜索任务。实现的思路是将索引数据进行Shard(分片)拆分,每个分片由多台的服务器共同完成,当一个索引或搜索请求过来时会分别从不同的Shard的服务器中操作索引。

SolrCloud需要Solr基于Zookeeper部署,Zookeeper是一个集群管理软件,由于SolrCloud需要由多台服务器组成,由zookeeper来进行协调管理。

下图是一个SolrCloud应用的例子:

对上图进行图解,如下:

1.4.1.物理结构

三台Solr物理机服务器( 每台服务器包括两个solr core(solr应用服务器 包括完整的索引和搜索)),组成一个SolrCloud。

1.4.2.逻辑结构

索引集合包括两个Shard(shard1和shard2),shard1和shard2分别由三个Core(solr应用服务器(tomcat))组成,其中一个Leader两个Replication,Leader是由zookeeper选举产生,zookeeper控制每个shard上三个Core的索引数据一致,解决高可用问题。用户发起索引请求分别从shard1和shard2上获取,解决高并发问题。

1、Collection

Collection在SolrCloud集群中是一个逻辑意义上的完整的索引结构。它常常被划分为一个或多个Shard(分片),它们使用相同的配置信息。

比如:针对商品信息搜索可以创建一个collection。

collection=shard1+shard2+....+shardX

2、Core

每个Core是Solr中一个独立运行单位,提供 索引和搜索服务。一个shard需要由一个Core或多个Core组成。由于collection可由多个shard组成,所以collection一般由多个core组成。

3、Master/Slave

Master是master-slave结构中的主结点(通常说主服务器),Slave是master-slave结构中的从结点(通常说从服务器或备服务器)。同一个Shard下master和slave存储的数据是一致的,这是为了达到高可用目的。

4、Shard

Collection的逻辑分片。每个Shard被化成一个或者多个replication,通过选举确定哪个是Leader。

2.SolrCloud搭建

2.1.搭建架构分析

2.1.1.两大组成部分

1、zookeeper集群

a)zookeeper需要保证高可用,需要搭建集群

b)zookeeper需要进行投票和选举机制,最少需要三个节点

c)zookeeper的三个节点,注意修改端口号不一样

2、Solr集群

a)需要四个节点(solr应用服务器);

b)四台tomcat部署4个 solr应用服务器

c)整个collection分成两个分片,每个分片都由两个服务器组成,master和slave

2.1.2.环境

Linux:CentOS6.5 32位

Jdk:1.7以上版本

2.2.zookeeper集群搭建

2.2.1.复制

复制三份zookeeper

cd /root/software

解压

tar -zvxf zookeeper-3.4.6.tar.gz

mkdir /usr/local/solr/solr-cloud/

cp -r zookeeper-3.4.6 /usr/local/solr/solr-cloud/zookeeper01 && cp -r zookeeper-3.4.6 /usr/local/solr/solr-cloud/zookeeper02 && cp -r zookeeper-3.4.6 /usr/local/solr/solr-cloud/zookeeper03

cd /usr/local/solr/solr-cloud/

2.2.2.配置

2.2.2.1.给每个zookeeper创建data文件夹

对/usr/local/solr/solr-cloud目录下的3个zookeeper创建data文件夹

mkdir zookeeper01/data && mkdir zookeeper02/data && mkdir zookeeper03/data

2.2.2.2.给每个zookeeper创建myid文件

对/usr/local/solr/solr-cloud目录下的3个zookeeper创建 myid 文件,并分别写入1,2,3

vi zookeeper01/data/myid

对上述文件写入数字 1

vim zookeeper02/data/myid

对上述文件写入数字 2

vim zookeeper03/data/myid

对上述文件写入数字 3

2.2.2.3.重命名每个zookeeper配置文件

mv zookeeper01/conf/zoo_sample.cfg zookeeper01/conf/zoo.cfg

mv zookeeper02/conf/zoo_sample.cfg zookeeper02/conf/zoo.cfg

mv zookeeper03/conf/zoo_sample.cfg zookeeper03/conf/zoo.cfg

2.2.2.4.修改每个zookeeper配置文件

修改dataDir(每个zookeeper对应路径;

如/usr/local/solr/solr-cloud/zookeeper01/data)

修改clientPort端口号(每个不同三台对应3181,3182,3183)

在三个配置文件底部都加上:

server.1=192.168.12.168:2881:3881

server.2=192.168.12.168:2882:3882

server.3=192.168.12.168:2883:3883

vim zookeeper01/conf/zoo.cfg

修改后效果如下:

vim zookeeper02/conf/zoo.cfg

修改后效果如下:

vim zookeeper03/conf/zoo.cfg

修改后效果如下:

2.2.3.启动

zookeeper01/bin/zkServer.sh start

zookeeper02/bin/zkServer.sh start

zookeeper03/bin/zkServer.sh start

zookeeper01/bin/zkServer.sh start

zookeeper02/bin/zkServer.sh start

zookeeper03/bin/zkServer.sh start

如果启动失败,可以在启动命令之后添加start-foreground;查看启动失败日志。

2.2.4.查看状态

./zookeeper01/bin/zkServer.sh status

./zookeeper02/bin/zkServer.sh status

./zookeeper03/bin/zkServer.sh status

./zookeeper01/bin/zkServer.sh status

./zookeeper02/bin/zkServer.sh status

./zookeeper03/bin/zkServer.sh status

2.4.搭建solr集群

按照上述搭建架构;需要4个solr应用服务器。

2.4.1.把solrhome复制到solr-cloud目录下,复制4份

cd /usr/local/solr/

cp -r solrhome/ solr-cloud/solrhome01

cp -r solrhome/ solr-cloud/solrhome02

cp -r solrhome/ solr-cloud/solrhome03

cp -r solrhome/ solr-cloud/solrhome04

2.4.2.安装(复制)4个tomcat

复制4个之前安装的单机版的solr

cp -r tomcat/ solr-cloud/tomcat-solr01

cp -r tomcat/ solr-cloud/tomcat-solr02

cp -r tomcat/ solr-cloud/tomcat-solr03

cp -r tomcat/ solr-cloud/tomcat-solr04

2.4.3.修改tomcat端口号8081~8084

cd solr-cloud

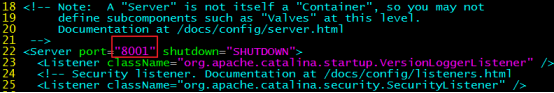

server.xml需要修改3个地方的端口号(server port(第22行)、http port(第71行)、connector port(第93行));与其它tomcat的不冲突就好,端口依次可以为(8001,8081,8011;8002,8082,8012;8003,8083,8013;8004,8084,8014)

vi tomcat-solr01/conf/server.xml

如下图第一个Tomcat为例,修改三个端口号8001,8081,8011,其他Tomcat类似(8002,8082,8012;8003,8083,8013;8004,8084,8014)

vi tomcat-solr02/conf/server.xml

vi tomcat-solr03/conf/server.xml

vi tomcat-solr04/conf/server.xml

2.4.4.修改每个solr的web.xml

4个tomcat都要修改为对应的solrhome

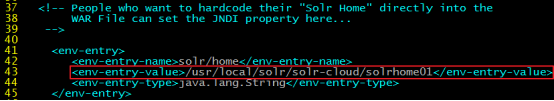

vi tomcat-solr01/webapps/solr/WEB-INF/web.xml

vi tomcat-solr02/webapps/solr/WEB-INF/web.xml

vi tomcat-solr03/webapps/solr/WEB-INF/web.xml

vi tomcat-solr04/webapps/solr/WEB-INF/web.xml

修改第43行的solrhome路径

例如 /usr/local/solr/solr-cloud/solrhome01

效果:

其它3个也类似修改。

2.4.5.修改每个solrhome里面的solr.xml

vi solrhome01/solr.xml

vi solrhome02/solr.xml

vi solrhome03/solr.xml

vi solrhome04/solr.xml

第32的host的内容修改为192.168.12.168【注意】原来的为${host:}

第33行hostPort的内容修改为8081【注意】原来的为${jetty.port:8983};另外修改的端口号应该对应每台tomcat的端口号。

如solrhome01需要修改为8081,其他的依次为8082、8083、8084

修改前:

修改后:

其它3个solr.xml类似的修改。

2.4.6.上传配置文件到zookeeper集群

进入/usr/local/solr/solr-4.10.3/example/scripts/cloud-scripts,执行命令

cd /usr/local/solr/solr-4.10.3/example/scripts/cloud-scripts

下载安装zip、unzip命令

yum install -y unzip zip

需要运行的以下命令,需要修改IP地址和修改solrcore的路径地址

./zkcli.sh -zkhost 192.168.12.168:3181,192.168.12.168:3182,192.168.12.168:3183 -cmd upconfig -confdir /usr/local/solr/solr-cloud/solrhome01/collection1/conf -confname myconf

zookeeper是做配置文件的集中管理,

以上命令的作用是把配置文件上传给zookeeper,由zookeeper管理配置文件

zookeeper把所有的solr集群的配置文件进行统一管理

2.4.7.查看zookeeper配置文件

进入任意zookeeper,使用客户端进行查看

cd /usr/local/solr/solr-cloud/zookeeper01/bin

./zkCli.sh -server 192.168.12.168:3181

执行上面命令后,使用ls命令查看zookeeper配置信息,再出来的界面分别输入。。按ctrl+c退出

ls /

ls /configs

ls /configs/myconf

2.4.8.设置zookeeper的地址给tomcat

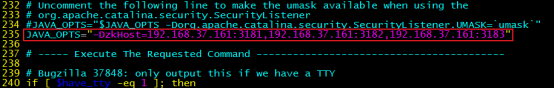

需要修改每个Tomcat的bin/catalina.sh文件

cd /usr/local/solr/solr-cloud/

vi tomcat-solr01/bin/catalina.sh

vi tomcat-solr02/bin/catalina.sh

vi tomcat-solr03/bin/catalina.sh

vi tomcat-solr04/bin/catalina.sh

如tomcat01,其他Tomcat都一样设置,第235行添加JAVA_OPTS,即如下内容:

JAVA_OPTS="-DzkHost=192.168.12.168:3181,192.168.12.168:3182,192.168.12.168:3183"

2.4.9.启动所有tomcat

cd /usr/local/solr/solr-cloud/

./tomcat-solr01/bin/startup.sh

./tomcat-solr02/bin/startup.sh

./tomcat-solr03/bin/startup.sh

./tomcat-solr04/bin/startup.sh

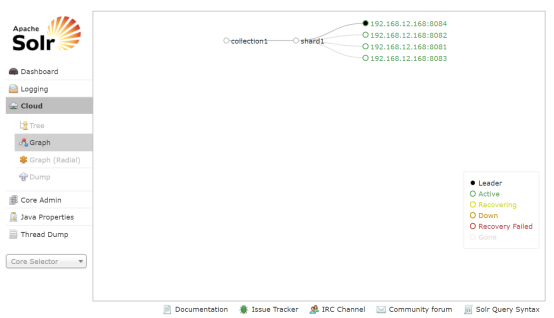

2.4.10.访问solr集群

访问任意一个solr集群的节点都可以

如http://192.168.12.168:8081/solr

2.4.11.集群分片

集群中有四个solr节点创建新集群testSolrCloud(名字可以自行取,不要原有的重复即可),将集群分为两片,每片一个副本。

http://192.168.12.168:8081/solr/admin/collections?action=CREATE&name=pinyougou&numShards=2&replicationFactor=2

2.4.12.删除原来的solrcore

http://192.168.12.168:8081/solr/admin/collections?action=DELETE&name=collection1

2.4.13.查看分片信息

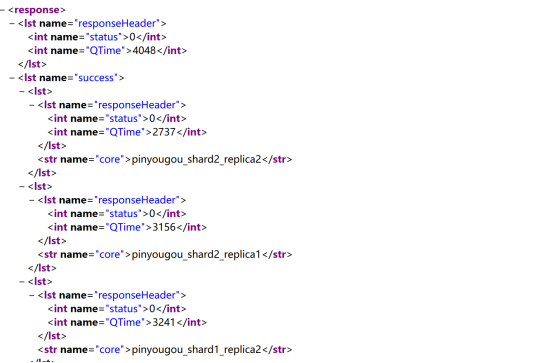

索引分片后:同一个分片的solr的索引数目是相同的;在不同的分片的数据总数一般不相同,整个索引库的数目是所有分片的数据总和。

8081/8084是一个分片的,它们的数据与8082/8083的分片数据不一样