数据变换操作

导入文件

import numpy as np

import pandas as pd

odata = pd.read_csv('example.csv')这三行代码就可以实现csv文件的导入,注意文件的路径

删除行

Data1 = data.drop([16,17])drop()方法

如果不设置参数inplace=True,则只能在生成的新数据块中实现删除效果,而不能删除原有数据块的相应行。也就是inplace属性可以对原来的数据进行删除操作Inplace = True用法:

odata.drop(odata.index[[16,17]],inplace=True)我们要注意到用与不用inplace的区别,不用inplace的时候,我们使用另外一个变量Data1来暂时保存处理后的数据,而使用inplace的时候,我们直接调用一个函数对原来的数据进行操作。值得注意的是,inplace属性并不会修改原来的文件,所以是安全的。也就是虽然直接对原来数据删除,但并不会删除到文件,只会在内存里操作原来变量。

删除列del data[‘date’]

代码如上所示,直接删除,注意这个del的方括号里只能够有一个参数。一次只能删除一列。

pop()方法

pop方法可以将所选列从原数据块中弹出,原数据块不再保留该列,

Data1=data.pop(‘latitude’)pop方法将单独的数据取出来,在我们想要对某一块数据很感兴趣的时候非常实用。

split()的使用

简单的Python的字符串分割我们在数据预处理的时候很多时候要对一串带有各种符号的数据进行处理。但是实际运行时我们要将它们分开处理,所以需要用到python带的split函数来处理

str = ('www.google.com')

print (str)

str_split = str.split('.')

print (str_split)

# 这样运行出来的结果是

# www.google.com

# [‘www’,‘google’,‘com’]如果我们想要设置分割的个数,就在split里面添加参数:

str_split = str.split(‘.’,1)

# 这样得出的结果是:

# www.google.com

# [‘www’,’google.com’]也就是只分割了第一个字符,第二个就没有分割了。

数据框合并concat()操作

concat函数是在pandas底下的方法,可以将数据根据不同的轴作简单的融合

pd.concat(objs, axis=0, join='outer', join_axes=None, ignore_index=False,

keys=None, levels=None, names=None, verify_integrity=False)参数说明

objs: series,dataframe或者是panel构成的序列lsit

axis: 需要合并链接的轴,0是行,1是列

join:连接的方式 inner,或者outer

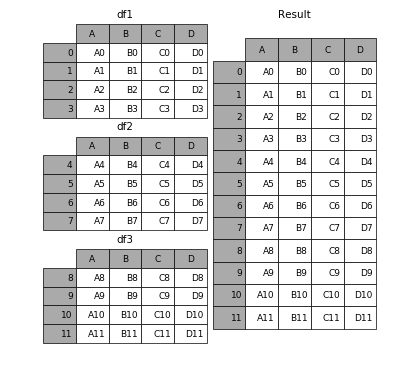

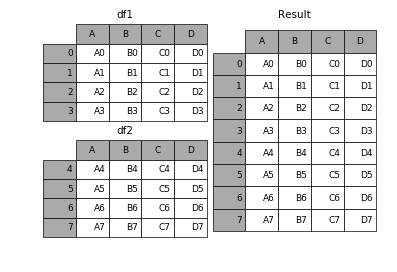

相同字段的表首尾相接

# 现将表构成list,然后在作为concat的输入

In [4]: frames = [df1, df2, df3]

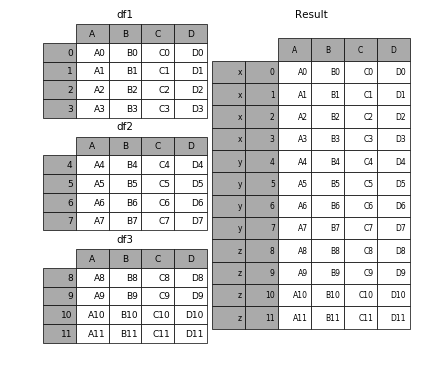

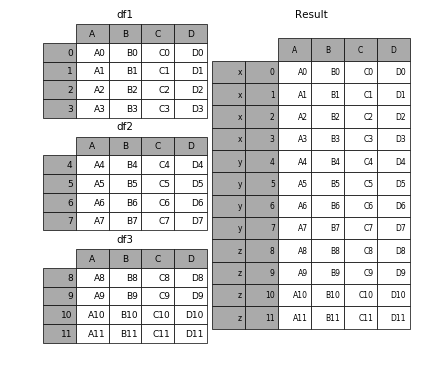

In [5]: result = pd.concat(frames)要在相接的时候在加上一个层次的key来识别数据源自于哪张表,可以增加key参数

result = pd.concat(frames, keys=['x', 'y', 'z'])效果如下

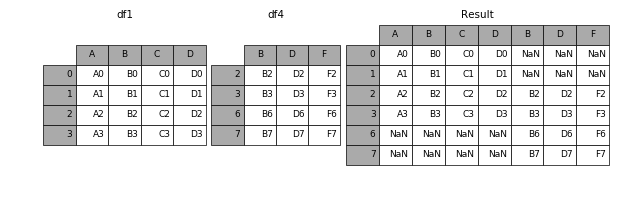

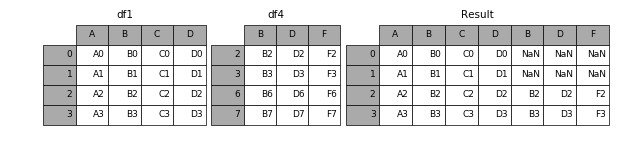

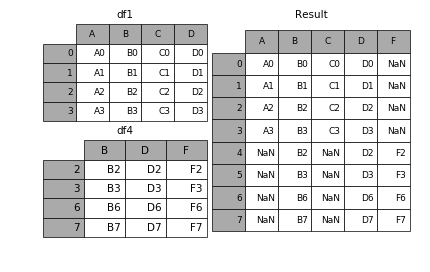

横向表拼接(行对齐)

当axis = 1的时候,concat就是行对齐,然后将不同列名称的两张表合并

result = pd.concat([df1, df4], axis=1)join

加上join参数的属性,如果为’inner’得到的是两表的交集,如果是outer,得到的是两表的并集。

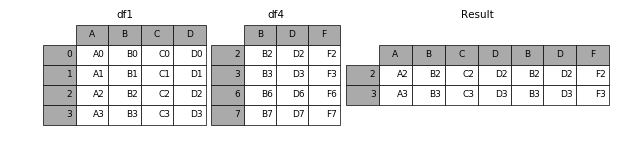

result = pd.concat([df1, df4], axis=1, join='inner')join_axes

如果有join_axes的参数传入,可以指定根据那个轴来对齐数据

例如根据df1表对齐数据,就会保留指定的df1表的轴,然后将df4的表与之拼接

result = pd.concat([df1, df4], axis=1, join_axes=[df1.index])append

append是series和dataframe的方法,使用它就是默认沿着列进行凭借(axis = 0,列对齐)

result = df1.append(df2)无视index的concat

如果两个表的index都没有实际含义,使用ignore_index参数,置true,合并的两个表就睡根据列字段对齐,然后合并。最后再重新整理一个新的index。

合并的同时增加区分数据组的键

前面提到的keys参数可以用来给合并后的表增加key来区分不同的表数据来源

- 直接用key参数实现

result = pd.concat(frames, keys=['x', 'y', 'z'])- 传入字典来增加分组键

pieces = {'x': df1, 'y': df2, 'z': df3}

result = pd.concat(pieces)在dataframe中加入新的行

append方法可以将 series 和 字典就够的数据作为dataframe的新一行插入。

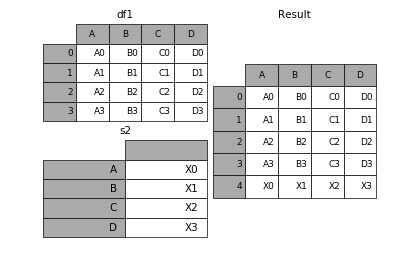

s2 = pd.Series(['X0', 'X1', 'X2', 'X3'], index=['A', 'B', 'C', 'D'])

result = df1.append(s2, ignore_index=True)表格列字段不同的表合并

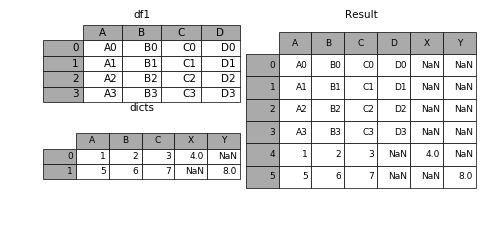

如果遇到两张表的列字段本来就不一样,但又想将两个表合并,其中无效的值用nan来表示。那么可以使用ignore_index来实现。

dicts = [{'A': 1, 'B': 2, 'C': 3, 'X': 4},{'A': 5, 'B': 6, 'C': 7, 'Y': 8}]

result = df1.append(dicts, ignore_index=True)