Ceph部署——ubuntu部署Luminous版Ceph

1、环境说明:

- ubuntu14.04

- 3台虚机(主机名分别为osd1、2、3)

- 挂载9块硬盘部署9个OSD节点

- 一台虚机中部署MON节点

- 为方便起见,所有主机以’root’权限登录

- 以一台主机为admin节点(这里以osd1充当)

2、环境准备(所有节点)

- 安装ssh admin节点登录其他节点

apt-get install openssh-server

- 安装ntp 时间同步

apt-get install ntp

- 修改

/etc/hostname文件 为各个节点名 eg:osd1、2、3 修改

/etc/hosts文件添加各个节点名

192.168.*.* osd1 192.168.*.* osd2 192.168.*.* osd3

3、修改源(所有节点)

- 修改

/etc/apt/sources.list文件

这里采用网易源,trusty对应ubuntu的版本号

deb http://mirrors.163.com/ubuntu/ trusty main restricted universe multiverse

deb http://mirrors.163.com/ubuntu/ trusty-security main restricted universe multiverse

deb http://mirrors.163.com/ubuntu/ trusty-updates main restricted universe multiverse

deb http://mirrors.163.com/ubuntu/ trusty-proposed main restricted universe multiverse

deb http://mirrors.163.com/ubuntu/ trusty-backports main restricted universe multiverse

deb-src http://mirrors.163.com/ubuntu/ trusty main restricted universe multiverse

deb-src http://mirrors.163.com/ubuntu/ trusty-security main restricted universe multiverse

deb-src http://mirrors.163.com/ubuntu/ trusty-updates main restricted universe multiverse

deb-src http://mirrors.163.com/ubuntu/ trusty-proposed main restricted universe multiverse

deb-src http://mirrors.163.com/ubuntu/ trusty-backports main restricted universe multiverse

- 更新源

apt-get update

4、安装ceph-deploy(admin节点)

配置key

wget -q -O- 'http://mirrors.163.com/ceph/keys/release.asc' | sudo apt-key add -

echo deb http://mirrors.163.com/ceph/debian-luminous/ $(lsb_release -sc) main | sudo tee /etc/apt/sources.list.d/ceph.list安装ceph-deploy

apt-get install -y ceph-deploy

5、创建连接(admin节点)

- 生成共钥

ssh-keygen+ 一路回车

- 添加信任节点

ssh-copy-id root@osd1(节点名)ssh-copy-id root@osd2ssh-copy-id root@osd3

6、部署集群(admin节点)

- 创建文件夹,以后生成的配置文件默认保存在此

mkdir ~/my-clustercd ~/my-cluster

- 创建一个新集群,默认生成三个文件

ceph-deploy new osd1

- 虚拟机单网卡不用修改网络配置

- 所有节点安装ceph

ceph-deploy install osd1 osd2 osd3

- 安装mon节点,默认生成五个文件

ceph-deploy mon create-initial

- 此时集群和mon节点已经创建好,下一步添加OSD节点

7、添加OSD节点(admin节点)

集群默认可以添加无数个OSD节点(10000个),OSD可以是磁盘也可以是分区,因为是虚拟机,所以直接添加裸盘

- 如果不是裸盘需要先格式化

ceph-deploy disk zap osd1:/dev/sdb

- 创建OSD节点

ceph-deploy osd create osd1:/dev/sdb- 依次添加三个虚机,9块磁盘

- 配置admin节点

- 可以不需要指定mon地址以及用户信息就可以直接管理ceph集群

ceph-deploy admin osd1 osd2 osd3chmod +r /etc/ceph/ceph.client.admin.keyring# 修改文件权限

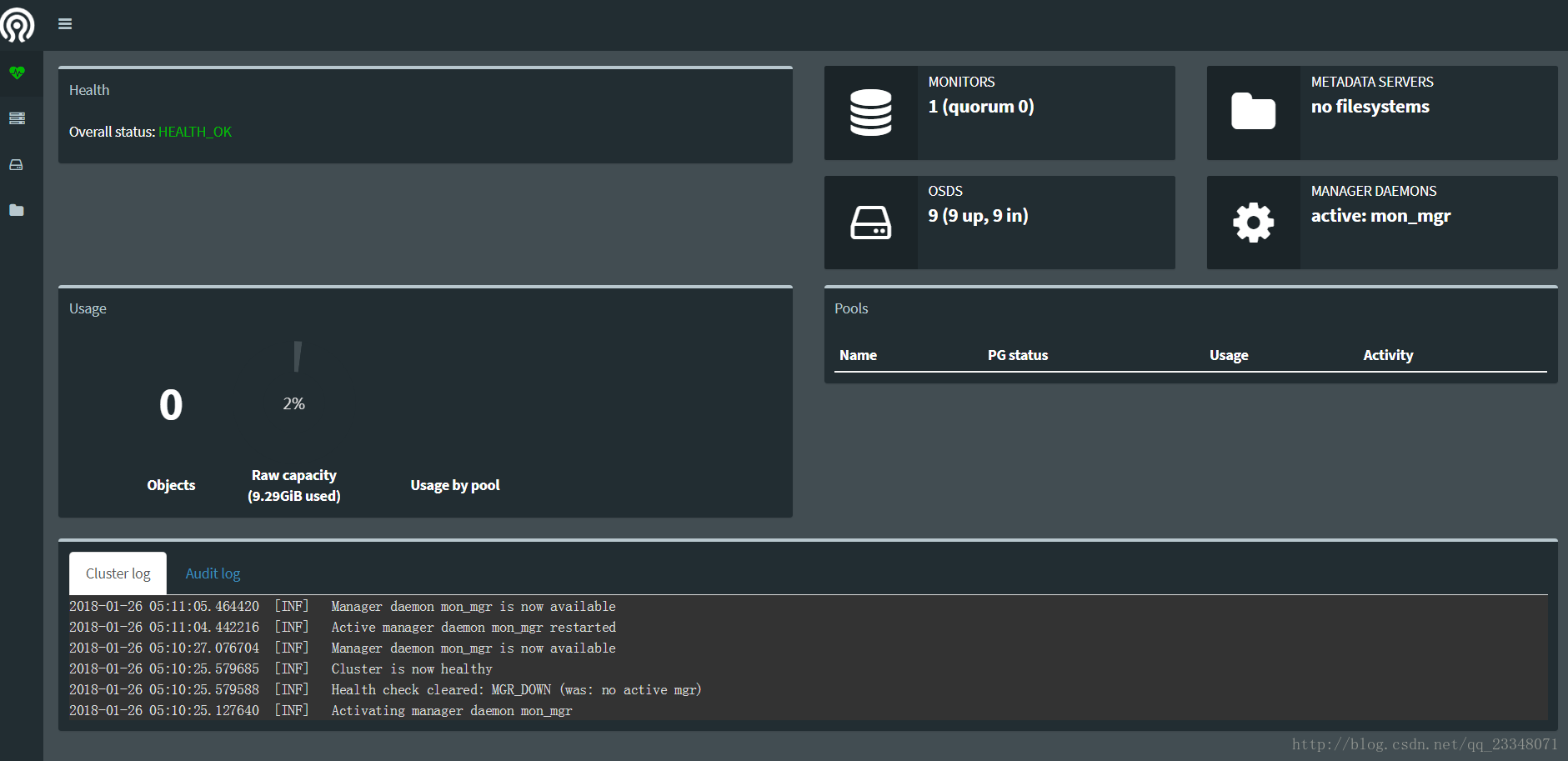

8、配置mgr(监控)服务

L版中ceph默认需要安装mgr服务

- 配置mgr服务

ceph-deploy mgr create osd1:mon_mgr

- 启动dashboard

ceph mgr module enable dashboard

- 通过

192.168.*.*:7000就可以访问原生监控页面了

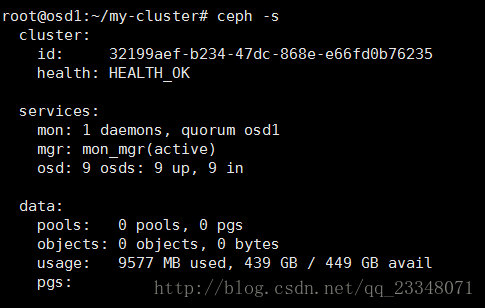

9、搭建完成

ceph -s检查集群健康状况