图像标准分割Berkeley图像库:http://www.eecs.berkeley.edu/Research/Projects/CS/vision/bsds/

此次研究两种图像分割法,分别是基于形态学的分水岭算法和基于图割理论的GrabCut算法。OpenCV均提供了两张算法或其变种。鉴于研究所需,记录一些知识点,开发平台为OpenCV2.4.9+Qt5.3.2。

一、使用分水岭算法进行图像分割

分水岭变换是一种常用的图像处理算法,在网上很容易搜到详细的原理分析。简单来说,这是一种基于拓扑理论的数学形态学的图像分割方法,其基本思想是把图像看作是测地学上的拓扑地貌,图像中每一点像素的灰度值表示该点的海拔高度,每一个局部极小值及其影响区域称为集水盆,而集水盆的边界则形成分水岭。分水岭的概念和形成可以通过模拟浸入过程来说明。在每一个局部极小值表面,刺穿一个小孔,然后把整个模型慢慢浸入水中,随着浸入的加深,每一个局部极小值的影响域慢慢向外扩展,在两个集水盆汇合处构筑大坝,即形成分水岭。

分水岭算法简单,因此存在一些缺陷,如容易导致图像的过度分割。分水岭算法对微弱边缘具有良好的响应,图像中的噪声、物体表面细微的灰度变化,都会产生过度分割的现象。

为消除分水岭算法产生的过度分割,有两种常规的处理方法,一是利用先验知识去除无关边缘信息。二是修改梯度函数使得集水盆只响应想要探测的目标。

OpenCV提供了该算法的改进版本,使用预定义的一组标记来引导对图像的分割,该算法是通过cv::watershed函数来实现的。

要实现分水岭算法,首先新建一个类WaterShedSegmentation,在watershedsegmentation.h中添加:

#ifndef WATERSHEDSEGMENTATION_H

#define WATERSHEDSEGMENTATION_H

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/imgproc/imgproc.hpp>

class WaterShedSegmentation

{

public:

void setMarkers(const cv::Mat &markerImage); // 将原图像转换为整数图像

cv::Mat process(const cv::Mat &image); // // 分水岭算法实现

// 以下是两种简化结果的特殊方法

cv::Mat getSegmentation();

cv::Mat getWatersheds();

private:

cv::Mat markers; // 用于非零像素点的标记

};

#endif // WATERSHEDSEGMENTATION_H

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

接着,在watershedsegmentation.cpp中添加:

#include "watershedsegmentation.h"

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/imgproc/imgproc.hpp>

void WaterShedSegmentation::setMarkers(const cv::Mat &markerImage) // 该函数将原图像转换为整数图像

{

markerImage.convertTo(markers,CV_32S);

}

cv::Mat WaterShedSegmentation::process(const cv::Mat &image)

{

// 使用分水岭算法

cv::watershed(image,markers);

return markers;

}

// 以下是两种简化结果的特殊方法

// 以图像的形式返回分水岭结果

cv::Mat WaterShedSegmentation::getSegmentation()

{

cv::Mat tmp;

// 所有像素值高于255的标签分割均赋值为255

markers.convertTo(tmp,CV_8U);

return tmp;

}

cv::Mat WaterShedSegmentation::getWatersheds()

{

cv::Mat tmp;

markers.convertTo(tmp,CV_8U,255,255);

return tmp;

}- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

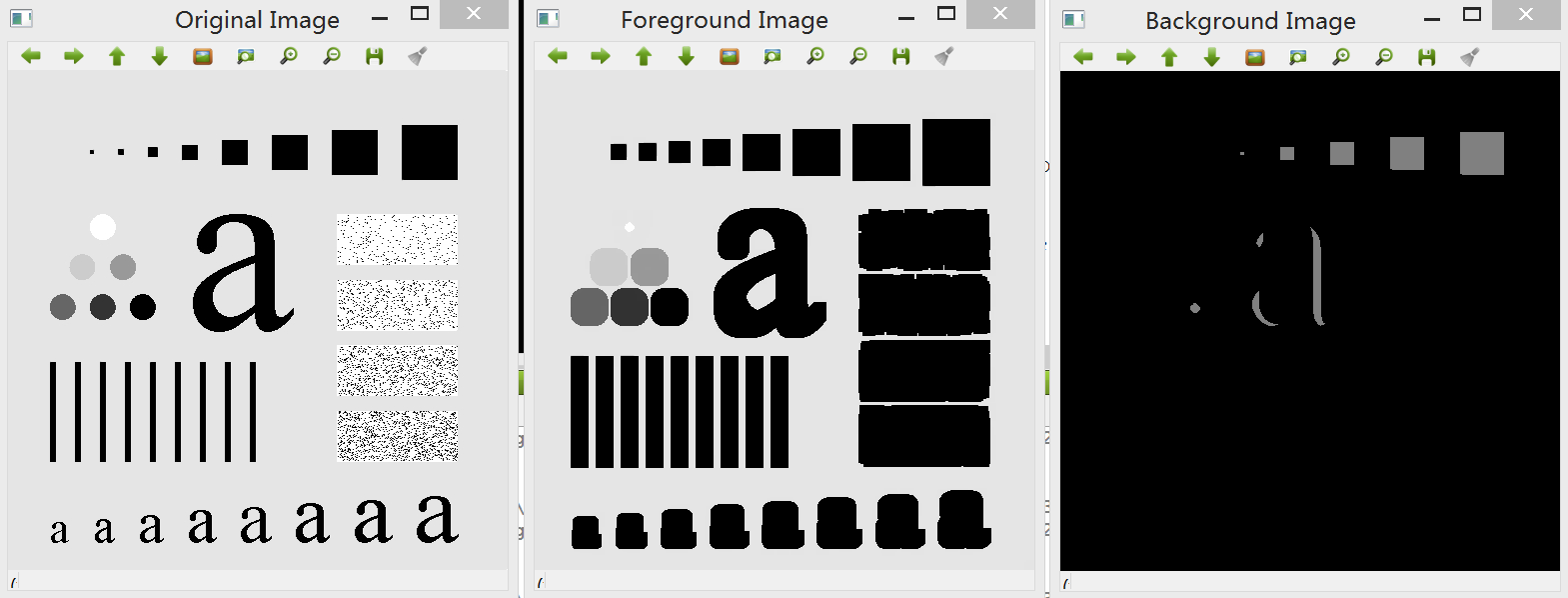

main函数修改如下:

#include <QCoreApplication>

#include "watershedsegmentation.h"

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/imgproc/imgproc.hpp>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 输入待处理的图像

cv::Mat image= cv::imread("c:/Fig4.41(a).jpg");

if (!image.data)

return 0;

cv::namedWindow("Original Image");

cv::imshow("Original Image",image);

// 输入图像,将其转化为二值图像

cv::Mat binary;

binary= cv::imread("c:/Fig4.41(a).jpg",0);

// 显示二值图像

cv::namedWindow("Binary Image");

cv::imshow("Binary Image",binary);

// 移除噪点

cv::Mat fg;

cv::erode(binary,fg,cv::Mat(),cv::Point(-1,-1),6);

// 显示前景图像

cv::namedWindow("Foreground Image");

cv::imshow("Foreground Image", fg);

// 识别背景图像,生成的黑色像素对应背景像素

cv::Mat bg;

cv::dilate(binary,bg,cv::Mat(),cv::Point(-1,-1),6);

cv::threshold(bg, bg, 1, 128, cv::THRESH_BINARY_INV);

// 显示背景图像

cv::namedWindow("Background Image");

cv::imshow("Background Image", bg);

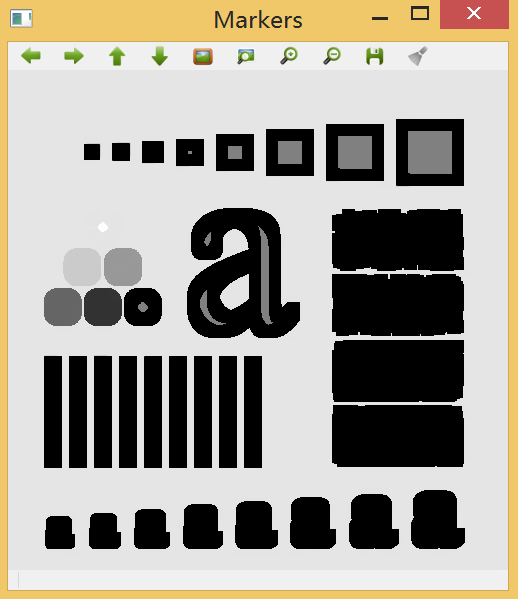

// 显示标记图像

cv::Mat markers(binary.size(), CV_8U,cv::Scalar(0));

markers= fg + bg;

cv::namedWindow("Markers");

cv::imshow("Markers", markers);

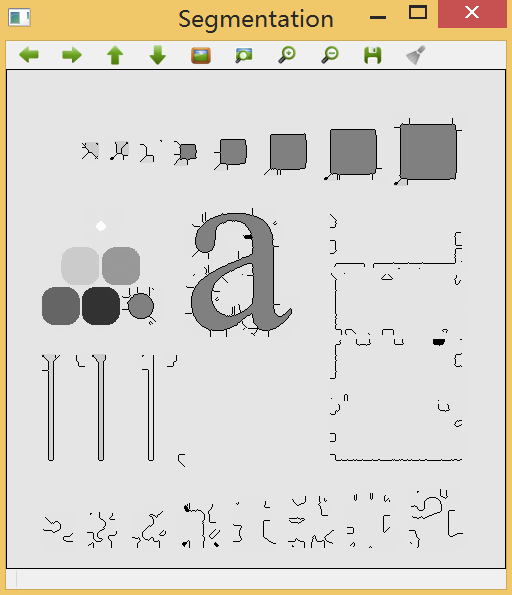

// 以下进行分水岭算法

WaterShedSegmentation segmenter;

segmenter.setMarkers(markers);

segmenter.process(image);

// 以下是两种处理结果,显示分割结果

cv::namedWindow("Segmentation");

cv::imshow("Segmentation", segmenter.getSegmentation());

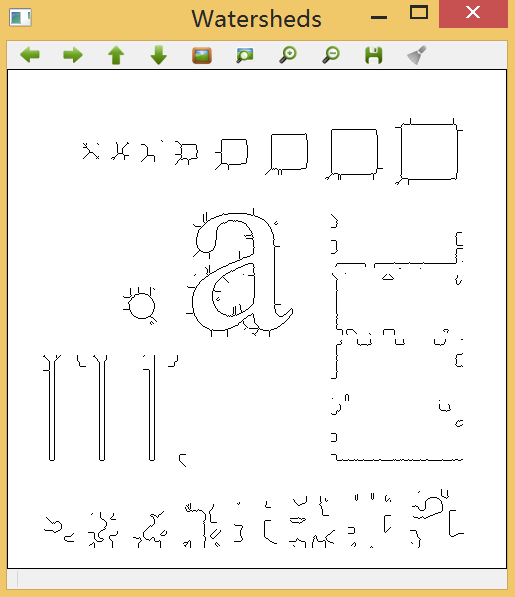

cv::namedWindow("Watersheds");

cv::imshow("Watersheds",segmenter.getWatersheds());

return a.exec();

}- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

效果1:算法识别出属于前景和背景的像素(有误差)。

效果2:组合前景和背景图,形成标记图形,这是分水岭的输入参数。

效果3:分割结果中,标记图像得到更新。

效果4:显示边界图像。

可以看出,分水岭算法对微弱边缘具有良好的响应,是得到封闭连续边缘的保证的。但对于不同质量的图像其分割效果不尽相同,但总的来说效果仍需要改进。

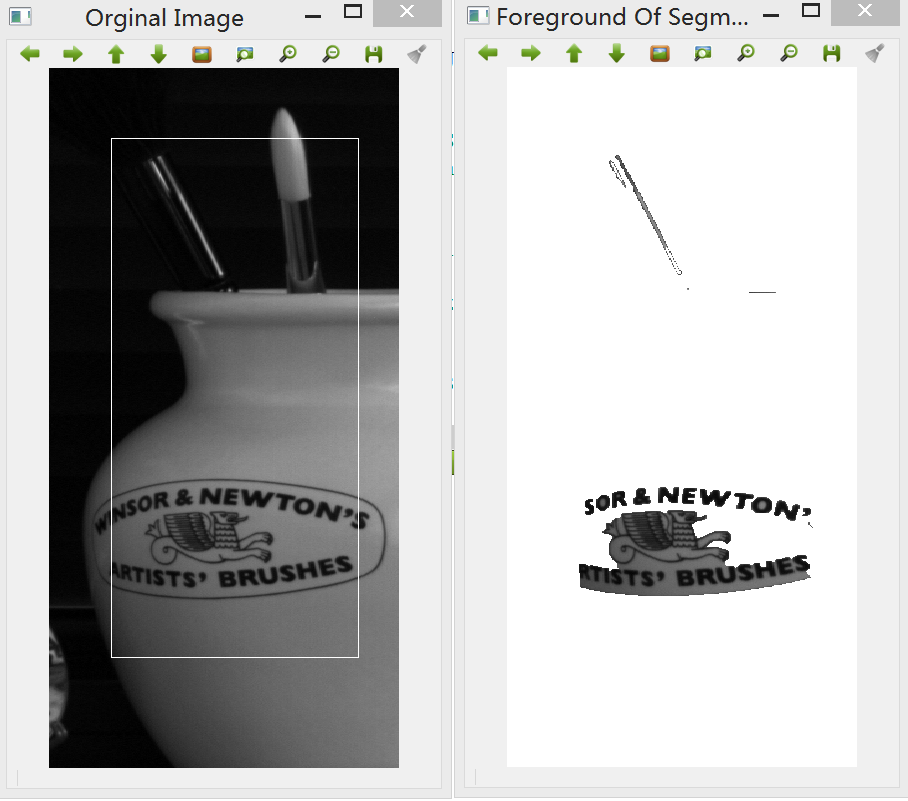

二、使用GrabCut算法分割图像

GrabCut是另一种同样较为流行的图像分割算法。GrabCut是在GraphCut基础上改进的一种图像分割算法,它并非基于图像形态学,而是基于图割理论(参考:http://www.cnblogs.com/tornadomeet/archive/2012/11/06/2757585.html)。在使用GrabCut时,需要人工给定一定区域的目标或者背景,然后算法根据设定的参数来进行分割。GrabCut在计算时比分水岭算法更加复杂,尤其适合从静态图像中提取前景照片的应用。

OpenCV中提供了cv::grabcut函数,因此只需提供图像并标记背景像素和前景像素,基于局部的标记,算法即可将图像中的像素进行分割。在这里使用的局部标记方法是定义一个矩形。cv::grabcut的函数定义如下:

cv::grabCut(image, // 输入图像

result, // 分割输出结果

rectangle,// 包含前景物体的矩形

bgModel,fgModel, // 模型

1, // 迭代次数

cv::GC_INIT_WITH_RECT); // 使用矩形进行初始化- 1

- 2

- 3

- 4

- 5

- 6

- 1

- 2

- 3

- 4

- 5

- 6

在main函数添加:

// GrabCut算法

cv::Mat image= cv::imread("c:/Fig8.04(a).jpg");

// 设定矩形

cv::Rect rectangle(50,70,image.cols-150,image.rows-180);

cv::Mat result; // 分割结果 (4种可能取值)

cv::Mat bgModel,fgModel; // 模型(内部使用)

// 进行GrabCut分割

cv::grabCut(image, result, rectangle, bgModel, fgModel, 1, cv::GC_INIT_WITH_RECT);

// 得到可能为前景的像素

cv::compare(result, cv::GC_PR_FGD, result,cv::CMP_EQ);

// 生成输出图像

cv::Mat foreground(image.size(), CV_8UC3, cv::Scalar(255,255,255));

image.copyTo(foreground, result); // 不复制背景数据

// 包含矩形的原始图像

cv::rectangle(image, rectangle, cv::Scalar(255,255,255),1);

cv::namedWindow("Orginal Image");

cv::imshow("Orginal Image", image);

// 输出前景图像结果

cv::namedWindow("Foreground Of Segmented Image");

cv::imshow("Foreground Of Segmented Image", foreground);- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

效果:

在函数cv::grabCut中,最后一个参数表示我们使用的是包围盒模式,而该算法支持的输入/输出分割图像可以有四种数值,如函数cv::compare函数中的参数:

cv::GC_BGD:确定属于背景的像素;

cv::GC_FGD:确定属于前景的元素;

cv::GC_PR_BGD:可能属于背景的元素;

cv::GC_PR_FGD:可能属于前景的元素。

在上图中,GrabCut算法通过指定方框区域来提取前景物体。同时,也可将数值cv::GC_BGD和cv::GC_FGD赋予分割图像的某些特定像素,并且把这类分割图像作为cv::grabcut函数的第二个参数(此时需要指定GC_INIT_WITH_MASK作为输入模式)。

基于这些信息,GrabCut通过以下主要步骤创建分割:

- 前景标签(cv::GC_PR_FGD)被临时赋予所有为标记的像素。基于当前的分类,算法将像素归类为颜色或灰度值相似的聚类。

- 通过引入背景与前景像素的边界进行分割。这个优化的过程尝试将标签相似的像素相连接,这里利用了在强度相对已知的区域之间对边界像素的(惩罚?)。这个最优化问题通过GraphCut算法得到高效解决。

- 对获取的分割结果产生新的像素标签,重复聚类过程,找到新的最优解。根据场景的复杂度,得到最佳结果,对于简单的场景,有时只需要一次迭代。

关于GrabCut算法,还需要进一步研究GraphCut才能深刻理解。