一、原始检测方法

具体内容如下:

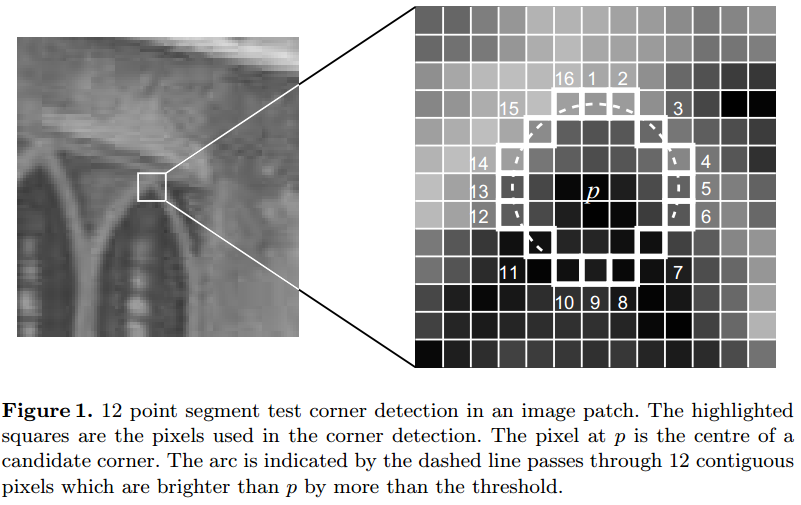

判别特征点pp是否是一个特征点,可以通过判断以该点为中心画圆,该圆过16个像素点。设在圆周上的16个像素点中是否最少有nn个连续的像素点满足都比Ip+tIp+t大,或者都比Ip−tIp−t小。(这里IpIp指的点pp的灰度值,tt是一个阈值)如果满足这样的要求,则判断pp是一个特征点,否则pp不是。在原论文中nn的值一般设为12。

如下图所示:

由于在检测特征点时是需要对图像中所有的像素点进行检测,然而图像中的绝大多数点都不是特征点,如果对每个像素点都进行上述的检测过程,那显然会浪费许多时间,因此论文中采用了一种进行非特征点判别的方法。如上图中,对于每个点都检测第1、5、9、13号像素点,如果这4个点中至少有3个满足都比 Ip+tIp+t 大或者都比 Ip−tIp−t 小,则继续对该点进行16个邻域像素点都检测的方法,否则则判定该点是非特征点,直接剔除即可。

这种做法在大幅减少了判断特征点的运算量,提升了算法的运行速度。但是还是存在一些问题,如下:

(1)当我们使用的 n<12n<12 时就不能通过上面说明的方法对非角点进行快速过滤;

(2)这样检测出来的特征点不是最优的,因为这种检测方法暗含了对特征周围的像素分布的假定;

(3)忽略了上述的前4个检测的结果分析;

(4)检测得到的特征点容易挤在一起。

针对以上问题作者提出了一种基于学习的特征点检测方法,这种检测方法解决了上面的前3个问题。

二、基于学习的特征点检测方法

这种基于学习的特征点检测方法分成两个阶段,如下所示:

阶段1:对你需要检测的场景的多张图像进行角点提取,在提取的过程中,使用你给定的nn和一个合适的阈值进行检测,同时这里不使用上面提出的先检测4个像素点的方法(因为你选择的nn可能小于12啊)。这样我们就提取到了许多的特征点,作为训练数据。

对于圆上的16像素点位置x∈{1,...,16}x∈{1,...,16},若选择一个位置xx对上面得到的特征点集进行划分,划分为3个部分,如下:

Sp→x=⎧⎩⎨⎪⎪d,s,b,Ip→x≤Ip−tIp−t<Ip→x<Ip+tIp+t≤Ip→x(darker)(similar)(brighter)Sp→x={d,Ip→x≤Ip−t(darker)s,Ip−t<Ip→x<Ip+t(similar)b,Ip+t≤Ip→x(brighter)

另外,对每个特征点设一个 boolbool 变量 KpKp ,用来表示是否为角点, Kp=trueKp=true 为角点。

阶段2: 对上面得到的特征点集进行训练,使用 ID3ID3 算法建立一棵决策树,假设通过使用第 xx 个像素点进行决策树的划分,那么对集合 PP 得到的熵 KK 是

H(P)=(c+c¯¯)log2(c+c¯¯)−clog2c−c¯¯log2c¯¯H(P)=(c+c¯)log2(c+c¯)−clog2c−c¯log2c¯

其中

cc

为角点的数目,

c¯¯c¯

为非角点的数目。

由此得到的信息增益为

H(P)−H(Pd)−H(Ps)−H(Pb)H(P)−H(Pd)−H(Ps)−H(Pb)

然后选择使信息增益最大位置进行分割,最终得到这棵决策树。以后再有类似的场景进行特征点检测时,则使用该决策树进行检测。

三、非最大值抑制

最后还有一个问题,如何解决特征点容易挤在一起的问题呢?

作者在这里提出了一种非最大值抑制的方法,给每个已经检测到的角点一个量化的值VV,然后比较相邻的角点的VV值,然后删除VV值较小的角点。

作者在论文中提出了几种不同的VV值的定义,最后主要是使用两种不同的定义:

(1)把角点的灰度与它邻近的16个点的灰度值的差值的绝对值的和作为VV的值;

(2)作者提出,为了计算速度的提升,在(1)的基础上更改为:

V=max⎛⎝∑x∈Sbright|Ip→x−Ip|−t,∑x∈Sdark|Ip−Ip→x|−t⎞⎠V=max(∑x∈Sbright|Ip→x−Ip|−t,∑x∈Sdark|Ip−Ip→x|−t)

在这里

SbrightSbright

是16个邻域像素点中灰度值大于

Ip+tIp+t

的像素点的集合,而

SdarkSdark

表示的是那些灰度值小于

Ip−tIp−t

的像素点。

至此,就是FAST特征点检测方法的算法整体过程,FAST算法在opencv中有实现。值得注意的是,在opencv中并没有对前面提到的基于学习的去检测特征点,原因也很简单,因为基于学习的检测方法学习的是对于某种场景下的特征点检测的学习,而opencv显然不是针对某个场景下的。