1. 前言

今年借着学校的由头继续参加了2023届视觉与学习青年学者研讨会(VALSE)。本次会议在江苏无锡,持续时间是6月10日至6月12日,共三天。由于工作不太好请假,所以我只听了6月10日下午,6月11日全天和6月12日上午的报告,涉及到的Workshop有:目标检测与分割、混合现实中的视觉与学习技术、三维视觉技术前沿以及一些大会特邀报告和年度进展评述。

我参与此次会议的目的就是了解一些大佬的前沿工作,避免自己的知识滞后。因此,趁着还有点印象,赶紧将本次会议的收获快速总结一下。(emmm,懒癌患者拖到了10月,有些都忘记了我直接粘图吧…)

由于该会议涉及的视觉方向很广,很多领域我都是听个概念,所以本篇文章仅是会议内容速记,不涉及知识的介绍,各位读者如果感兴趣可以查看相关大佬的主页或者论文工作。基于此,我将本篇文章分为2个部分,其简介如下:

- 第一部分为热点词:主要记录会议中大佬经常提到的高频词。

- 第二部分为报告记录:主要简介大佬的工作和论文。

可参考的博客:

[1] CV预训练MAE(Masked AutoEncoder)

[2] 自监督学习系列(一):基于 Pretext Task

[3] 【NLP预训练】深入理解“预训练”语言模型

[4] 对比学习(Contrastive Learning),必知必会

[5] 深度对比学习综述

[6] 理解扩散模型Diffusion Models(一)

2. 热点词

热点词是在我听的报告中出现频率很高的词,这应该是最近这段时间大佬们都在做的工作。下面的热点词几乎我都没了解过(捂脸),因此我就不过多介绍了,仅简单说明并引出相关论文。方便读者朋友进一步学习(包括我)。

话说,感觉最近的会议全是关于大模型的。大模型太火了~

2.1 自监督预训练

在本次会议中提到了很多次自监督预训练,即使用没有标签的数据进行预训练。尽管自监督预训练在17年transformer提出后,就成为了NLP领域主流的研究方向。但是,随着大模型的发展,对于数据的需求与之俱增,目前已经标注的数据无法满足大模型的需求,因此需要使用数据自监督预训练。

自监督学习的核心就是来合理构造有利于模型学习的任务。目前来说构造这些任务的方法大致可以划分为三个方面:

- 基于 pretext task ( 代理任务 )

- 基于 contrastive learning ( 对比学习 )

- 基于 mask image modeling ( 掩码图像模型 )

引用自参考博客[2]

2.2 MIM(Masked Image Modeling)

在这次会议中,大部分提及的是掩码图建模(MIM)和对比语言-图像预训练(clip)。

知识点相关论文:On Data Scaling in Masked Image Modeling

2.3 MAE(Masked Autoencoders)

2.4 clip(Contrastive Language-Image Pre-Training)模型

知识点相关论文:Learning Transferable Visual Models From Natural Language Supervision

2.5 对比学习

可以看看这个博客对比学习(Contrastive Learning),必知必会和自动化学报中的论文深度对比学习综述。

简单介绍就是:

对比学习的思想有两个起源, 一个是同类数据对比的思想 另一个是自监督学习中的实例判别任务. 文献[1]最早提出了使用两幅图像进行对比学习的思想, 主要使用孪生神经网络进行训练, 旨在拉近同类图像的特征之间的距离、推远不同类图像之间的距离, 以获得更好的特征提取模型. 而自监督学习中的实例判别任务, 将同一批次中的每个样本视作一个独立的类, 故类别的数量与该批次的样本数量相同. 通过该设计, 将无监督学习任务转化为分类任务 (实例判别任务, 寻找图像集中与输入图像特征相似度最高的图像). SimCLR和MoCo是最早结合上述两个思想的方法, 它们通过同一幅图像分别增广后的图像对之间的特征比对计算, 增强神经网络模型的特征提取能力, 再应用于下游任务中.

文献[1] Hadsell R, Chopra S, LeCun Y. Dimensionality reduction by learning an invariant mapping. In: Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR). New York, USA: IEEE, 2006. 1735−1742

2.6 扩散模型(diffustion model)

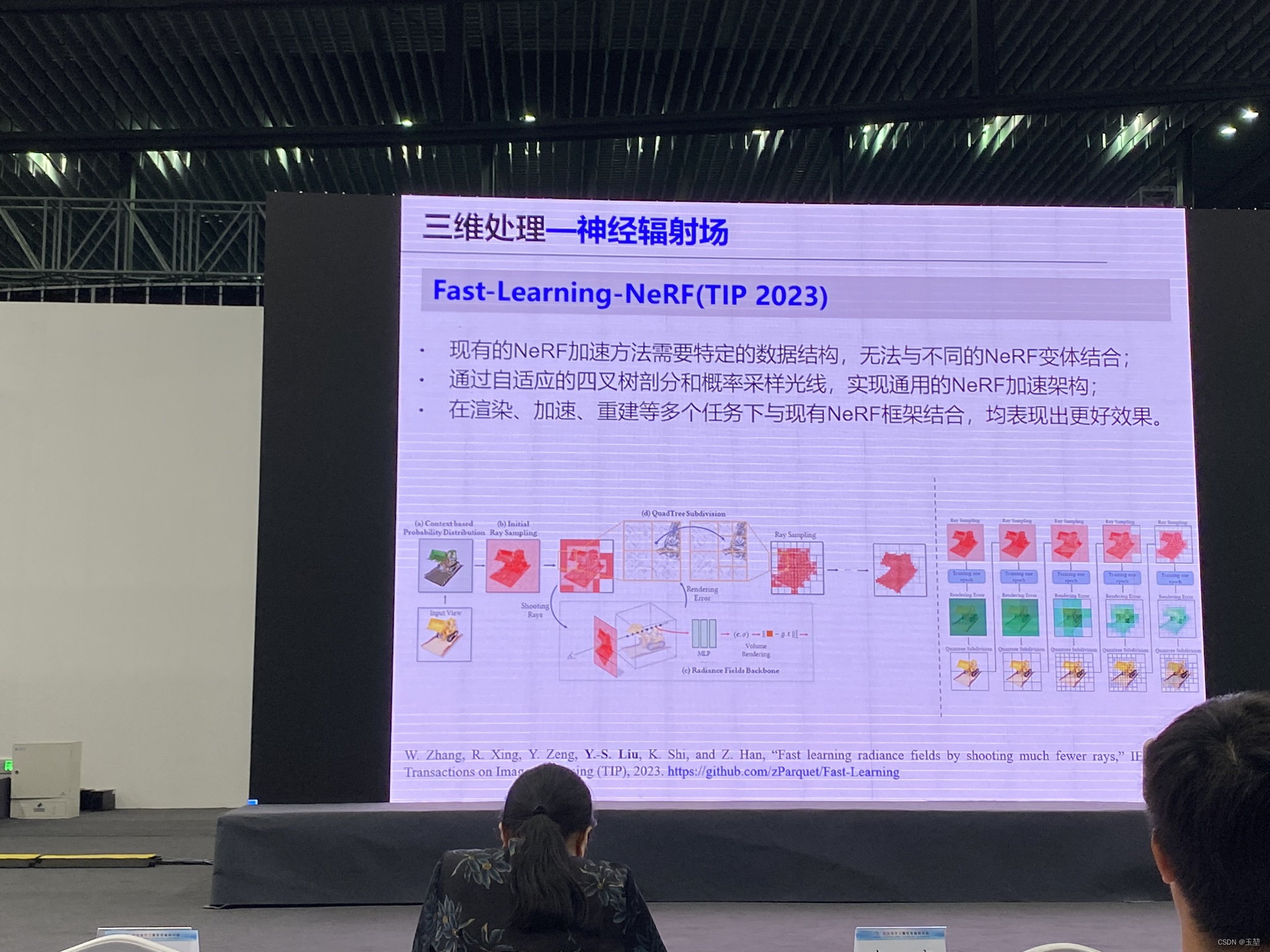

2.7 Nerf(Neural Radiance Fields)的各种变形

相关知识点论文:

[1] NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

[2] NeRF及其发展

[3] “Fast learning radiance fields by shooting much fewer rays,” IEEE Transactions on Image Processing (TIP), 2023. https://github.com/zParquet/Fast-Learning

3. 报告记录

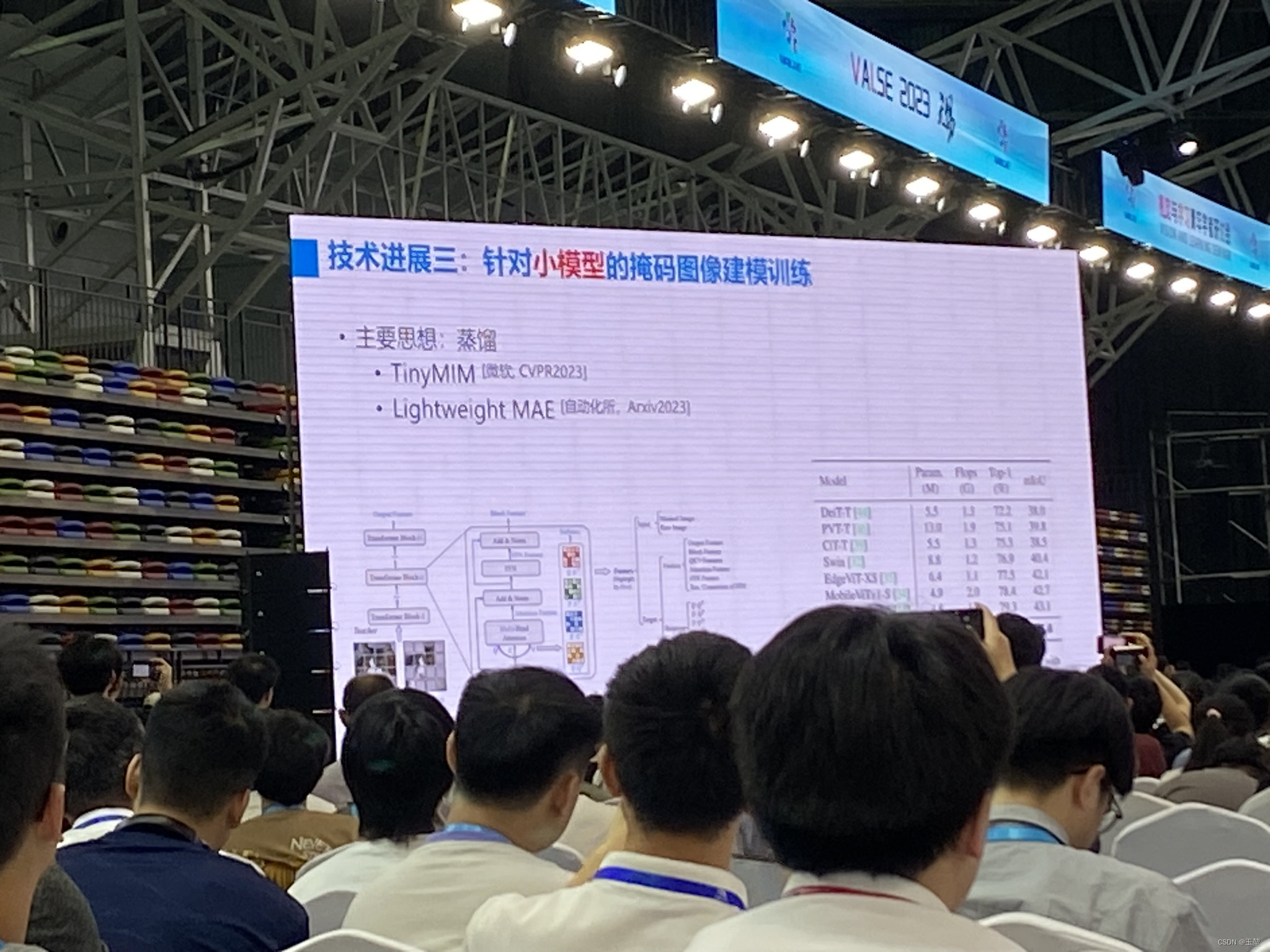

3.1 主题:视觉自监督学习-胡瀚-微软亚洲研究院

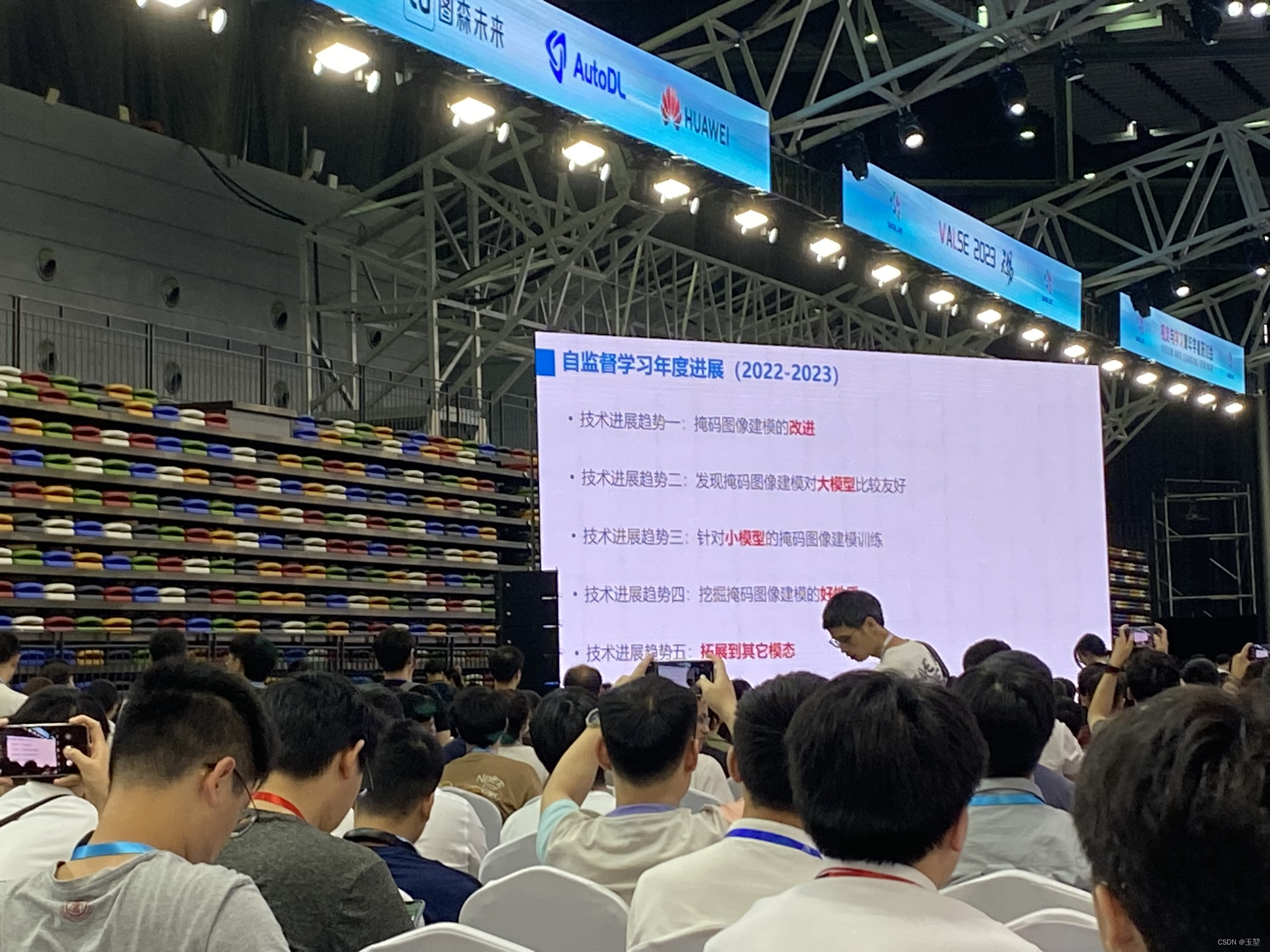

首先,胡瀚老师总结了关于自监督学习的年度进展,分成了5个技术进展趋势,分别是:

- 掩码图像建模的改进。

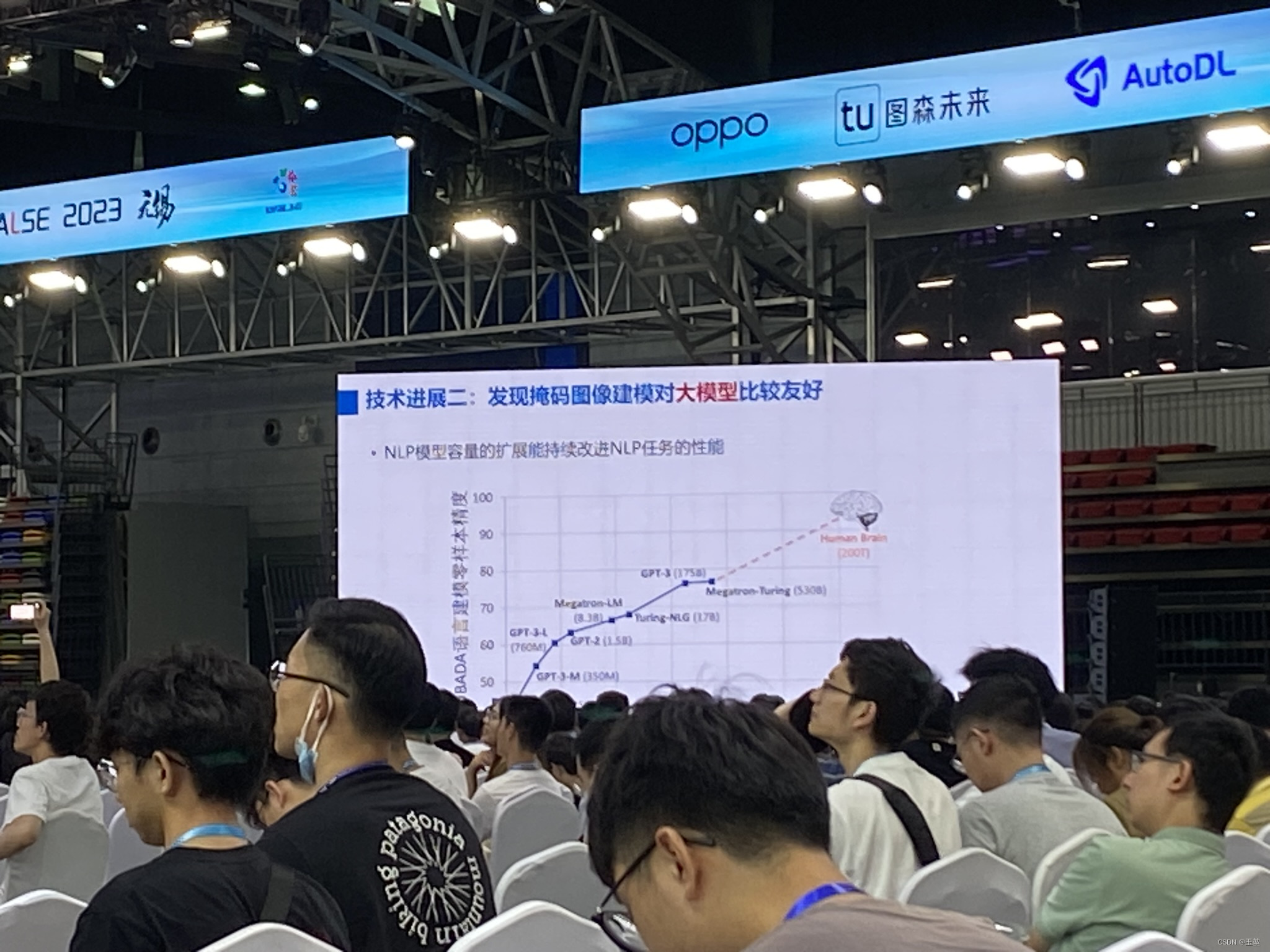

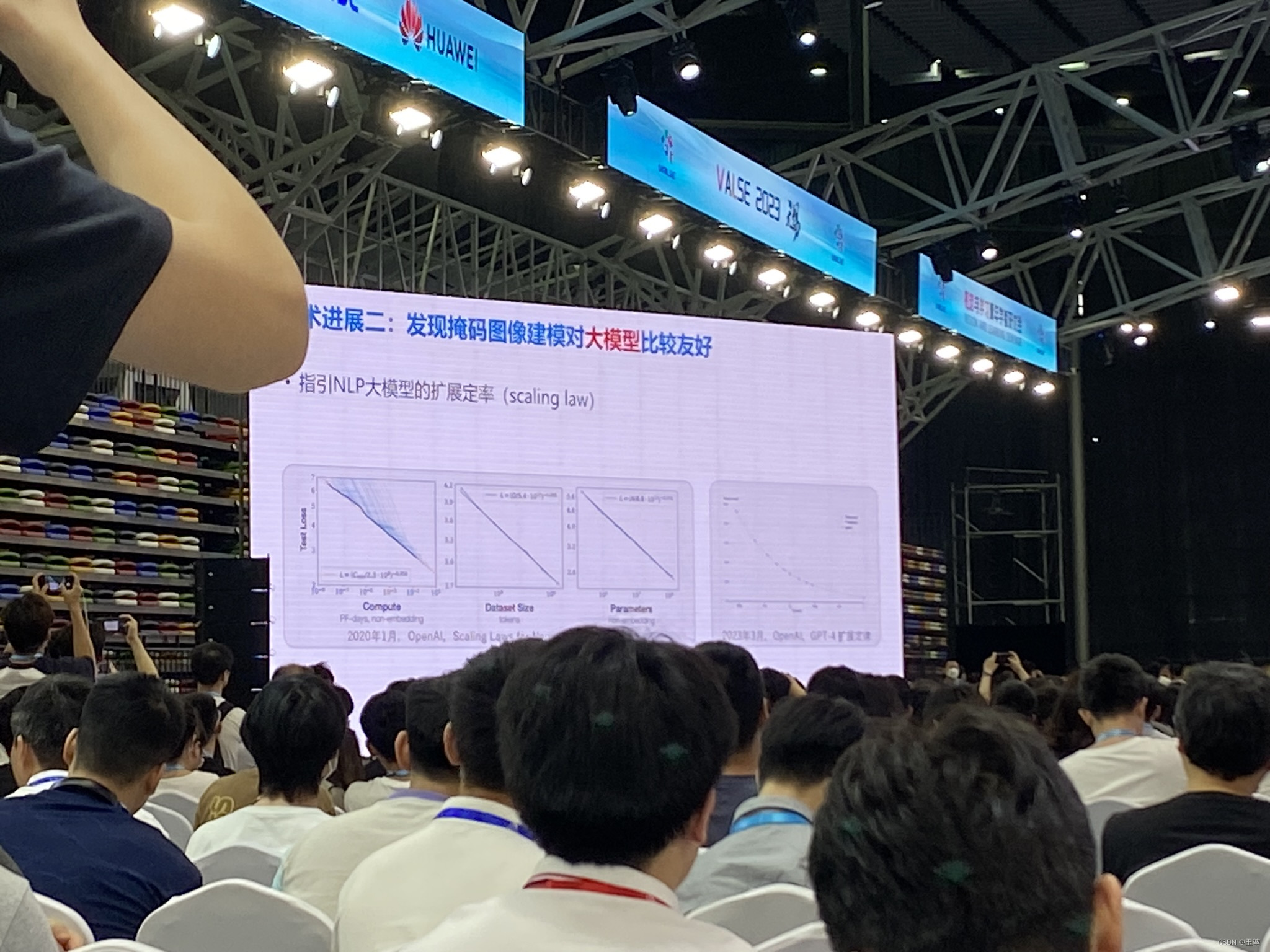

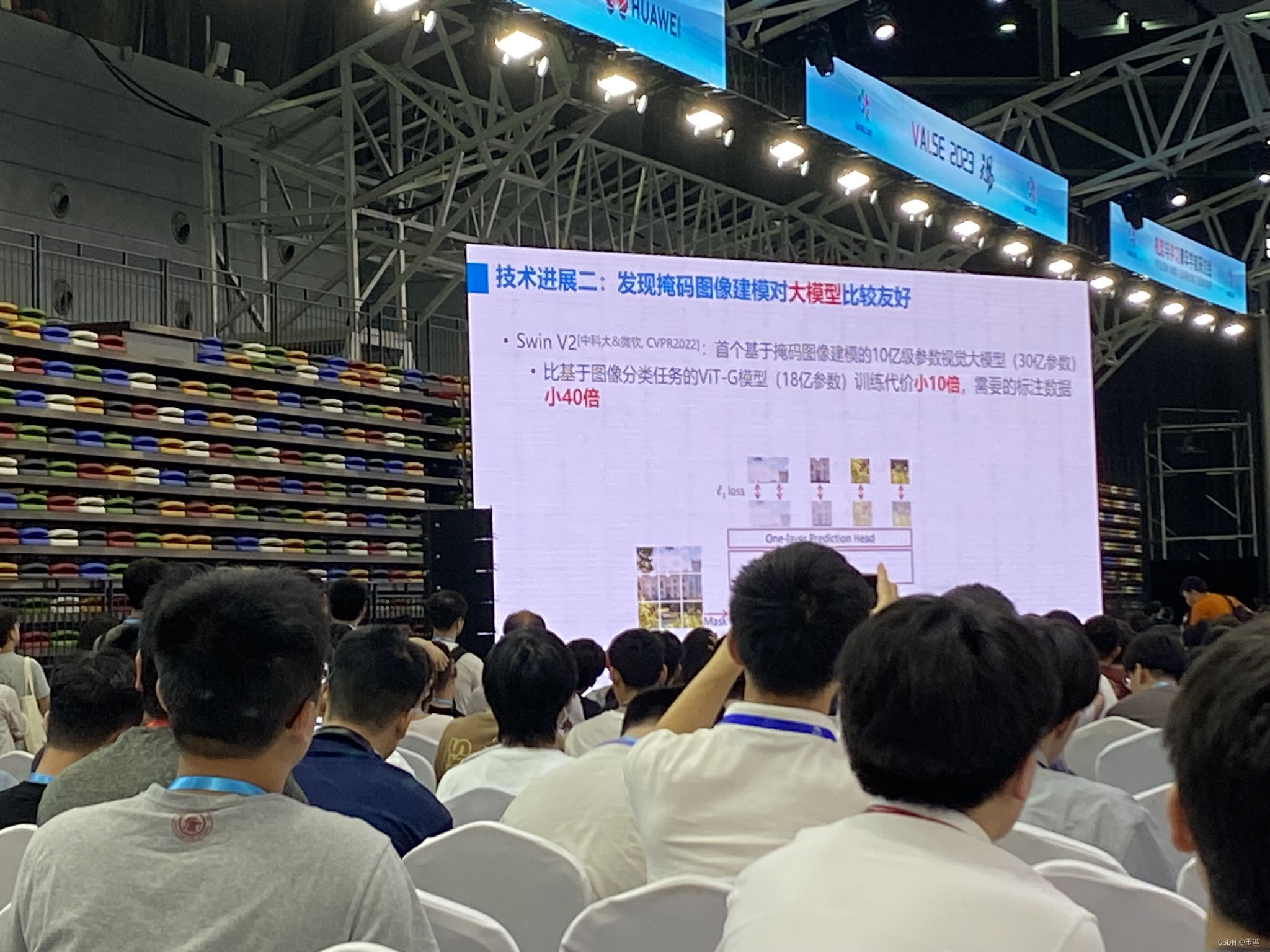

- 发现掩码图像建模对大模型比较友好。

- 针对小模型的掩码图像建模训练。

- 挖掘掩码图像建模的好性质。

- 拓展到其它模态。

技术进展1:掩码图像建模的改进。

| 网络 | 1N-1Ktop-1 |

|---|---|

| BEiT | 83.2 |

| MAE/SimMIM | 83.6/83.8 |

| MaskFeat | 84.0 |

| MVP | 84.4 |

| BEiTv2/MILAN | 85.5,/85.6 |

技术进展2:掩码图像建模的改进。

技术进展3:针对小模型的掩码图像建模训练。

技术进展4和5,没照到。。。

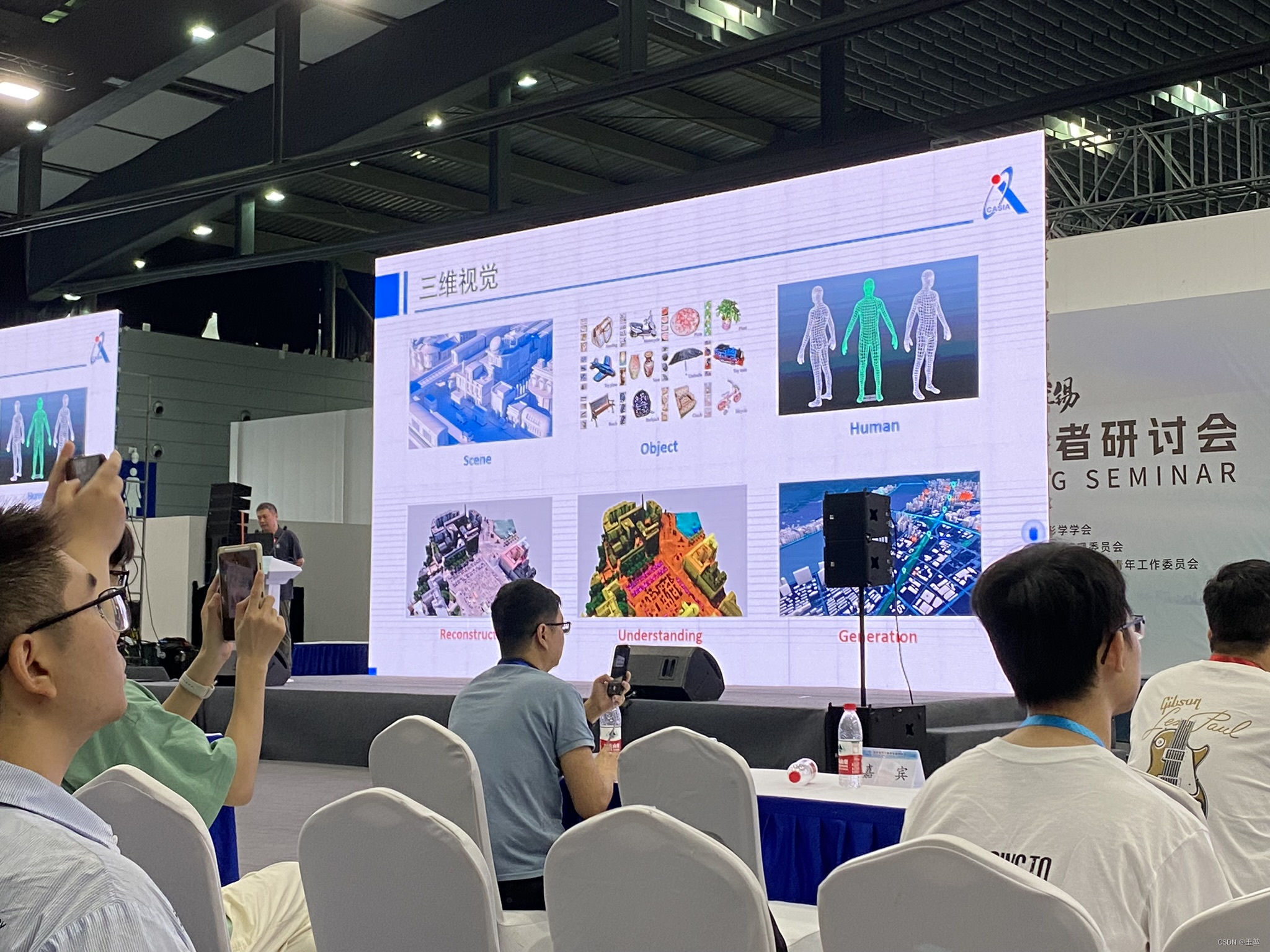

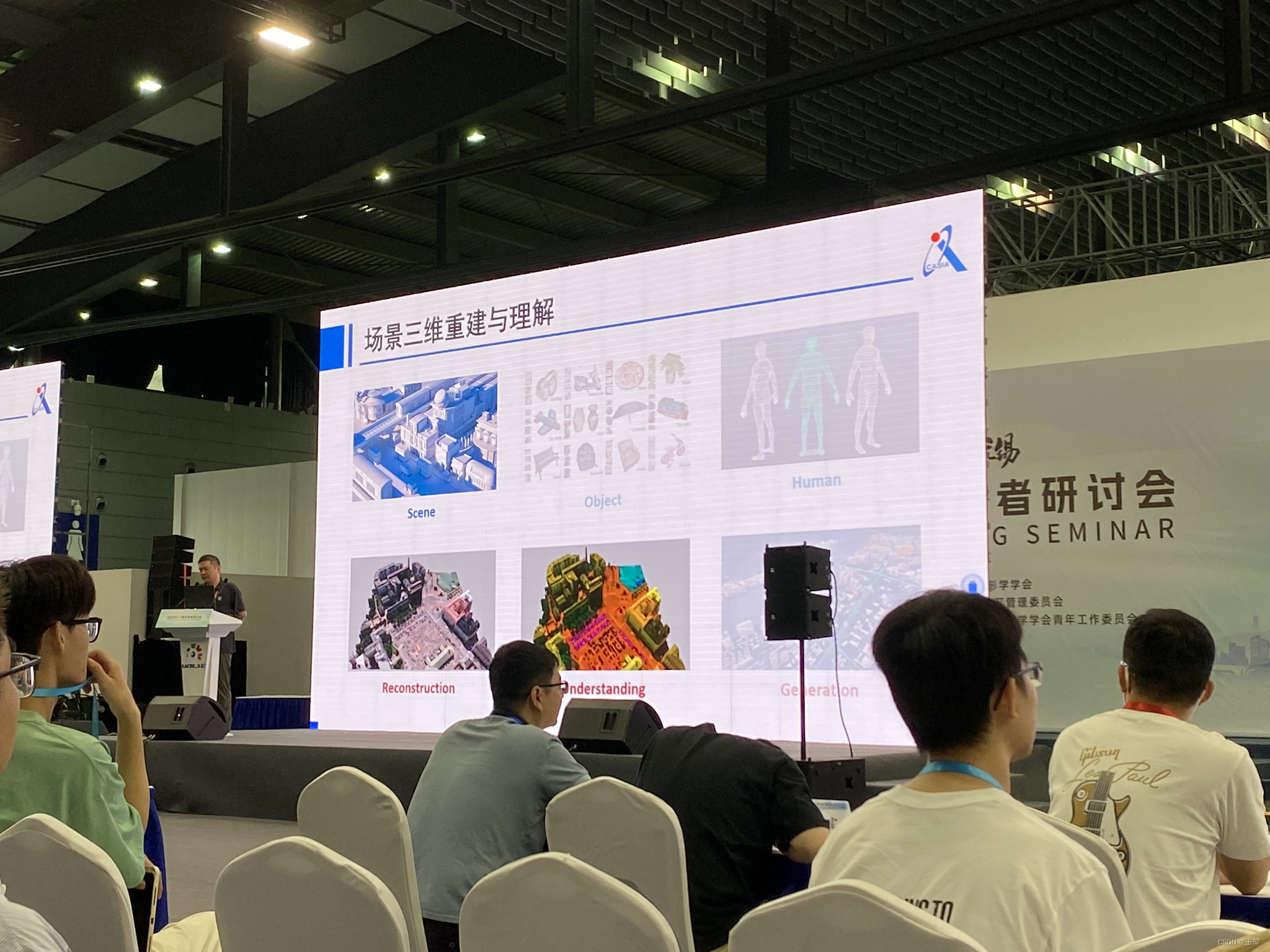

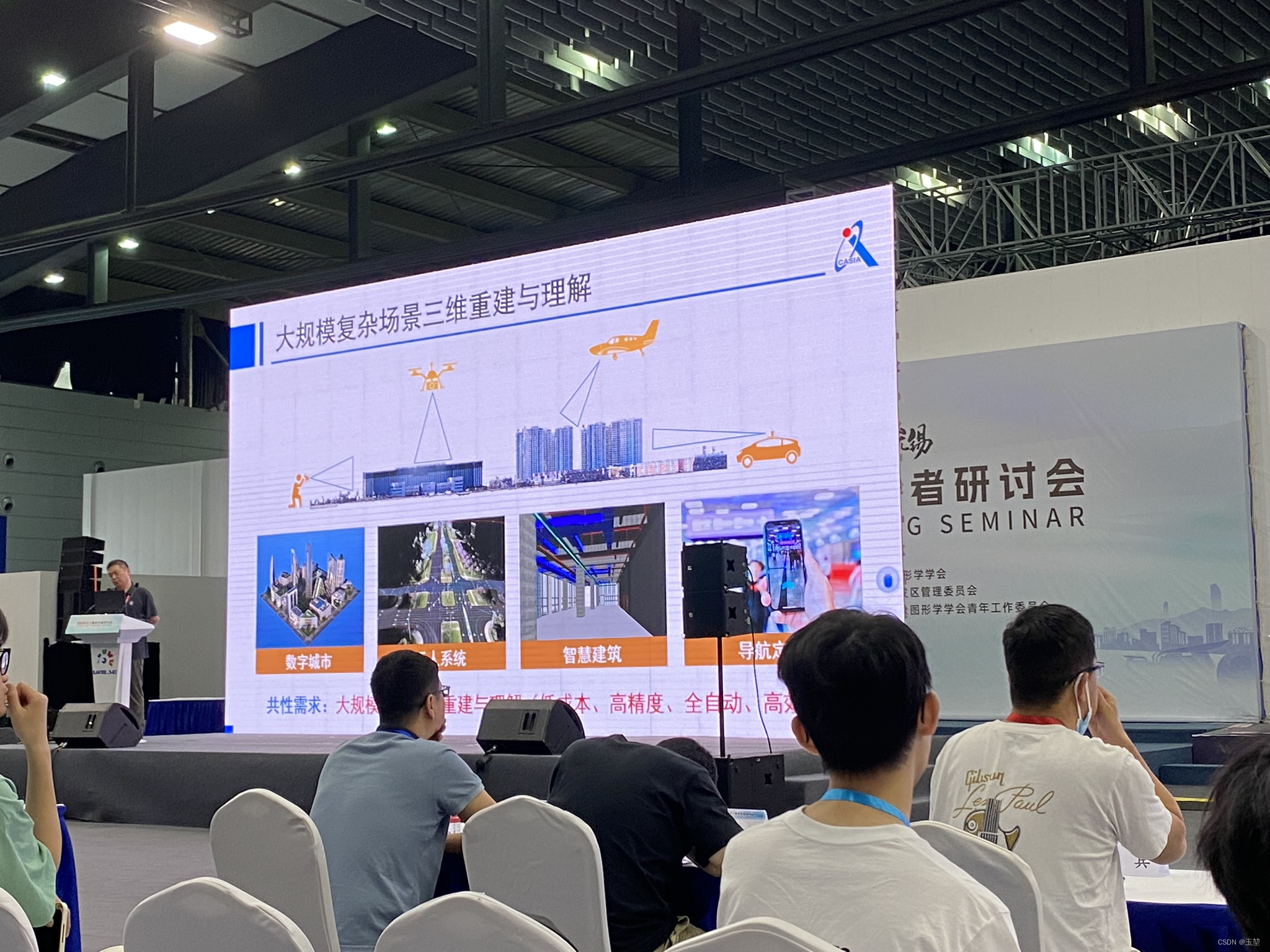

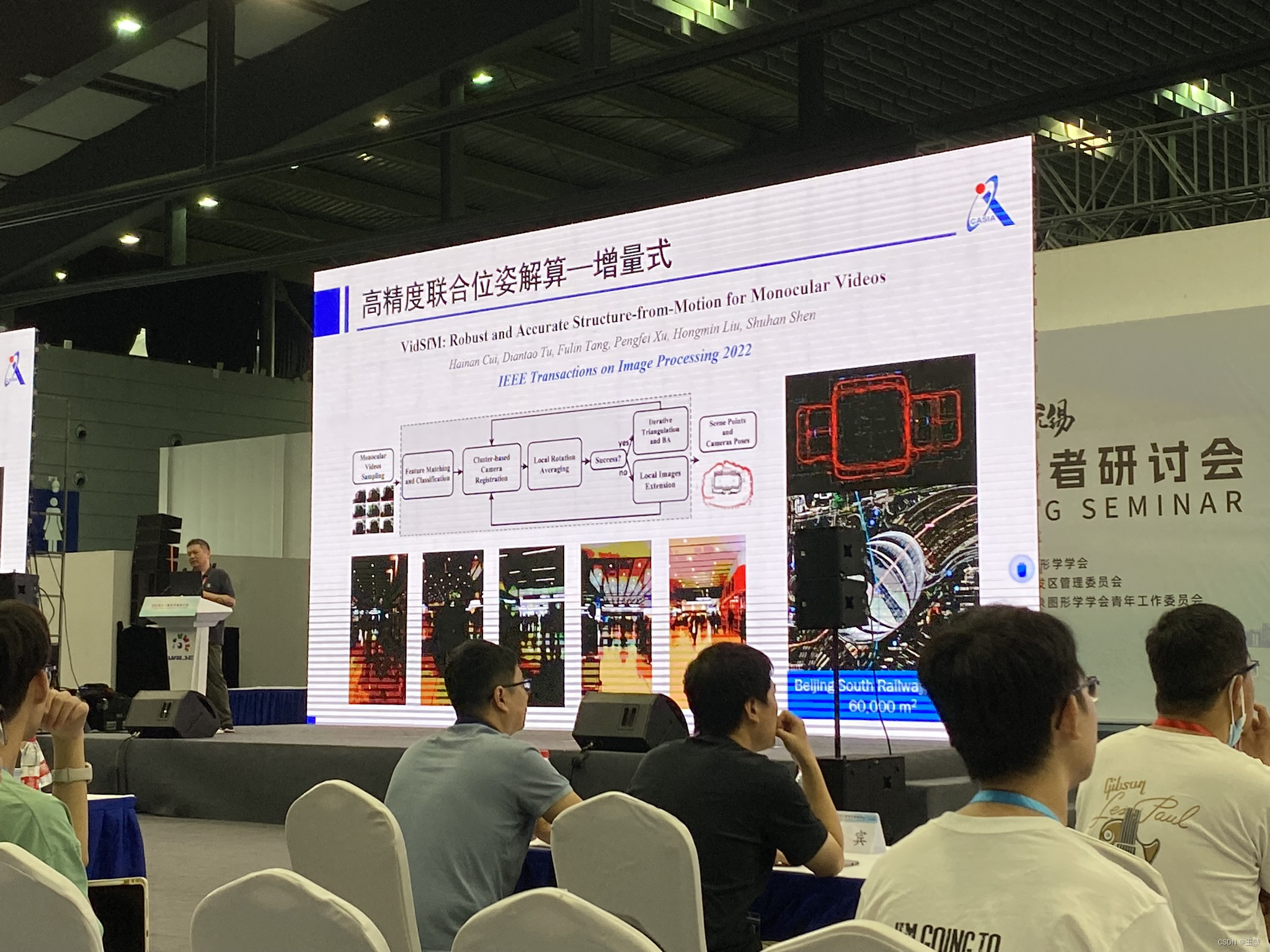

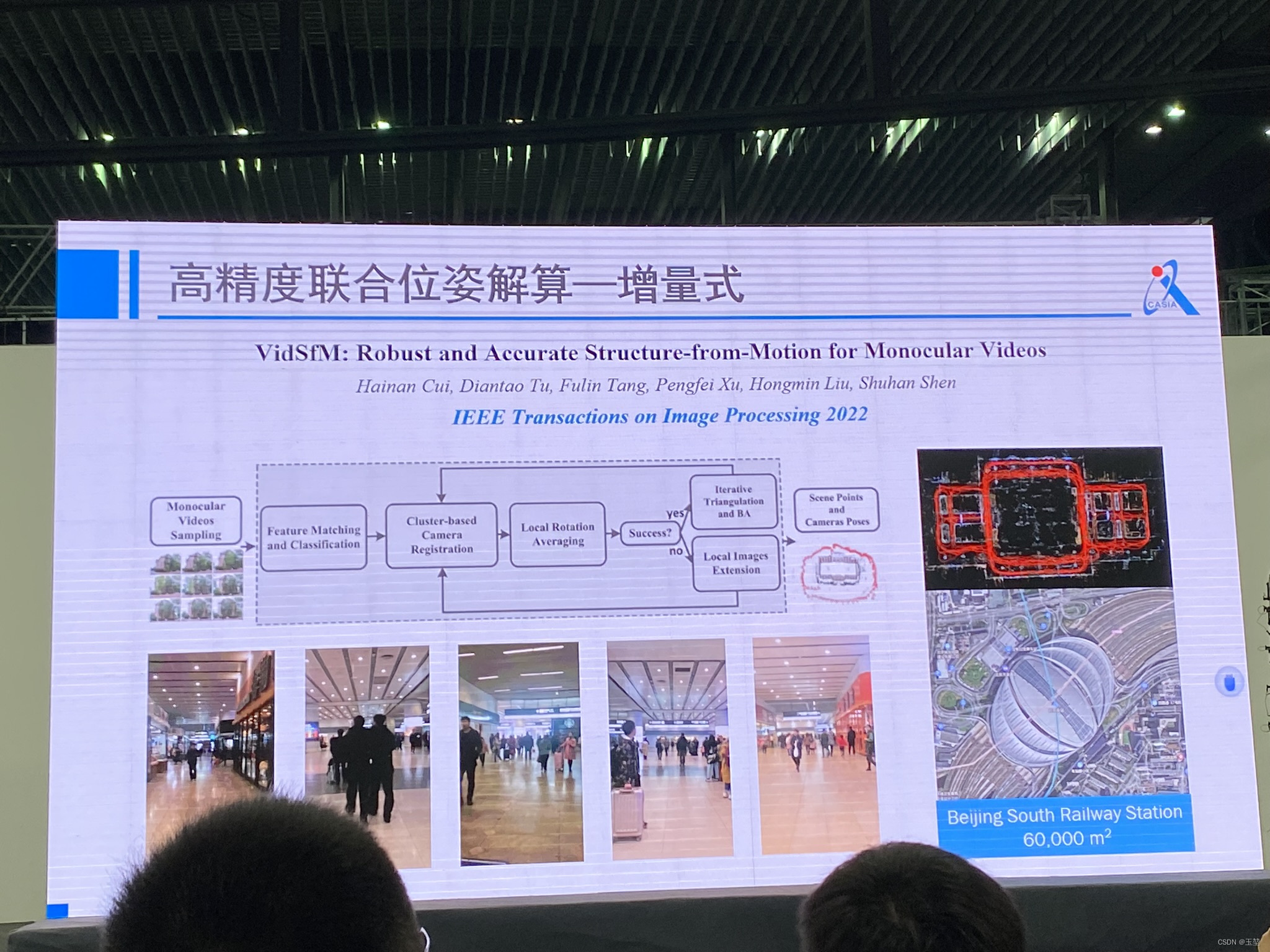

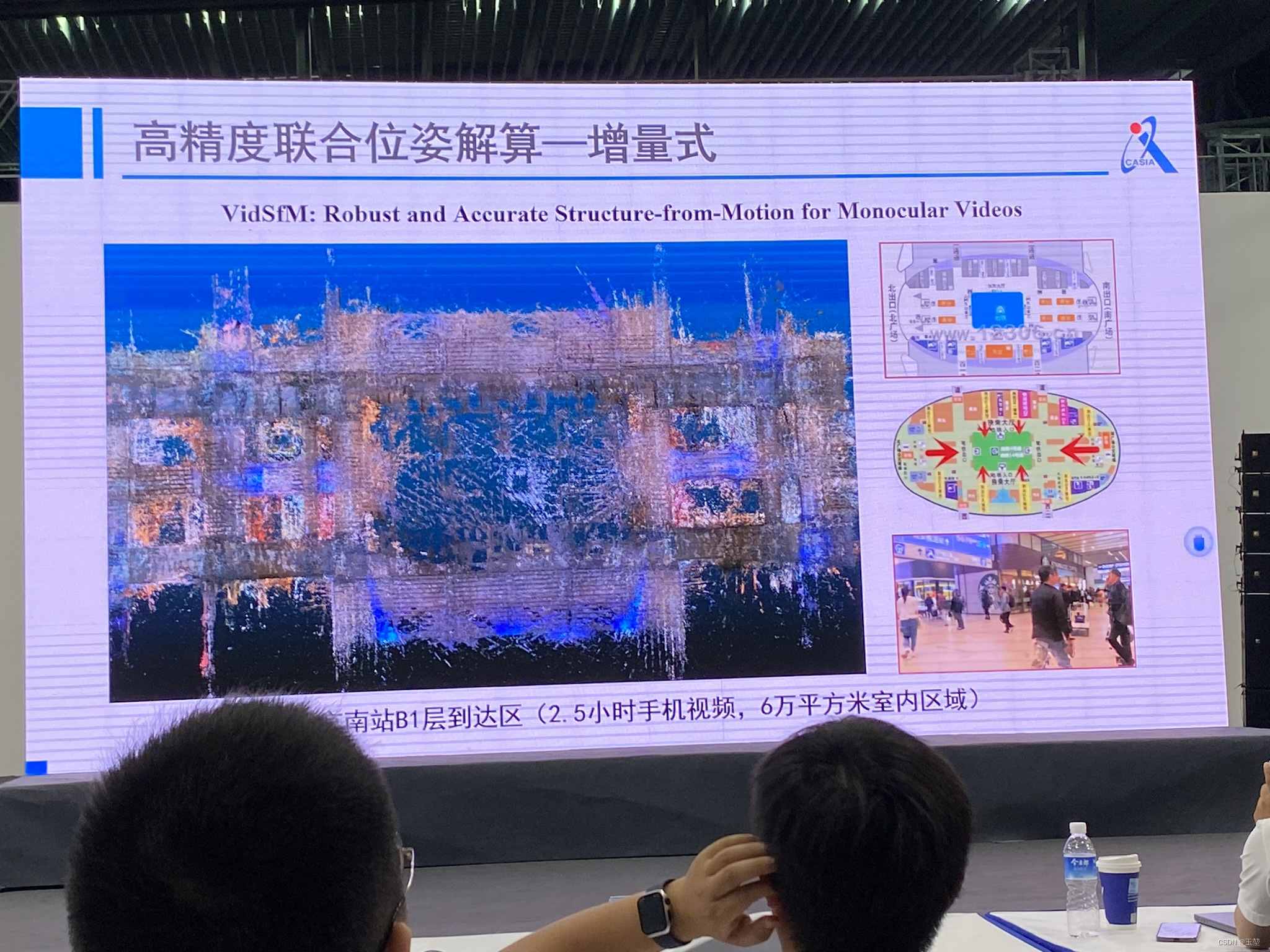

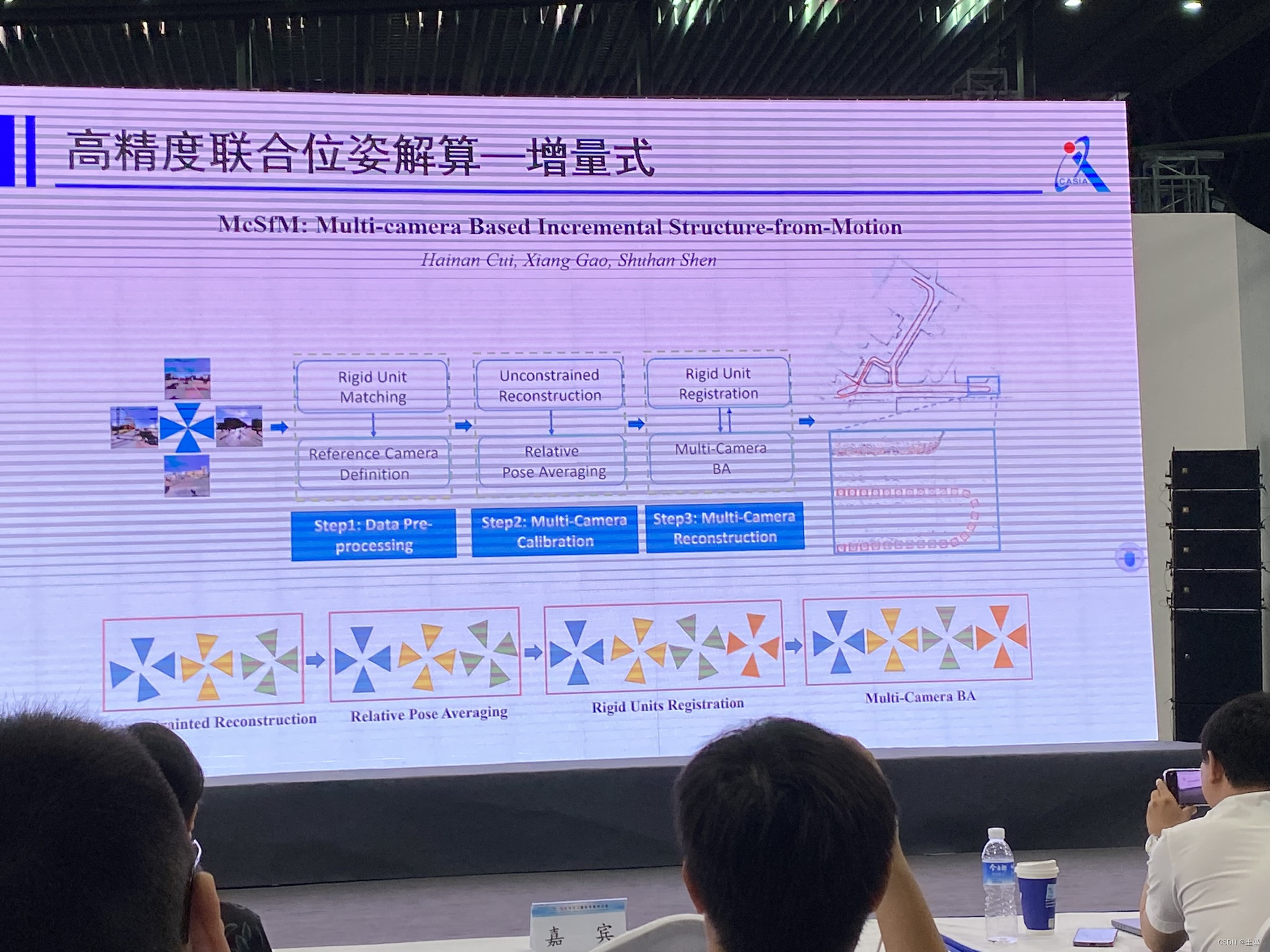

3.2 主题:大规模复杂场景三维重建与理解-申抒含-自动化所

这个是我听的比较认真的一个主题。申老师在三维重建相关讲解的非常好。我进行简单总结一下:

首先,讲到三维视觉可以简单概括为针对场景,目标,人类等目标进行重建,理解和生成。

申老师的主要汇报内容为针对场景目标的重建和理解。

在大规模场景三维重建与理解中,共性需求是低成本,高精度,全自动,高强度。

大规模场景三维重建与理解可以拆分成七个部分,分别是:

- 自主式场景数据获取

- 高精度联合位姿解算

- 完整化三维几何重建

- 细粒度三维语义分割

- 结构化三维矢量表达

- 全天候长时定位位姿

- 高时效地图增量更新

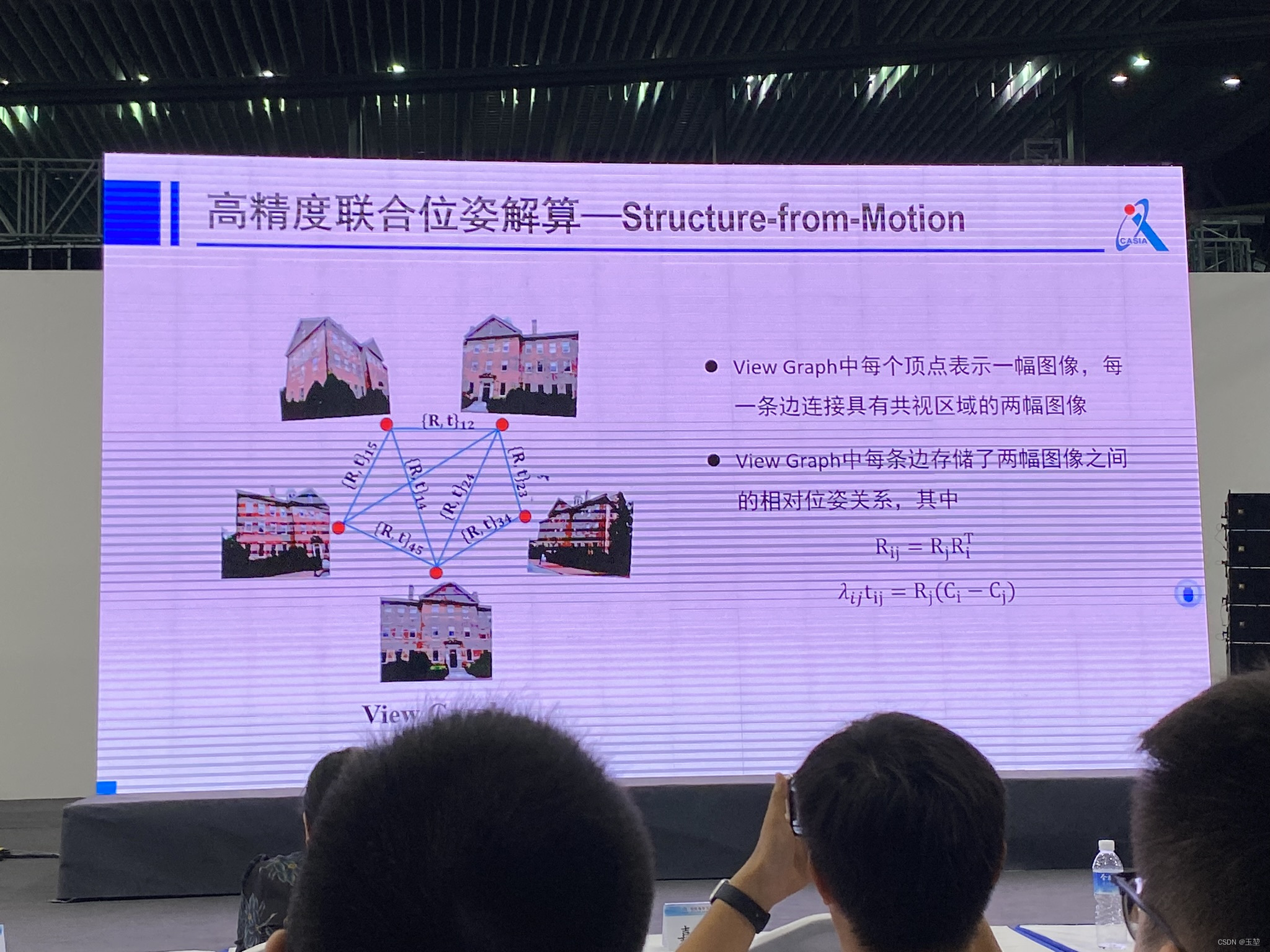

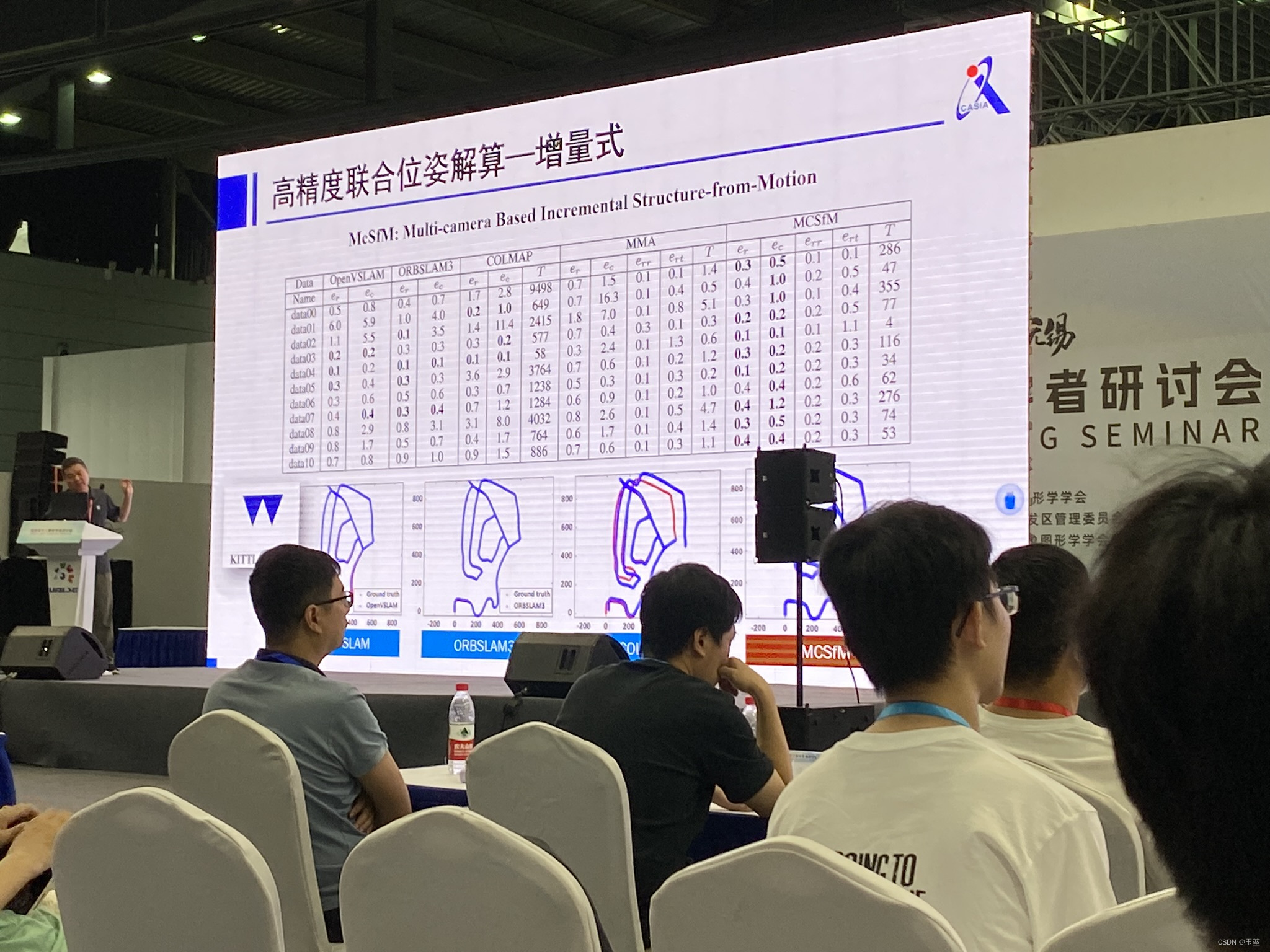

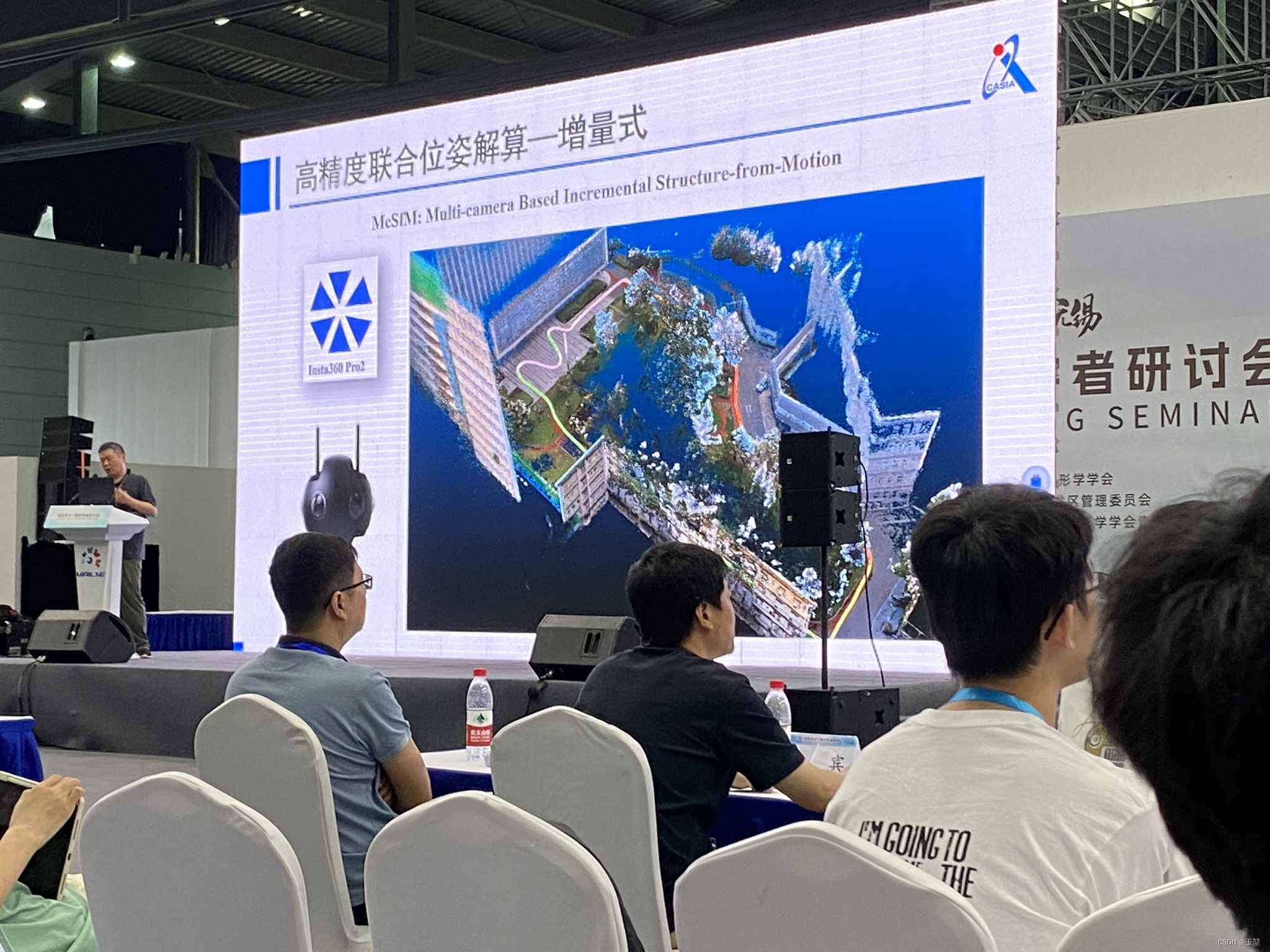

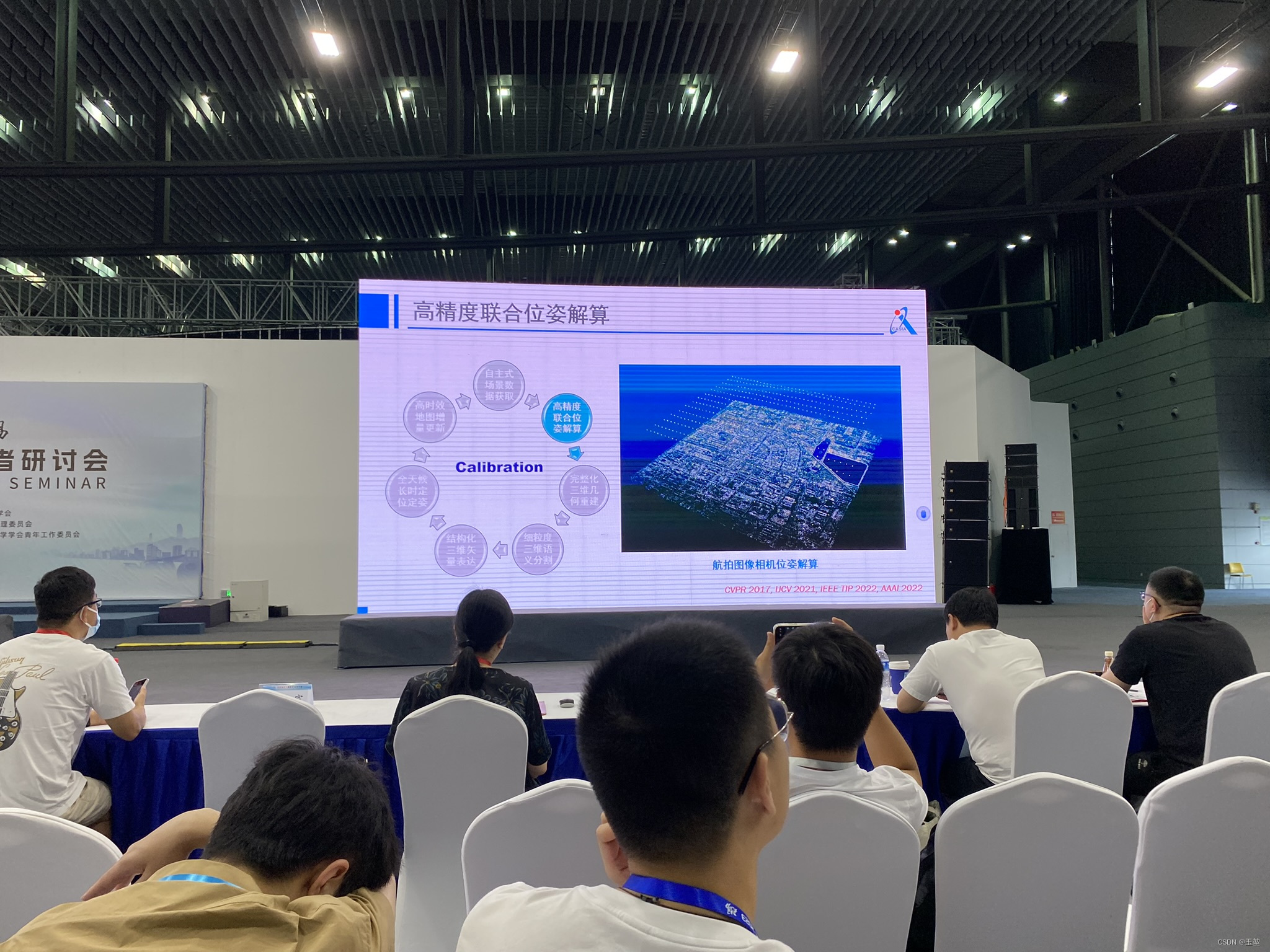

首先讲“高精度联合位姿解算”,这个部分我个人理解就是用来获取相机不同帧下的相机位姿和稀疏点云数据。

这是一种求解方法,称为运动推断结构 (Structure from motion)。

节选自ChatGPT:

“Structure from motion”(SfM),又称为"运动估计与三维重建",是一种计算机视觉技术,用于从二维图像序列中重建三维结构。它是计算机图形和三维计算机视觉领域的基本过程,用于从照片或视频镜头中创建三维模型。SfM旨在恢复场景或物体的三维几何结构以及捕获图像的相机的运动。

以下是结构从动的工作原理概述:

- 图像获取:该过程始于使用摄像机捕获图像序列或帧,摄像机可以在场景中移动。这些图像可以来自一个移动的摄像机,也可以来自多个摄像机从不同的视角捕获相同的场景。

- 特征检测:SfM算法分析每一张图像,检测并提取独特的视觉特征或关键点。这些特征可以包括在图像中能够可靠匹配的点、边缘或角点。

- 特征匹配:接下来,算法会尝试在不同图像之间匹配相同的特征点。这通常涉及到计算这些特征点之间的相似性或距离,以确定它们是否来自于同一物体的不同视角。

- 相机运动估计:通过比较不同图像中的特征点的位置以及相机的内外参数,SfM算法可以估计相机的运动。这包括相机的平移和旋转。

- 三维重建:一旦估计出相机的运动,算法可以使用三角测量等技术来重建场景中的三维点。这些三维点表示场景中的实际物体或结构。

- 稠密重建:有时候,SfM还可以进一步生成稠密的三维重建,而不仅仅是稀疏的特征点。

- 应用领域:SfM广泛应用于许多领域,包括地图制作、建筑文化遗产保护、虚拟现实、增强现实、无人机导航、电影制作等。它为这些领域提供了一种以低成本和非侵入性的方式获取三维信息的手段

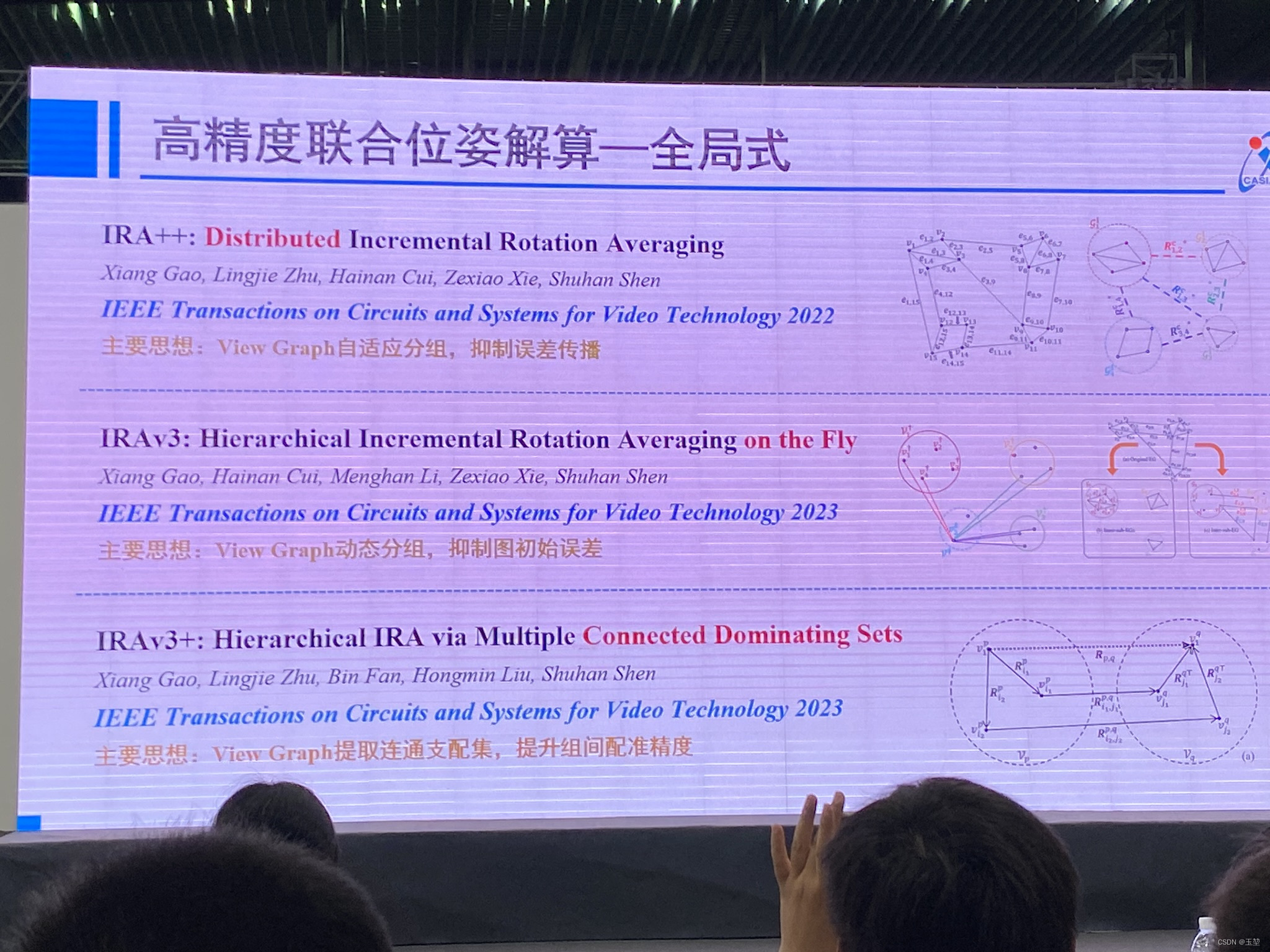

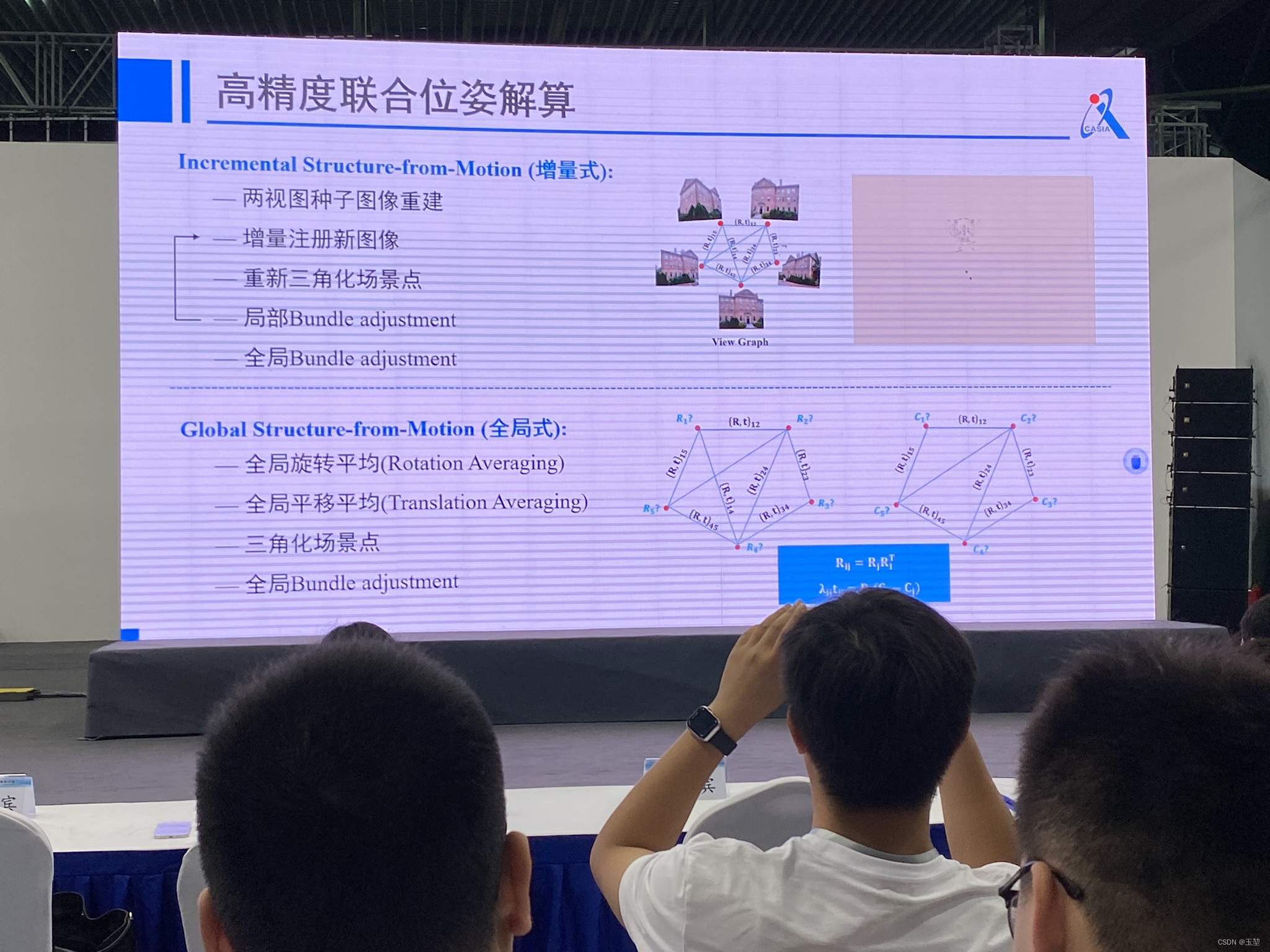

高精度联合位姿解算可以划分为2种方式:一种是增量式,另一种是全局式。

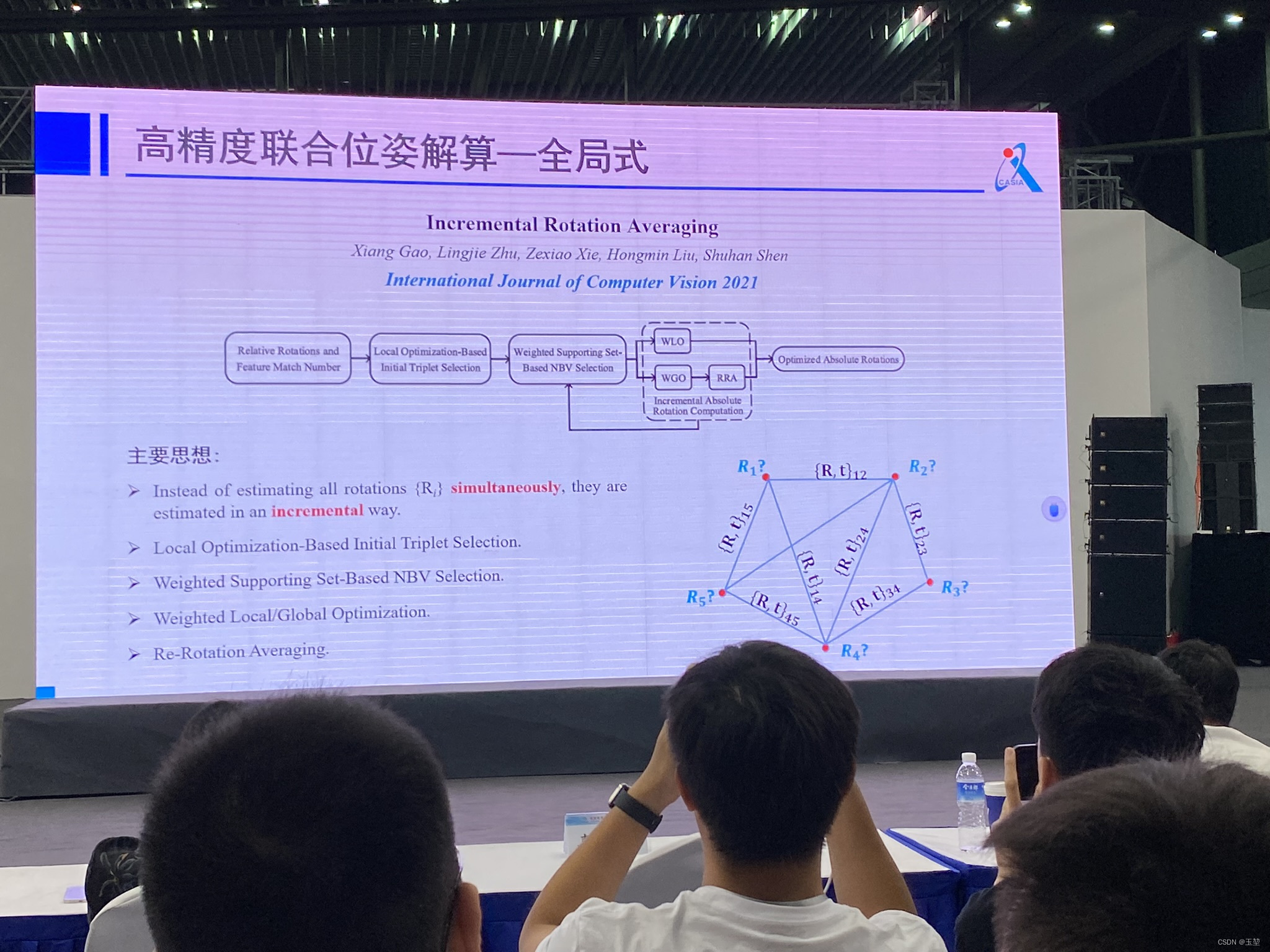

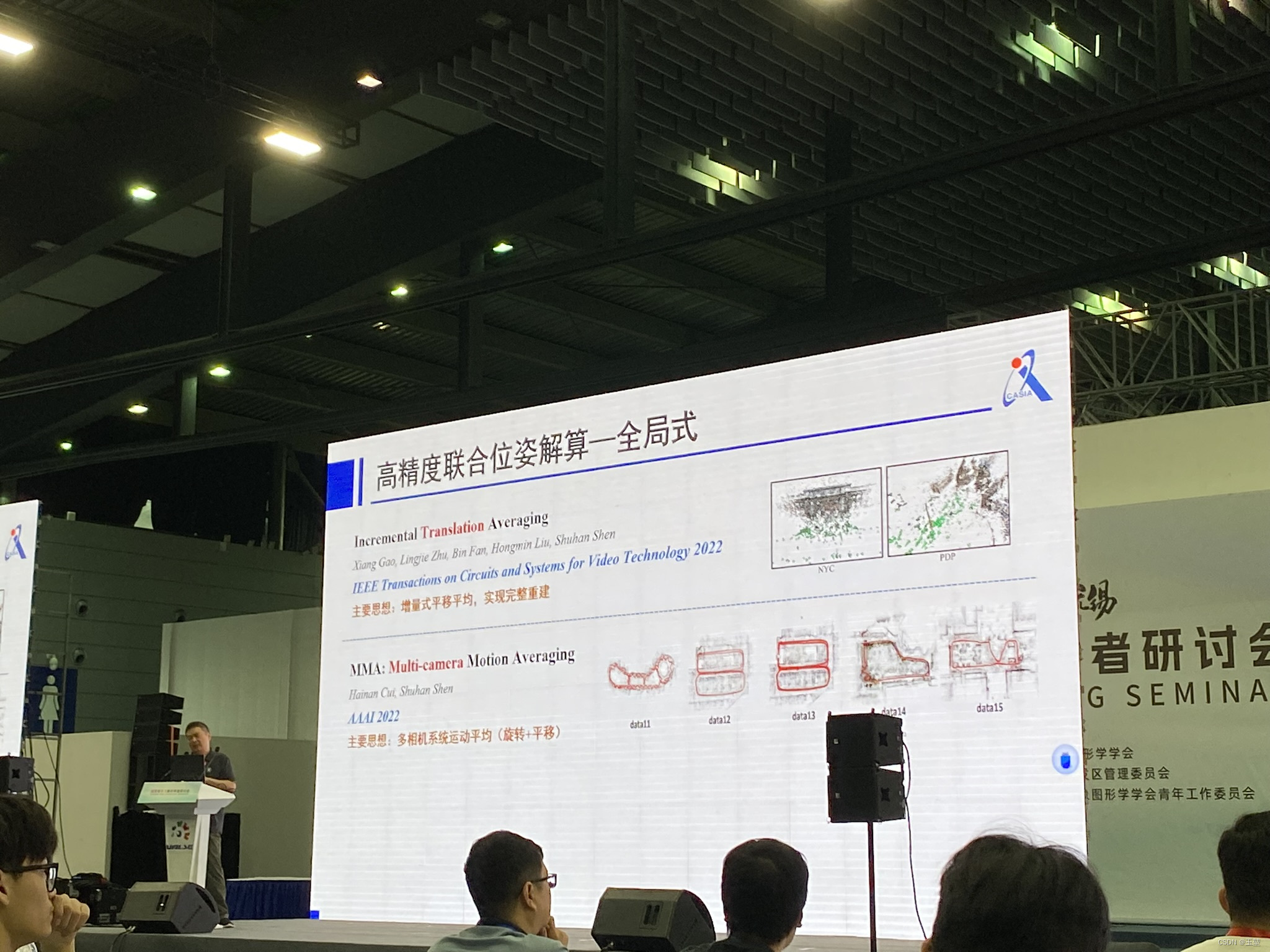

全局式的文章推荐:

[1] Gao, X., Zhu, L., Xie, Z. et al. Incremental Rotation Averaging. Int J Comput Vis 129, 1202–1216 (2021). https://doi.org/10.1007/s11263-020-01427-7

[2] X. Gao, L. Zhu, B. Fan, H. Liu and S. Shen, “Incremental Translation Averaging,” in IEEE Transactions on Circuits and Systems for Video Technology, vol. 32, no. 11, pp. 7783-7795, Nov. 2022, doi: 10.1109/TCSVT.2022.3183631.

[3] X. Gao, L. Zhu, H. Cui, Z. Xie and S. Shen, “IRA++: Distributed Incremental Rotation Averaging,” in IEEE Transactions on Circuits and Systems for Video Technology, vol. 32, no. 7, pp. 4885-4892, July 2022, doi: 10.1109/TCSVT.2021.3118883.

[4] X. Gao, H. Cui, M. Li, Z. Xie and S. Shen, “IRAv3: Hierarchical Incremental Rotation Averaging on the Fly,” in IEEE Transactions on Circuits and Systems for Video Technology, vol. 33, no. 4, pp. 2001-2006, April 2023, doi: 10.1109/TCSVT.2022.3217151.

[5] X. Gao, H. Cui, W. Huang, M. Li and S. Shen, “IRAv3+: Hierarchical Incremental Rotation Averaging via Multiple Connected Dominating Sets,” in IEEE Transactions on Circuits and Systems for Video Technology, doi: 10.1109/TCSVT.2023.3309661.

[6] Cui, H., & Shen, S. (2022). MMA: Multi-Camera Based Global Motion Averaging. Proceedings of the AAAI Conference on Artificial Intelligence, 36(1), 490-498. https://doi.org/10.1609/aaai.v36i1.19927

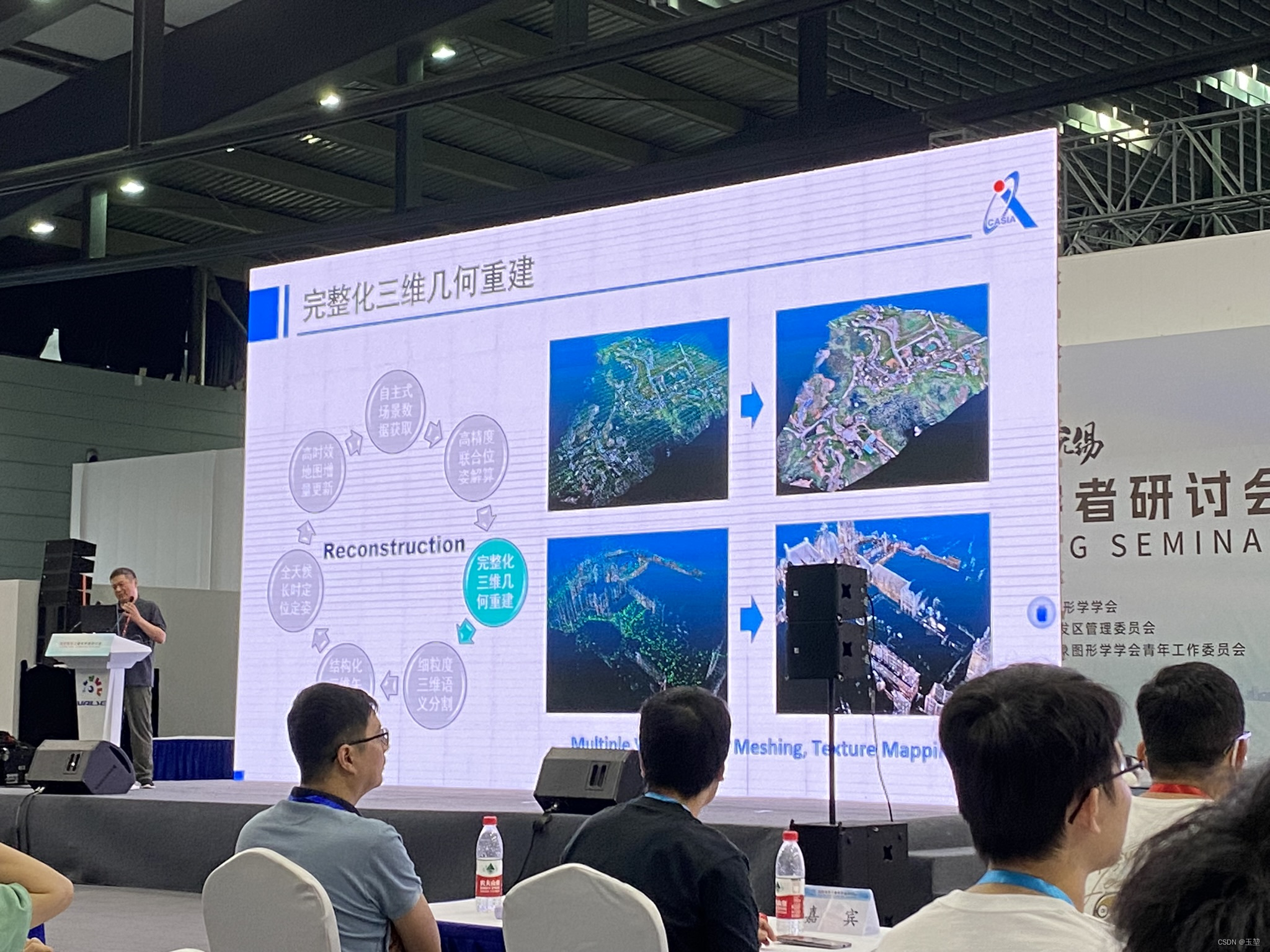

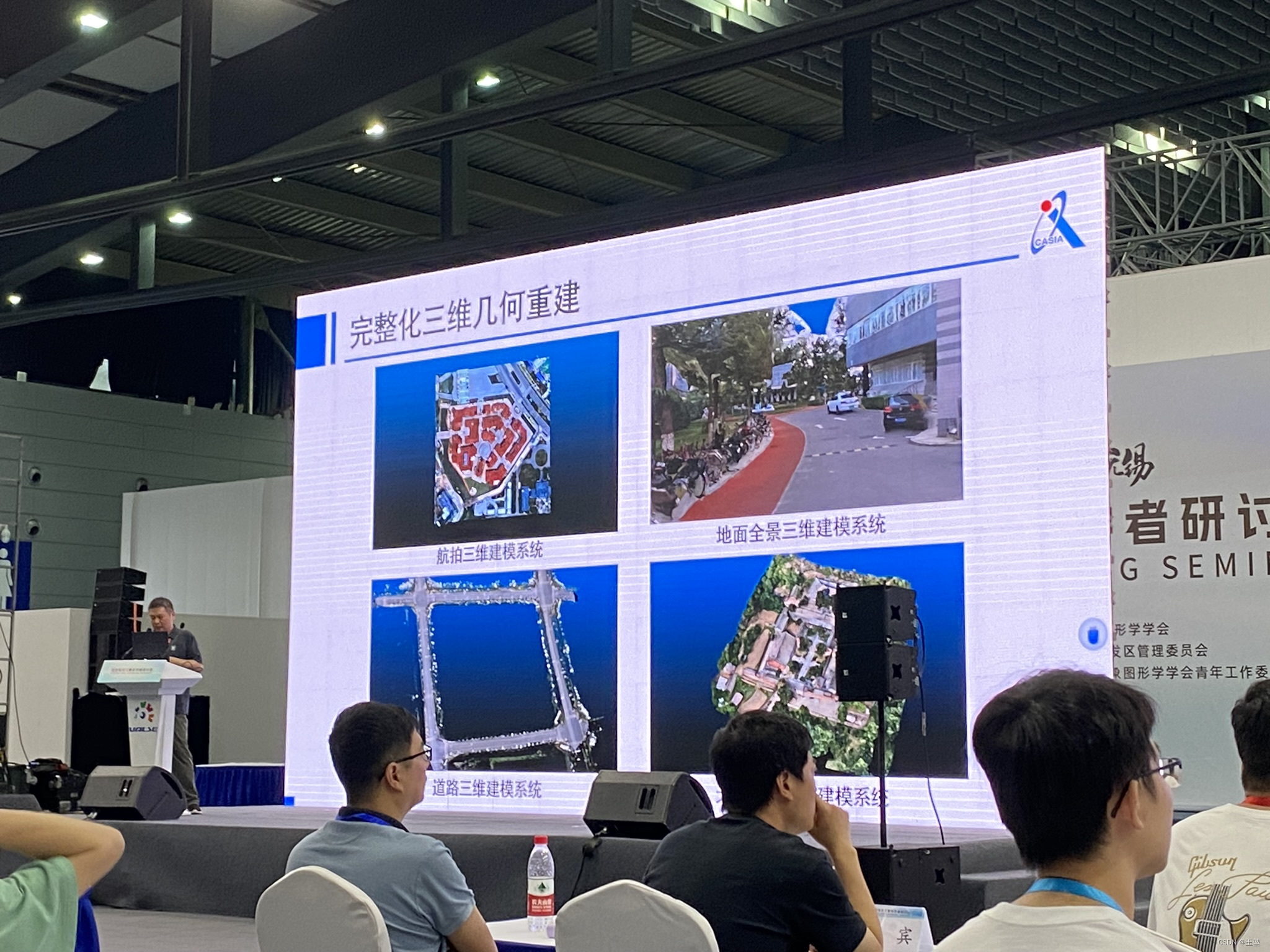

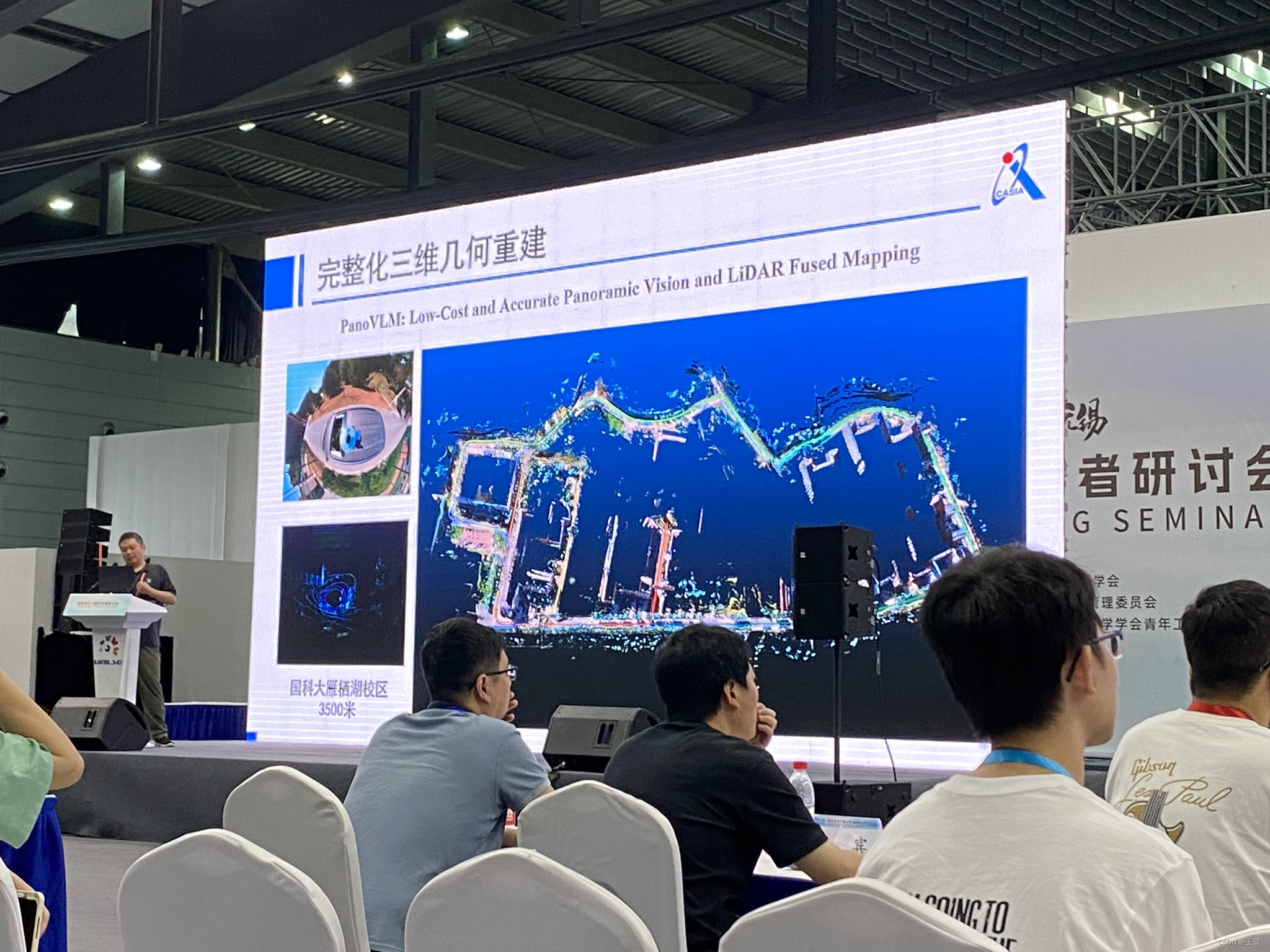

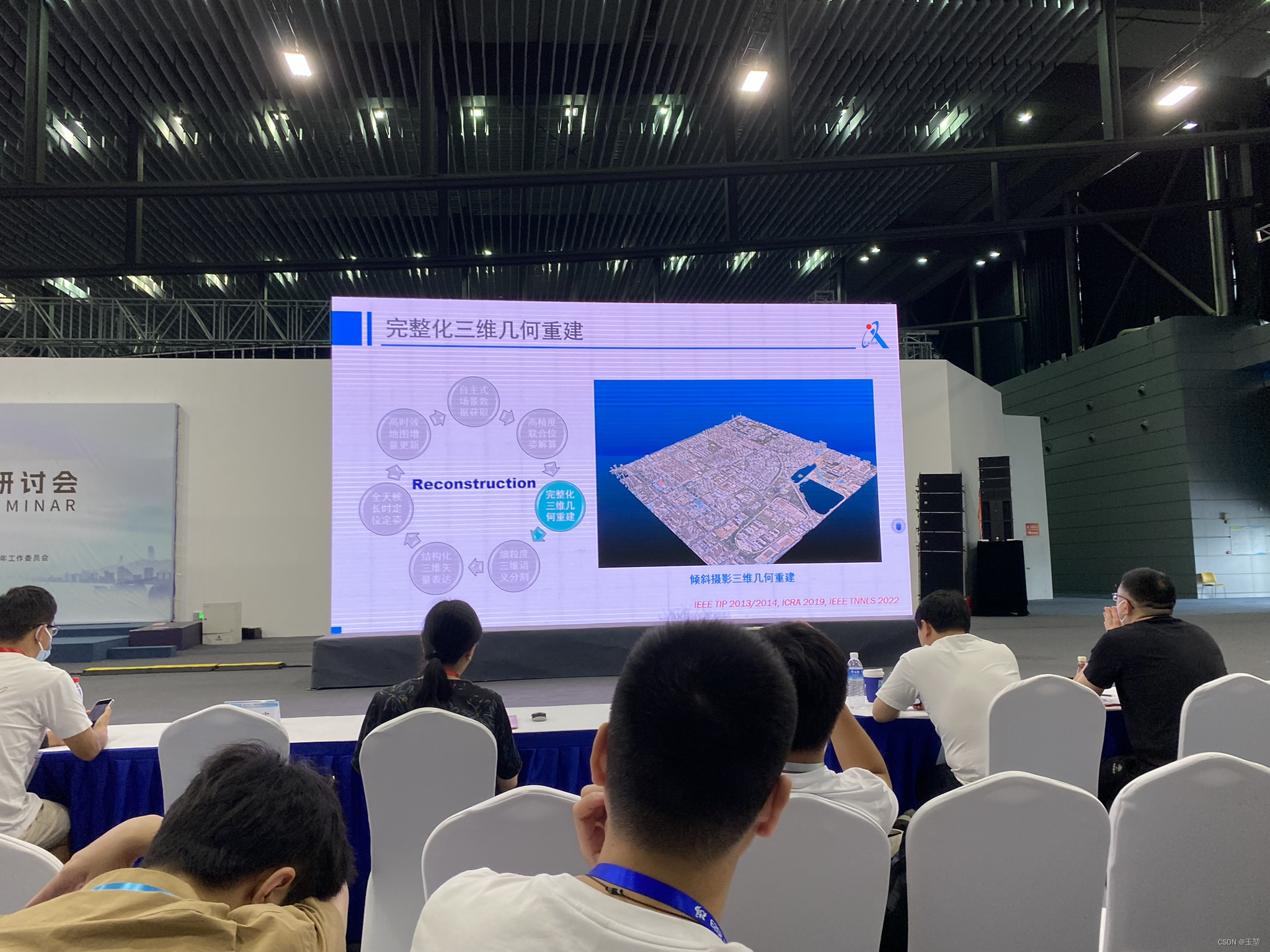

然后,开始讲第二部分“完整化三维几何重建”。

下面是三维几何重建的几个示例:

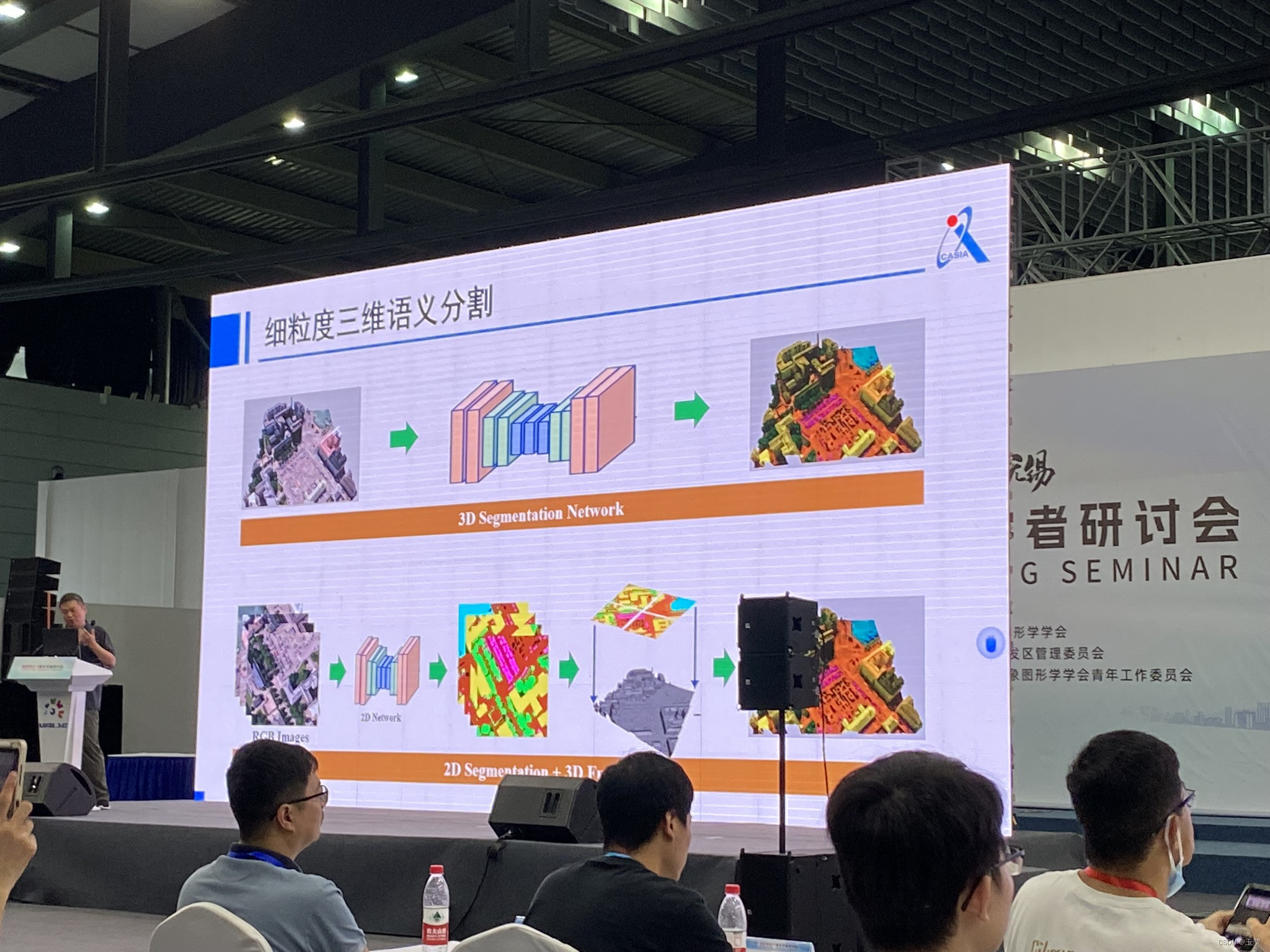

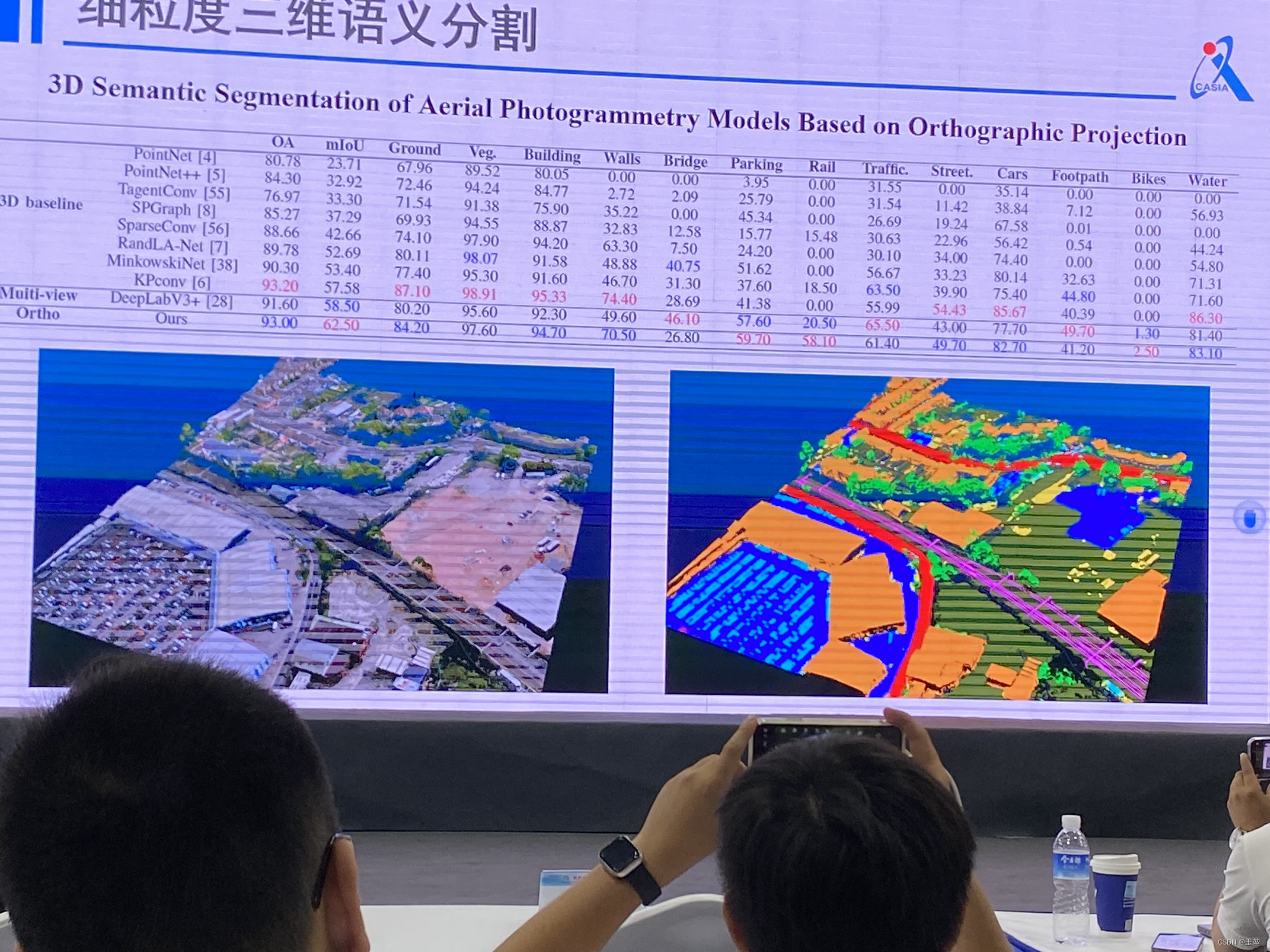

接着,开始讲第三部分“细粒度三维语义分割”。

接着,开始讲第三部分“细粒度三维语义分割”。

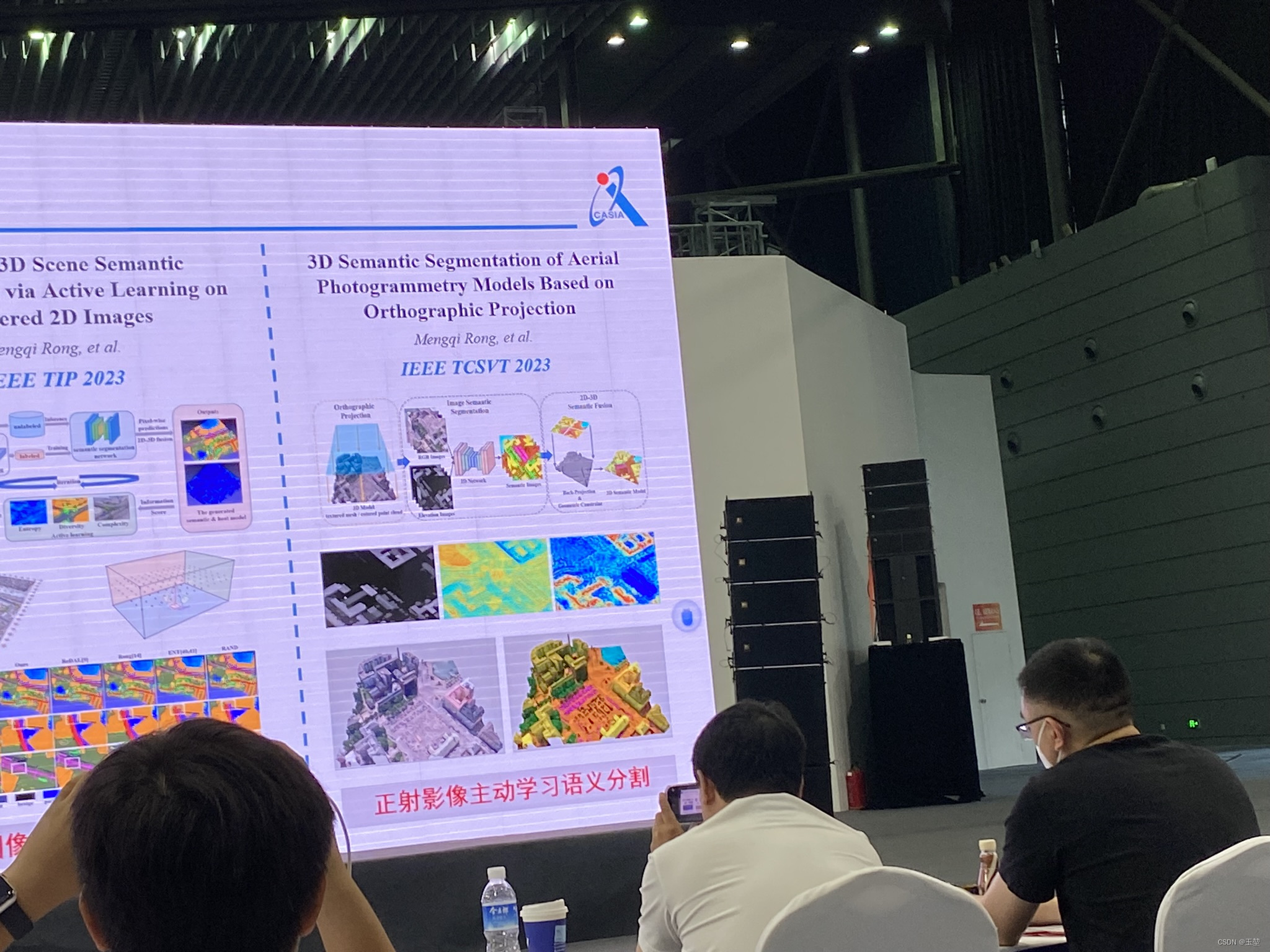

三维语义分割可以分为两种:一种是直接对点云数据进行语义分割,另一种是先对dom(正射影像图)进行2d的语义分割,然后以二维语义分割的结果来分割三维点云数据。

语义分割文章推荐:

[1] M. Rong, H. Cui, Z. Hu, H. Jiang, H. Liu and S. Shen, “Active Learning Based 3D Semantic Labeling From Images and Videos,” in IEEE Transactions on Circuits and Systems for Video Technology, vol. 32, no. 12, pp. 8101-8115, Dec. 2022, doi: 10.1109/TCSVT.2021.3079991.

[2] M. Rong, H. Cui and S. Shen, “Efficient 3D Scene Semantic Segmentation via Active Learning on Rendered 2D Images,” in IEEE Transactions on Image Processing, vol. 32, pp. 3521-3535, 2023, doi: 10.1109/TIP.2023.3286708.

[3] M. Rong and S. Shen, “3D Semantic Segmentation of Aerial Photogrammetry Models Based on Orthographic Projection,” in IEEE Transactions on Circuits and Systems for Video Technology, doi: 10.1109/TCSVT.2023.3273224.

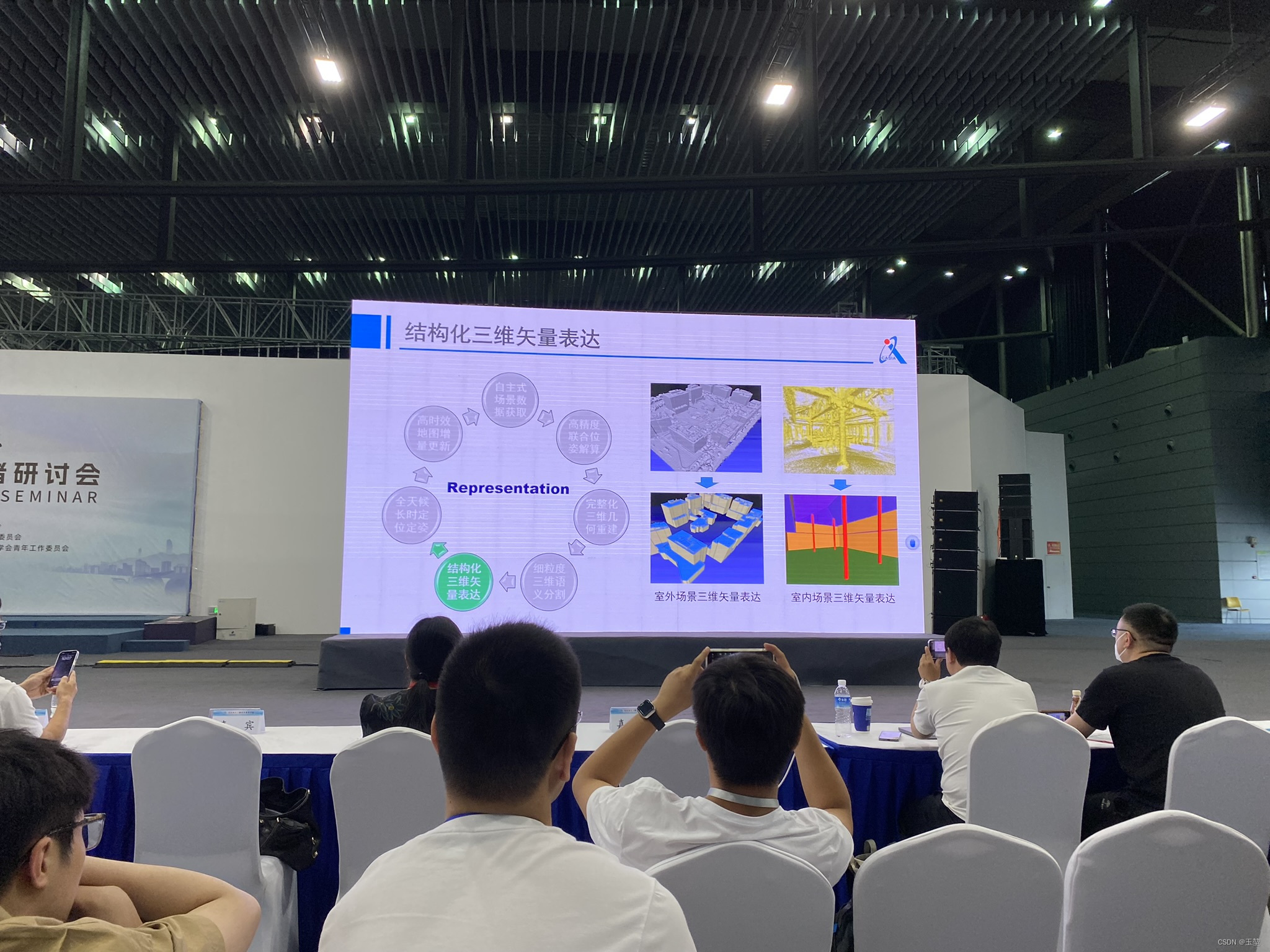

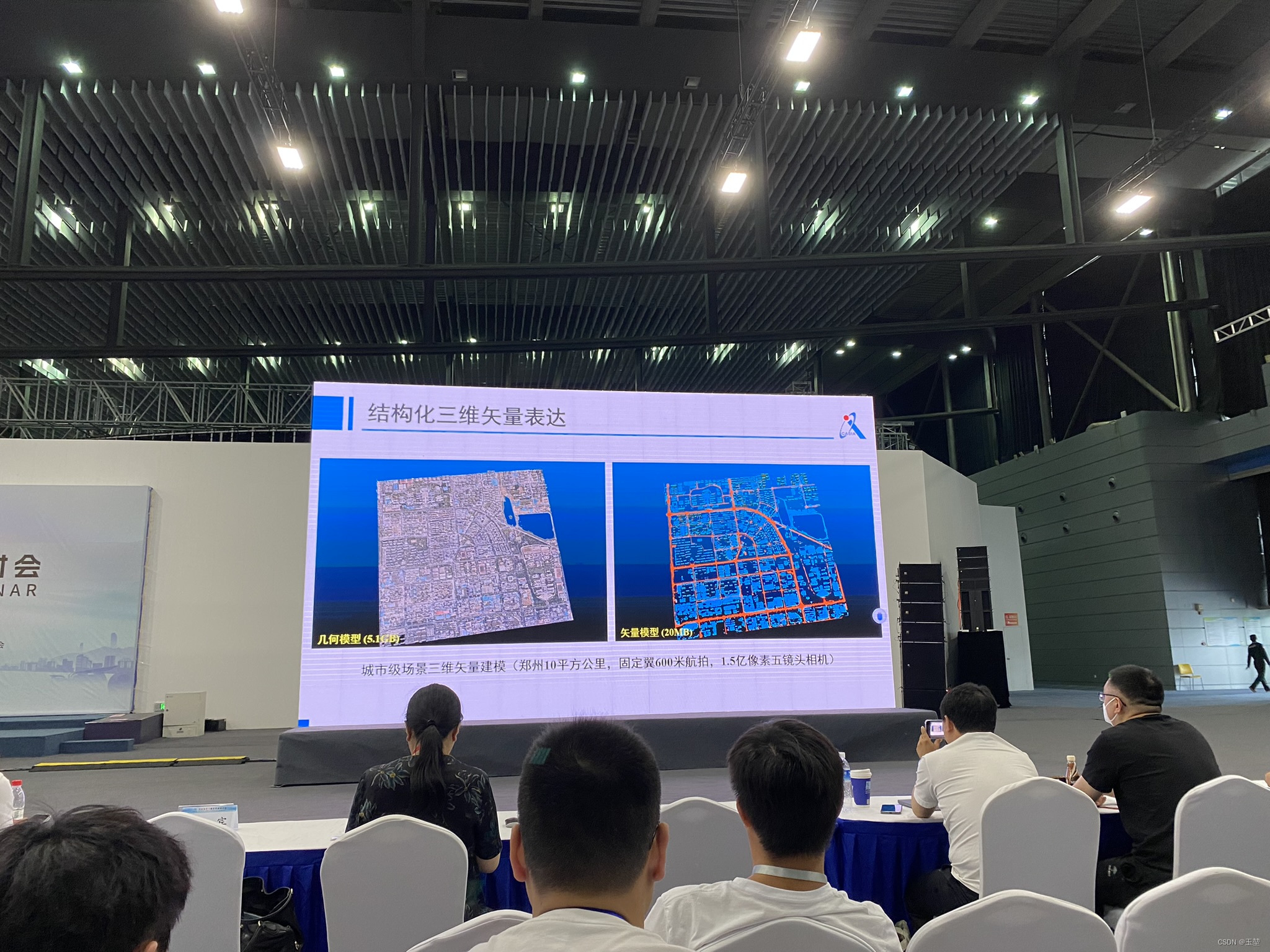

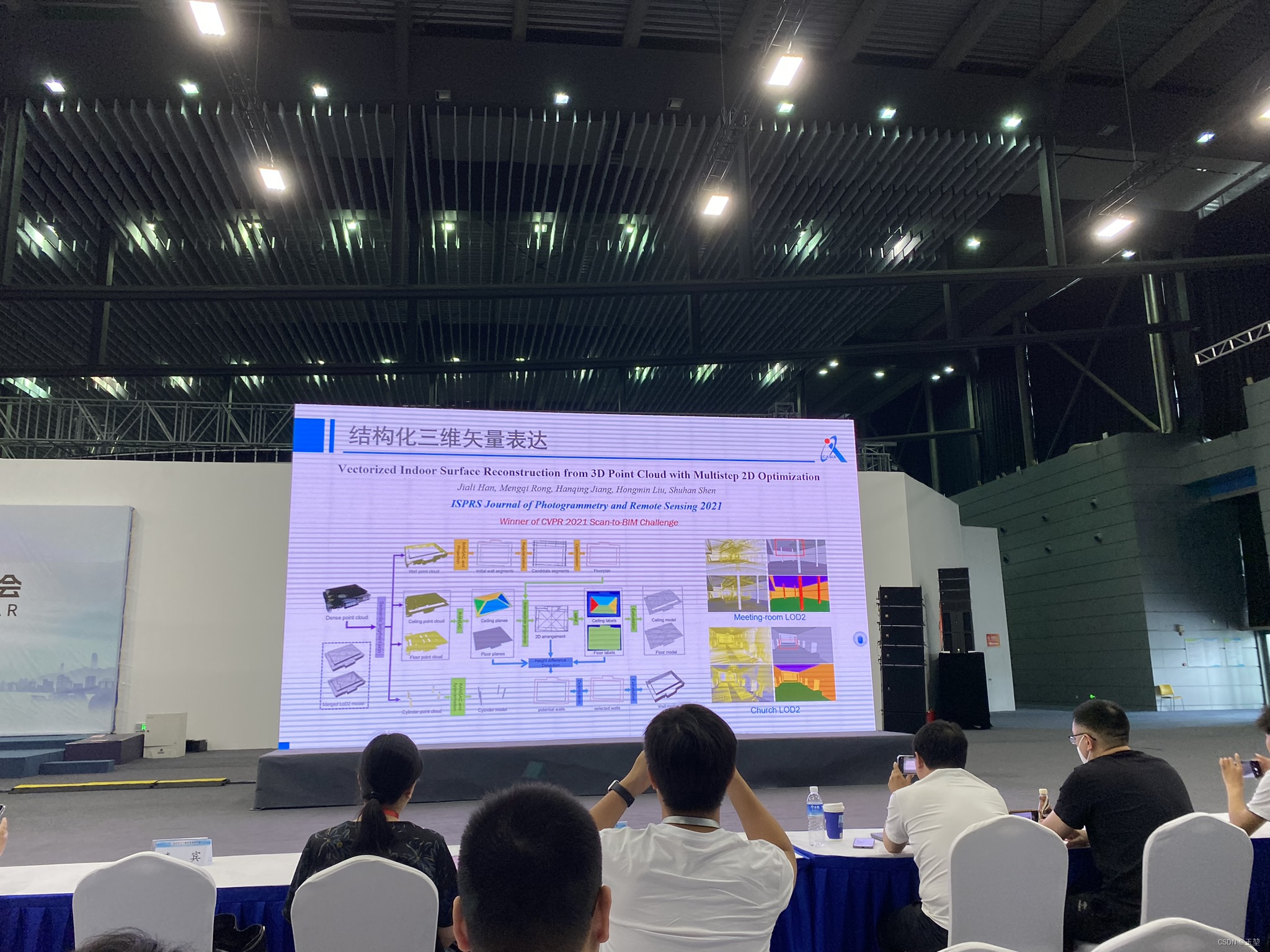

紧接着,就是第四部分“结构化三维矢量表达”。

文章推荐:

[1] J. Han et al., “Urban Scene LOD Vectorized Modeling From Photogrammetry Meshes,” in IEEE Transactions on Image Processing, vol. 30, pp. 7458-7471, 2021, doi: 10.1109/TIP.2021.3106811.

[2] J Han, M Rong, H Jiang, H Liu, S Shen,Vectorized indoor surface reconstruction from 3D point cloud with multistep 2D optimization, ISPRS Journal of Photogrammetry and Remote Sensing,Volume 177,2021,Pages 57-74,ISSN 0924-2716, https://doi.org/10.1016/j.isprsjprs.2021.04.019.

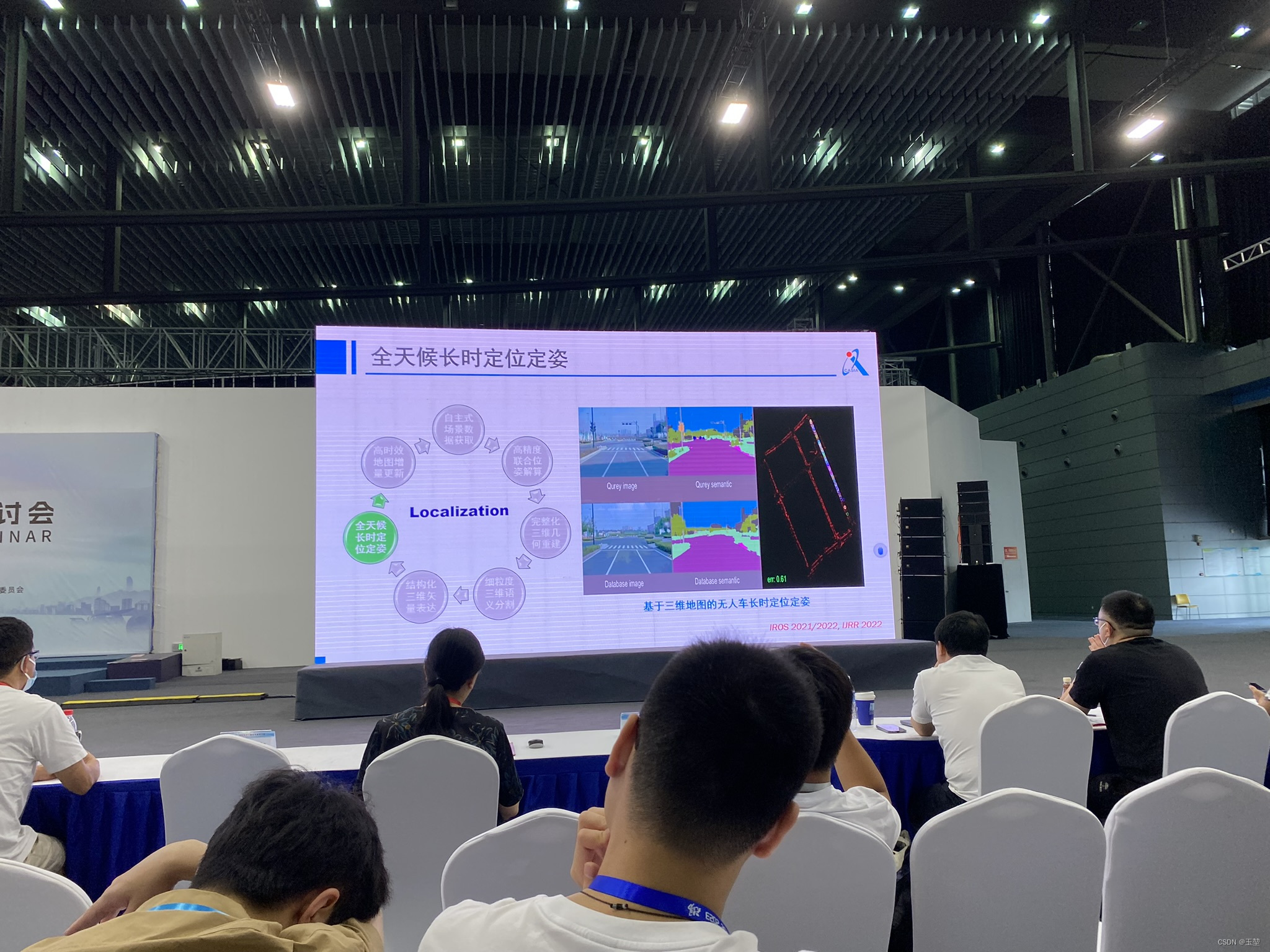

第五部分“全天候长时定位位姿”,第六部分“高时效地图增量更新”,第七部分“自主式场景数据获取”则是没有细讲。

最后,申老师进行简单总结。

至此讲解结束,最后附上申老师的联系方式。

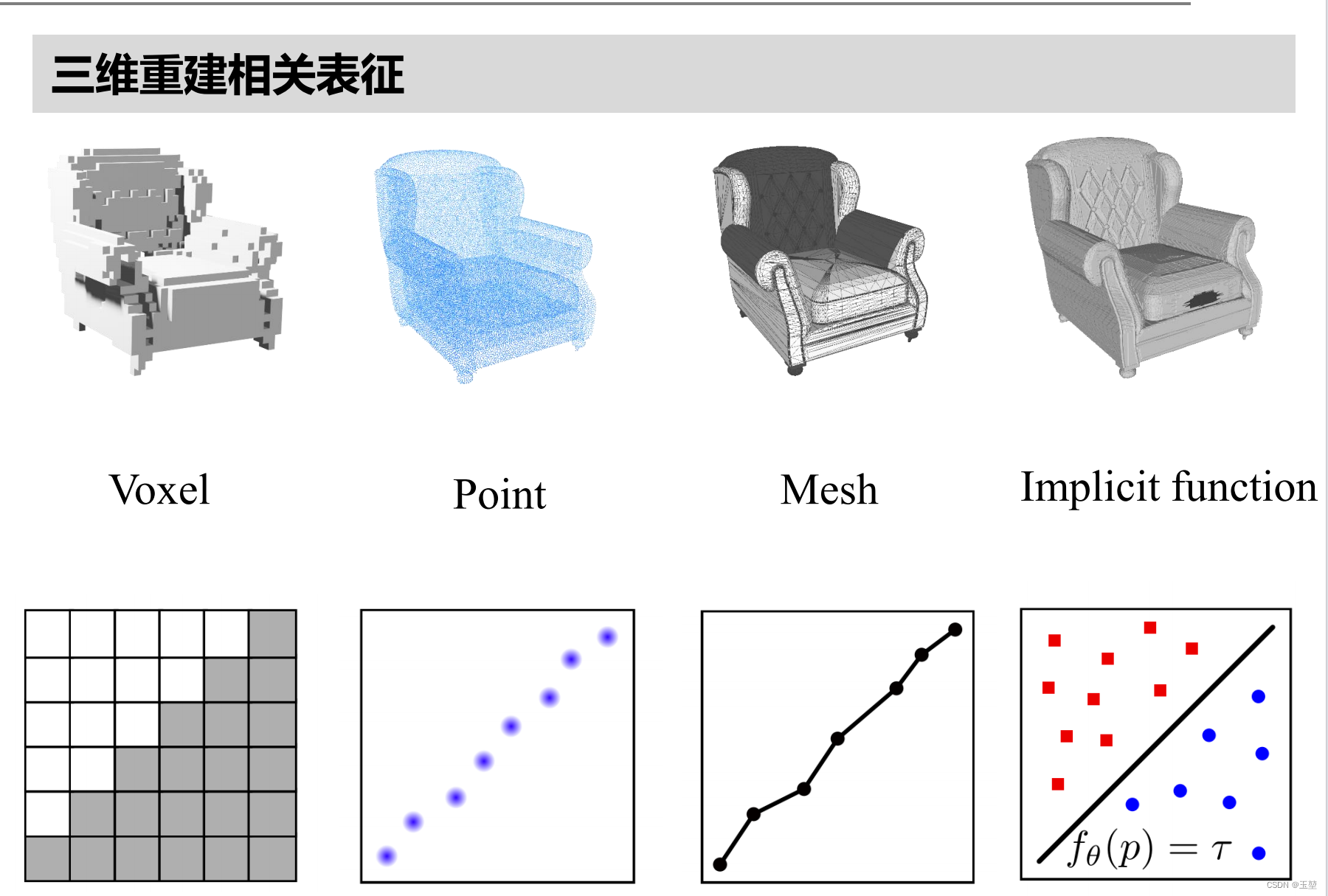

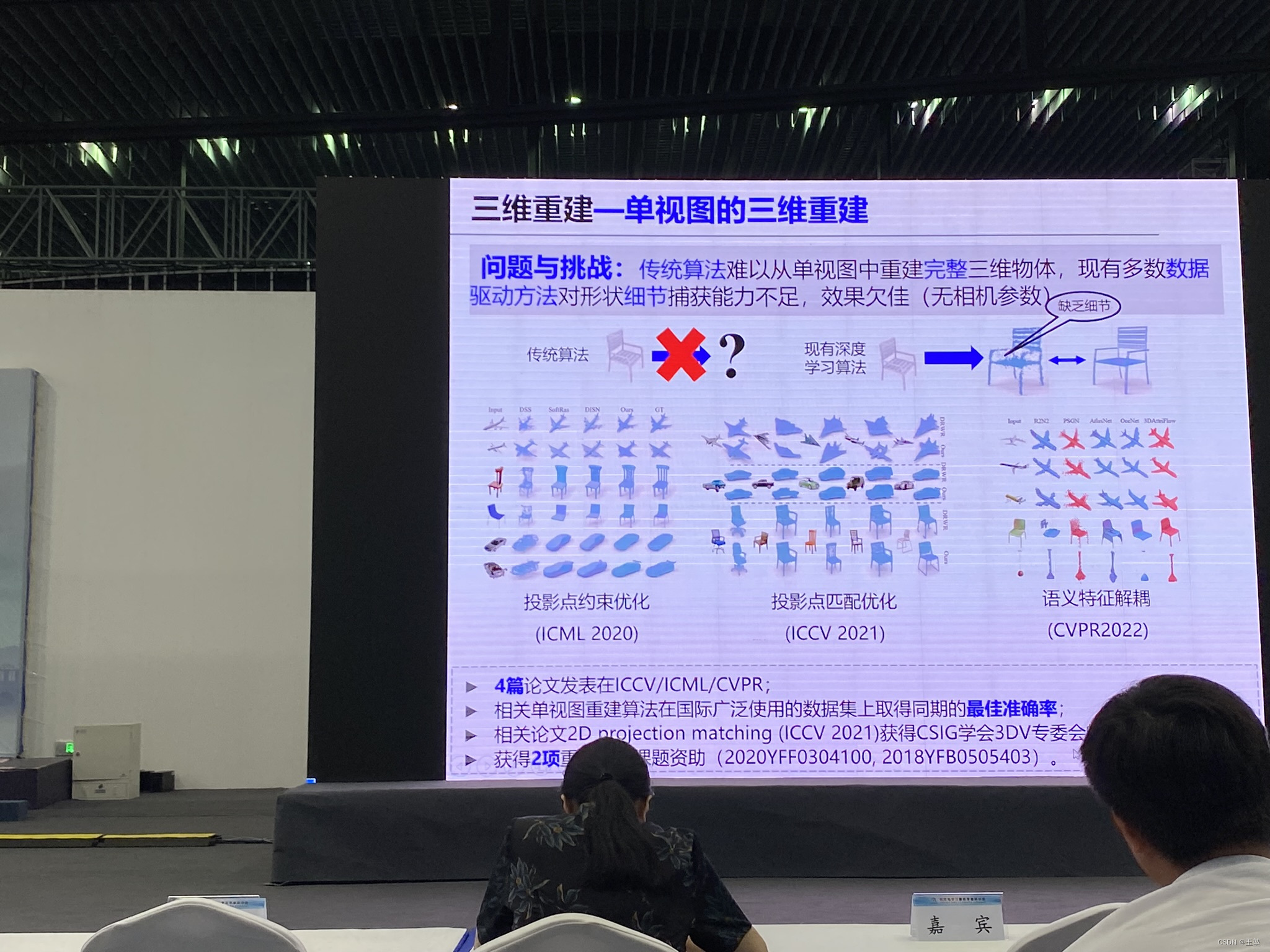

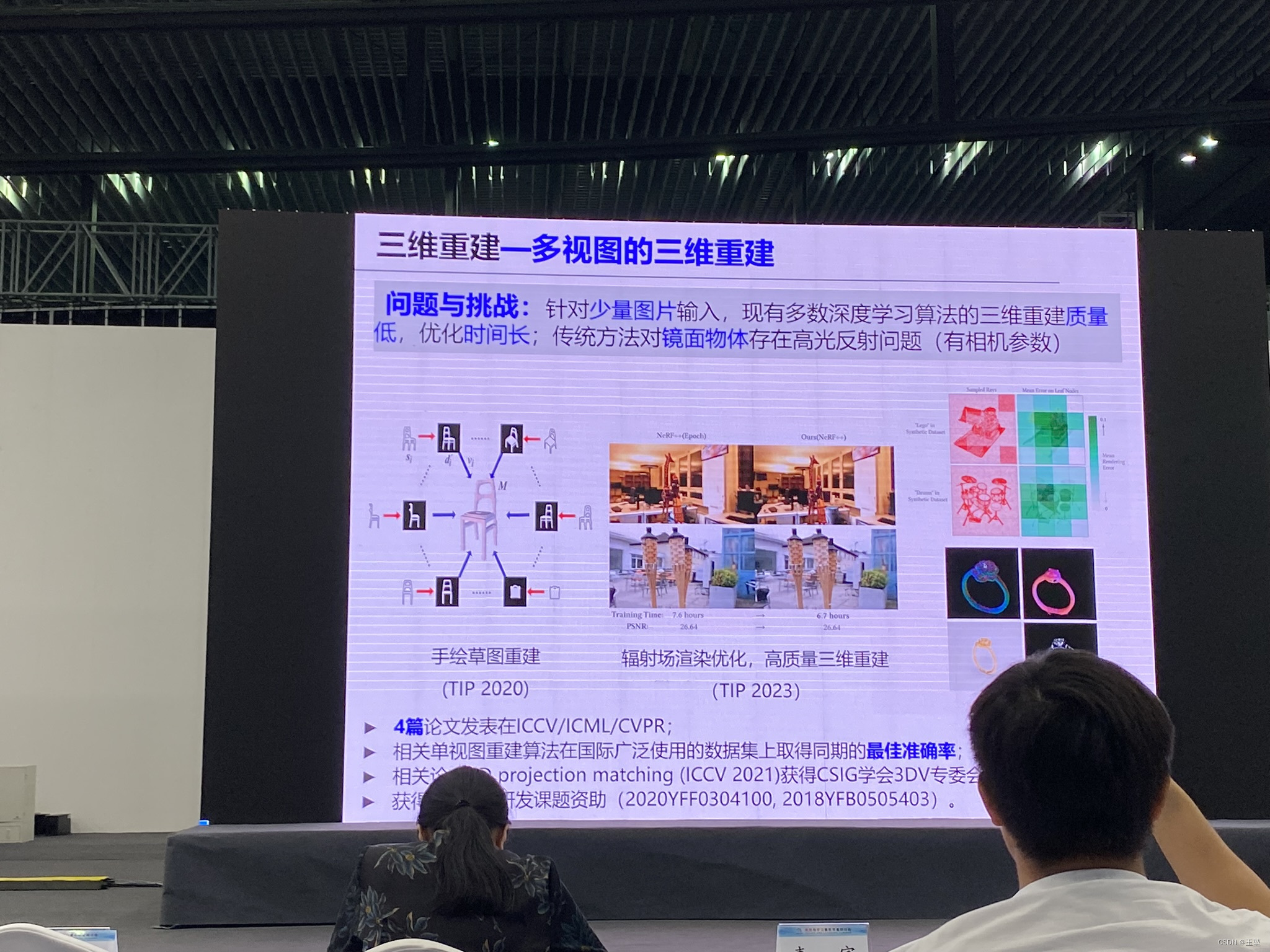

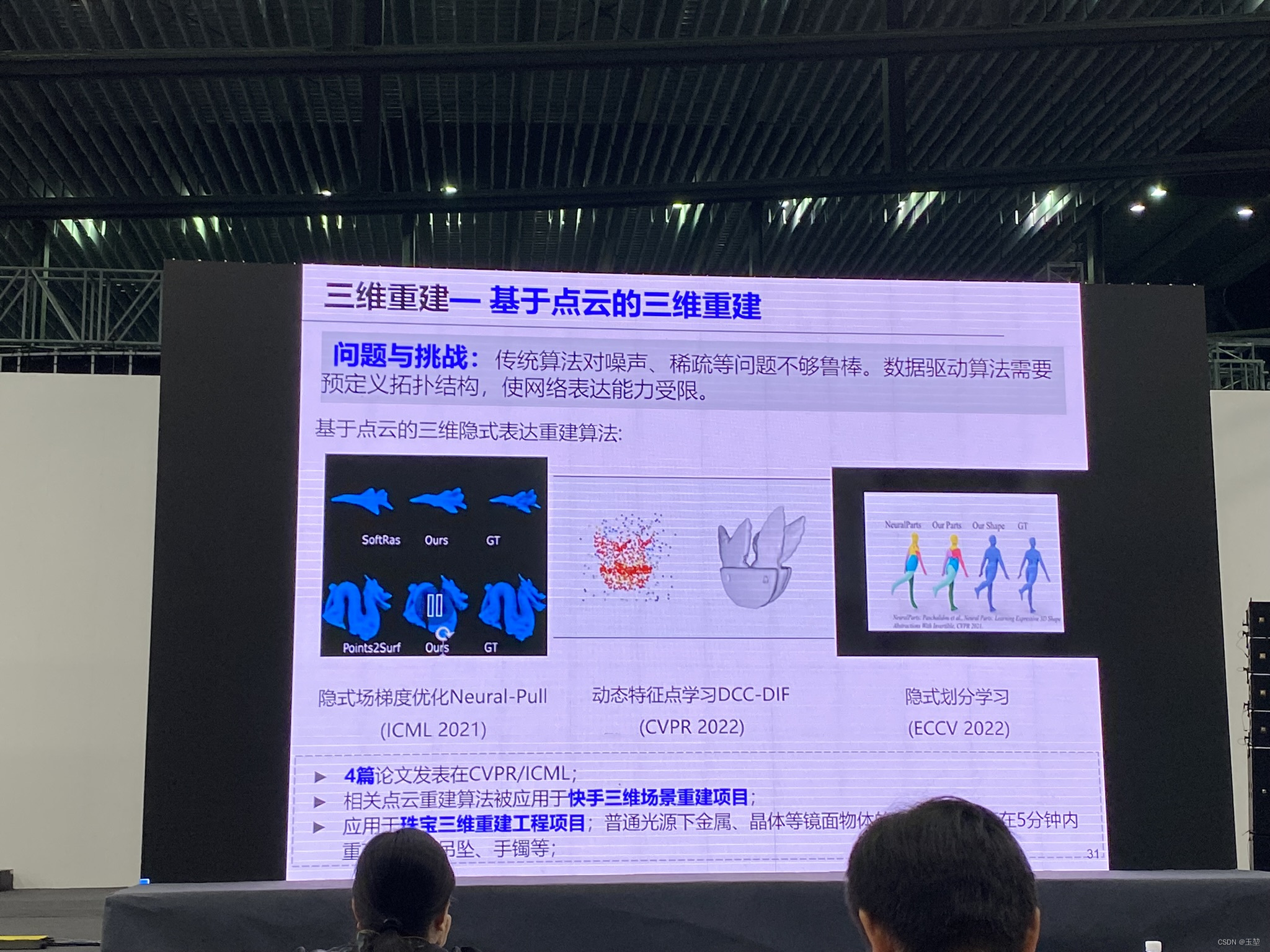

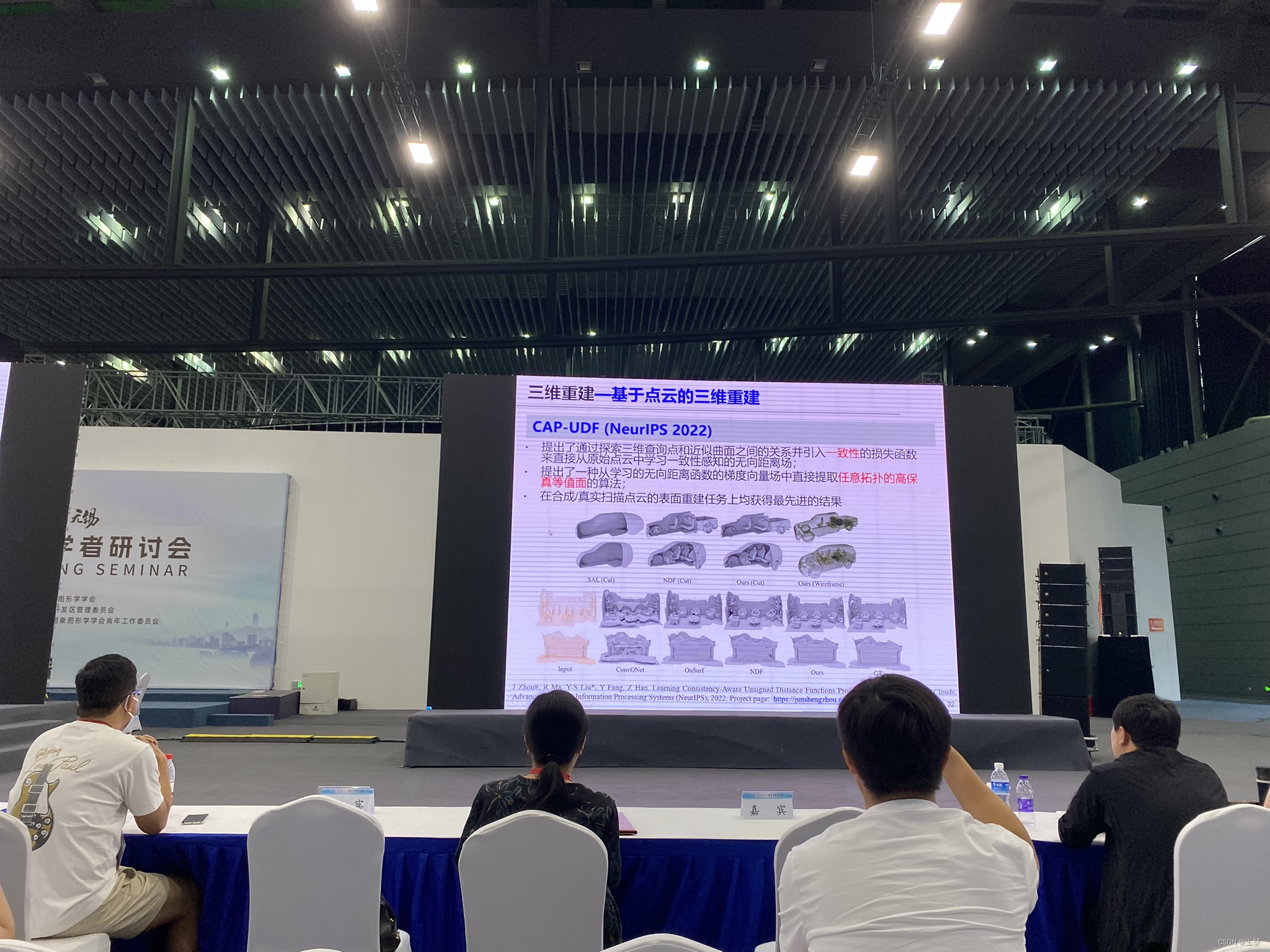

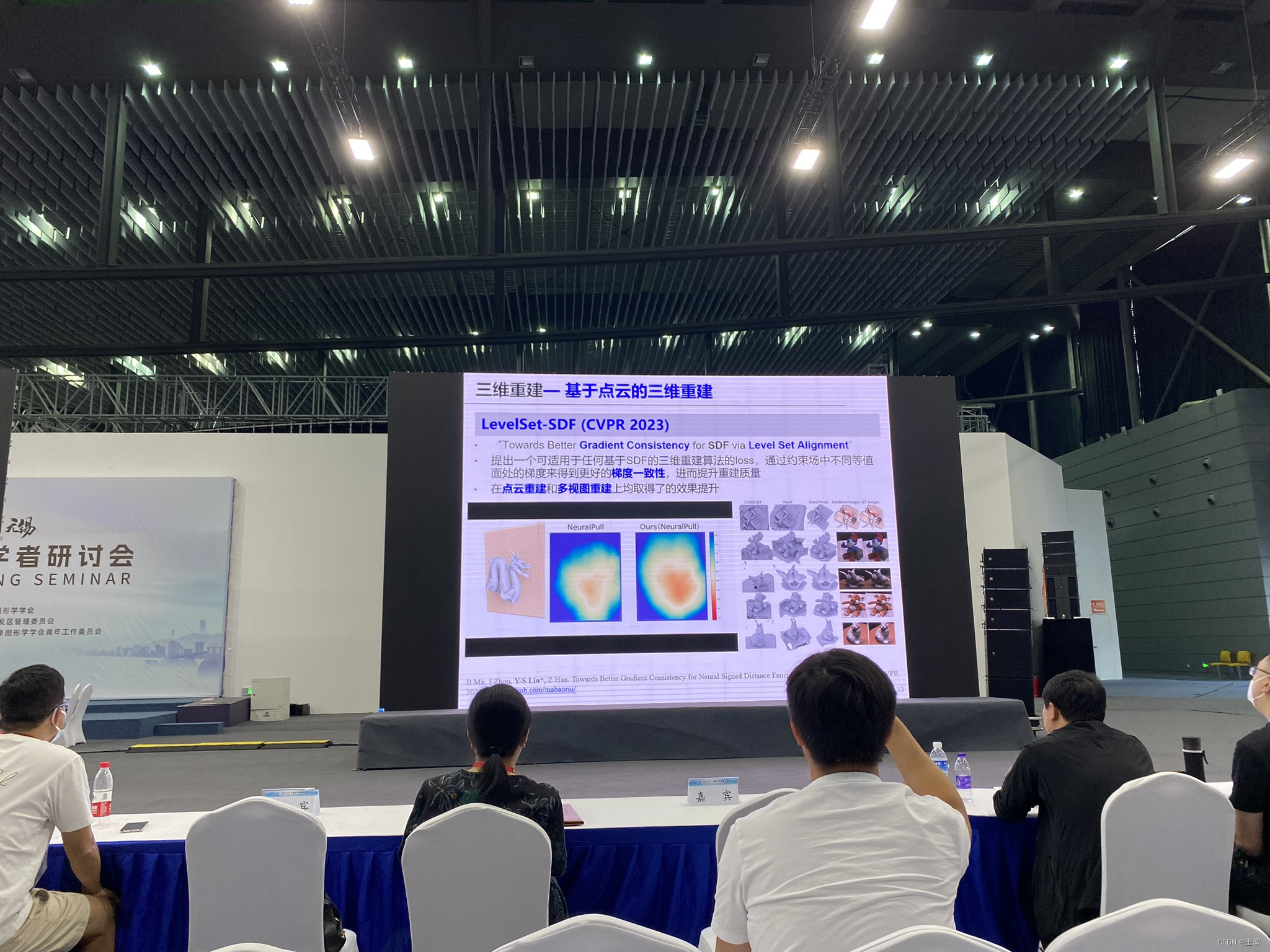

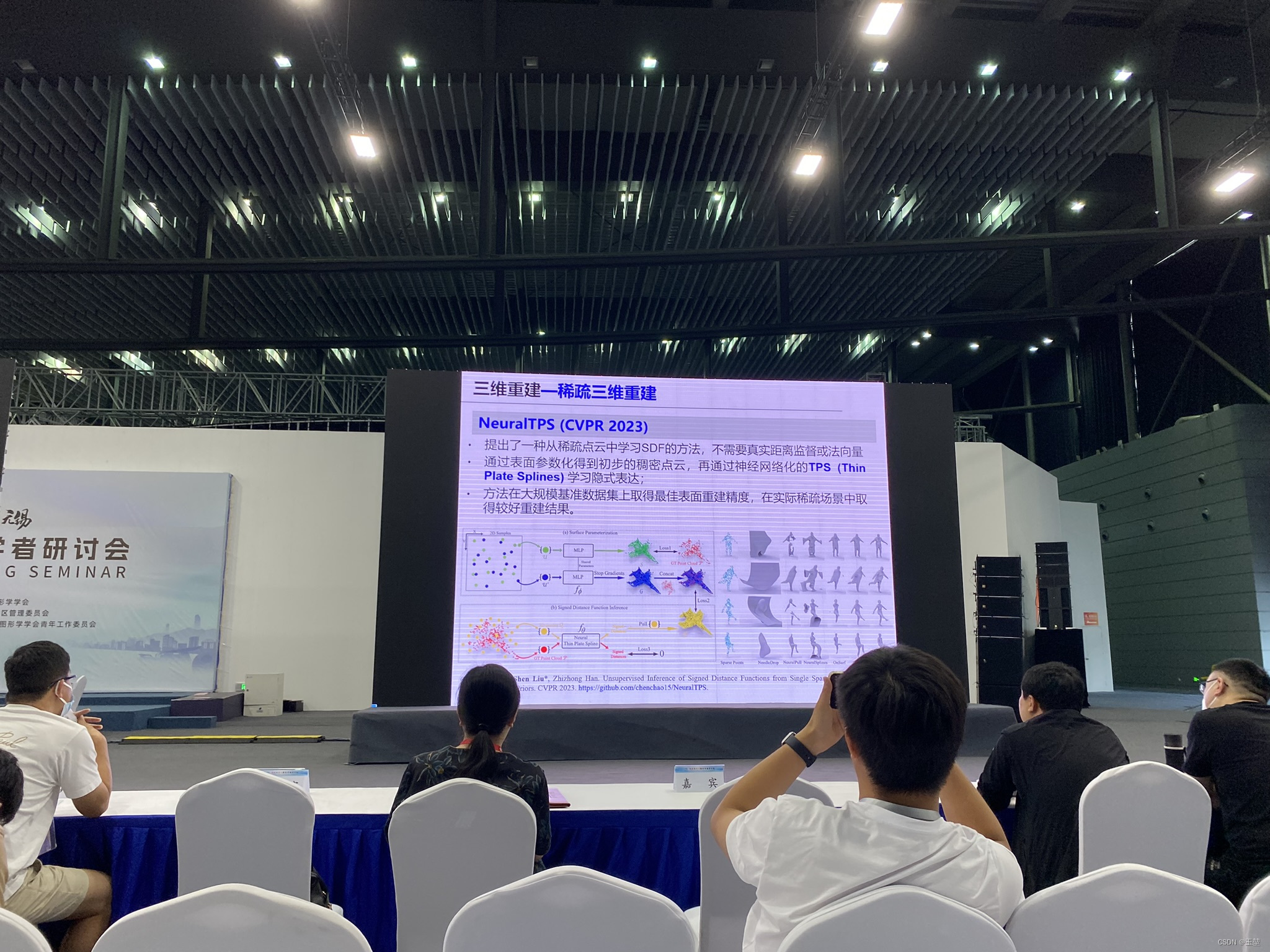

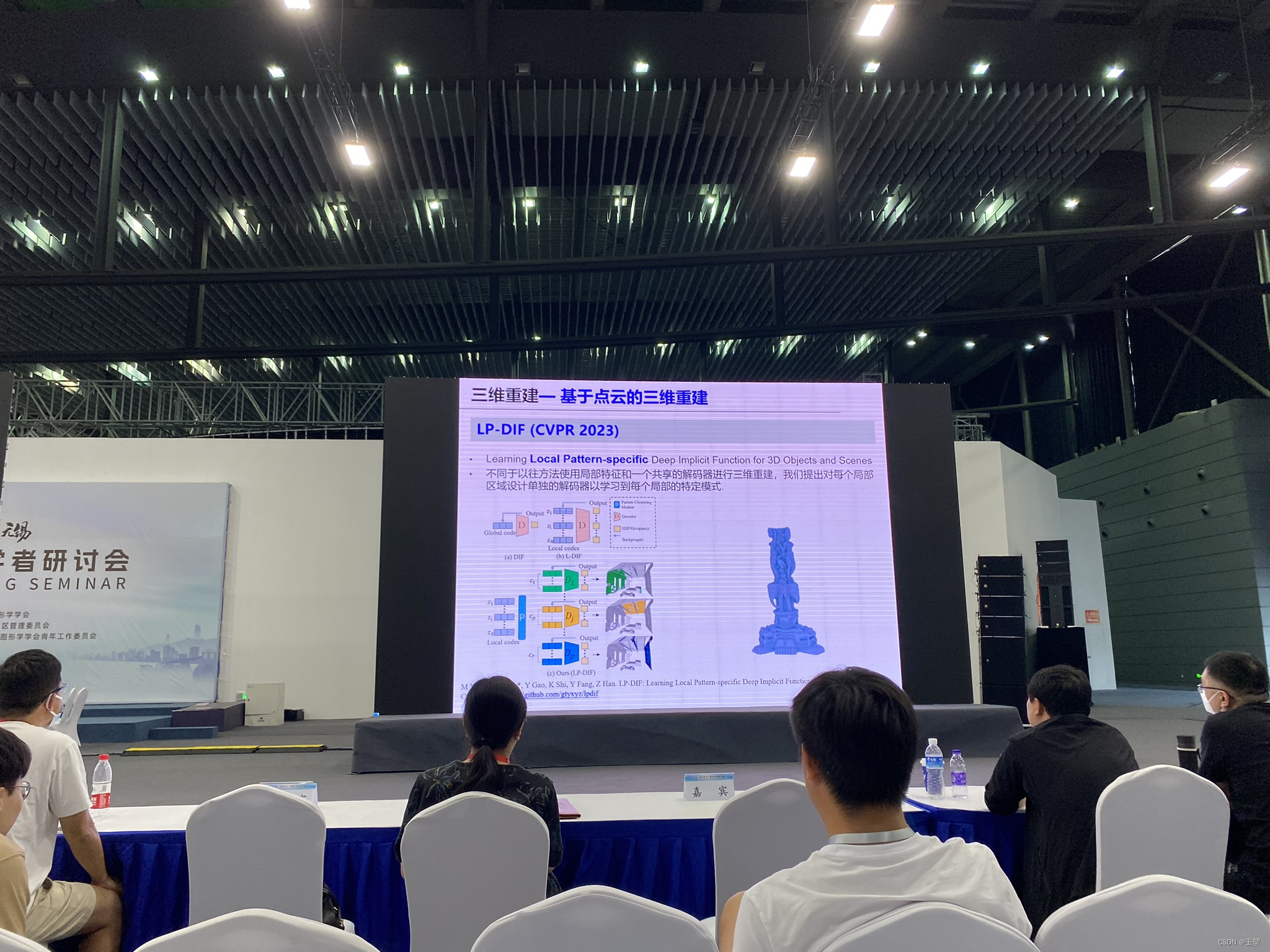

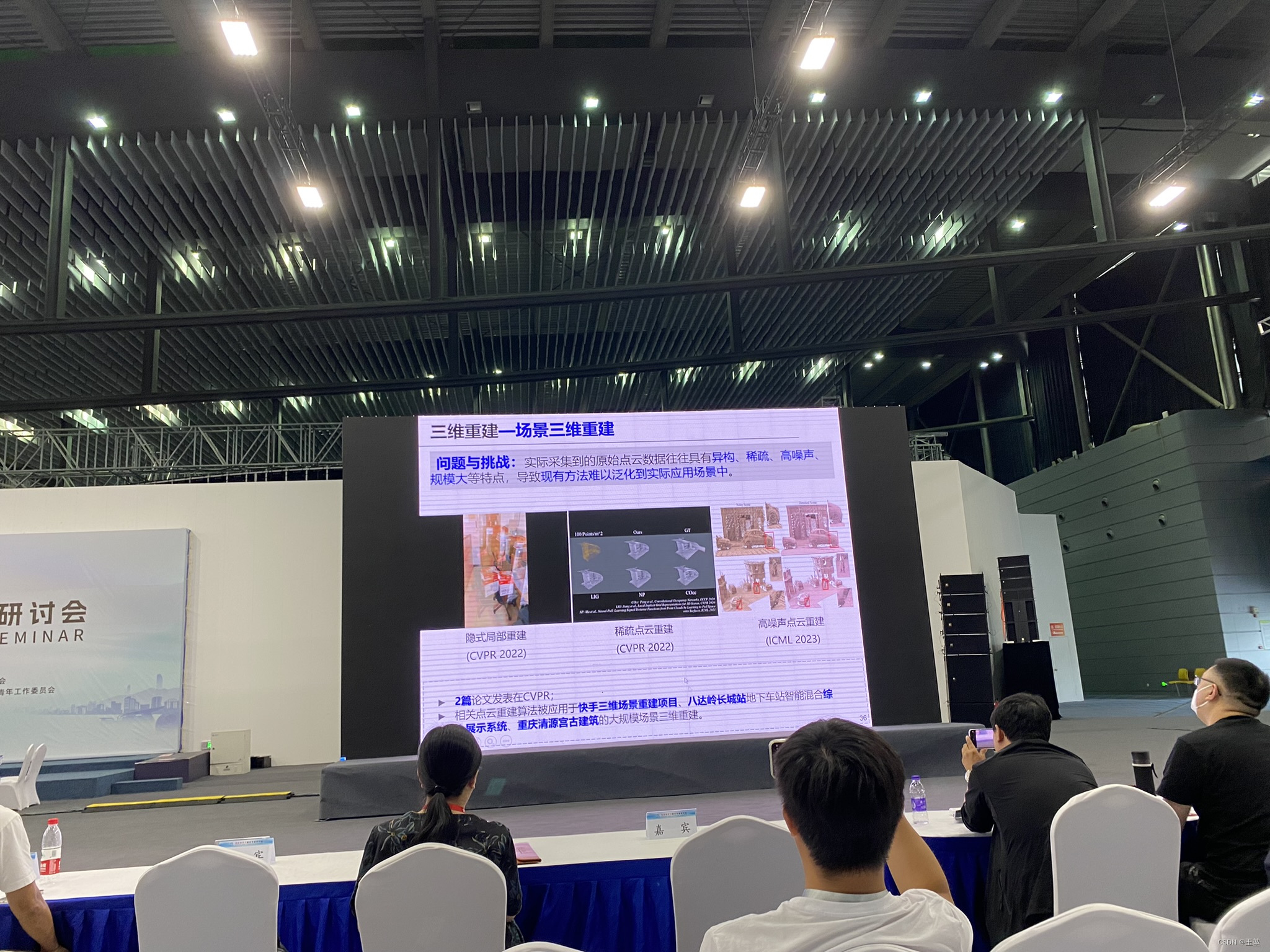

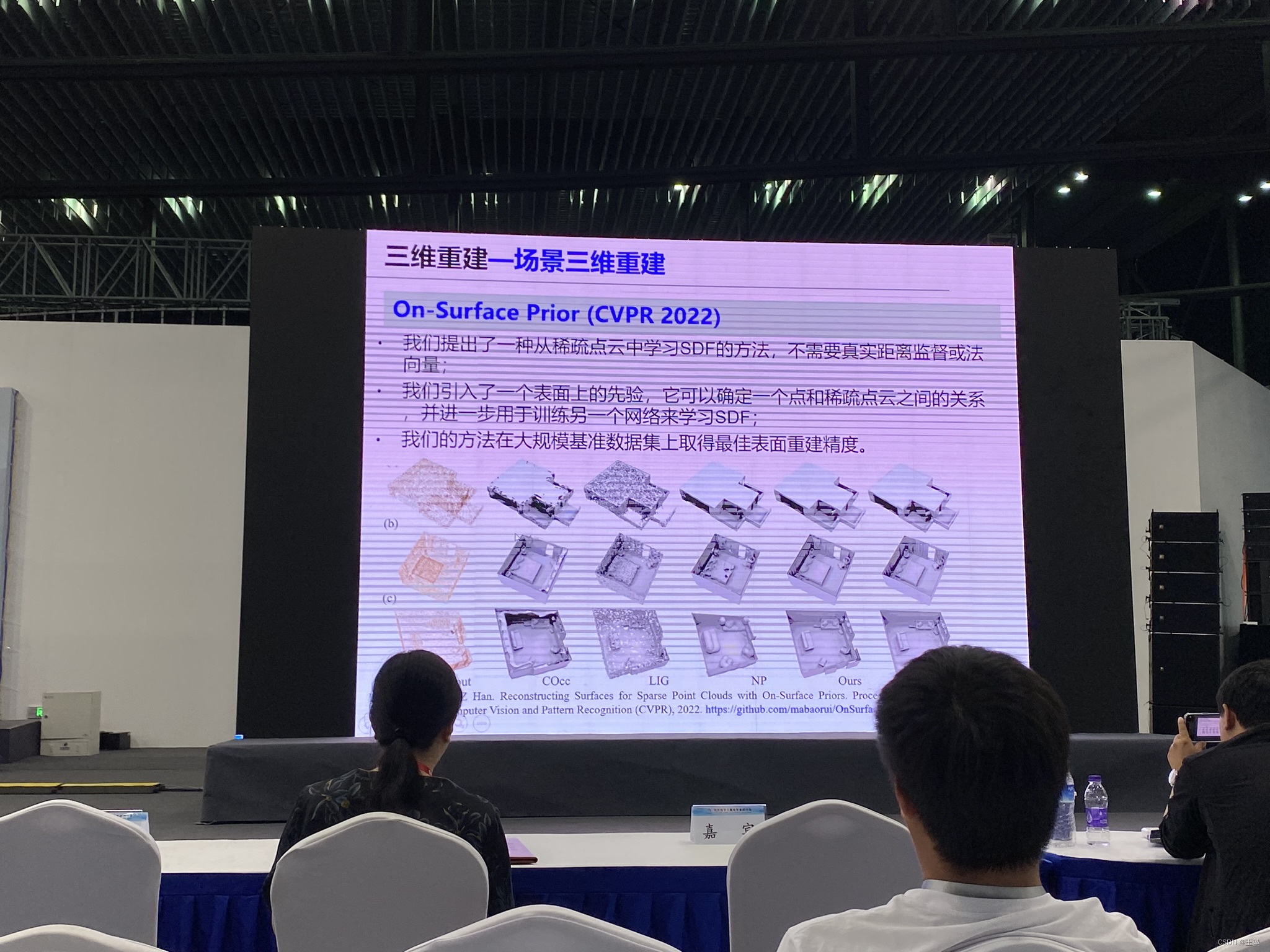

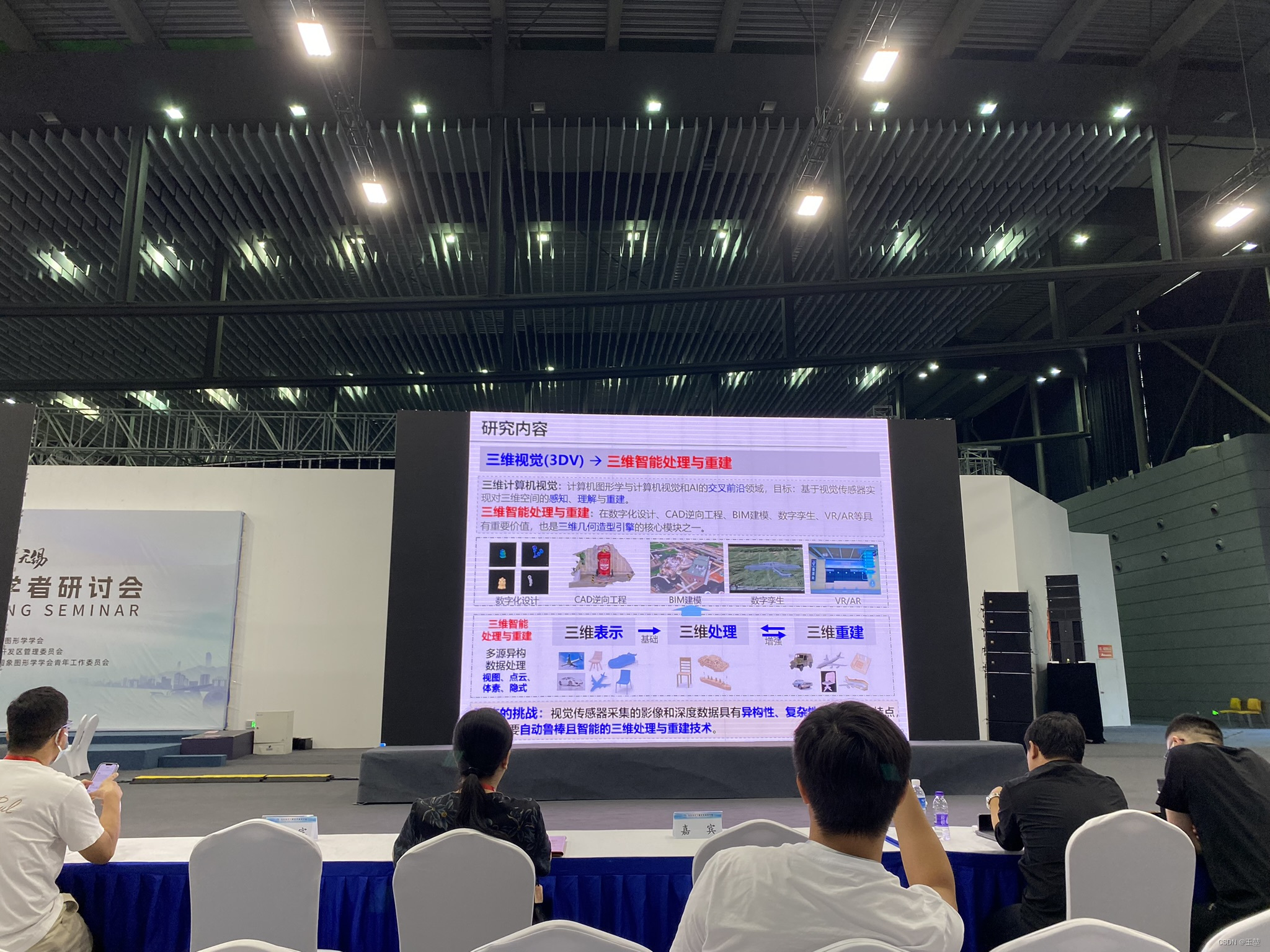

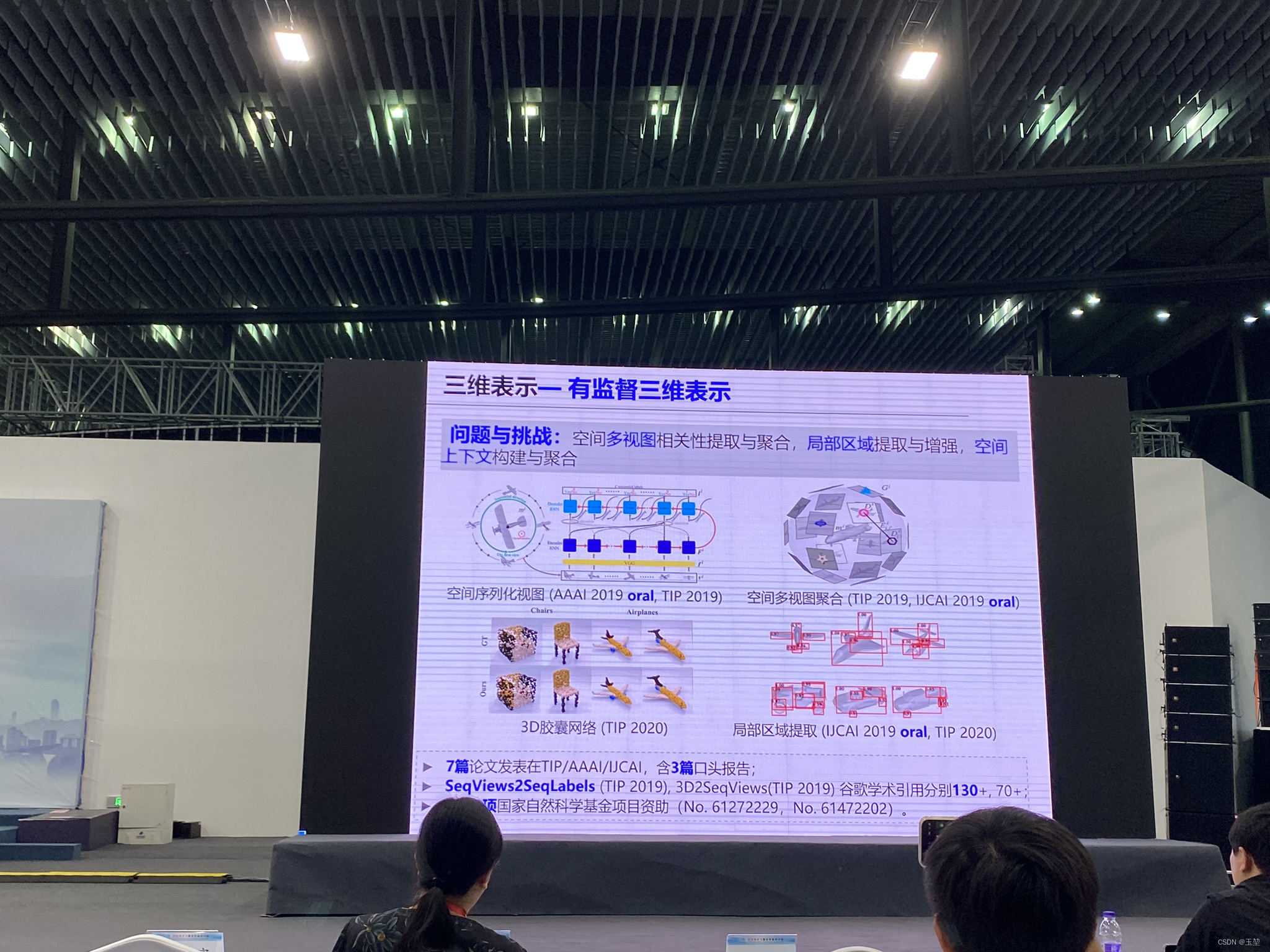

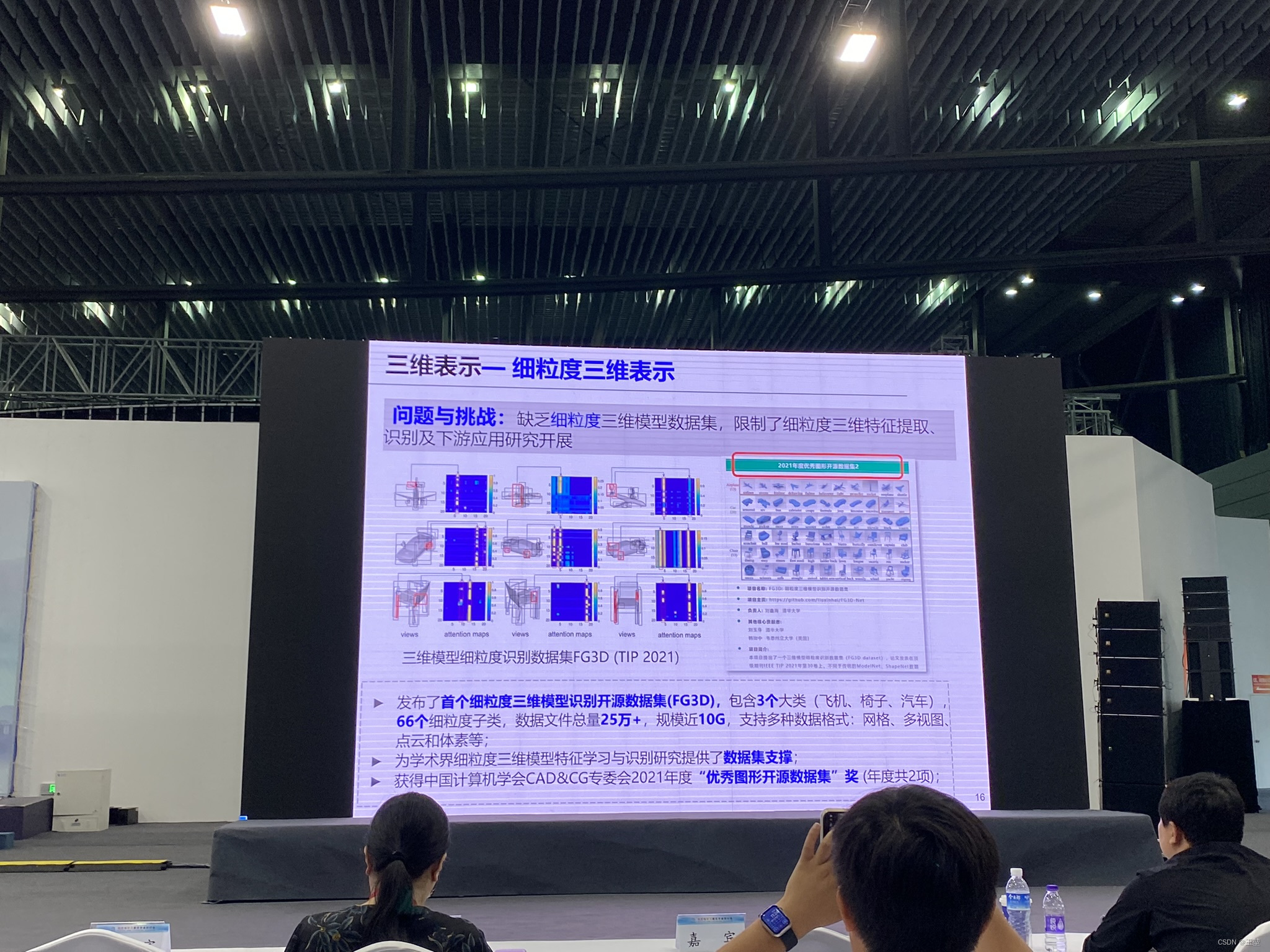

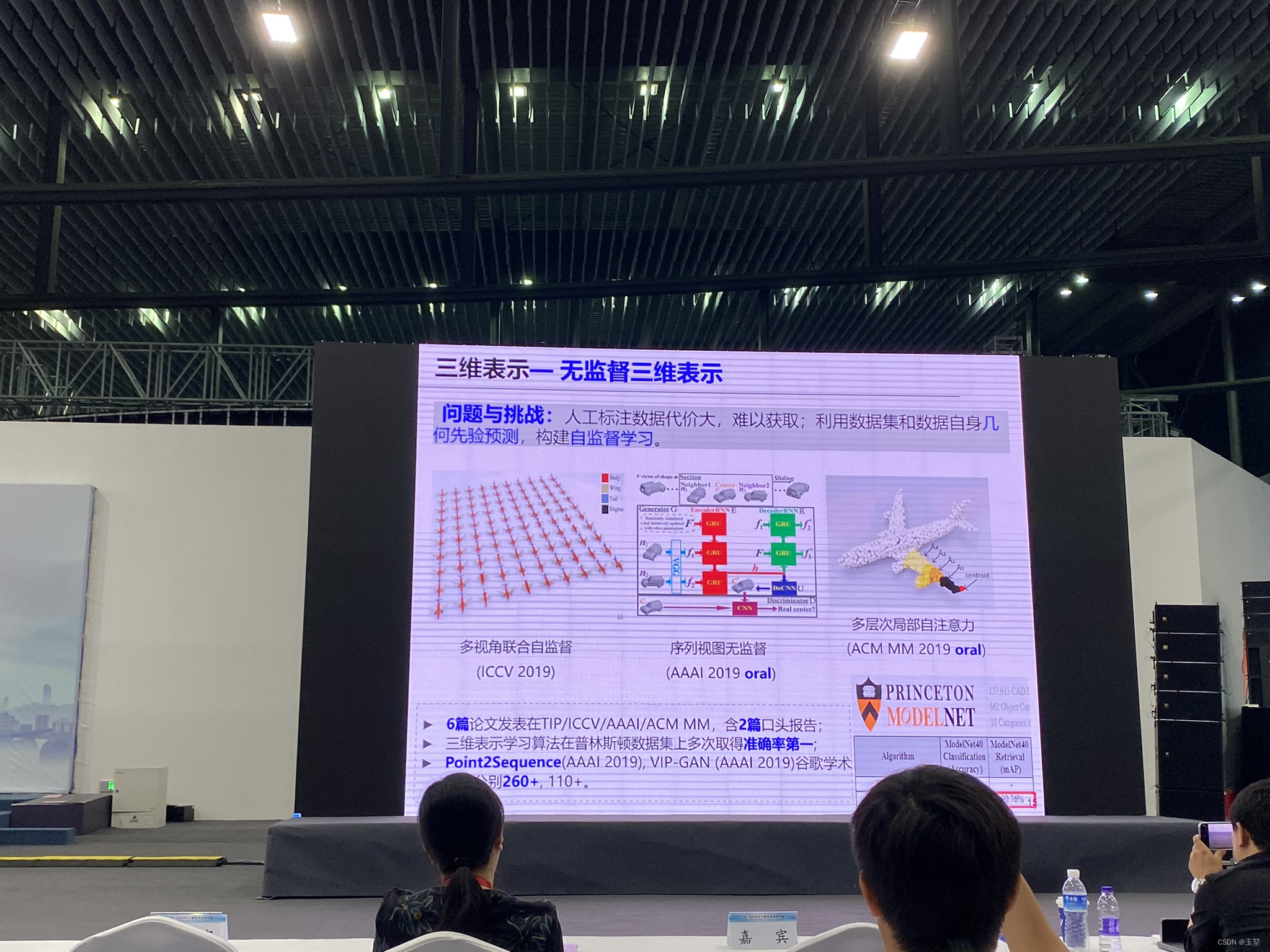

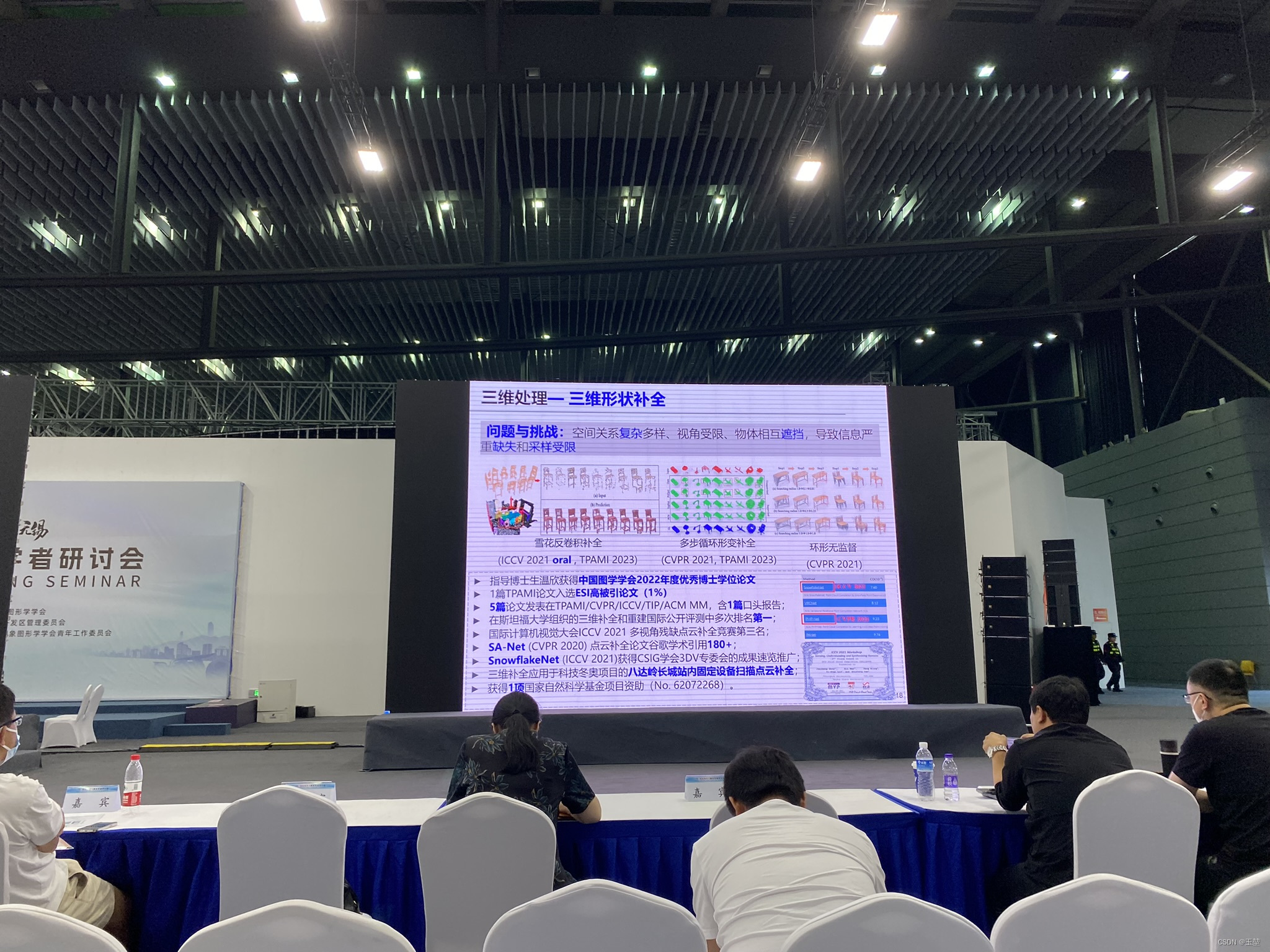

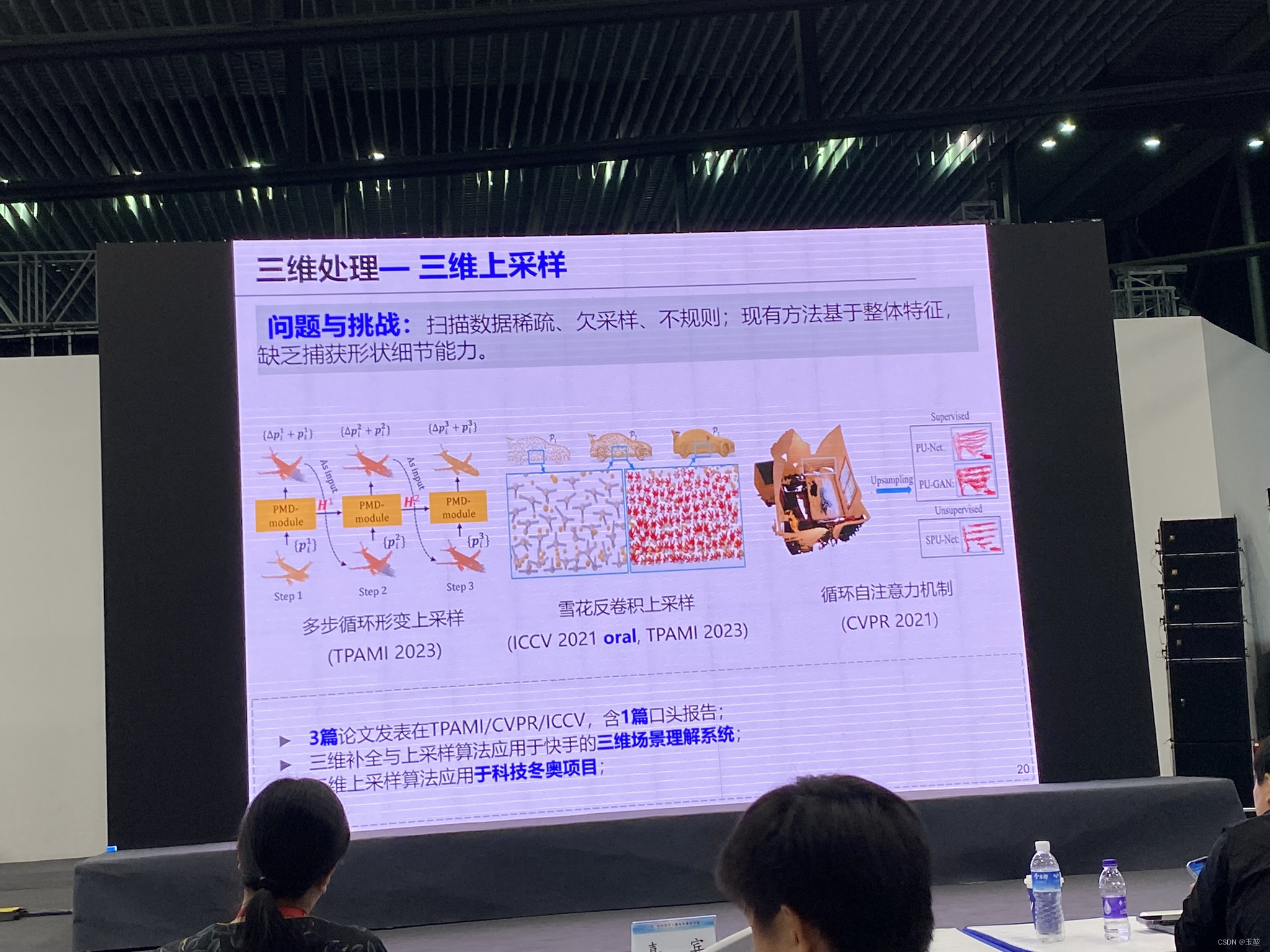

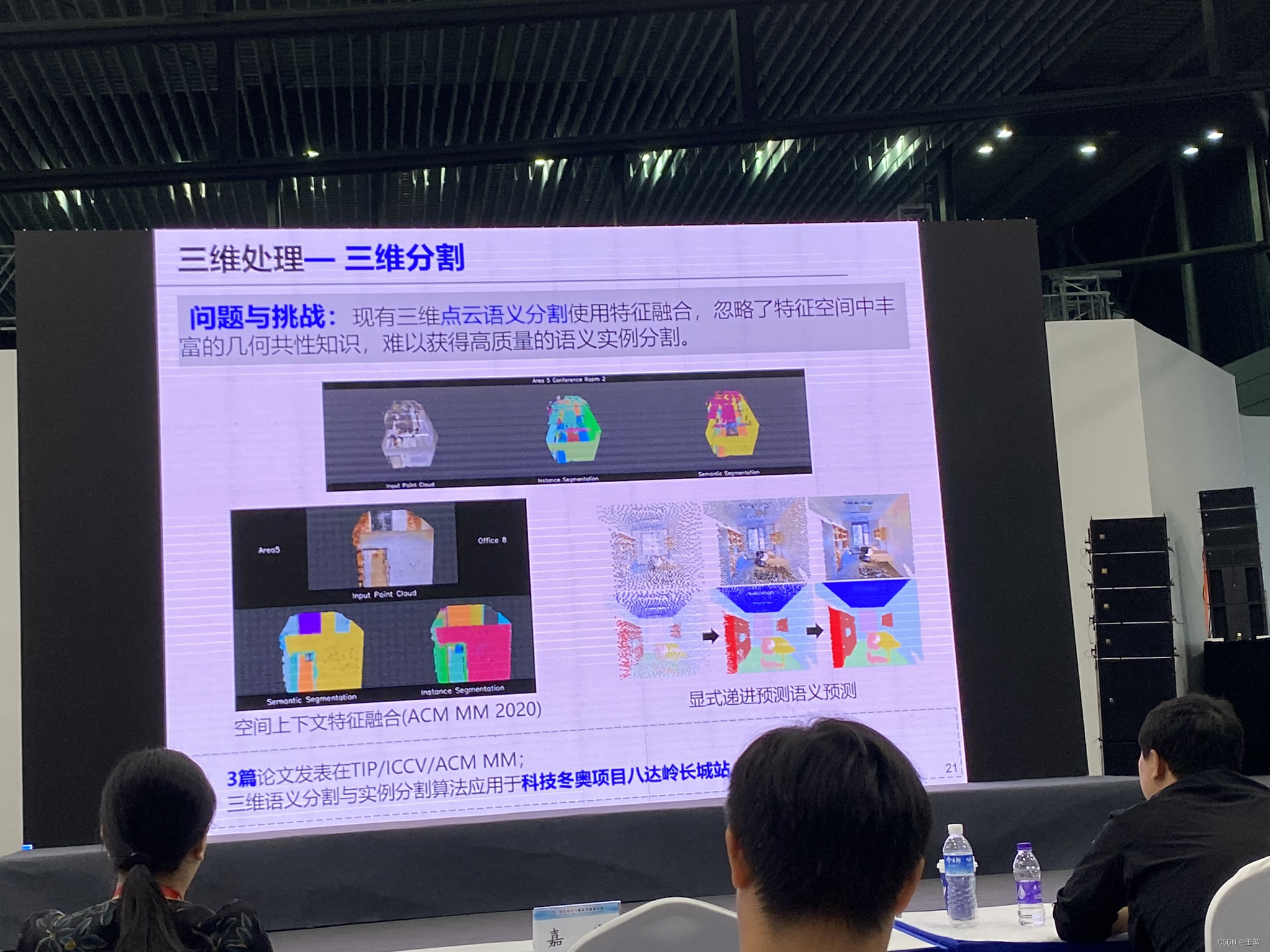

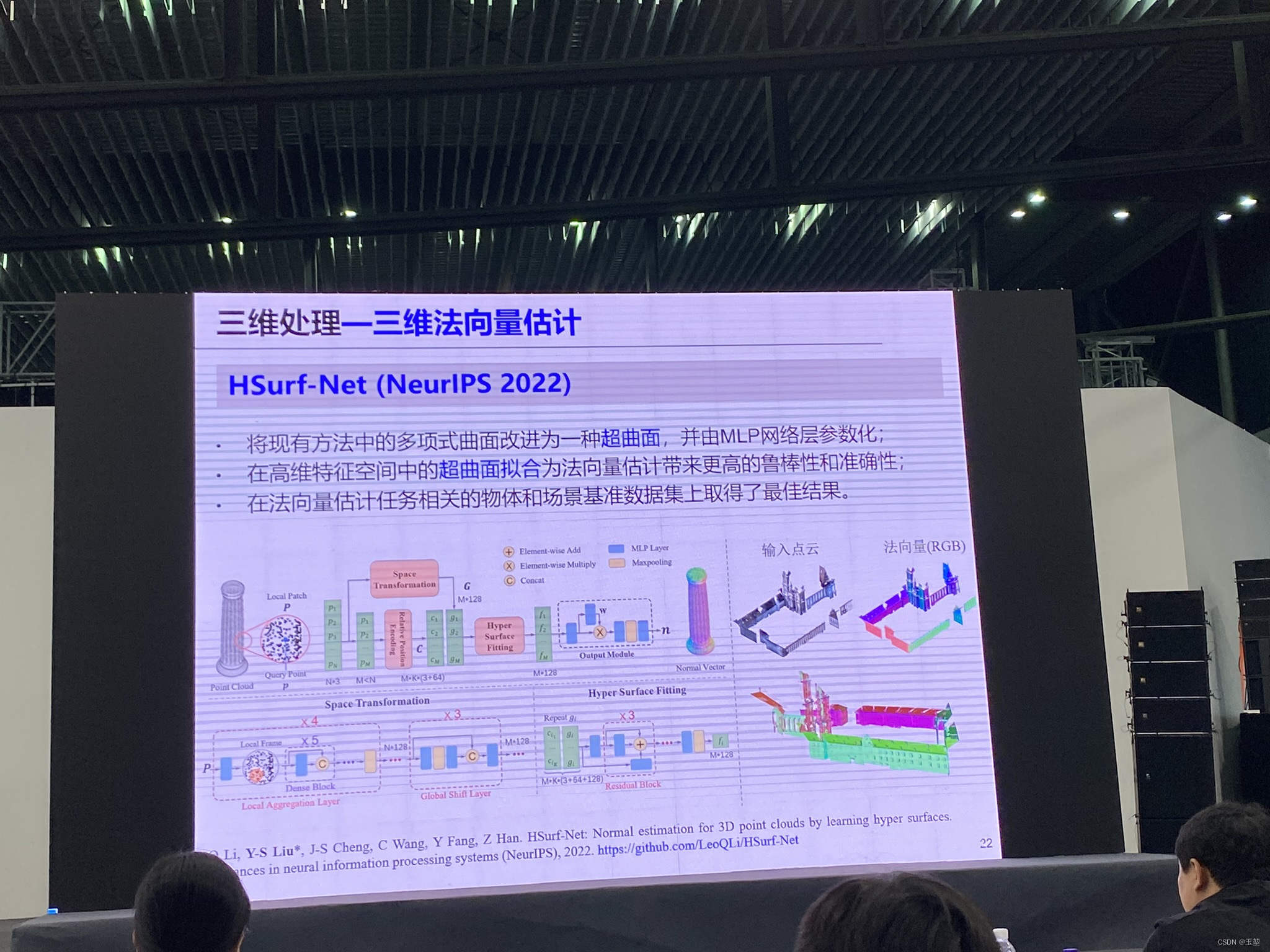

3.3 主题:三维智能处理与重建-刘玉身-清华大学

首先,附上刘老师的联系方式:

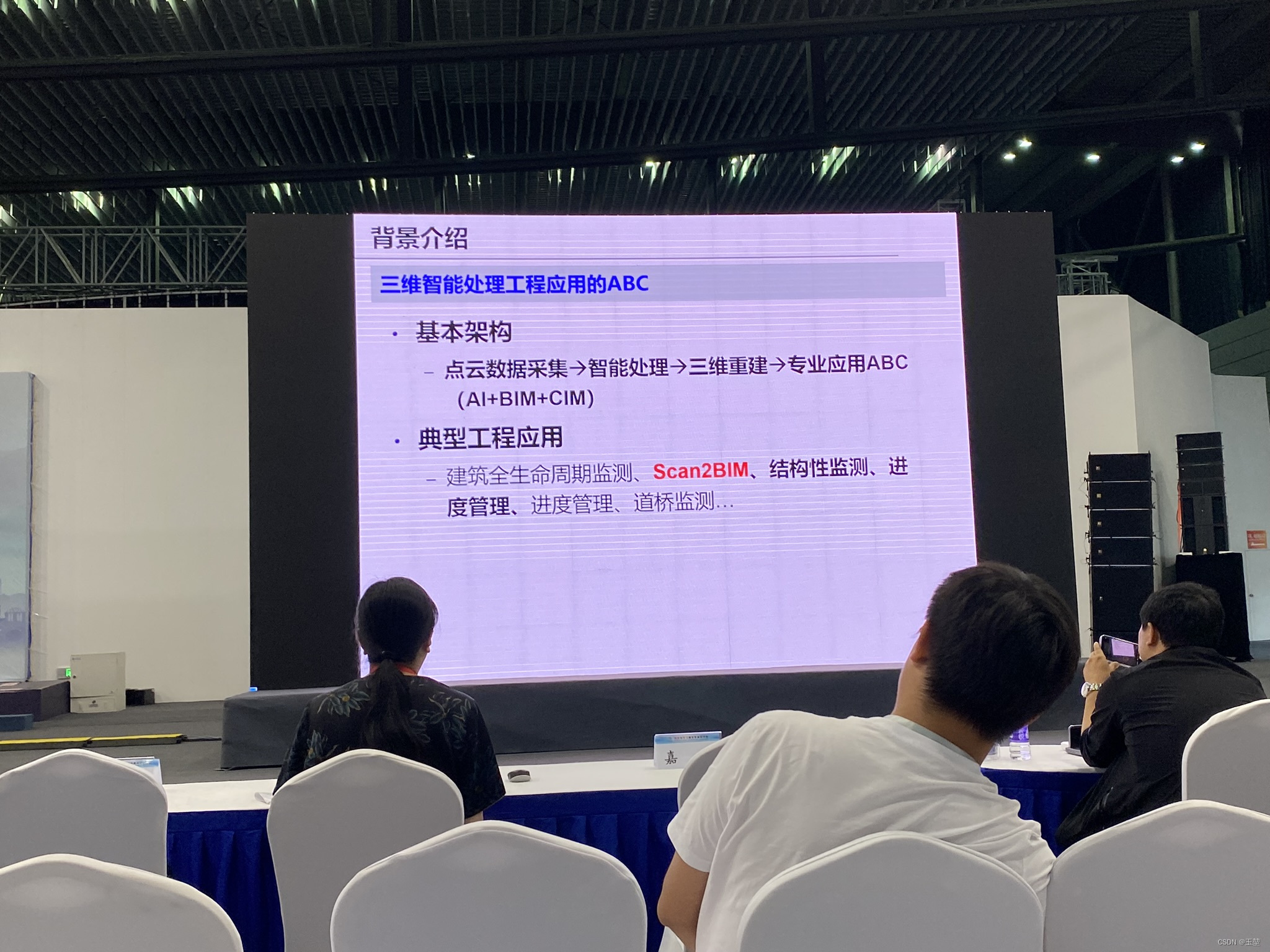

开头的一些背景介绍:

此刻,开始正式内容讲解。刘老师的内容分为三部分:

- 三维表示与识别

-

- 特征表示学习

-

- 大规模三维细粒度数据集

- 三位处理与理解

-

- 三维补全

-

- 三维上采样

-

- 三维分割

- 三维重建

-

- 基于视图的三维重建

-

- 基于点云的三维重建

三维表示方面,可以分为三种有监督,无监督和细粒度。

在三位处理与理解中,分为补全,上采样和分割。

在三维重建中,分为基于视图、基于点云和场景。