文章地址:https://arxiv.org/pdf/2310.03589.pdf

近期美国的一家公司Nixtla提出了业界首个时序基础模型TimeGPT,并开放了相关模型的API(https://docs.nixtla.io/)供大家体验。TimeGPT号称使用了来自金融、气象、能源、网络数据等多个领域超过1000亿个数据点进行训练,同时允许使用者利用自己的数据对其进行微调,最终支撑各类预测及异常检测任务,并号称是第一个始终能够以最小的复杂性超越其他选择的基础模型。今天就让我们一起来看看。

相比于NLP和CV领域,基于深度学习的时序基础模型的发展一直有些“磕磕绊绊”,这或许可以归咎于以下的一些原因。

1)不明确或不成熟的评估机制:不同于其他领域具有大规模的训练及测试数据集,如ImageNet及各类NLP语料数据集,目前并没有大规模标准化的公开时间序列数据集。2)次优模型:基于有限且简单的数据集,即使是优秀的深度学习架构也可能在泛化上遇到困难,或甚至出现过拟合,以及耗费大量时间寻找最优参数设置。3)不同领域的时间序列具有很强的异构性,如变量维度、采样频率、稀疏性、趋势、季节性、平稳性和异方差性等等为建模带来了很大的挑战。

通常我们提到基础模型,也会提到其优秀的跨领域泛化的能力,特别是在训练期间不可见的新数据集中。这是需要大量数据集来支撑模型训练的,因此这篇论文中,作者利用来大规模数据集训练时序基础模型,并证明了更大、更多样化的数据集能够使更复杂的模型在各种任务中表现更好。

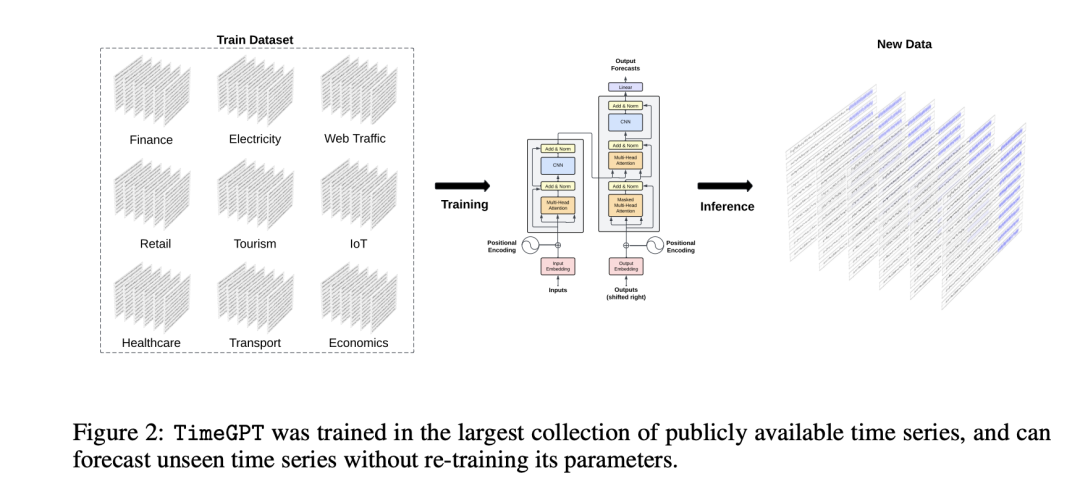

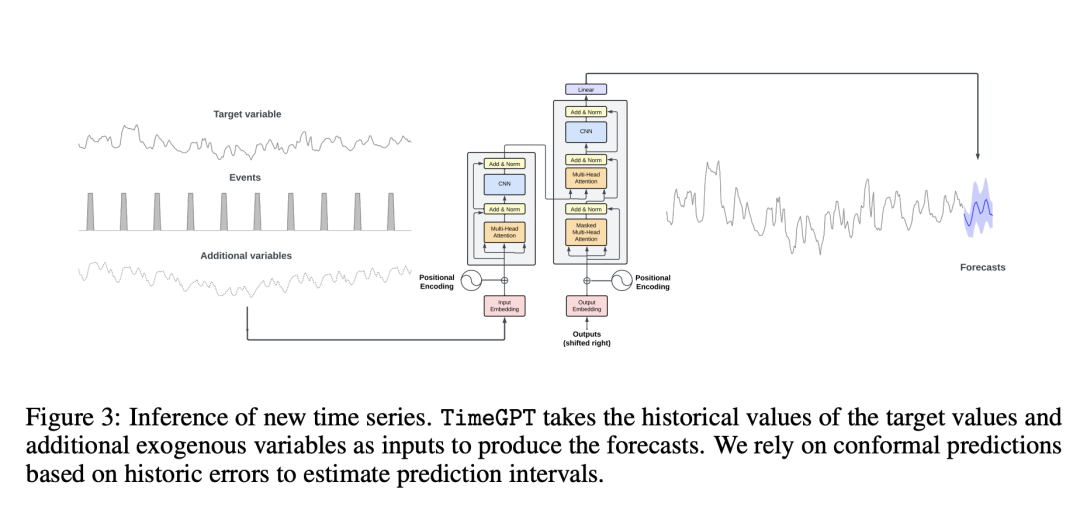

关于具体的架构,文章介绍得非常简单。TimeGPT仍采用基于Transformer的模型架构(Vaswani et al., Attention is all you need 2017),以一定窗口的历史数据为输入,添加位置编码来帮助捕捉时序信息,通过编码器-解码器后,利用一个线性层将解码器输出映射至预测窗口为度,并最终在大规模数据集上训练来最小化预测误差。而对于TimeGPT如何克服不同的数据维度、采样频率、周期性等问题,文章仅一句带过,并没有公布细节。

关于具体的架构,文章介绍得非常简单。TimeGPT仍采用基于Transformer的模型架构(Vaswani et al., Attention is all you need 2017),以一定窗口的历史数据为输入,添加位置编码来帮助捕捉时序信息,通过编码器-解码器后,利用一个线性层将解码器输出映射至预测窗口为度,并最终在大规模数据集上训练来最小化预测误差。而对于TimeGPT如何克服不同的数据维度、采样频率、周期性等问题,文章仅一句带过,并没有公布细节。

至于训练所用数据集,据文章所提TimeGPT是在迄今为止最大的公开可用时间序列集合上训练的,总共包含超过1000亿个数据点(目前数据集并没有公开)。这个训练集包含了来自广泛领域的时间序列,包括金融、经济、人口统计、医疗保健、天气、物联网传感器数据、能源、网站流量、销售、交通和银行业务。训练数据集包含有不同周期性、不同长度和各种趋势的序列。同时,数据集中包含一定的噪声和异常点以保证模型的鲁棒性和泛化性能。文章还提到模型未对序列数据做特殊处理,仅进行了标准化标准化和填补缺失值以确保数据的完整性(小编还是挺好奇的,之前一直被如何处理不同维度和长度的数据所困扰,能想到的只能是将均看作单序列并处理成patch送入模型)。

TimeGPT是在NVIDIA A10G GPU集群上训练的,使用了带有学习率衰减策略的Adam优化器。作者提到在训练过程中使用更大的批次和较小的学习率能获得更好的效果。

同时,作者提出TimeGPT能够实现概率预测且不需要对数据分布进行任何假设,即估计出模型对预测的不确定性,可以给出指定精度下的预测值可能存在的区间(可以理解为指定精度下的正态分布置信区间)。与传统方法不同,共形预测不需要严格的分布假设,这使它更加灵活,且对模型或时间序列领域是不可知的。在对新时间序列进行推断时,我们对最新可用数据执行滚动预测,以估计模型在预测特定目标时间序列时的误差。

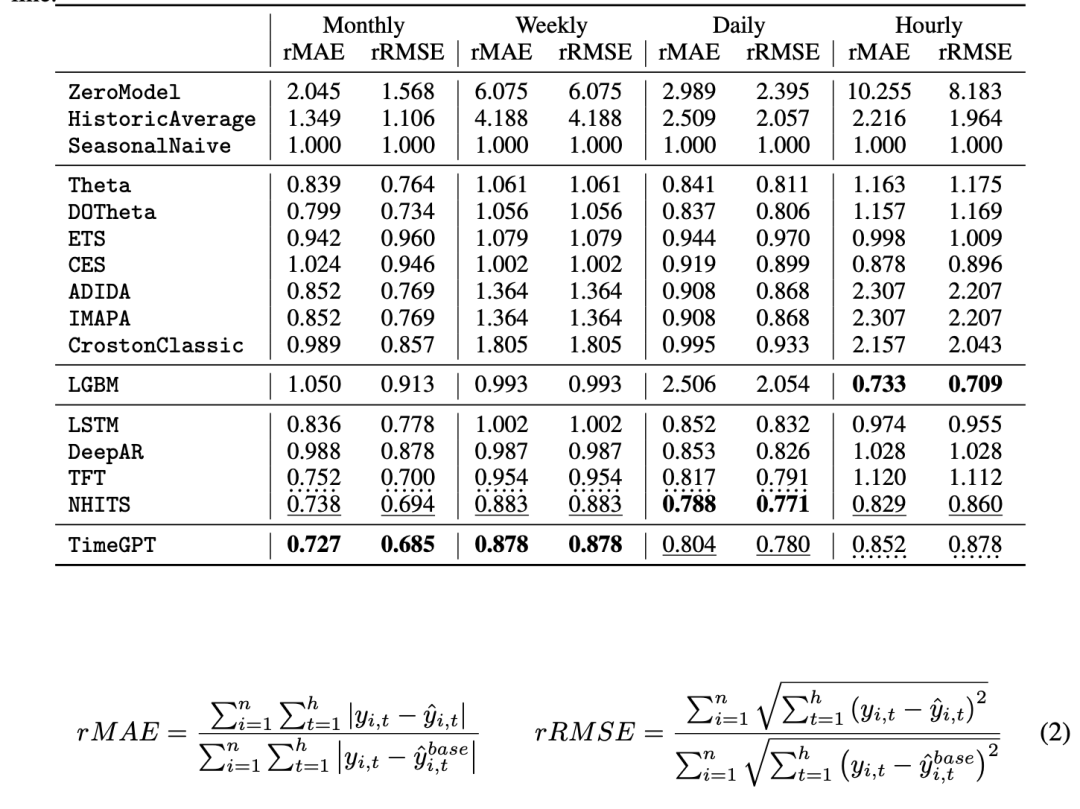

在实验部分,文章采用了来自多个领域的超过30万个时间序列作为测试集,同时根据频率指定不同的预测窗口,以模拟实际应用。下图是一些数据集上的测试效果,采用rmse和rmae作为评测指标。

推荐阅读:

公众号:AI蜗牛车

保持谦逊、保持自律、保持进步

发送【蜗牛】获取一份《手把手AI项目》(AI蜗牛车著)

发送【1222】获取一份不错的leetcode刷题笔记

发送【AI四大名著】获取四本经典AI电子书