使用Hugging Face模型:NLP任务的强大工具

Hugging Face是一个知名的自然语言处理(NLP)模型和工具库,它提供了各种预训练的NLP模型,使NLP任务更容易实现。本文将介绍如何使用Hugging Face模型来执行各种NLP任务。

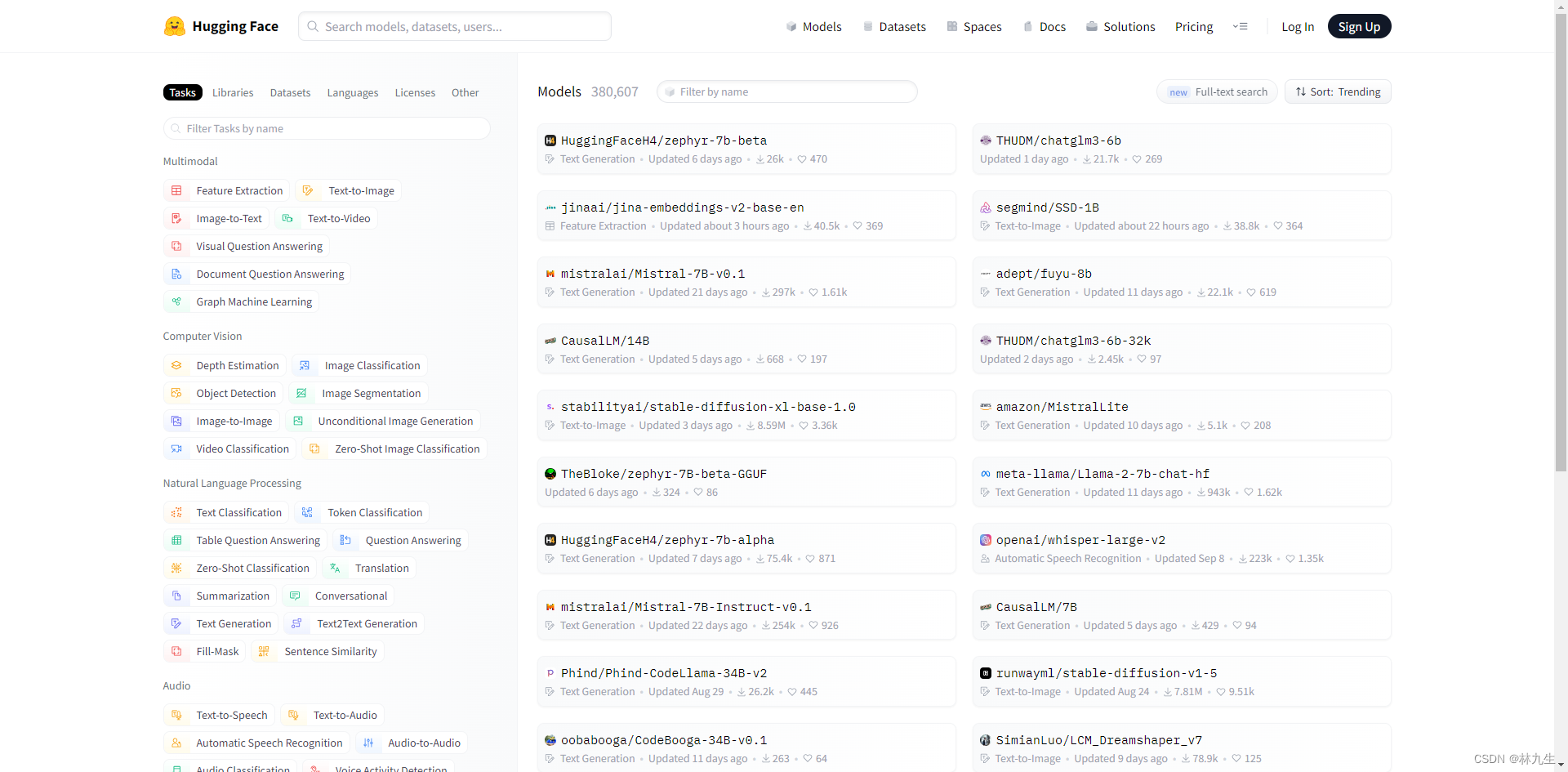

什么是Hugging Face?

Hugging Face是一个致力于改进NLP应用的社区,提供了丰富的NLP模型、工具和资源。你可以在官方网站上找到各种不同的模型,包括文本生成、文本分类、情感分析等。这些模型可以用于多种NLP任务,无需从头开始训练模型。

安装Hugging Face Transformers库

在开始使用Hugging Face模型之前,你需要安装transformers库。你可以使用pip来安装它:

pip install transformers

使用Hugging Face模型

现在,让我们来看看如何使用Hugging Face模型来执行中文文本生成任务。以下是一个简单的Python示例:

from transformers import BertTokenizer, GPT2LMHeadModel, TextGenerationPipeline

tokenizer = BertTokenizer.from_pretrained("uer/gpt2-chinese-poem")

model = GPT2LMHeadModel.from_pretrained("uer/gpt2-chinese-poem")

text_generator = TextGenerationPipeline(model, tokenizer)

result = text_generator("我 就 说 三 句 话 ,", max_length=50, do_sample=True)

print(result)

上述代码首先加载了一个预训练的BERT模型和相应的标记器,然后使用模型对输入文本进行分类。

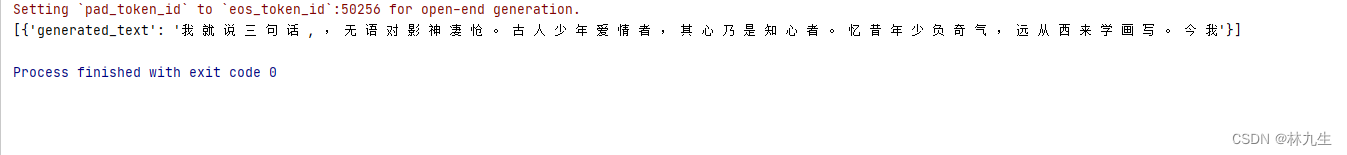

运行结果:

你可以根据你的任务选择不同的模型和标记器。

总结

Hugging Face是一个强大的NLP工具库,它提供了各种预训练的NLP模型,使NLP任务更容易实现。在本文中,我们了解了如何安装transformers库并使用Hugging Face模型来执行文本分类任务。你可以在Hugging Face官方网站上找到更多模型和资源,以满足各种NLP需求。

希望这篇文章对你有所帮助,让你更好地利用Hugging Face进行NLP任务的开发和研究。