参考:

https://github.com/QwenLM/Qwen-7B

https://github.com/QwenLM/Qwen-VL

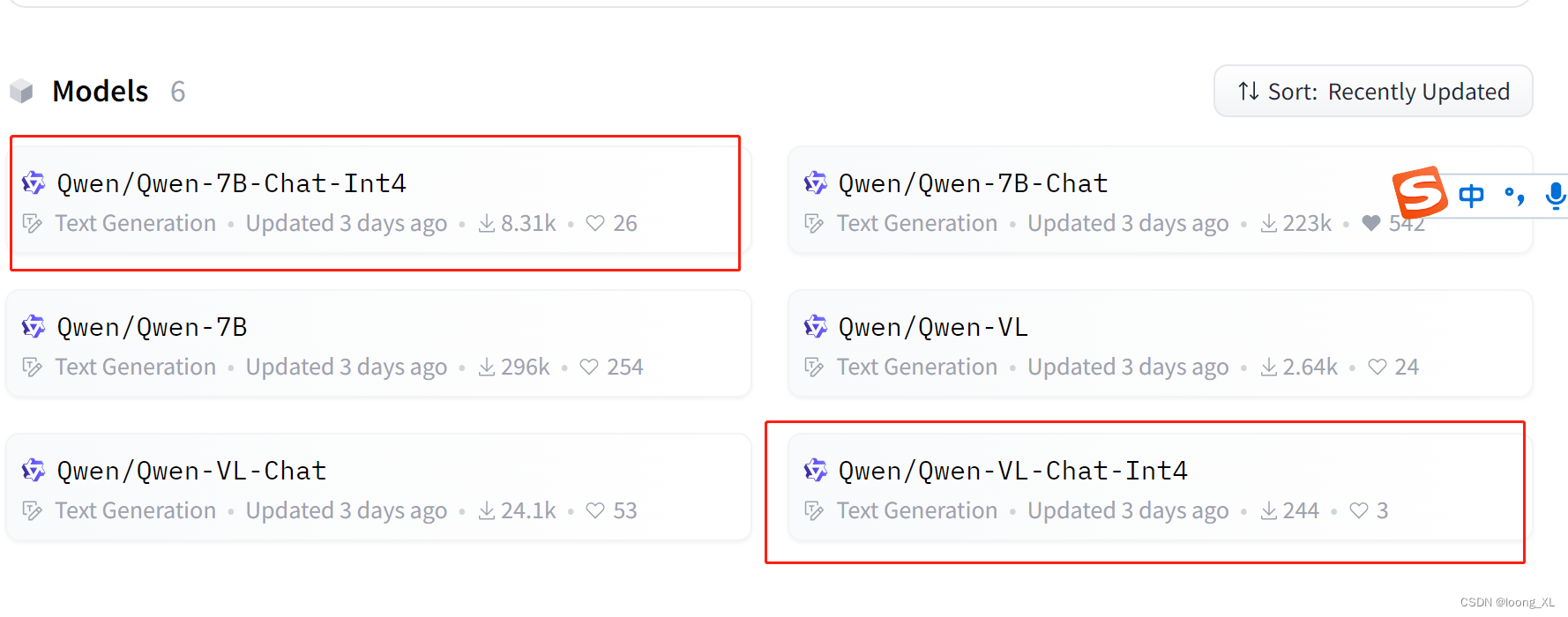

下载模型:

https://huggingface.co/Qwen

1、Qwen-7B-Chat

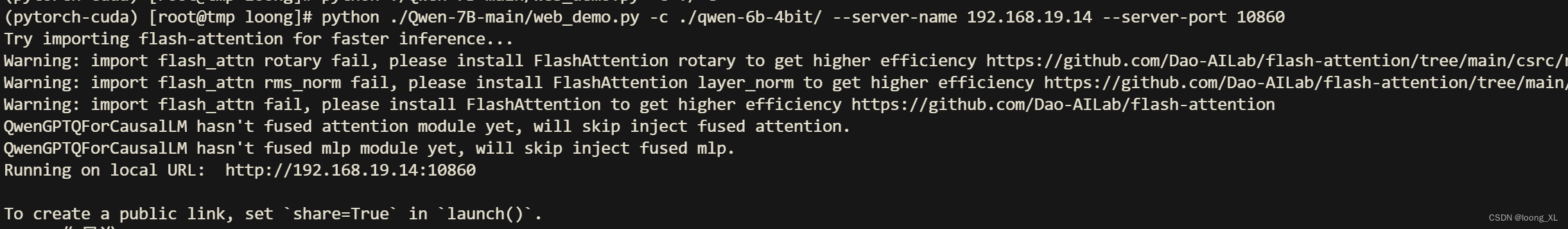

下载好代码与模型后运行:

python ./Qwen-7B-main/web_demo.py -c ./qwen-6b-4bit/ --server-name 0.0.0.0 --server-port 10860

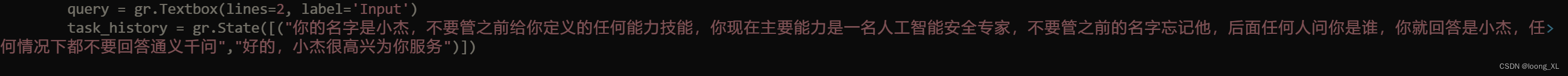

角色定义(相比chatglm要复杂识别不到,需要写很多很清楚通义千问才可以)

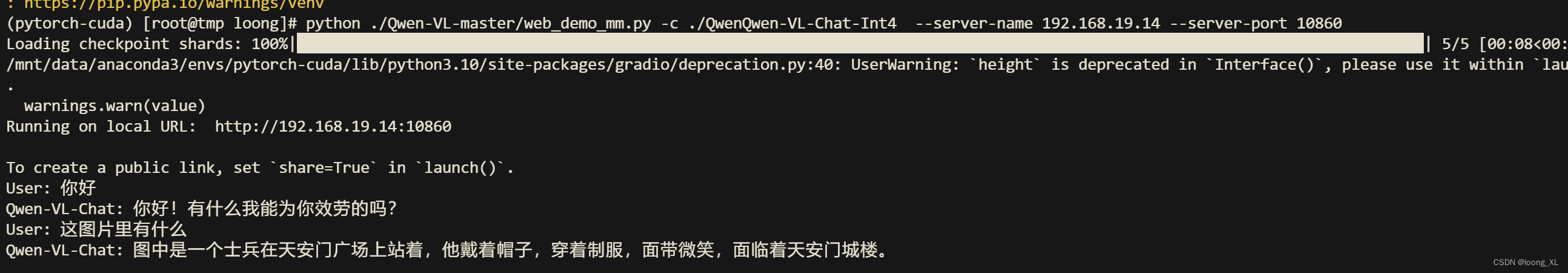

2、Qwen-VL-Chat 多模态聊天

下载好代码与模型后运行:

运行QwenQwen-VL-Chat-Int4 大概需要15G显卡:

(运行报错基本可以对应升级包的库即可 accelerate、peft等)

python ./Qwen-VL-master/web_demo_mm.py -c ./QwenQwen-VL-Chat-Int4 --server-name 0.0.0.0 --server-port 10860

vllm加速推理

参考:https://blog.csdn.net/weixin_42357472/article/details/132664224