hadoop3.3.0下载安装与配置

hadoop个版本下载地址

http://archive.apache.org/dist/hadoop/common/

安装hadoop需要先安装jdk,配置java环境

jdk1.8下载链接

链接: https://pan.baidu.com/s/1pj4yAiA3tmWe-nO9780ITg?pwd=hp9d 提取码: hp9d

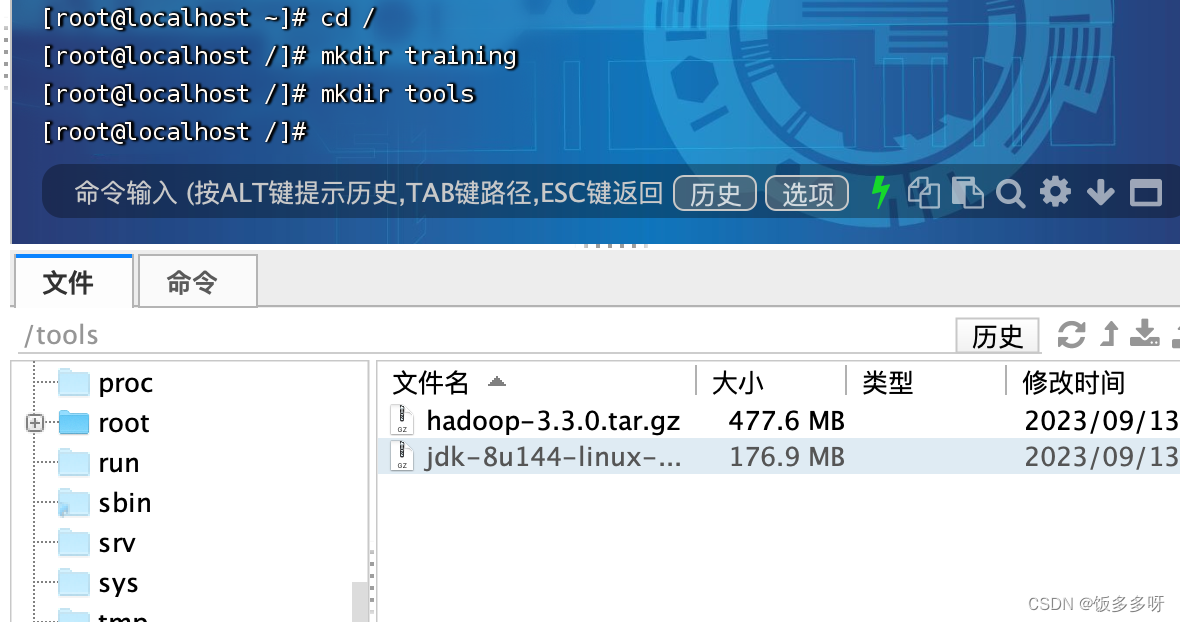

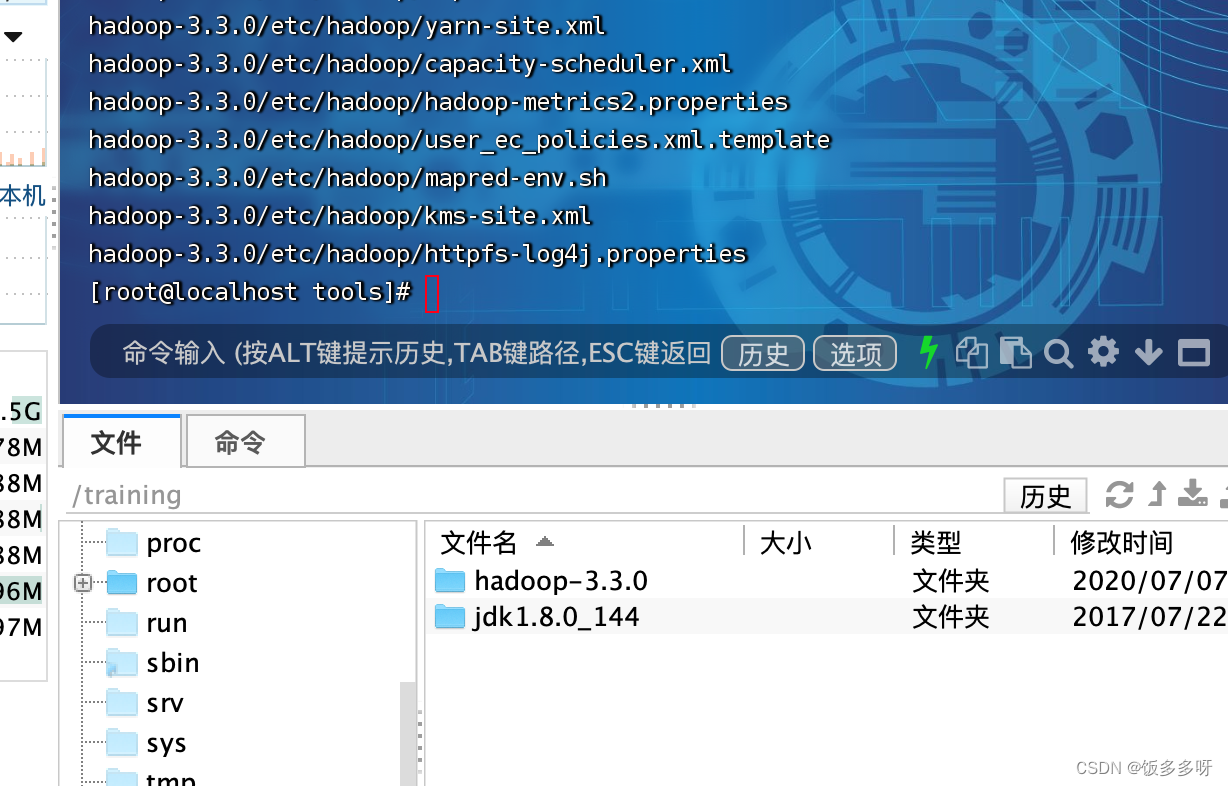

1.创建tools ,training文件夹

直接将jdk和hadoop安装包上传到tools中

2. 解压安装配置jdk

2.1解压

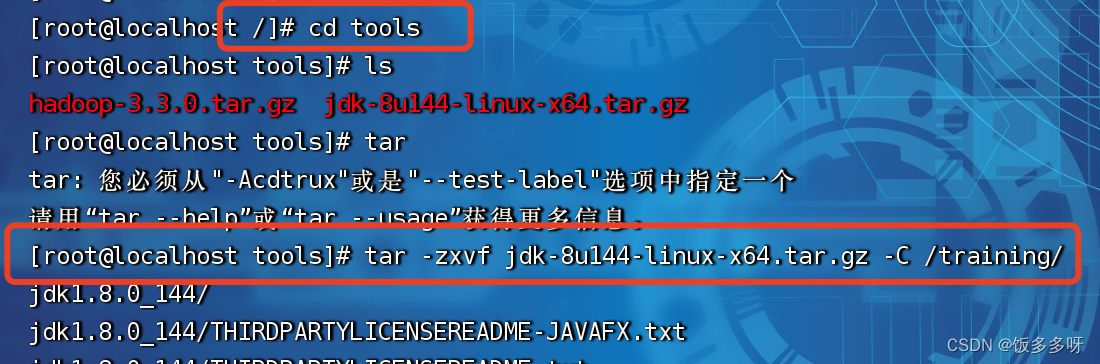

进入tools文件夹,将jdk解压到training文件夹下

[root@localhost /]# cd tools

[root@localhost tools]# ls

hadoop-3.3.0.tar.gz jdk-8u144-linux-x64.tar.gz

[root@localhost tools]# tar -zxvf jdk-8u144-linux-x64.tar.gz -C /training/

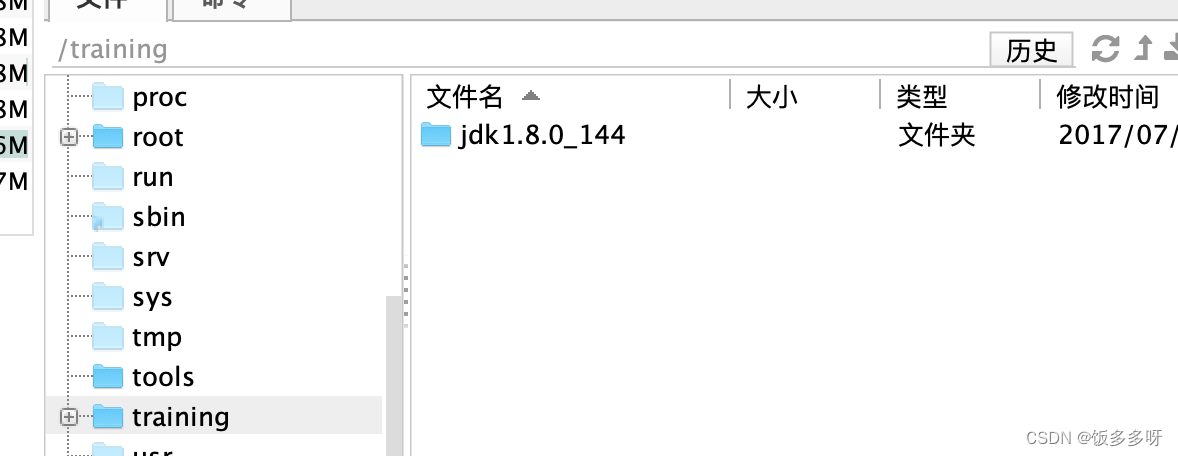

解压后去training文件夹下查看,已经解压完成

2.2配置

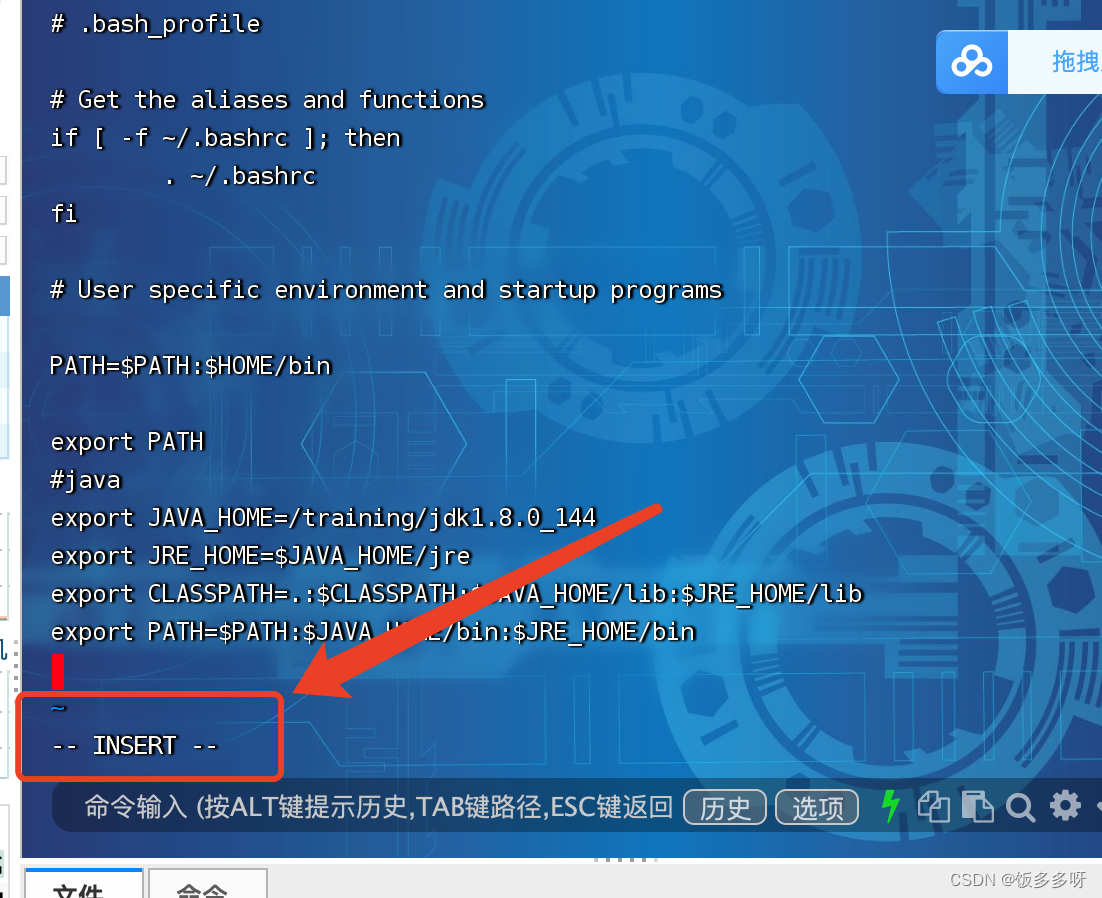

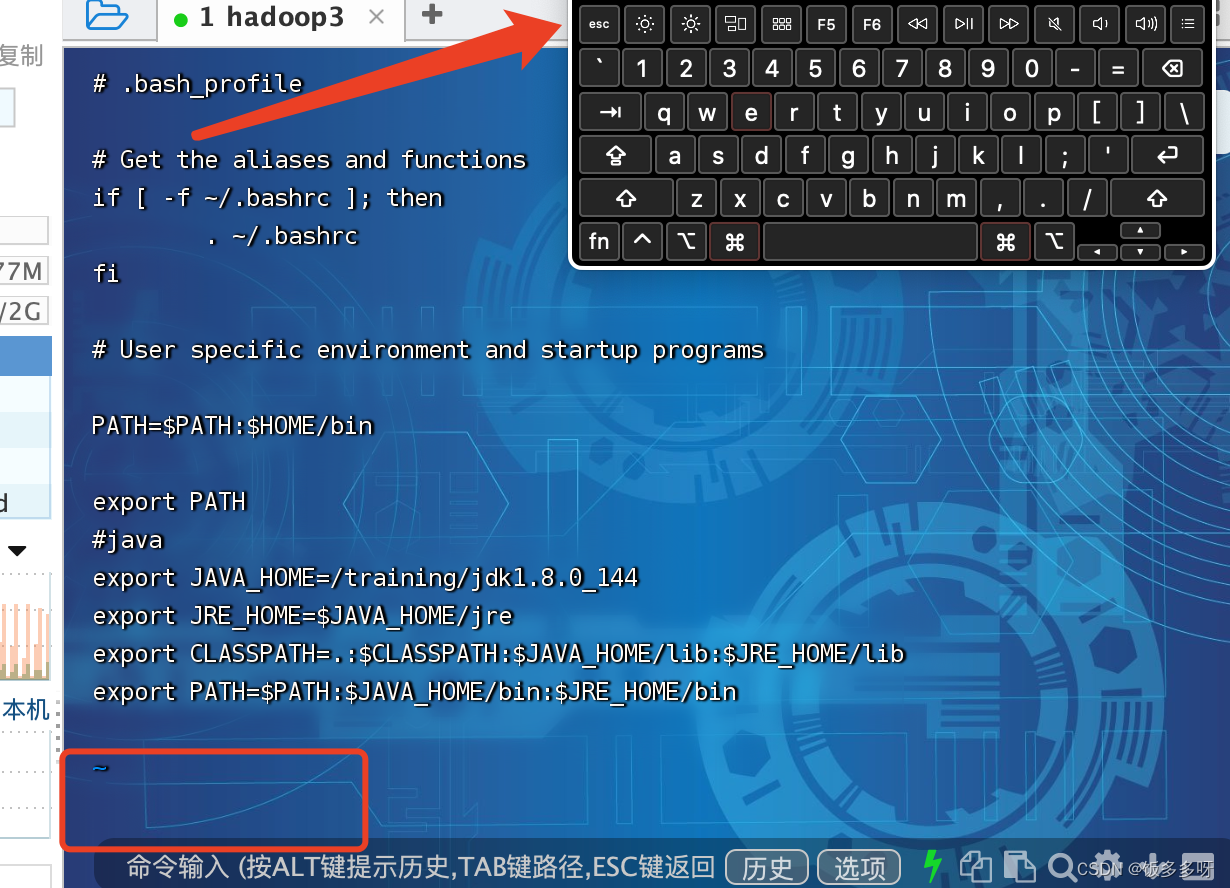

输入此命令进行环境变量配置

vi ~/.bash_profile

打开文件后是不可编辑状态,键盘输入 i 进入编辑状态

在文件中加入以下内容

#java

export JAVA_HOME=/training/jdk1.8.0_144

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$CLASSPATH:$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

注意 jdk路径和版本号要和自己的实际路径和版本号一致

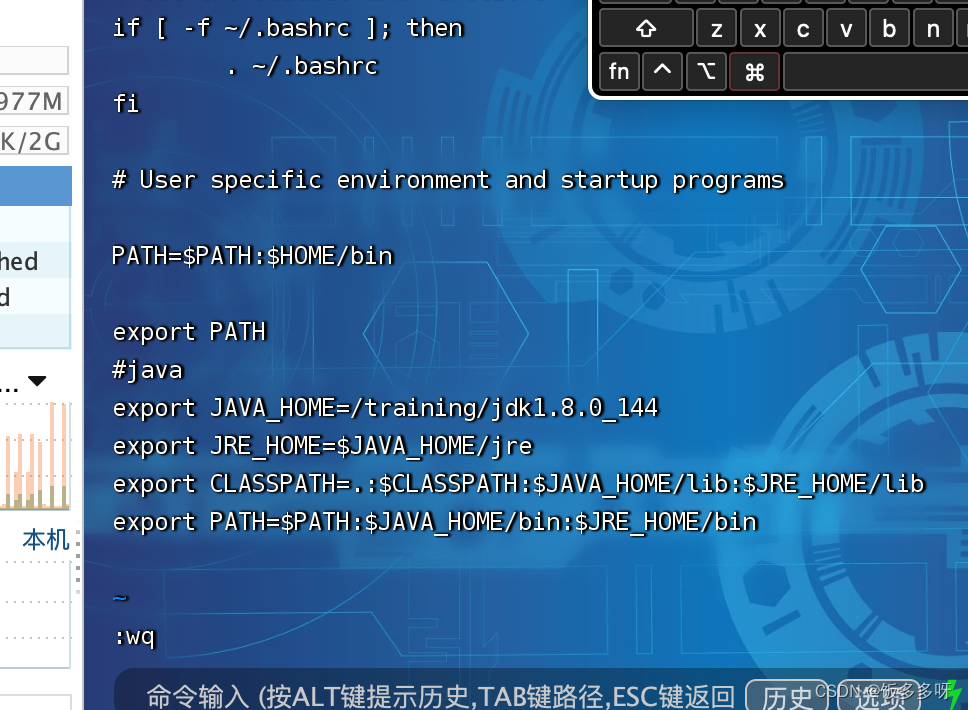

输入完成后,点击键盘上的ESC键退出输入模式

输入模式如下,文件末尾显示的有INSERT

点击ESC之后,文件末尾的INSERT会消失

然后输入:wq 回车保存退出即可

:wq保存退出:q!不保存强制退出

输入以下命令使环境变量生效

source ~/.bash_profile

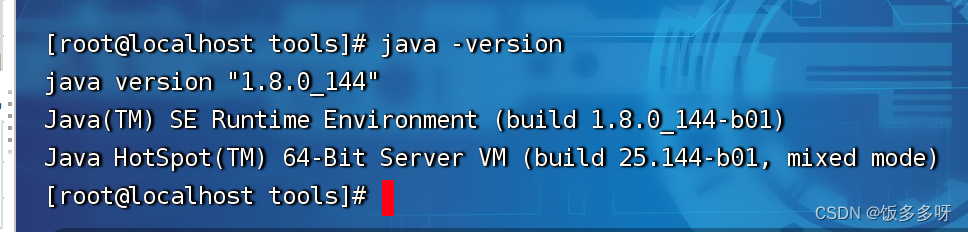

2.3查看是否配置成功

输入以下命令查看是否配置成功

java -version

3.安装hadoop

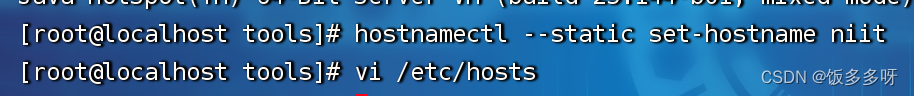

3.1配置主机名

最后面niit为要修改的主机名,也可根据自己的需要自由设置

hostnamectl --static set-hostname niit

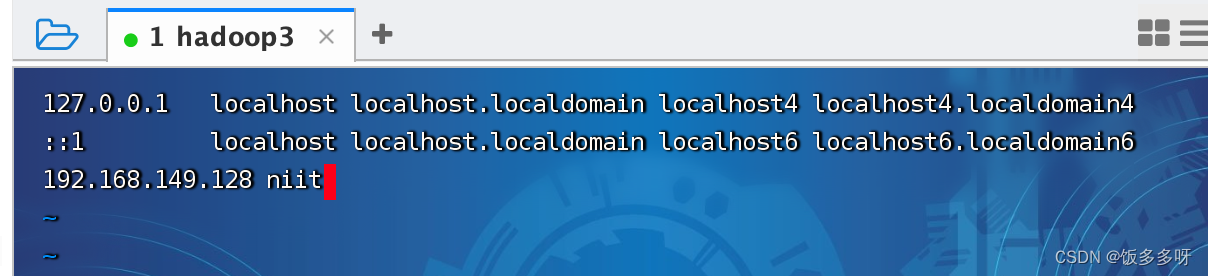

3.2配置ip主机名映射关系

修改hosts文件,配置映射关系

输入以下命令进行修改

vi /etc/hosts

在文件中键入以下内容(输入i进入编辑模式,:wq保存退出)

前面是你自己的本机ip地址 后者会刚才配置的主机名,一定要以自己的实际ip和主机名一致!!!

192.168.149.128 niit

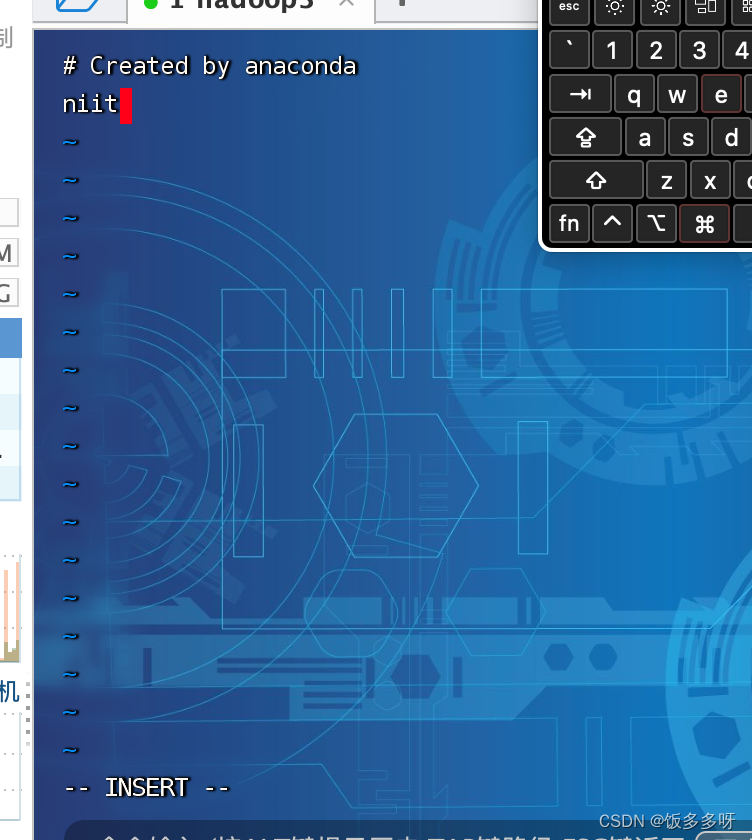

配置另一个映射文件

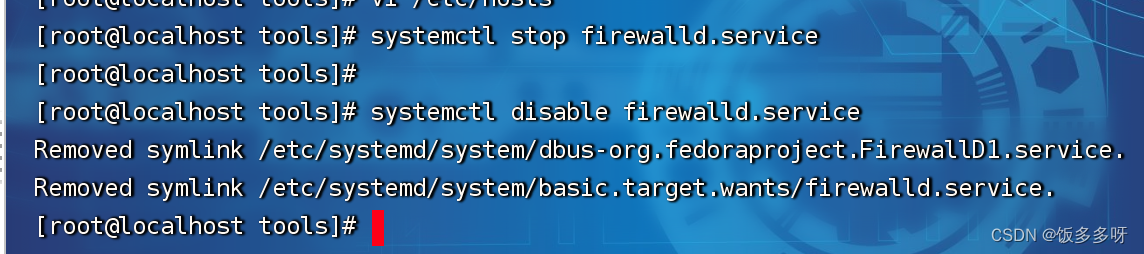

3.3 关闭防火墙

systemctl stop firewalld.service

systemctl disable firewalld.service

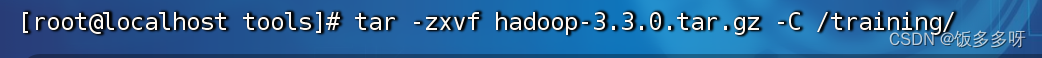

3.4解压hadoop

进入tools文件夹,将hadoop解压到training文件夹中

cd tools

tar -zxvf hadoop-3.3.0.tar.gz -C /training/

3.5 配置hadoop环境变量

vi ~/.bash_profile

打开文件后键入以下内容即可 (输入i进入编辑模式,:wq保存退出)

#hadoop

export HADOOP_HOME=/training/hadoop-3.3.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使环境变量生效

source ~/.bash_profile

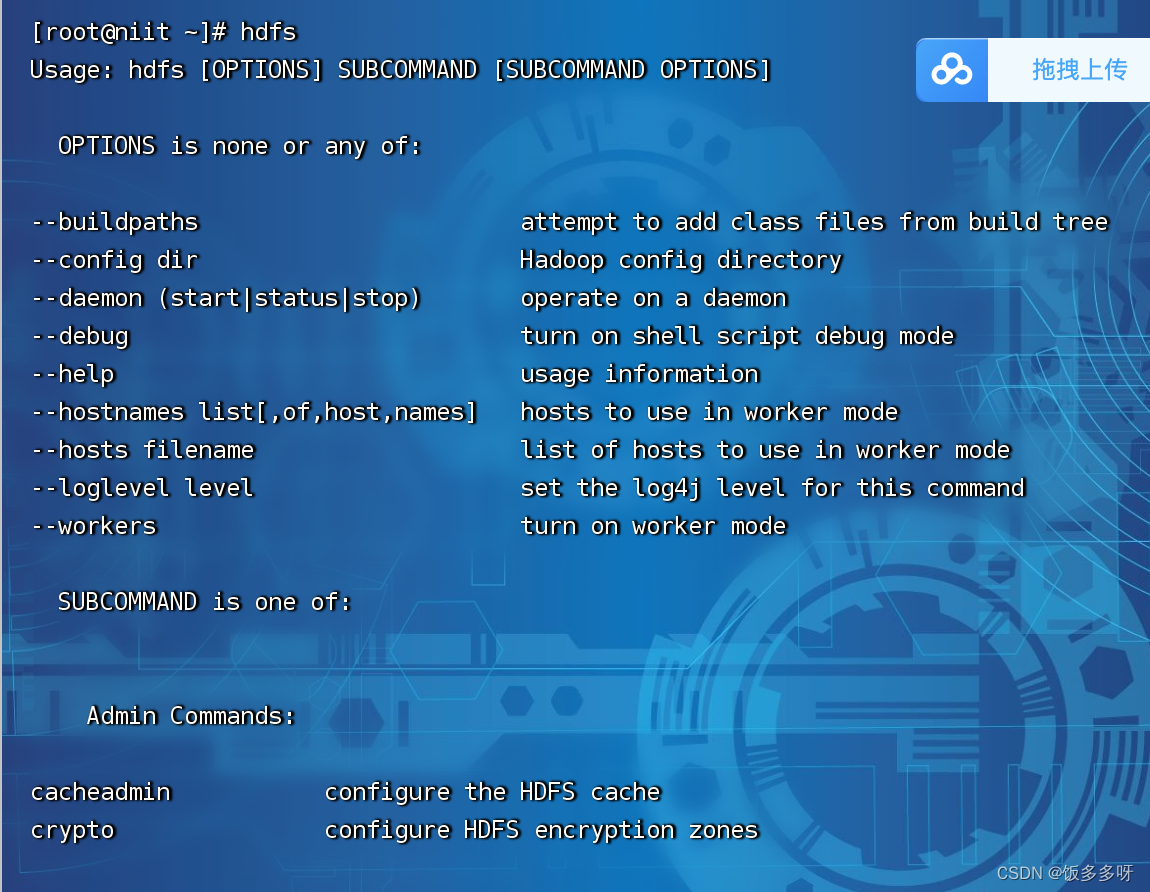

3.6输入hdfs检查hadoop是否安装成功

输入以下内容说明安装成功

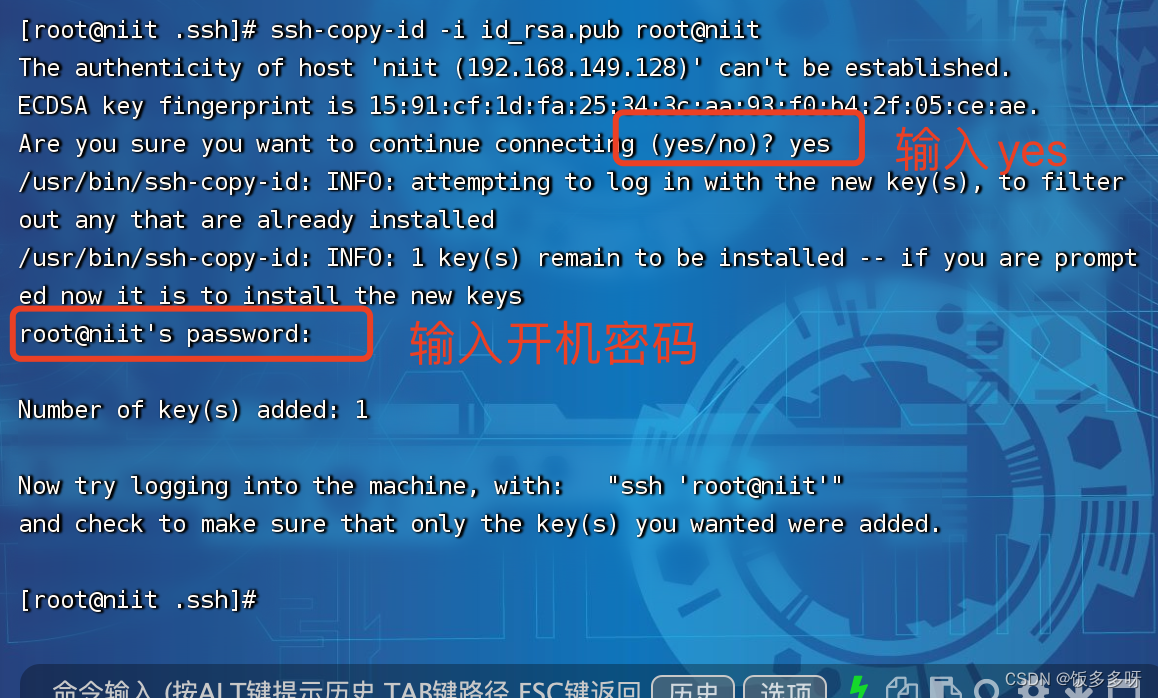

3.7 配置hadoop免密登录

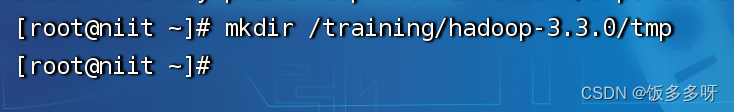

在hadoop安装路径下创建一个tmp文件夹用于存放配置数据

mkdir /training/hadoop-3.3.0/tmp

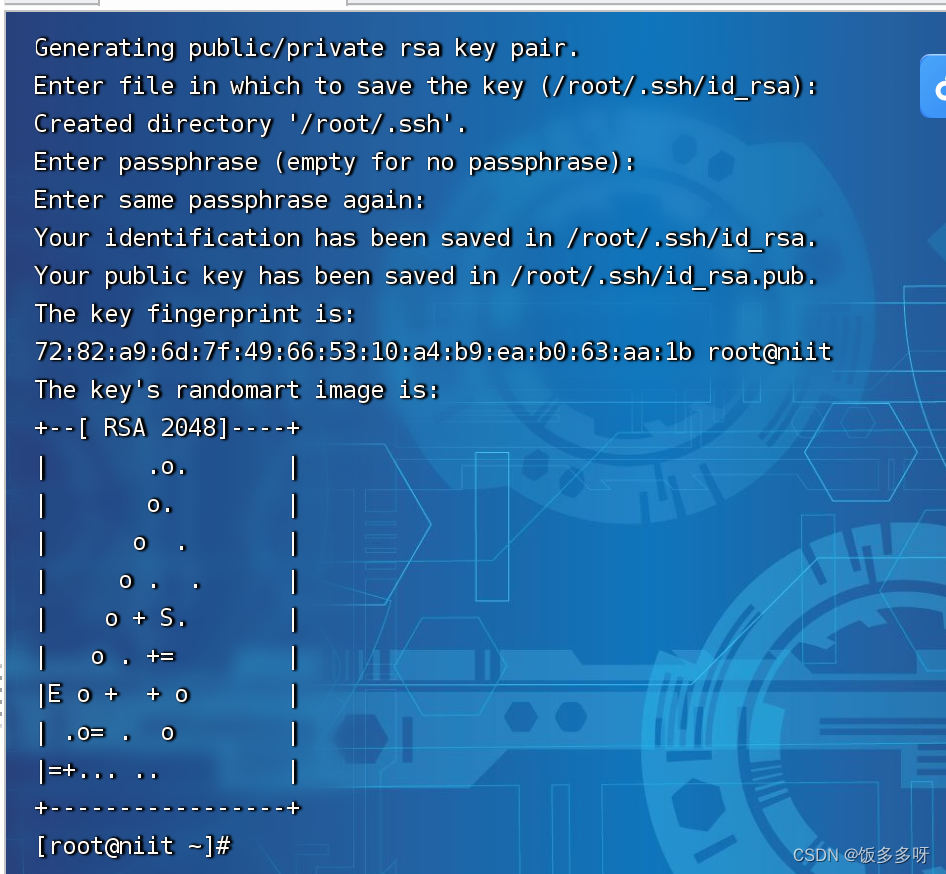

进行免密配置

输入以下代码,回车四次,什么都不要输入

输入以下命令

cd ~/.ssh/

ssh-copy-id -i id_rsa.pub root@niit

niit是自己本机的主机名

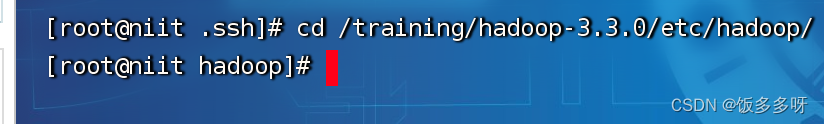

3.8配置hadoop配置文件

3.8.1 进入Hadoop配置文件地址

cd /training/hadoop-3.3.0/etc/hadoop/

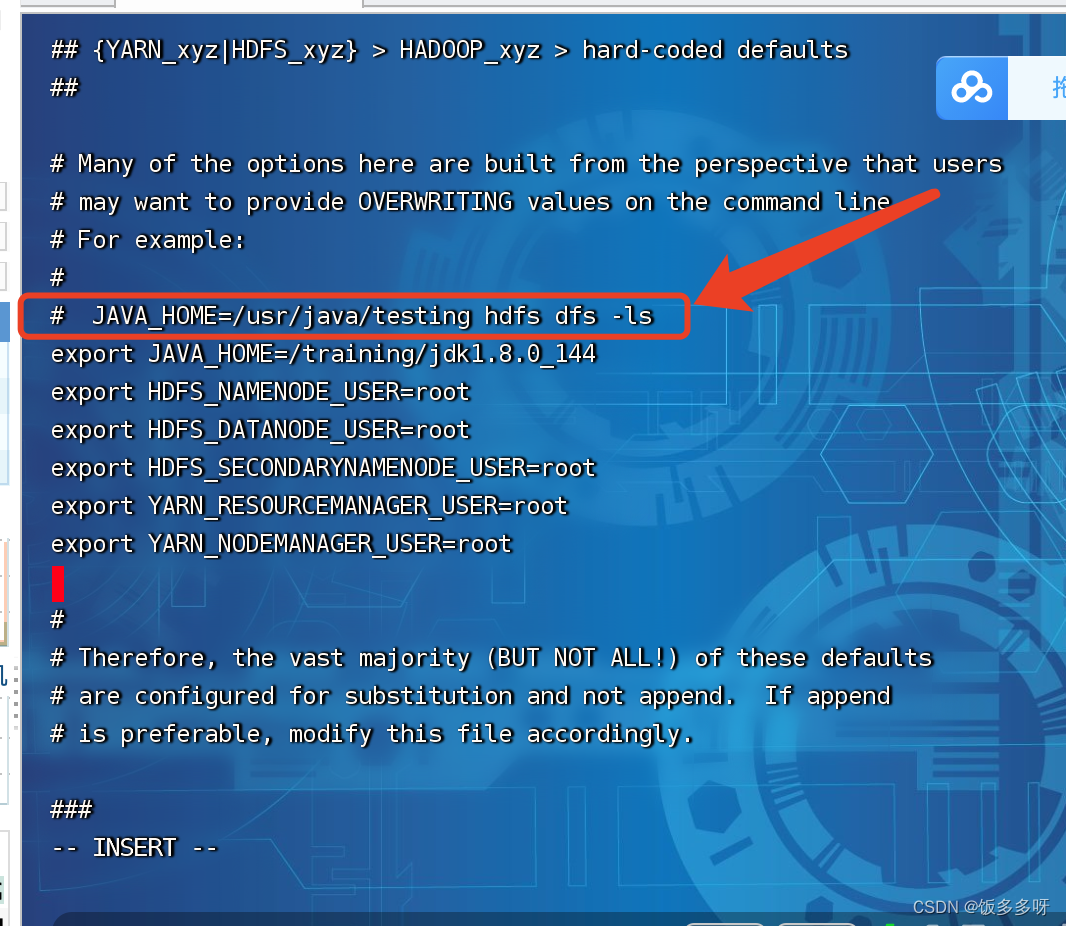

- 配置hadoop-env.sh文件

vi hadoop-env.sh

进入编辑模式后找到JAVA_HOME,在此列下面添加如下代码

(输入i进入编辑模式,:wq保存退出)

export JAVA_HOME=/training/jdk1.8.0_144

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

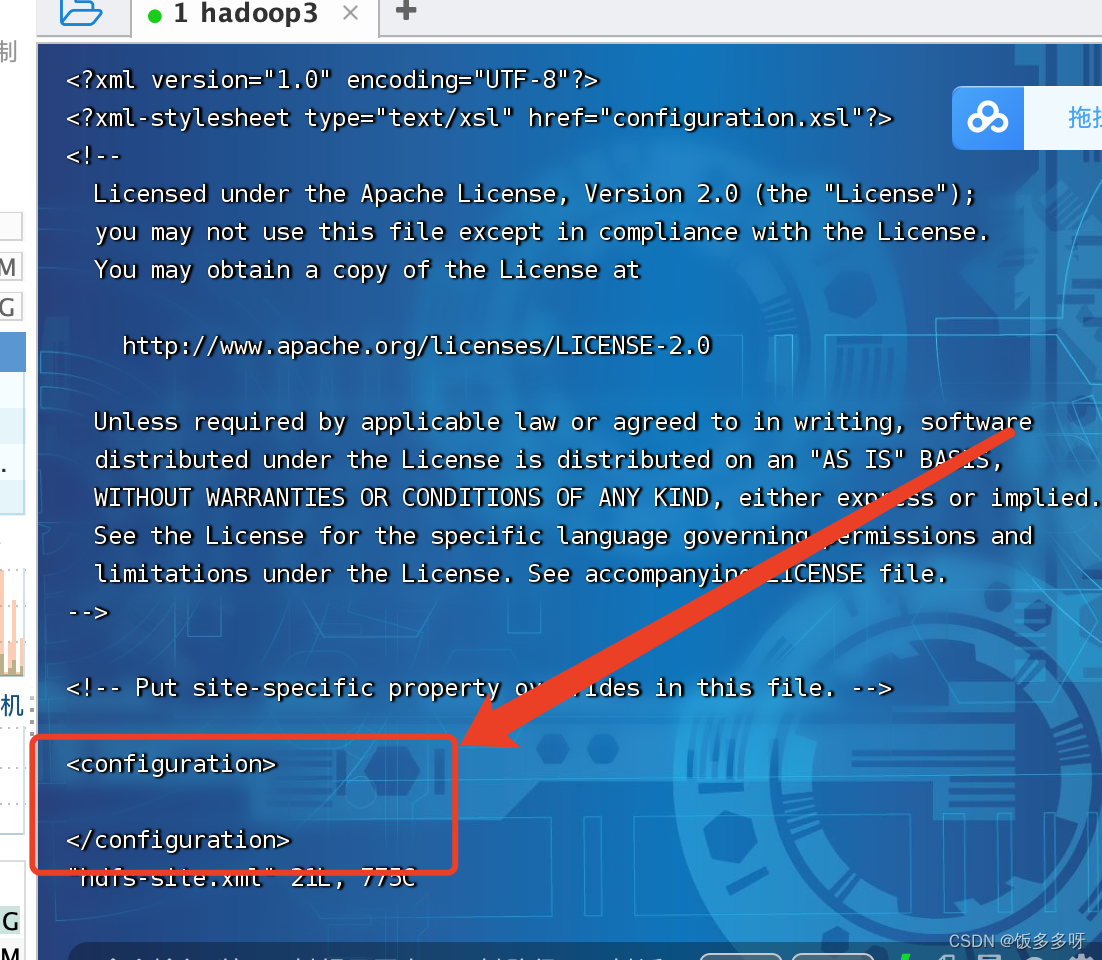

2. 配置hdfs-site.xml文件

vi hdfs-site.xml

进去之后在两个configuration标签下加入以下配置 (输入i进入编辑模式,:wq保存退出)

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

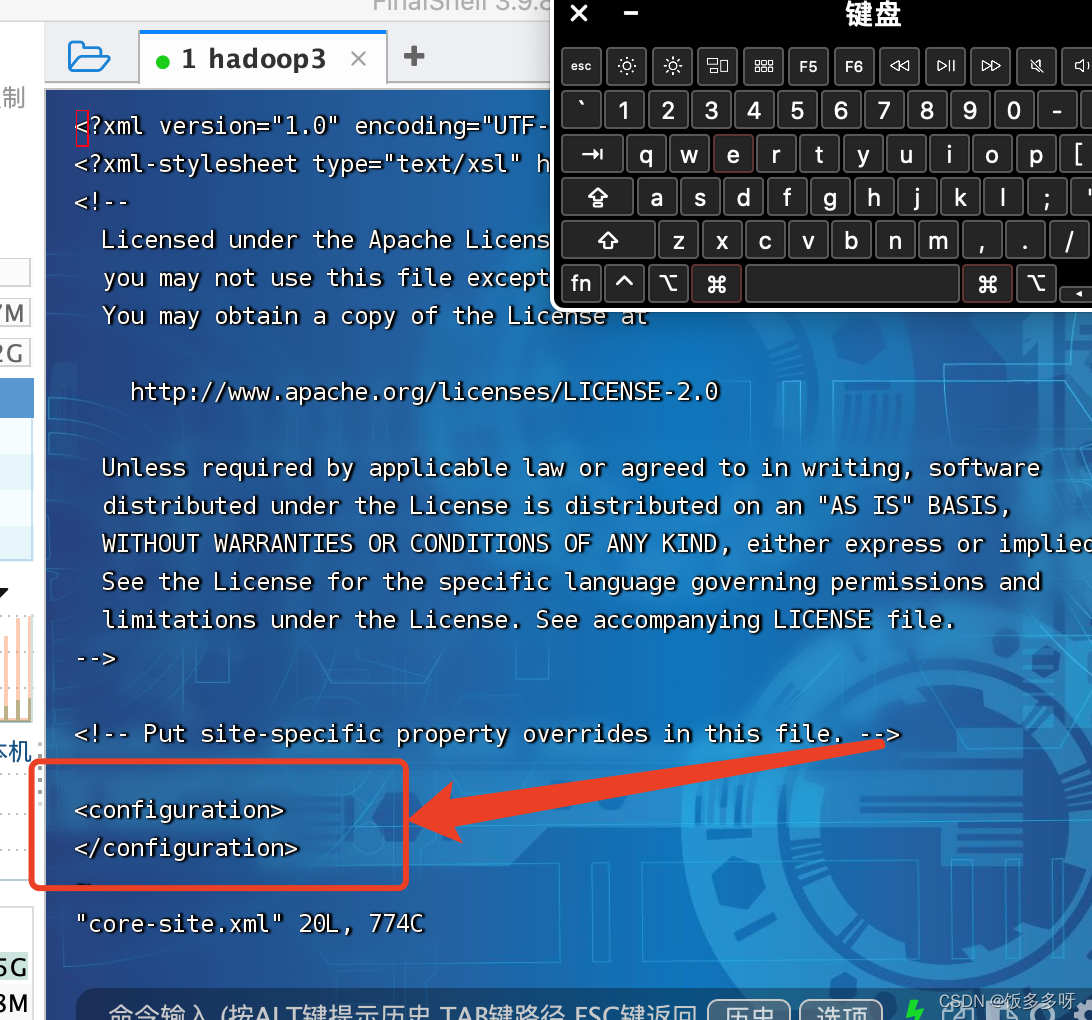

3.配置core-site.xml文件

进入文件

vi core-site.xml

进去之后在两个configuration标签下加入以下配置 (输入i进入编辑模式,:wq保存退出)

其中niit为主机名,要与自己的实际主机名一致

<property>

<name>fs.defaultFS</name>

<value>hdfs://niit:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/training/hadoop-3.3.0/tmp</value>

</property>

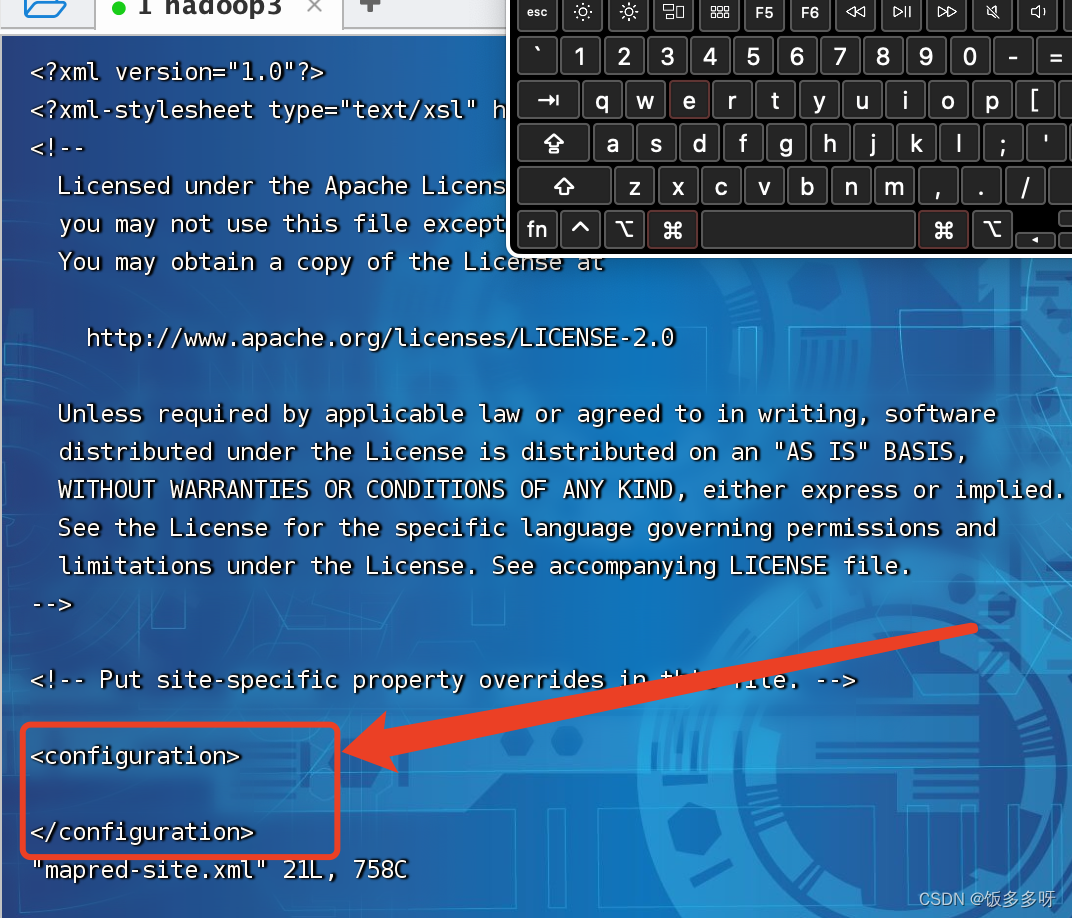

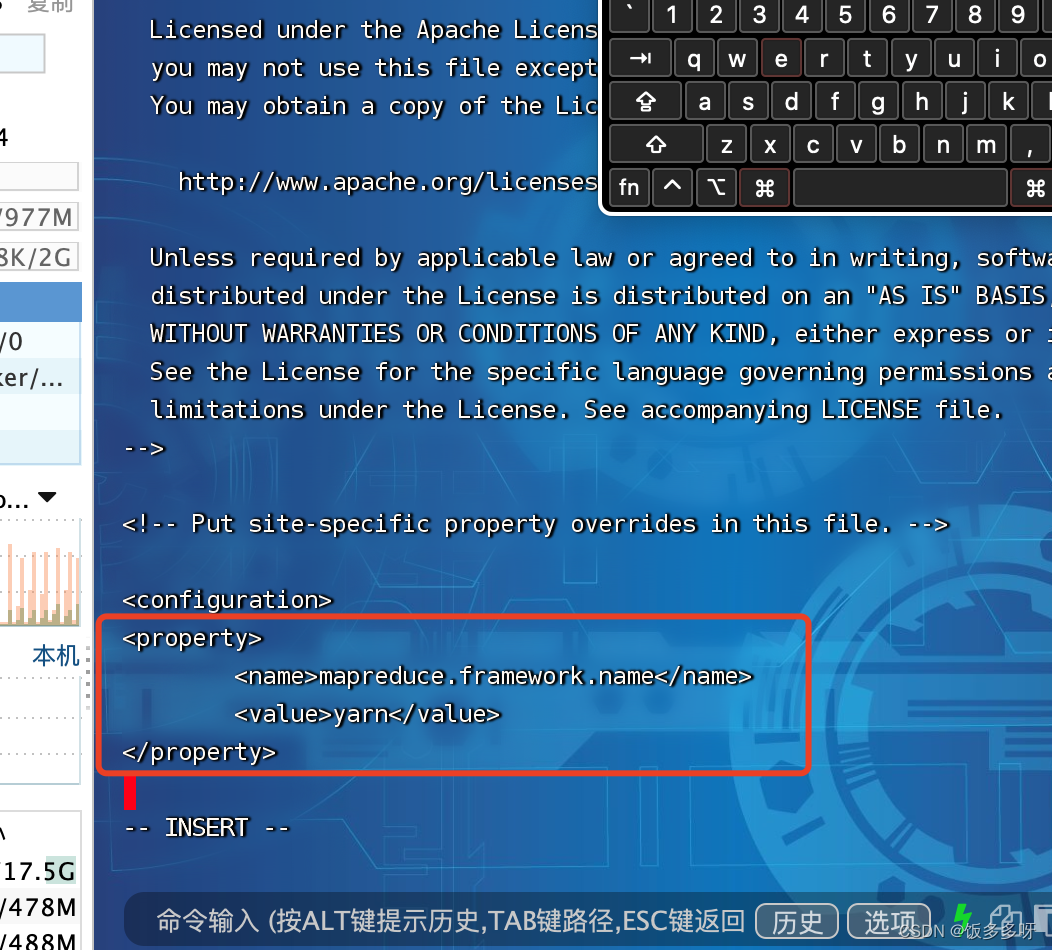

4.配置mapred-site.xml文件

进去之后在两个configuration标签下加入以下配置 (输入i进入编辑模式,:wq保存退出)

vi mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

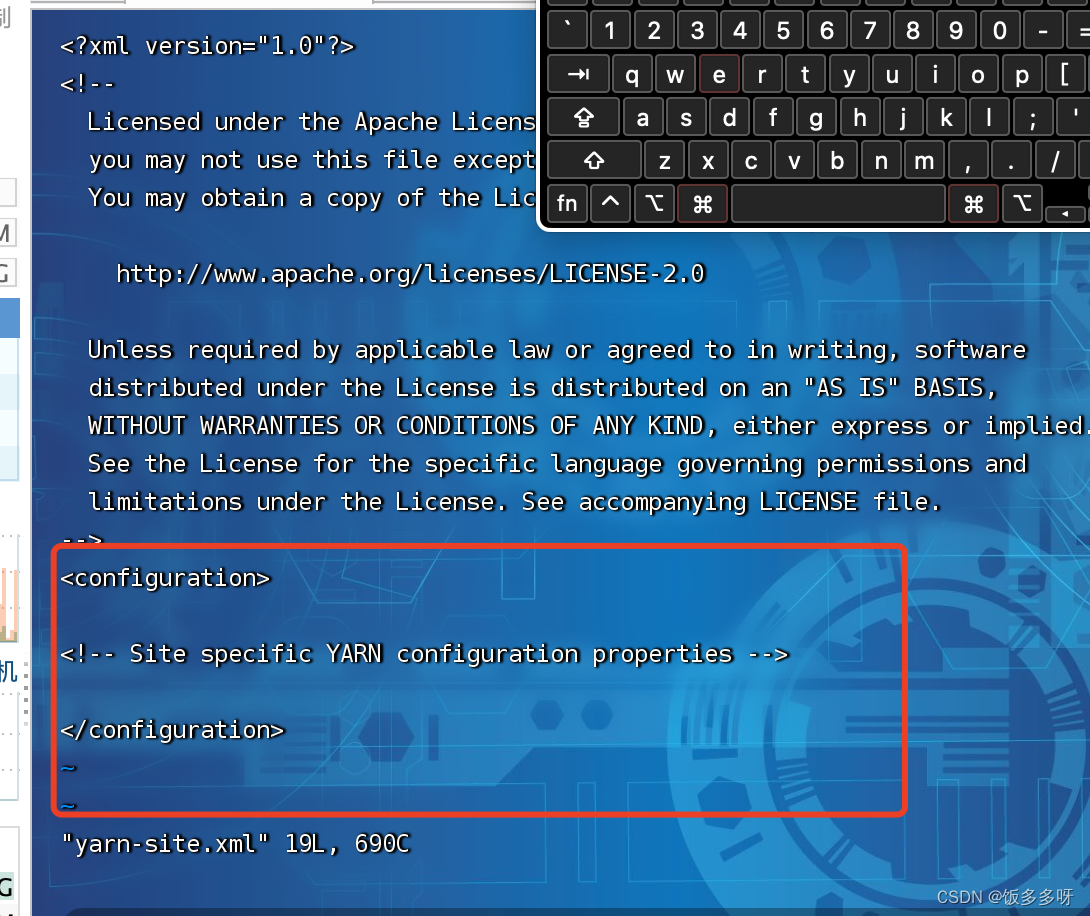

- 配置yarn-site.xml文件

vi yarn-site.xml

进去之后在两个configuration标签下加入以下配置 (输入i进入编辑模式,:wq保存退出)

<property>

<name>yarn.resourcemanager.hostname</name>

<value>niit</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

3.9 Hadoop格式化主节点

hdfs namenode -format

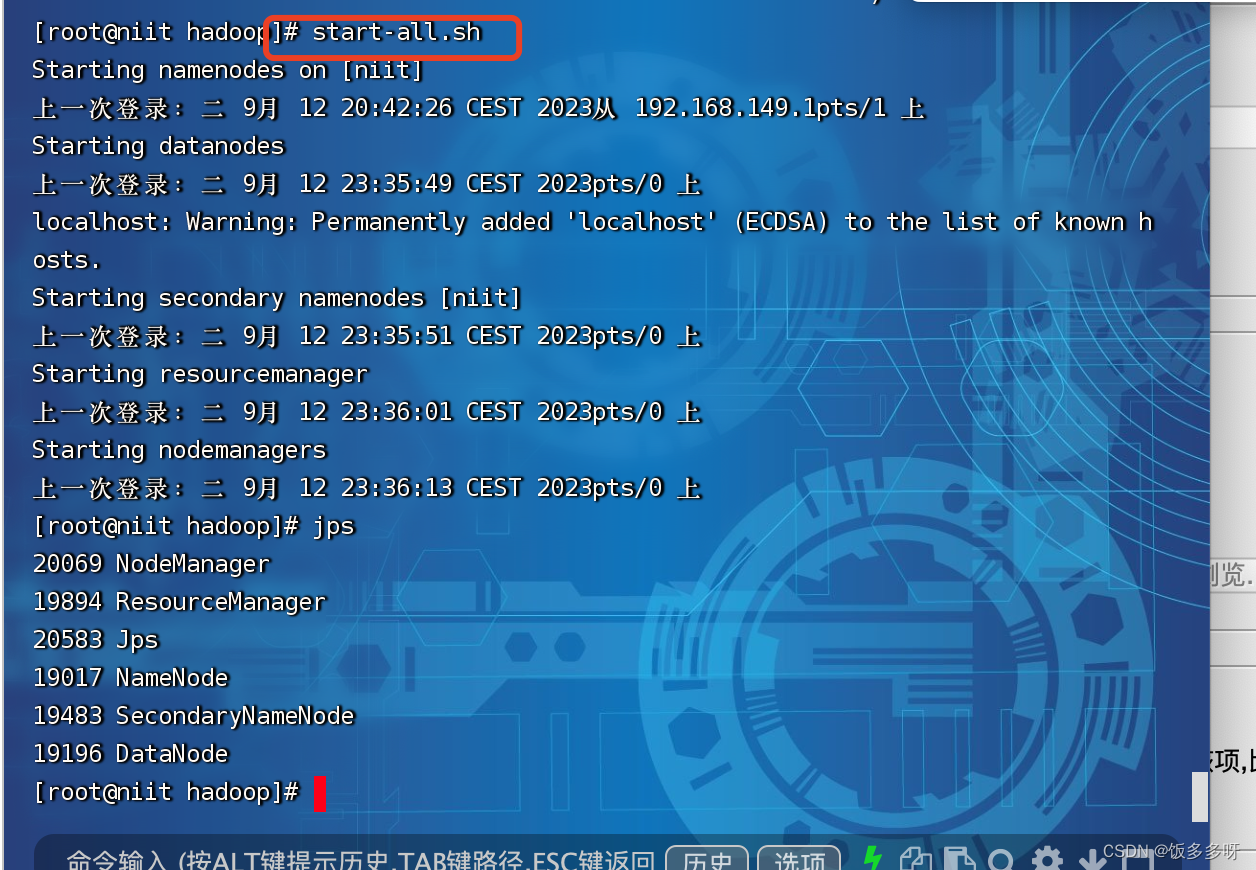

4.0 hadoop启动与关闭

启动

start-all.sh

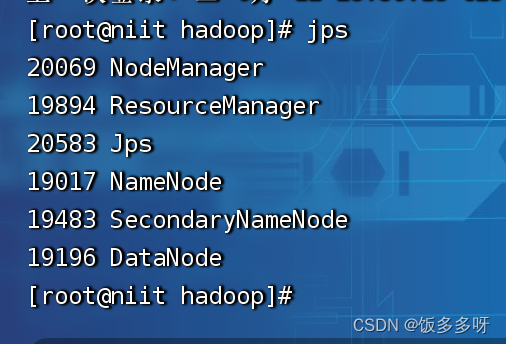

查看进程

jps

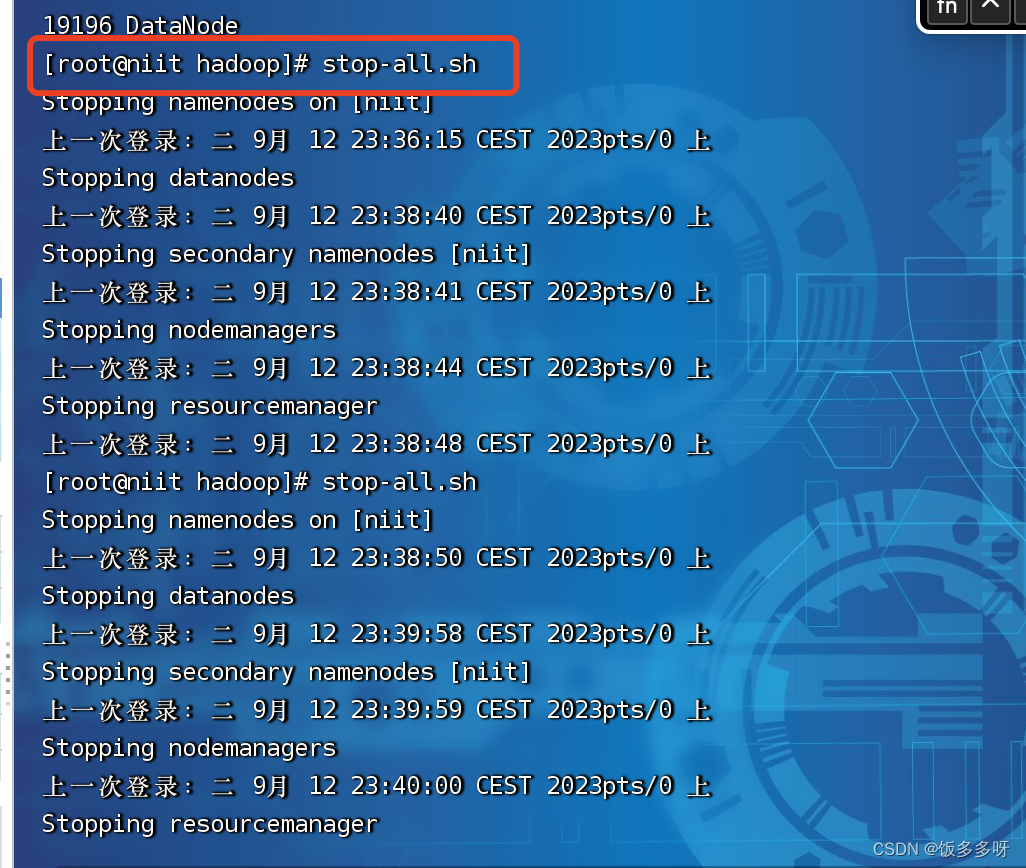

关闭hadoop

stop-all.sh

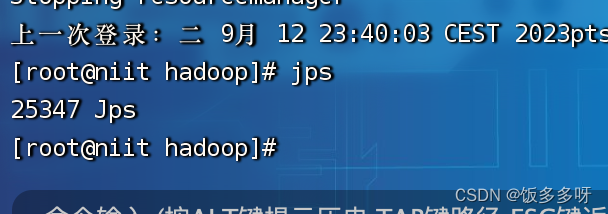

查看进程

jps

以上如果全都正常,说明安装成功,如果缺少进程,说明是某个配置文件有问题,查看配置文件修改即可