cvpr2021

Zhendong Yang*1,2 Zhe Li2 Xiaohu Jiang1 Y uan Gong1

Zehuan Y uan2 Danpei Zhao3 Chun Y uan†1

1Tsinghua Shenzhen International Graduate School 2ByteDance Inc

3BeiHang University

0.摘要

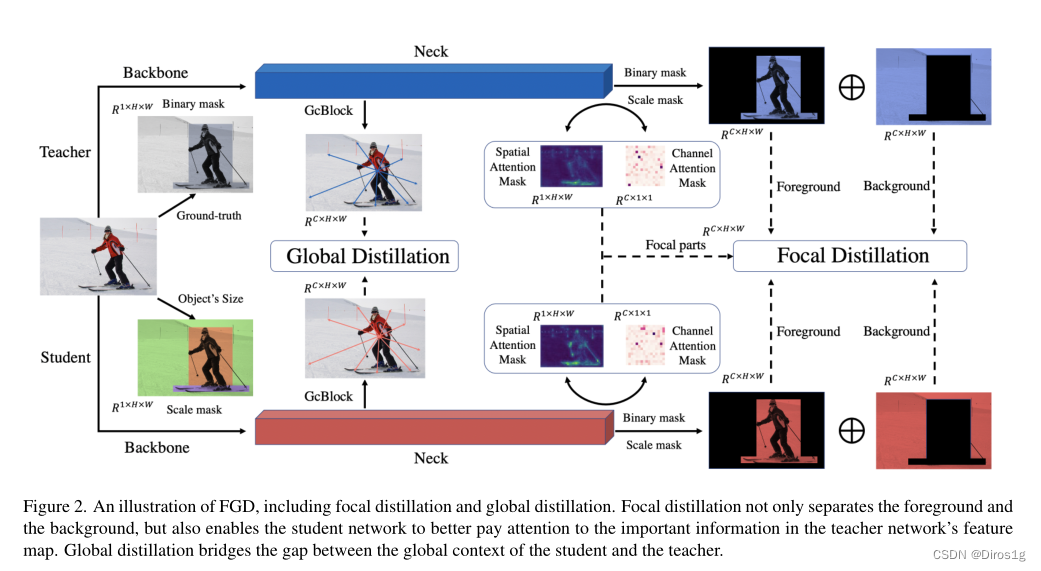

作者觉得在目标检测领域,知识蒸馏效果比较差,其原因是教师和学生的特征在背景和前景中差距比较大。如果蒸馏的温度一样,会产生吸收大量噪音负面影响。

作者提出了全局和局部蒸馏,局部蒸馏会分离前后景(语义分割?),来让学生关注老师的精华。而全局蒸馏会重建不同像素之间的联系,填充全局信息。

1.模型结构

1.1局部蒸馏

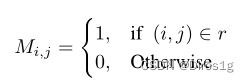

很简单,r为gt_box,只有这一块是1。

由于前后景不均衡,对mask进行了改进:

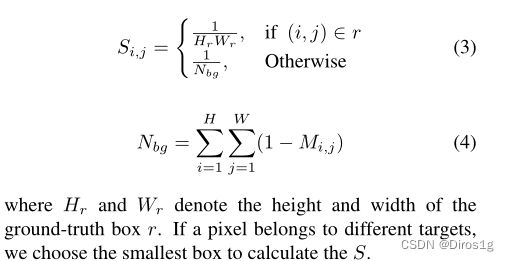

然后加了空间和通道注意力:

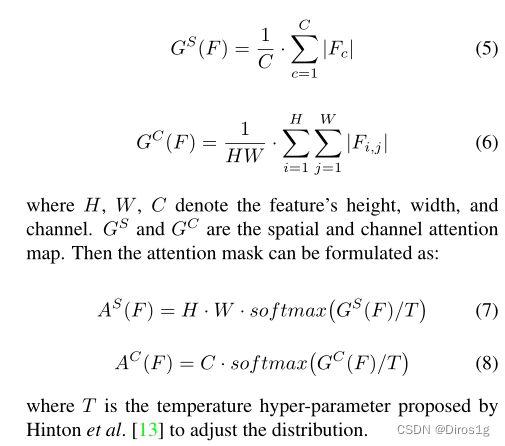

损失包括两部分,特征损失

是和注意力损失:

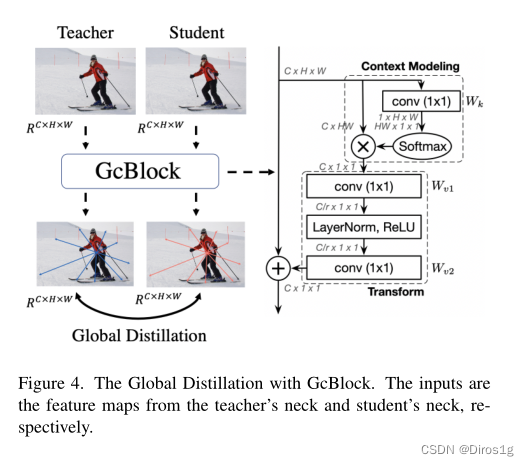

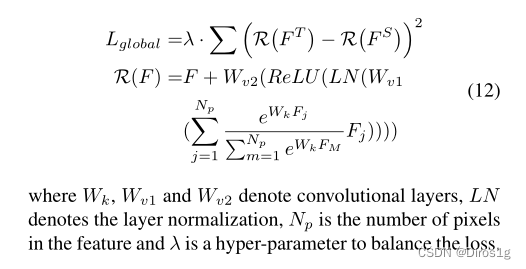

1.2全局蒸馏