标题:Learning Responsibility Allocations for Safe Human-Robot Interaction with Applications to Autonomous Driving

作者:Ryan K. Cosner, Yuxiao Chen, Karen Leung, and Marco Pavone

来源:2023 IEEE International Conference on Robotics and Automation (ICRA 2023)

这是佳佳怪分享的第5篇文章,仅限于分享,如有错误欢迎批评指正

摘要

驾驶员有责任采取合理的谨慎措施,避免与其他道路使用者发生碰撞。这种承担的责任允许交互代理在没有明确协调的情况下维护安全。因此,为了实现安全的自动驾驶汽车(AV)交互,AV必须了解他们维护安全的职责以及他们如何影响附近代理的安全。在这项工作中,我们试图了解在多智能体环境中,自主智能体与人类同行互动时,责任是如何分担的。我们引入了责任感知控制障碍函数(RA CBF),并提出了一种从数据中学习责任分配的方法。通过将安全关键控制和基于学习的技术相结合,RA CBF使我们能够考虑场景相关的责任分配,并综合安全高效的驾驶行为,而不会做出通常导致过度保守行为的最坏情况假设。我们使用真实世界的驾驶数据测试了我们的框架,并证明了它作为安全控制和不安全驾驶法医分析工具的有效性。

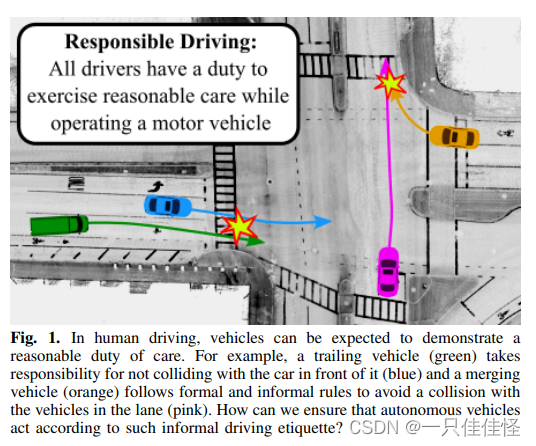

图1。在人类驾驶中,车辆可以表现出合理的注意义务。例如,尾随车辆(绿色)负责不与前车相撞(蓝色),并线车辆(橙色)遵守正式和非正式规则,以避免与车道上的车辆相撞(粉色)。我们如何确保自动驾驶汽车按照这种非正式的驾驶规则行动?

图2。对于一系列速度和相对位置,学习的责任分配表面是可视化的。场景一:ego车(黄色)行驶在一条双车道道路上。在所有情况下,γ(ego,x)>0表示保守驾驶的程度。通常,当另一个代理(红色)在后面时,γ(ego,x)更大,表明在另一辆车后面行驶时责任增加。场景2:ego车辆停在一个四向交叉口,另一辆车(绿色)在它前面或后面(没有蓝色代理)。同样,当绿色车辆在其前面时,ego车辆(黄色)比在其后面时更负责任。场景3:ego车辆(蓝色)停在四向交叉口,另一辆车辆从上到下穿过(没有绿色代理)。γ(ego,x)对于蓝色车辆的所有位置和速度都是大的,这表明在这种情况下,ego 代理承担的责任更大。

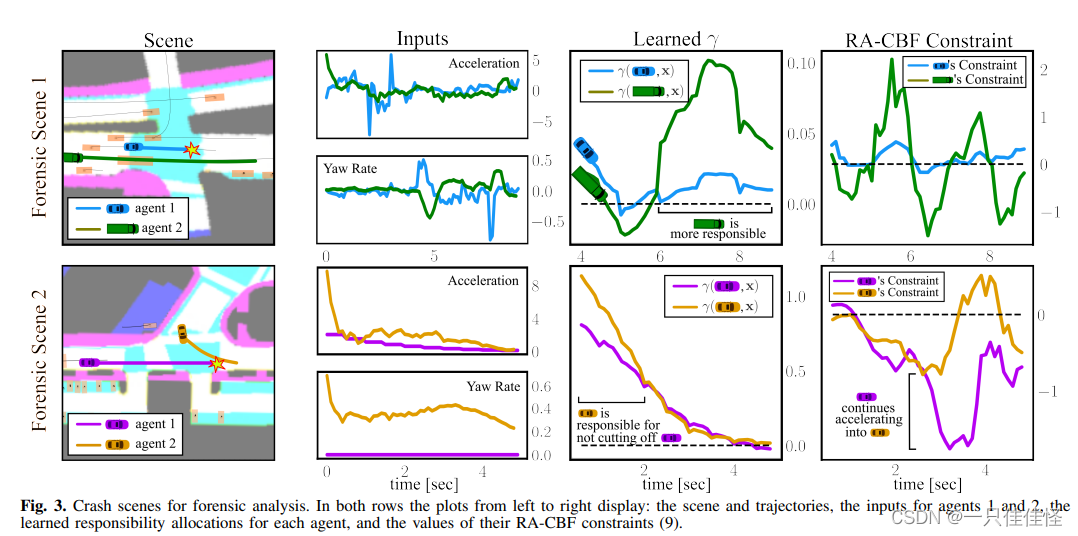

图 3. 用于法医分析的碰撞场景。两行中从左到右的图显示了:场景和轨迹、代理 1 和代理 2 的输入、每个代理的学习责任分配以及它们的 RA-CBF 约束值 (9)。学习到的每个代理的责任分配,以及它们的 RA-CBF 约束值 (9)。

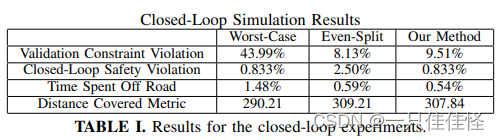

表 I. 闭环实验结果

结论

我们提出了责任意识控制障碍函数(RA-CBFs)作为学习和合成安全负责驾驶行为的框架。RA-CBFs 旨在捕捉多个(人类)代理之间的非对称责任分担,我们提出了一种从数据中学习与上下文相关的责任分配的方法。然后,我们利用真实世界的驾驶数据证明了我们方法的有效性和实用性。这项工作为未来的发展指明了方向,包括将明确的交通规则纳入我们的责任学习范式,比较不同地理区域的责任分配差异,以及探索人群导航等其他应用领域。