一、概述

NSX-T(Transformer)是VMware 的另一个 NSX 平台,NSX-T 与 VMware Photon 平台集成。VMware NSX-T 专注于处理异构endpoint和技术堆栈的新兴应用程序框架和架构的解决方案。除了 vSphere 管理程序之外,这些环境还可能包括其他 hypervisors、容器、裸机和公共云。NSX-T 提供分布式防火墙、逻辑交换和分布式路由。同NSX-V一样,NSX-T架构内置了独立的数据平面、控制平面和管理平面。NSX-T Data Center 的工作方式就是实现三个单独而集成的工作面:管理、控制和数据。这些工作面是作为位于两种类型的节点上的一组进程、模块和代理实现的: NSX Manager 和传输节点。

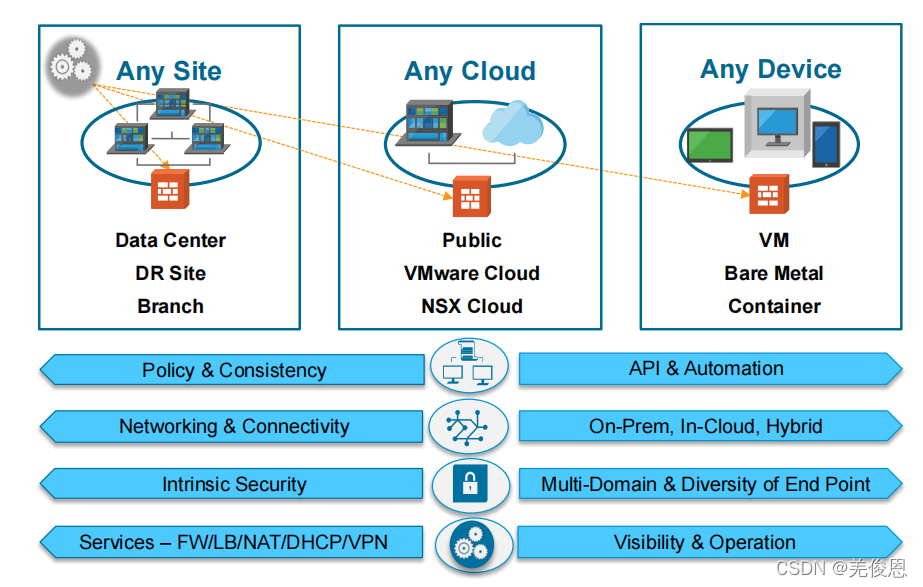

二、架构

NSX-T架构是围绕四个基本属性设计的。如上图示,图中描述了跨越任何站点、任何云和任何端点设备的这些属性的通用性。这不仅在基础设施级别(如硬件、管理程序)上,而且在公共云(如AWS、Azure)和容器级别(如K8、Pivotal)上实现了更大的解耦,同时维护跨域实现的平台的四个关键属性。NSX-T体系结构的关键价值概念和特点包括:

● 策略和一致性: 允许通过RESTful API一次性定义策略并实现最终状态,以满足当今自动化环境的需求。NSX-T维护多个独立系统清单信息和控制以实现不同域中期望结果。

● 网络和连接性:允许与多个vSphere和kvm节点进行一致的逻辑交换和分布式路由,而无需绑定到计算管理器/域。连接通过特定于域的实现在容器和云之间进一步扩展,同时仍然提供跨异构端点的连接。

● 安全和服务:允许与网络一样使用统一的安全策略模型连通性。这样就可以实现跨多个计算域的负载均衡器、NAT、EDGEfw和dfw等服务。安全操作规定阐述了:提供在虚拟机和容器工作负载的一致安全对于确保整体框架的完整性至关重要。

● 可见性:允许通过跨计算域的公共工具集进行一致的监视、指标收集和流跟踪。这对于混合工作负载的操作是至关重要的–通常,以虚拟机和容器为中心的这两种工作负载都具有完成类似任务的截然不同的工具。

这些属性能实现异构性,应用一致和可扩展性来支持不同需求。此外,NSX-T支持DPDK库以提供线速有状态服务(例如,负载均衡器、NAT)。

2.1 架构组件

NSX-T在软件中复制了整套网络服务(如交换、路由、防火墙、QoS)。这些服务可以以编程方式任意组合,在几秒钟内生成唯一的、独立的虚拟网络。NSX-T通过三个独立但集成的平面来完成工作:管理、控制和数据。这三个平面作为一组进程、模块和代理实现,这些进程、模块和代理驻留在三种类型的节点上:管理器、控制器和传输设备。

每个节点托管一个管理平面代理。

NSX Manager 节点托管 API 服务和管理平面集群守护进程。它支持具有三个节点的集群,它在节点集群上合并 Policy Manager、管理和中央控制服务。NSX Manager 集群提供用户界面和 API 的高可用性。管理和控制平面节点的融合减少了必须由 NSX-T Data Center 管理员部署和管理的虚拟设备数。

NSX Controller 节点托管中央控制平面集群守护进程。

传输节点托管本地控制平面守护进程和转发引擎。

● 其中管理组件可管理多达16个vCenter、容器编排和公有云环境;数据平面(网络传输节点)上 驻留management plane agent (MPA)来完成域NSX-T manger的通信;NSX 在2.4之前的版本中,各管理组件是基于角色的独立设备、一个管理设备和3个控制器设备,NSX总共需要部署4个管理设备+各中服务设备。从2.4开始,NSX管理器、NSX策略管理器和NSX控制器将在一个公共虚拟机中共存。

而群集可用性需要三个独特的NSX-vm设备。NSX-T依赖于三个这样的NSX管理器设备组成的集群来进行向外扩展和冗余。NSX-T管理器存储的所有信息在内存数据库,这样它可即时同步整个集群,而写磁盘,配置或读操作这些可以在三台中的任何设备上执行。鉴于大多数操作发生在内存中,NSX管理器设备磁盘的性能要求显著降低。这3个appliance,每个设备都有一个专用的IP地址,其管理器进程可以直接访问或通过负载均衡器访问。NSX Manager 提供了一个基于 Web 的用户界面,可以在其中管理 NSX-T 环境。另外它还托管用于处理 API 调用的 API 服务器。它有一个名为 admin 的内置用户帐户,该帐户具有所有资源的访问权限,但无权访问操作系统以安装软件。NSX-T 升级文件是唯一允许安装的文件。您可以更改 admin 的用户名和角色权限,但不能删除 admin。在 NSX Manager 上,每个会话的会话 ID 和令牌是唯一的,并在用户注销或处于不活动状态一段时间后过期。此外,每个会话具有一个时间记录,将加密会话通信以防止会话劫持。

● NSX-T将控制平面分为两部分:

● Central Control Plane (CCP:中控室):它实际就是管理集群中的一台vm设备(多称为CCP设备);该设备(管理网络)通信逻辑上与所有数据平面(业务网络)流量隔离;因此它的流量和故障不会对实际的业务流量造成影响,业务网络里的数据也不会穿入到管理网络,导致管控风险;

/

Local Control Plane (LCP:端控):该组件部署在----传输节点(数据节点)上,负责在数据平面的传输节点上转发路由条目和防火墙规则等;

\

● 数据平面

传输节点是运行本地控制平面守护进程和实现NSX-T数据平面的转发引擎的主机。传输节点中运行的NSX-T 虚拟交换机为N-VDS;在ESXi主机平面,N-VDS下联VDS,NSX-T 3.0后,N-VDS是基于OVS实现的(平台无关系,可移植到其他管理程序平台),这也是满足其他平台网络环境的实现;NSX-T中有2种类型的传输节点:

Hypervisor Transport Nodes:支持 VMware ESXi™ 和KVM hypervisors,为运行这些hypervisor上vm提供网络服务;

Edge Nodes:VMware NSX-T Edge™ nodes是一种服务网关设备,该appliance可实力为裸金属/vm;需注意的是,这些Edge设备并不是服务本身,它只是一些网络服务的消费资源池;其中二层网桥是负责在NSX-T Overlay层和支持VLAN的物理网络之间桥接通信的设备。一个二级网桥是通过两个ESXi Hypervisor(基于每个VLAN的活动/备用)组成的集群实现的,专门用于桥接。

通过在备用 Edge 节点上运行 CLI 命令 set l2bridge-port <uuid> state active,可以手动将备用 Edge 节点设置为活动节点。该命令只能在非主动模式下应用。否则,将出现错误。在非主动模式下,当在备用节点上应用此命令时,它将触发 HA 故障切换,当在活动节点上应用时,它将被忽略。

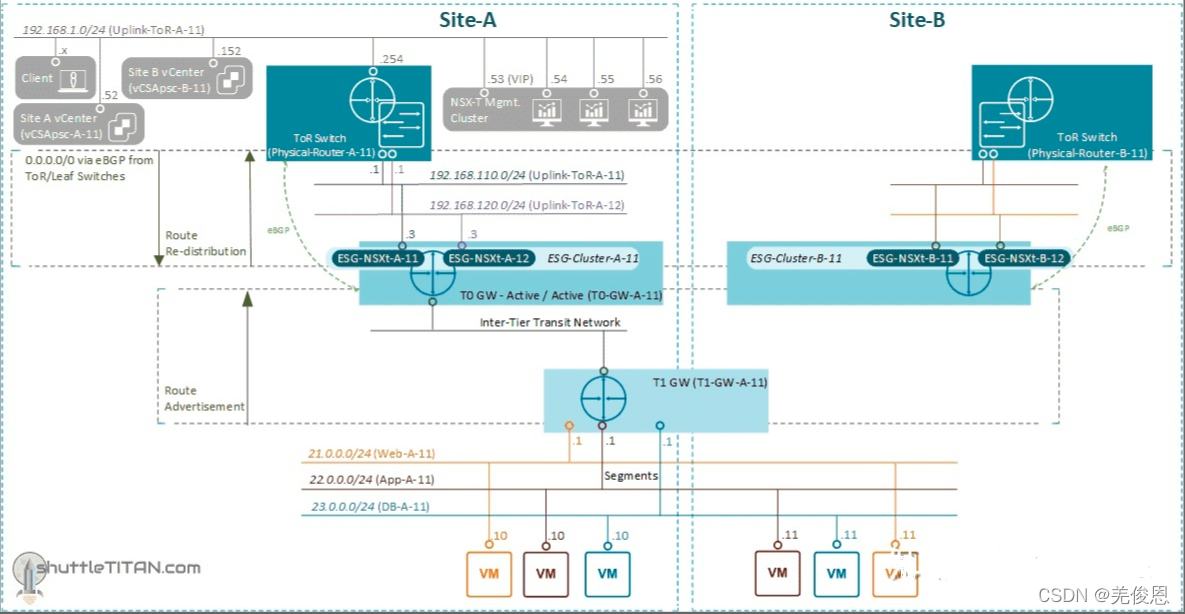

1)Tier-0 网关

Tier-0 网关执行 Tier-0 逻辑路由器的功能,负责处理逻辑网络和物理网络之间的流量。Edge 节点只能支持一个 Tier-0 网关或逻辑路由器。因此在创建 Tier-0 网关或逻辑路由器时,我们需要确保创建的 Tier-0 网关或逻辑路由器不超过 NSX Edge 集群中的 Edge 节点数。Tier-0 网关一般下链Tier-1 网关及到物理网络的外部连接;还可以在 Tier-0 网关上配置到外部网络的静态路由。在配置静态路由后,不需要将该路由从 Tier-0 通告到 Tier-1,Tier-1 网关会自动学习到它连接的 Tier-0 网关的静态默认路由。

2)Tier-1 网关

Tier-1 网关具有通往分段的下行链路连接和通往 Tier-0 网关的上行链路连接;Tier-1 网关通常在北向方向连接到 Tier-0 网关,在南向方向连接到分段。可以在 Tier-1 网关上配置路由通告和静态路由。支持递归静态路由。

3)逻辑路由DLR

4)微分段

在 NSX-T Data Center 中,分段是第 2 层虚拟域。分段之前称为逻辑交换机。 它是一个为虚拟机接口和网关接口提供虚拟第2 层交换的实体。NSX-T Data Center 中共有两种类型的分段:

VLAN 支持的分段:它是作为物理基础架构中的传统 VLAN 实施的第 2 层广播域。意味着两台不同主机上的两个虚拟机之间的流量(连接到同一个 VLAN 支持的分段)将通过两个主机之间的 VLAN 进行传输。由此产生的限制是,您必须在物理基础架构中置备相应的 VLAN,以使这两个虚拟机通过 VLAN 支持的分段在第 2 层上进行通信。

Overlay网络支持的分段:不同主机上的两个虚拟机之间的流量(连接到同一覆盖网络分段)的第 2 层流量由主机之间的隧道传输。NSX-T Data Center 实例化并维护此 IP 隧道,而无需在物理基础架构中进行任何特定于分段的配置。因此,虚拟网络基础架构将与物理网络基础架构分离。也就是说,可以在不配置物理网络基础架构的情况下动态创建分段。

5)主机交换机:

它管理的对象是为网络中的各个主机提供网络连接服务的虚拟网络交换机。该对象会在加入 NSX-T 网络连接的每个主机上进行实例化。NSX-T 中支持以下主机交换机:

1、NSX-T 虚拟分布式交换机:NSX-T 引入了一个主机交换机,以使各个计算域(包括多个 VMware vCenter Server 实例、KVM、容器以及其他外部部署或云实施)之间的连接实现标准化。

可以根据环境中所需的性能来配置 NSX-T 虚拟分布式交换机:

标准:为常规工作负载(此类工作负载需要常规的流量吞吐量)配置。

增强:为电信工作负载(此类工作负载需要较高的流量吞吐量)配置。

2、vSphere 分布式虚拟交换机:为 vCenter Server 环境中与交换机关联的所有主机的网络连接配置提供集中化管理和监控。

更多参看官方文档。

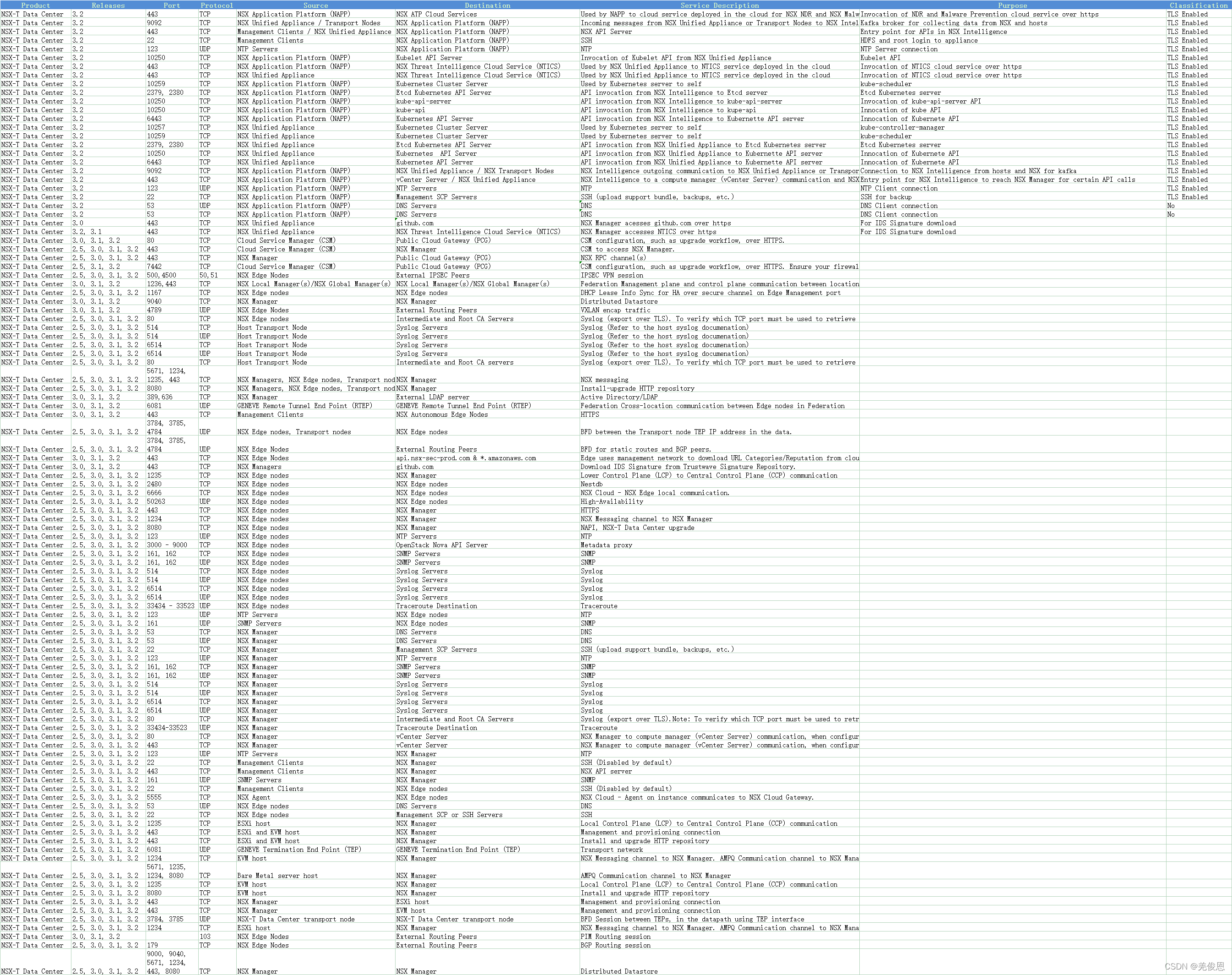

2.2 端口和协议

三、相关概念

3.1、相关概念

1)异构性:

为了满足异构环境的需要,NSX-T的一个基本要求是不依赖于任何计算管理器。由于还要支持多个虚拟化程序和/或多个工作负载,它不在受没有NSX到vCenter的1:1映射这种约束。在设计NSX-T的管理层、控制层和数据层组件时,特别考虑了灵活性、可扩展性和性能。

它的管理平面是独立于任何计算管理器(包括vSphere)设计的。VMware NSX-T®Manager™是完全独立的;NSX功能的管理是直接进行的,无论是通过编程还是通过GUI。

而控制平面被分为两个组件——>集中式集群(CCP)和特定endpoint端的本地组件(LCP)。这使得控制平面能够随着本地化实现(数据平面实现和安全实施)的提高而扩展,更有效率并且允许异构环境。

对于数据平面,在不同的环境中被设计成特定规范化的实例。NSX-T引入了一个主机交换机,它规范了各种计算域之间的连接,包括多个VMware vCenter®实例、KVM、容器和其他非本地实现,此交换机称为N-VDS。N-VDS交换机的全部功能内嵌在ESXi VDS7.0中完全实现,这允许ESXi客户再不更改VDS的情况就就能充分利用完整的NSX-T功能,提供了一致性的体验。

2)应用一致性

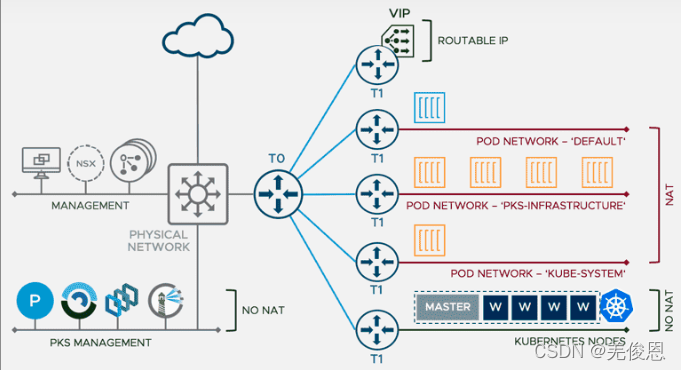

MSX-T为运行在虚拟机或容器上的工作负载提供无缝网络虚拟化,NSX支持多个CaaS(Communications-as-a-Service,相关的还有MAAS和TAAS)和PaaS解决方案;NSX-T是以应用程序为关键结构构建的,完美支持容器和云原生应用;NSX提供了一个通用的框架来管理和增加可视性,包含从物理服务器到vm和容器的一切内容的环境;

NCP的主要组件运行在一个容器中,并与NSX管理器和Kubernetes API服务器(在k8s/openshift的情况下)进行通信。NCP监控对容器和其他资源的更改。它还通过NSX API管理容器的网络资源,如逻辑端口、交换机、路由器和安全组。

3.2、 VDS NSX-T 注意事项

NSX-T 的设计初衷是作为独立于 vSphere 的网络虚拟化平台。当然,目标并不是完全丢弃 vSphere,而是为了提供更大的跨度网络,提供超出vsphere的服务。同一 NSX-T 可以同时为多个 vCenter 提供网络服务,例如,扩展到 KVM,云或裸机服务器。

与 vSphere 分离的另一个原因是允许 NSX-T 拥有自己的发行周期,因此功能和错误修复将独立于 vSphere 的时间轴。为实现这一目标,NSX-T 虚拟交换机 N-VDS 正在利用现有的软件基础架构,允许 vSphere 通过对第三方虚拟交换机的一组 API 调用来使用网络连接。因此,NSX-T 分段以“模糊网络”的形式表示,这一名称清楚地显示这些对象是完全独立且无法从 vSphere 管理的。

在NSX-T 3.0,现在可以在 VDS 上直接运行 NSX-T(VDS 版本必须至少为 7.0)。NSX-T 仍然独立于 vCenter,因为它可以在多个 vCenter 之间无缝运行。但是,由于它需要 VDS,因此 NSX-T 现在需要使用 vCenter 才能在 ESXi 主机上运行。

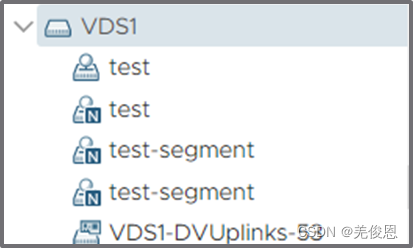

NSX-T 网段 分段的范围是由它所属的传输区域定义的。这意味着,如果在传输区域"Overlay"中定义"test-segment",则此分段将在连接到传输区域Overlay"的所有主机上可供使用。如下图所示,N-VDS(称为"nvds1")下挂了(准备了)2台ESXi主机,它们共用一个网络分段:

上图的左侧显示 vCenter 中"test-segment"的 Opaque(模糊) 网络表示形式。管理员可以通过选择 Opaque 网络,将 ESXi1 和 ESXi2 上的虚拟机的虚拟网卡直连到此分段。下面是 MOB(受管对象浏览器)快照,其中显示了 vCenter 上有关 Opaque 网络的信息,注意"摘要"和部分"extraConfig"的内容:

从图上有主要以下内容:

- 逻辑交换机"test-segment"的名称。

- 逻辑交换机 UUID:“7884ca6a-4e8f-4b52-98f6-a265cf0e19f8”。

- 当 Opaque 网络代表一个NSX分段时,extraConfig 字段也会提供分段路径:“/infra/segments/test-segment”。 如果虚拟机连接到此 Opaque 网络,则还会显示更详细的信息,显示网络类型和逻辑交换机的 UUID:

● VDS 上打开NSX-T 功能:

如上图所示,可以在两个主机上将"test-segment"作为 dvportgroup 提供。我们将此称为"NSX-T dvportgroup",因为它是 NSX-T 的 dvportgroup 表示。dvportgroup 图标还显示一个小"N",表示我们正在处理 NSX-T 对象。但是,从网络使用者的角度看:虚拟机可以连接到 dvportgroup NSX-T,就像在前一种情况下可以连接到 Opaque 网络一样。由于 dvportgroup 属于 VDS,因此可以看到层次结构中的"VDS1"下显示"test-segment"。对应 MOB下的 NSX-T dvportgroup如下:

上图中,左侧部分与常规 dvportgroup 类似。图表右侧表示的"config"部分注意下:

- 存在值为 NSX 的"backingType",明确指明这是 NSX 对象。

- 可获取分段名称和分段 ID及分段所属的传输区域的名称和 UUID NSX-T。请注意,这两个字段在这一特定场景中是相同的;

- 与分段关联的逻辑交换机由"logicalSwitchUuid"字段引用。注意,该值与显示在上一个基于 N-VDS 的示例中的"opaqueNetworkId"相同。这是因为我们是在 vCenter 中以不同方式表示相同的对象。

- dvportgroup 的NSX-T始终为"临时"。当虚拟机连接到此 dvportgroup NSX-T时,backend将仅指向上面 NSX-T dvportgroup 对象:

● NSX-T 在多个 VDS 上情况:

上图为 ESXi1 主机在 VDS1 上运行 NSX 而 ESX2 主机在 VDS2 顶部运行 NSX-T 时发生的情况。图中左侧的 vCenter 网络视图显示 VDS1 和 VDS2,每个 VDS1 和 VDS2 都有一个称为"test-segment"的 NSX-T dvportgroup。因为在 VDS 上运行 NSX-T 主要就是使用不同 vCenter 表示的 NVDS 模型,但功能必须保持不变。因此,在这种情况下,"test-segment"的范围仍由"Overlay"传输区域定义。ESXi host1 和 host2 连接到同一个"OverLay"传输区域,因此"OverLay"中定义的分段必须在 host1 和 host2 上可用。由于 dvportgroup 是在 vCenter 中的 VDS 下定义的,因此我们需要复制 VDS1 和 VDS2 上的 NSX-T dvportgroup。这两个 dvportgroup 实际上是同一个虚拟端口 NSX-T两个不同的 VDS 中的表示形式。下图显示了 MOB 中 VDS2 下 dvportgroup NSX-T"test-segment"的信息:

如上所示,可以看到 VDS2 下的 NSX-T dvportgroup 具有与 VDS1 (dvportgroup-57) 下不同的受管对象 ID (dvportgroup-59)。这些对象是两个不同的 vCenter 对象。但是,它们指向同一个 NSX-T 分段中检查 logicalSwitchUuid 和 segmentID 字段,当然这2 字段也就是一样的。

下图显示了:NSX-T 在主机 1 中的 VDS 上安装 ,而 host2 使用 N-VDS 准备的情况。在这种情况下,分段"test-segment"的 opaque 网络和 NSX-T dvportgroup 表示均将显示在 vCenter 中。

在 NSX-T 2.3 之前,表示第 2 层广播域的对象是逻辑交换机,在逻辑交换机 UUID NSX 唯一标识。

NSX-T 2.4 引入了分段的概念,用于相同的目的。分段是一个对象,包括逻辑交换机以及一些额外参数,如下所示:

分段由分段路径唯一标识。上述示例中使用的分段将"/infra/segments/test-segment"作为分段路径。路径的最后一部分(此处为"test-segment")称为分段 ID。在大多数情况下,分段 ID 是分段的名称。

同一分段跨越多个 VDS,当传输区域扩展到为 NSX 准备的多个 VDS 时,每个 VDS 将针对传输区域的每个分段提供一个 NSX-T dvportgroup。这些 NSX-T dvportgroup 将按它们表示的分段进行命名,这意味着多个 dvportgroup 具有相同的名称。这是 vCenter 以前无法实现的信息: dvportgroups 在 vCenter 中以前是唯一的。

对于NSX-T的分段,该分段路径是分段的唯一标识符,此标识符 NSX-T。可以让网络管理员为多个分段使用相同的名称。NSX-T 确保分段的 ID 不同。假设在"Overlay"传输区域中创建第二个"test-segment"。可注意到,此新分段的分段 ID 后面附加了一个额外的字符串,以便不同于现有的字符串。

注意,vCenter 不会允许创建名称与 dvportgroup 中的现有 dvportgroup同名的 NSX-T dvportgroup;但是,如果 dvportgroup 表示 VDS 下已存在"test",NSX-T 在创建 NSX-T dvportgroup"test",两个"test"dvportgroup 在此处的类型不相同:

PowerCLI 的 NSX 分布式端口组查询:

Get-VDPortGroup -Name "MyVDPortGroup" -VDSwitch "MyVDSwitch"

//如果某个特定的分布式端口组需要使用 LogicalSwitch UUID 进行引用,则可以使用 ExtensionData 过滤特定的 UUID。

Get-VDPortGroup -VDSwitch "MyVDSwitch" | where {

$_.ExtensionData.Config.LogicalSwitchUuid -eq ‘9c6388c3-2ad6-41c6-bcaa-a23edefcea38’}

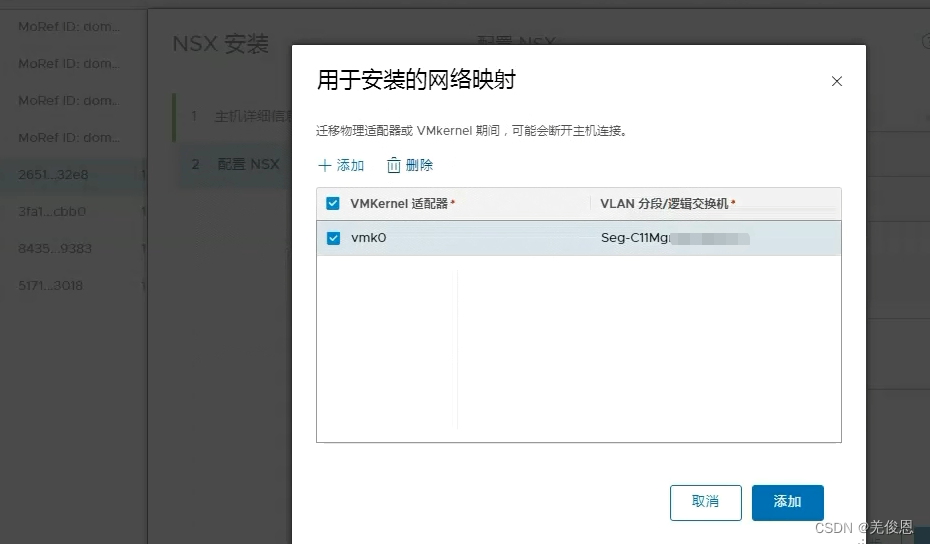

3.3、VMkernel从vss迁移到 N-VDS Switch

从 NSX-T Data Center 3.0 开始,可以使用 vSphere Distributed Switch 创建传输节点。要在安装期间将 VMkernel 迁移到 N-VDS 交换机,请将 VMkernel 映射到现有逻辑交换机。NSX Manager将 VMkernel 迁移到 N-VDS 上的映射逻辑交换机。要在集群级别将 VMkernel 接口从 VSS 或 DVS 交换机迁移到 N-VDS 交换机,请使用迁移所需的网络映射详细信息(将 VMkernel 接口映射到逻辑交换机)配置传输节点配置文件。同样,要迁移主机节点上的 VMkernel 接口,请配置传输节点配置。要将 VMkernel 接口迁移回 VSS 或 DVS 交换机,请在要在卸载过程中实现的传输节点配置文件中配置卸载网络映射(将逻辑端口映射到 VMkernel 接口)。在迁移期间,当前正在使用的物理网卡将迁移到 N-VDS 交换机,而可用或空闲物理网卡则在迁移后连接到 N-VDS 交换机。传输节点配置文件应用到集群的所有成员主机。但是,如果您希望在特定主机上限制 VMkernel 接口的迁移,您可以直接配置主机。迁移后,N-VDS 将为连接到 N-VDS 交换机的那些接口处理 VLAN 和覆盖网络上的流量。在使用 NSX-T UI 或传输节点 API 将 VMkernel 接口和 PNIC 从 VDS 迁移到 N-VDS 交换机后,vCenter Server 将为 VDS 显示警告。如果主机需要连接到 VDS,请从 VDS 中移除主机。vCenter Server 将不再为 VDS 显示任何警告。对于:将 VMkernel 接口迁移回 VSS 或 DVS 交换机,卸载 NSX-T Data Center 时将 VMkernel 接口从 N-VDS 交换机迁移回 VSS 或 DVS 交换机,将 VMkernel 迁移回 DVS 交换机上的端口组时,请确保将端口组类型设置为 临时(ephemeral)。

试验条件:

vmk0 和 vmk1 连接到 vSwitch0,并在 vSwitch0 上将 vmnic0 和 vmnic1 分别配置为上行链路 1 和 2。

NVSX 交换机没有配置任何 vmnic 或 VMkernel 适配器。

迁移前, ESXi 主机需具有来自两个物理端口 vmnic0 和 vmnic1 的两个上行链路。此处,vmnic0 配置为处于活动状态且连接到 VSS,而 vmnic1 未使用。此外,还有三个 VMkernel 接口:vmk0、vmk1 和 vmk2。可以使用 NSX-T Data Center Manager UI 或 NSX-T Data Center API 迁移 VMkernel 接口。迁移后,vmnic0、vmnic1 及其 VMkernel 接口将迁移到 N-VDS 交换机。vmnic0 和 vmnic1 通过 VLAN 和覆盖网络传输区域进行连接。

VMkernel 迁移的注意事项:

- 物理网卡和 VMkernel 迁移:将固定物理网卡和关联的 VMkernel 接口迁移到 N-VDS 交换机之前,请记下主机交换机上的网络映射(物理网卡到端口组映射)。

- 仅物理网卡迁移:如果打算仅迁移物理网卡,请确保不要迁移已连接到管理 VMkernel 接口的管理物理网卡。这会导致失去与主机的连接。关联添加传输节点配置文件中的仅迁移 PNIC 字段。

- 恢复迁移:计划将 VMkernel 接口迁移回固定物理网卡的 VSS 或 DVS 主机交换机之前,请确保记下主机交换机上的网络映射(物理网卡到端口组映射)。这是使用卸载的网络映射字段中的主机交换机映射配置传输节点配置文件的必备条件。如果没有此映射,NSX-T Data Center 不知道必须将 VMkernel 接口迁移回哪些端口组。这种情况可能会导致失去与 vSAN 网络的连接。

- 在迁移前注册 vCenter Server:如果计划迁移连接到 DVS 交换机的 VMkernel 或物理网卡,请确保向 NSX Manager 注册 vCenter Server。

- 匹配 VLAN ID:迁移后,管理网卡和管理 VMkernel 接口必须位于管理网卡迁移前所连接的同一个 VLAN 上。如果 vmnic0 和 vmk0 已连接到管理网络并迁移到不同的 VLAN,那么将失去与主机的连接。

- 迁移到 VSS 交换机:无法将两个 VMkernel 接口迁移回 VSS 交换机的同一个端口组。

- vMotion:在 VMkernel 和/或 PNIC 迁移之前,执行 vMotion 以将虚拟机工作负载移动到另一个主机。如果迁移失败,则工作负载虚拟机不会受到影响。

- vSAN:如果正在主机上运行 vSAN 流量,请通过 vCenter Server 将主机置于维护模式,并在 VMkernel 和/或 PNIC 迁移之前使用 vMotion 功能将虚拟机从主机中移出。

- 迁移:如果 VMkernel 已连接到目标交换机,则仍然可以选择该 VMkernel 以迁移到同一交换机。该属性允许执行幂等 VMK 和/或 PNIC 迁移操作。如果希望仅将 PNIC 迁移到目标交换机,这是非常有用的。由于迁移始终需要至少一个 VMkernel 和一个 PNIC,因此,在仅将 PNIC 迁移到目标交换机时,可以选择已迁移到目标交换机的 VMkernel。如果不需要迁移任何 VMkernel,请通过 vCenter Server 在源交换机或目标交换机中创建一个临时 VMkernel。然后,将其与 PNIC 一起迁移,并在迁移完成后通过 vCenter Server 删除临时 VMkernel。

- MAC 共享:如果 VMkernel 接口和 PNIC 具有相同的 MAC 并且它们位于同一交换机中,则必须将它们一起迁移到同一目标交换机(如果在迁移后使用它们)。请始终将 vmk0 和 vmnic0 保留在同一交换机中。可以运行以下命令,以检查主机中的所有 VMK 和 PNIC 使用的 MAC:

esxcfg-vmknic -l

esxcfg-nics -l

\- 在迁移后创建的 VIF 逻辑端口:在将 VMkernel 从 VSS 或 DVS 交换机迁移到 N-VDS 交换机后,将在 NSX Manager 上创建 VIF 类型的逻辑交换机端口。不能在这些 VIF 逻辑交换机端口上创建分布式防火墙规则。

VDS 7.0版本,NSX-T3.2版本可以直接在VDS上运行NSX-T;

传输节点配置文件是一个模板,可用于定义应用于集群的配置。它不适用于准备独立主机。通过应用传输节点配置文件,将 vCenter Server 集群主机准备好作为传输节点。传输节点配置文件定义传输区域、成员主机、N-VDS 交换机配置(包括上行链路配置文件、IP 分配、物理网卡到上行链路虚拟接口的映射等)。传输节点配置文件仅适用于主机。它不能应用于 NSX Edge 传输节点。在传输节点配置文件应用于 vCenter Server 集群时,开始创建传输节点。NSX Manager 准备集群中的主机,并在所有主机上安装 NSX-T Data Center 组件。主机的传输节点基于在传输节点配置文件中指定的配置进行创建。注意:

NSX-T Data Center 提供了流量隔离以便通过第一个 N-VDS 的流量与通过第二个 N-VDS 的流量隔离,以此类推。每个 N-VDS 上的物理网卡必须映射到主机上的 Edge 虚拟机,以允许与外界的南北向流量连接。从第一个传输区域上的虚拟机移出的数据包必须通过外部路由器或外部虚拟机路由到第二个传输区域上的虚拟机。

每个 N-VDS 交换机的名称都必须唯一。NSX-T Data Center 不允许使用重复的交换机名称。

传输节点配置或传输节点配置文件配置中与每个 N-VDS 或 VDS 主机关联的每个传输区域 ID 都必须是唯一的。

浏览器中,使用管理员权限登录到 https:// 中的NSX Manager,即NSX-T独立页面,系统 > Fabric > 配置文件 > 传输节点配置文件 > :

如果主机已配置成为了传输节点,我们可以利用【迁移 ESXi VMkernel 和物理适配器】,转至系统 > Fabric > 主机传输节点,选择传输节点,然后单击操作 > 迁移 ESX VMkernel 和物理适配器。更新后的 VMkernel 适配器和物理适配器将迁移到 N-VDS 交换机或将已迁移项恢复到 ESXi 主机中的 VSS 或 VDS 交换机。

注意:上述两个vmnic与uplink的映射关系要一致,否则会迁移失败

将 VMkernel 接口迁移到 N-VDS 交换机的汇总工作流:

如果需要,创建逻辑交换机。在要将 VMkernel 接口和物理网卡迁移到 N-VDS 交换机的主机上关闭虚拟机的电源。

使用创建传输节点时用于迁移 VMkernel 接口的网络映射配置传输节点配置文件。网络映射意味着将 VMkernel 接口映射到逻辑交换机。

确认 vCenter Server 中的网络适配器映射反映了 VMkernel 交换机与 N-VDS 交换机的新关联。如果是固定物理网卡,请确认 NSX-T Data Center 中的映射反映了固定到 vCenter Server 中的物理网卡的任何 VMkernel。

在 NSX Manager 中,转至网络 → 分段。在分段页面上,确认 VMkernel 接口已通过新创建的逻辑端口连接到分段。

转到系统 > 节点 > 主机传输节点。对于每个传输节点,确认节点状态列上的状态为“成功”,以确认已成功验证传输节点配置。

在主机传输节点页面上,确认配置状态上的状态为“成功”,以确认已成功使用指定的配置实现主机。

将网络接口迁移到 N-VDS 之前和之后:

将 VMkernel 接口和物理网卡从 VSS 或 DVS 交换机迁移到 N-VDS 交换机,或者将接口迁移回 VSS 或 DVS 主机交换机时,可能会遇到如下错误:

| 错误代码 | 问题 | 原因 | 解决方案 |

|---|---|---|---|

| 8224 | 找不到传输节点配置指定的主机交换机。 | 找不到主机交换机 ID。 | * 请确保使用主机交换机名称创建传输区域,然后创建传输节点。 * 请确保在传输节点配置中使用有效的主机交换机。 |

| 8225 | VMkernel 迁移正在进行中。 | 迁移正在进行中。 | 等待迁移完成后再执行其他操作。 |

| 8226 | VMkernel 迁移仅在 ESXi 主机上受支持。 | 迁移仅对 ESXi 主机有效。 | 请确保在启动迁移之前该主机为 ESXi 主机。 |

| 8227 | 主机交换机名称未附加 VMkernel 接口。 | 在具有多个主机交换机的主机上,NSX-T Data Center 无法识别每个 VMkernel 接口与其主机交换机的关联。 | * 如果主机具有多个 N-VDS 主机交换机,请确保主机所连接的 N-VDS 的主机交换机名称附加 VMkernel 接口。 * 例如,卸载具有 N-VDS 主机交换机名称 nsxvswitch1 和 VMkernel1 以及另一个 N-VDS 主机交换机名称 nsxvswitch2 和 VMkernel2 的主机的网络映射必须进行如下定义:device_name: VMkernel1@nsxvswitch1, destination_network: DPortGroup。 |

| 8228 | 在主机上未找到在 device_name 字段中使用的主机交换机。 | 主机交换机名称不正确。 | 输入正确的主机交换机名称。 |

| 8229 | 传输节点未指定逻辑交换机的传输区域。 | 未添加传输区域。 | 将传输区域添加到传输节点配置。 |

| 8230 | 主机交换机上没有物理网卡。 | 主机交换机上必须至少有一个物理网卡。 | 至少为上行链路配置文件指定一个物理网卡,并为逻辑交换机指定 VMkernel 网络映射配置。< |