介绍

这篇文章提出了一种新的深度匹配器,LightGlue,基于深度神经网络,用来匹配图像中的局部特征。

可以说,这个LightGlue是SuperGlue的加强版本,相比于SuperGlue,在内存和计算方面更高效,同时结果更准确,也更容易训练,SuperGlue是在其之前性能最好的特征匹配算法。

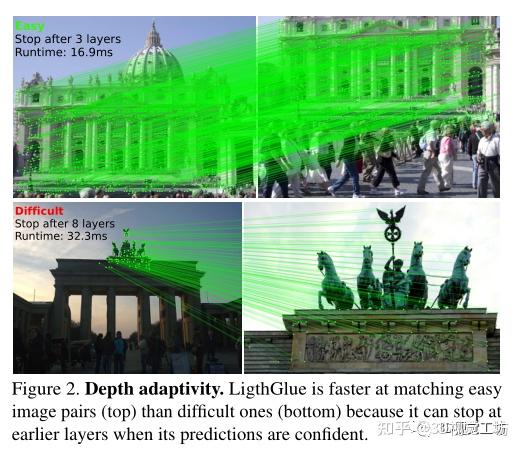

LightGlue通过适应每幅图像的难度来决定什么时候退出推理。图像匹配的难度取决于两幅图像视觉重叠度、外观变化程度。在直观上容易匹配的图像对上推理比在具有挑战性的上要快得多,这是通过在每个计算块之后预测一组对应关系使模型能够预测是否需要进一步计算来实现最终目的。LigthGlue也会在早期阶段丢弃不可匹配的点,从而将注意力集中在共视区域。

特征匹配

简单介绍特征匹配定义:特征匹配是寻找两幅图像之间的特征对应关系,是许多计算机视觉应用的基本组成部分,最常见的图像匹配方法依赖于稀疏特征点,通过对特征点局部视觉外观编码成高维向量进行匹配。这里也推荐「3D视觉工坊」新课程《面向自动驾驶领域目标检测中的视觉Transformer》

特征匹配的难点在于弱纹理、视点和照明变化而导致的外观变化等,而且为了筛选由遮挡和缺失点引起的外点,特征表示应该是有区别的。要保证稳健性和唯一性。

SuperGlue与LightGlue的区别联系:

SuperGlue将Transformer的表达表示与最优传输相结合以解决部分分配问题。它学习关于场景几何和相机运动的强大先验,因此对极端变化具有鲁棒性,并能很好地在数据域中泛化。但是SuperGlue和其他基于Transformer的模型一样,很难训练,需要一般人无法获得的计算资源来训练。

之前SuperGlue用MLP对绝对点位置进行编码,并在网络靠前的层将其与描述子融合,作者观察到这样做的话模型在层间传递时会忘记位置信息。而LightGlue依赖于一种相对编码,这种编码在图像之间更具可比性,并添加到每个自注意力单元中,这样可以更容易地利用位置,并提高更深层次的精度。

在预测头方面,SuperGlue通过使用Sinkhorn算法解决可微最优传输问题来预测匹配,包括行和列归一化的多次迭代,这在计算和内存方面都很昂贵,SuperGlue还添加了一个dustbin来拒绝无法匹配的点,作者发现dustbin纠缠了所有点的相似性得分,从而产生了次优的训练,而LightGlue将相似性和可匹配性解耦,这两个问题的预测效率要高得多,产生了更清洁的梯度。

在训练监督方面,由于Sinkhorn的价格昂贵,SuperGlue无法在每层之后进行预测,只能在最后一层进行监督,LightGlue较轻的head使其能够预测每一层的分配并对其进行监督,这加快了收敛速度,并使其能够在任何层退出推理,这是LightGlue提高效率的关键。

LightGlue网络

LightGlue由一堆L个相同的层组成,这些层共同处理一对图像,每一层都由自注意力单元和交叉注意力单元组成,它们更新每个点的表示。然后,分类器在每一层决定是否停止推理,从而避免不必要的计算。轻量级头最终根据表示集计算匹配。

注意力单元:

在每个单元中,多层感知器(MLP)根据从图像A,B聚合的信息更新状态

在自注意单元中,每个图像I从同一图像的点提取信息,在交叉关注单元中,每个图像从另一个图像提取信息,该信息由注意力机制计算为图像的所有状态j的加权平均值:

其中W是投影矩阵,是图像i和S的点i和j之间的注意力得分。对于自注意力单元和交叉注意力单元,该得分的计算方式不同。

对于自注意力单元,每个点都涉及同一图像的所有点。首先通过不同的线性变换将当前状态xi分解为键向量和查询向量ki和qi,然后,我们将点i和j之间的注意力得分定义为

其中是点之间相对位置的旋转编码,将空间划分为d/2个2D子空间,并根据傅立叶特征将每个子空间旋转一个对应于投影的可学习的偏差角度:

位置编码是注意力的关键部分,因为它允许根据不同元素的位置对其进行寻址,作者观察到在投影相机几何中,视觉观察的位置与相机在图像平面内的平移是等变的:源于同一正面到平行平面上的3D点的2D点以相同的方式平移,并且它们的相对距离保持不变。这需要一种只捕捉点的相对位置而不捕捉点的绝对位置的编码。所以旋转编码使模型能够从i检索位于学习的相对位置的点j。

针对交叉注意力,I中的每个点都涉及另一个图像S的所有点,为每个元素计算一个关键字ki,但没有查询。这允许将分数表示为:

因此只需要为两个I计算一次相似性信息,这被称为双向注意力。

对应预测

设计了一个轻量级的head,它可以在任何层的更新状态下预测匹配。

先计算两个图像的点之间的成对得分矩阵:

其中Linear(·)是一个学习的带有偏差的线性变换,该分数将每对点的亲和性编码为对应的,即同一3D点的2D投影,还为每一点计算一个匹配性得分:

该分数对i具有对应点的可能性进行编码。在其他图像中未检测到的点,例如被遮挡时,是不可匹配的,因此为0.

将相似性和可匹配性得分组合到软分配矩阵P中,如下所示:

当两个点都被预测为可匹配并且当它们的相似性高于两个图像中的任何其他点时,一对点(i,j)产生对应关系,选择Pij大于阈值τ并且在行和列上都大于任何其他元素的对。

时间上如何节省

作者添加了两种机制来避免不必要的计算并节省推理时间:

i)根据输入图像对的难度来减少层数;ii)删除了早期被坚定拒绝的点。

LightGlue的主干通过上下文增强了输入视觉描述符,如果图像对很容易,即具有高的视觉重叠和很少的外观变化,则这些通常是可靠的,在这种情况下,早期层的预测是有信心的,并且与晚期层的预测相同,然后可以输出这些预测并停止推理。

在每个层的末尾,LightGlue推断每个点预测分配的置信度:

更高的值表示i的表示是可靠的。

对于给定层, 如果ci>λ,则认为一个点是有信心的,如果所有点的充分率α是可信的,则停止推理:

当不满足退出标准时,被预测为可信和不可匹配的点不太可能有助于后续层中其他点的匹配。例如,这些点位于图像中明显不可见的区域。因此在每一层都丢弃它们,只将剩余的点馈送到下一层。考虑到注意力的二次复杂性,这显著减少了计算量,并且不会影响准确性。

如何训练

分两个阶段训练LightGlue:首先训练它来预测对应关系,然后才训练置信度分类器。因此,后者不会影响最终层的准确性或训练的收敛性。

监督具有从两个视图变换估计的用真值标注的分配矩阵P。给定单应性或像素深度和相对姿态,将点从图像A wrap到B,反之亦然。

真值匹配M是在两个图像中具有低重投影误差和一致深度的点对。当一些点A和B的重投影或深度误差与所有其他点足够大时,它们被标记为不可匹配。然后最小化在每一层预测的分配的对数似然性ℓ, 推动LightGlue尽早预测正确的对应关系:

然后训练MLP来预测每一层的预测是否与最后一层相同,最小化层的分类器的二进制交叉熵。

实验:

评估了LightGlue在单应性估计、相对姿态估计和视觉定位任务上的性能。

单应估计

评估了LightGlue在HPatches数据集的平面场景上估计的对应关系的质量,该数据集由5个图像对的序列组成。

报告了与GT匹配相比的精度和召回率,3个像素内的重投影误差。对于每个图像对,计算四个图像的平均重投影误差,并报告累积误差曲线下的面积(AUC)。

从结果来看,LightGlue比SuperGlue和SGMNet有着更高的精度和相似的召回率,当使用DLT估计单应性时,这导致比使用其他匹配器更准确的估计。因此,LightGlue使DLT这样一个简单的求解器达到了与昂贵且较慢的MAGSAC相比的竞争力。在5px的粗略阈值下,LightGlue也比LoFTR更准确。

相对位姿估计

评估了LightGlue在户外场景中的姿势估计,这些场景表现出强烈的遮挡和具有挑战性的照明和结构变化。

使用MegaDepth-1500测试集的图像对。该测试集包含来自两个热门摄影旅游目的地的1500对图片,数据的收集方式是根据视觉重叠来平衡难度。这里也推荐「3D视觉工坊」新课程《面向自动驾驶领域目标检测中的视觉Transformer》

从结果来看,LightGlue在SuperPoint特征上大大优于现有的方法SuperGlue和SGMNet,并且可以大大提高DISK局部特征的匹配精度。它产生了更好的对应关系和更准确的相对姿态,并将推理时间减少了30%。LightGlue通常比SuperGlue预测的匹配次数略少,但这些预测更准确。通过在模型的早期检测到有信心的预测,自适应变体比SuperGlue和SGMNet快2倍以上,而且更准确。考虑到准确性和速度之间的权衡,LightGlue在很大程度上优于所有方法

视觉定位任务

使用Aachen Day-Night数据集来评估在具有挑战性的条件下的长期视觉定位。使用hloc遵循分层定位框架。首先使用COLMAP,在已知姿态和校准的情况下,从4328幅日间参考图像中对稀疏的3D点云进行三角化。对于824个白天和98个夜间查询中的每一个,使用NetVLAD检索50张图像,对它们进行匹配,并使用RANSAC和Perspective-n-Point解算器估计相机姿势。报告了在多个阈值下的姿态召回以及在建图和定位过程中匹配步骤的平均时间。

结果来看,LightGlue达到了与SuperGlue类似的精度,但时间少2.5倍。

优化后的变体利用了有效的自注意力,使吞吐量增加了4倍。LightGlue因此可实时匹配多达4096个关键点。

总结:

介绍了一种用于特征匹配的深度神经网络LightGlue。在SuperGlue成功的基础上,将注意力机制的力量与关于匹配问题的见解以及Transformer最近的创新相结合,赋予这个模型反思其自身预测可信度的能力,使计算量适应每个图像对的难度。LightGlue比之前表现最好的SuperGlue更快、更准确、更容易训练!