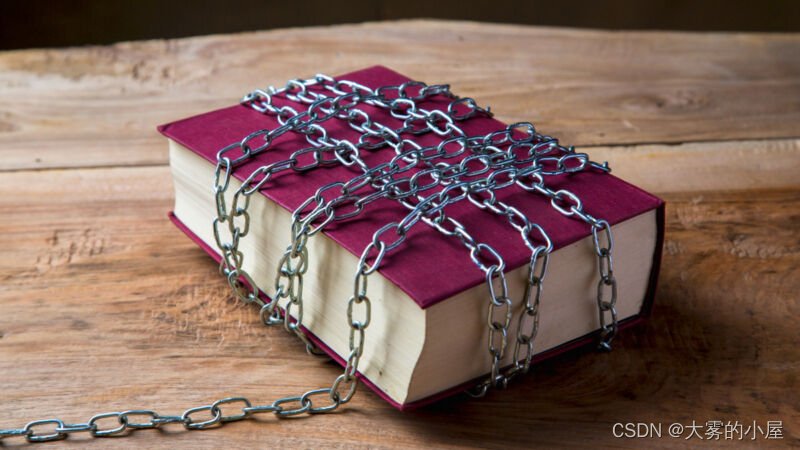

为了响应爱荷华州最近颁布的立法,管理员们正在从梅森市学校图书馆移除禁书,官员们正在使用ChatGPT帮助他们挑选书籍,根据公报和大众科学.

由州长金·雷诺兹签署的禁令背后的新法律是教育改革浪潮的一部分,共和党立法者认为这是保护学生免受有害和淫秽材料影响的必要措施。具体来说,参议院496号文件根据爱荷华州法规702.17,要求学校图书馆提供给学生的每本书都是“适合年龄”的,没有任何“性行为的描述或视觉描绘”。

但管理员表示,禁书是一项艰巨的工作,因此他们需要依靠机器智能在法律规定的三个月时间内完成这项工作。“阅读每本书并过滤这些新要求是完全不可行的,”该学区的助理主管Bridgette Exman在公报引用的一份声明中说。“因此,我们正在使用我们认为是合理的过程来确定应该在23-24学年开始时从藏书中删除的书籍。”

该学区分享了他们的方法:“我们从几个来源收集了一些常见的有争议的书籍,以创建一个应该被评论的书籍的主列表。这个主列表上的书籍被过滤掉了,以寻找与性内容相关的挑战。使用人工智能软件来审查这些文本,以确定它是否包含对性行为的描述。基于这一审查,有19个文本将从我们7-12学校图书馆的收藏中删除,并存储在行政中心,同时我们等待进一步的指导或澄清。我们还会让老师检查教室图书馆的藏书。”

不适合这个目的

随着ChatGPT的发布,它已经被越来越多地常见到的人工智能助手延伸到它的能力——以及阅读它的不准确的输出被人类接受,因为自动化偏差,即倾向于过度信任机器决策。在这种情况下,这种偏见对管理员来说更加方便,因为他们可以将决策的责任传递给AI模型。然而,机器并不具备做出这种决定的能力。

大型语言模型,如那些权力ChatGPT,不是无限智慧的神谕,他们做了穷人的事实参考。他们是易于谈心信息,而这些信息不在他们的培训数据中。即使数据存在,他们的判断也不能代替人类——尤其是在法律、安全或公共健康方面。

“这是一个提示ChatGPT的完美例子,它几乎肯定会产生令人信服但完全不可靠的结果,”人工智能研究员西蒙·威廉森说,他经常写道大型语言模型,告诉Ars。“一本书是否包含对性行为的描述,这个问题只能由看过这本书全文的模型来准确回答。但是OpenAI不告诉我们ChatGPT接受了什么训练,所以我们无法知道它是否看到了有问题的书的内容。"

ChatGPT的训练数据不太可能包括每本有问题的书的完整文本,尽管这些数据可能包括关于该书内容的讨论的参考文献——如果这本书足够有名的话——但这也不是准确的信息来源。

“根据ChatGPT看到的互联网片段,我们可以猜测它可能如何回答这个问题,”威廉森说。“但缺乏透明度让我们在黑暗中工作。会不会是和书中人物有关的网络同人小说混淆了?对作者有怨恨的人在网上写的误导性评论怎么样?”

事实上,即使通过其他人的粗略测试,ChatGPT也被证明不适合这项任务。在向ChatGPT询问潜在禁书名单上的书籍时,科普发现不均衡的结果有些显然不符合已实施的禁令。

即使官员们假设将每本书的文本输入到最长的ChatGPT版本中上下文窗口32K令牌模型(令牌是单词块),它不可能一次考虑大多数书的整个文本,尽管它可能能够按块处理它。即使确实如此,人们也不应该在没有验证的情况下就相信这个结果是可靠的——无论如何,这需要一个人去读这本书。

“具有讽刺意味的是,负责教育的人没有足够的知识来批判性地确定哪些书是好的或不好的,可以纳入课程,却把这个决定外包给一个无法理解书籍,也根本无法批判性思考的系统,”玛格丽特·米歇尔博士说,首席伦理学家科学家在拥抱脸,告诉Ars。