近十年来谷歌引领着人工智能方向的发展,从TensorFlow到TPU再到Transformer,都是谷歌在引领着,然而,在大语言模型上,却被ChatGPT(OpenAI)抢了风头,并且知道GPT-4(OpenAI)的推出,谷歌依然没有推出能打的竞品都没有,甚至是后来居上的LlaMA(Meta)类的Google也败下阵来,也许是Google倾尽资源在Gemini上了。

Gemini是谷歌大脑和DeepMind和ChatGPT竞争的多模态( Visual-Language-Action (VLA) )大语言模型,其是将CPT-4和AlphaGo类系统相结合的新的多模态大语言模型。

据传Gemini是将融合多模态Encoder-Decoder的新架构,Encdoer部分对不同的数据提出供Decoder理解的特征,Decoder的任务是理解和执行。

目前的大模型是不具备规划能力,需要用知识图谱等符号主义的方法来增强,也许 Google DeepMind 找到的方法是行为主义【强化学习】的方法,而非符号主义【知识图谱】的方法。

要在人工智能中真正实现 AGI ,这中间最关键的环节是让机器能够自主地从物理世界中学习,这就要求 AGI 具备连续的视觉理解能力。当前的ChatGPT离真正的AGI还欠缺以下能力:

1.感知世界的能力:这个基础是连续视觉感知。可以猜测,Gemini 显然在尝试这个,但发布时是否具备该能力,或者到了哪种程度,现在还未知。

2.推理决策的能力:这个的基础就包括记忆和规划。在 Gemini 有关的信息中显然提到了这一点。关于记忆方面没有很多内容,神经网络本身就具备记忆功能,同时基于此前Google LaMDA模型,在记忆中加入 Google 的知识图谱(Knowledge Graph)也未必不可能。而规划方面,目前已经明确的是使用了 AlphaGo所使用的强化学习方法来增强大模型的规划能力。

3.使用工具的能力:这个就是使用工具和调用 API 的能力,使用工具可以认为是“硬”的能力,比如类似 PaLM-E 操纵机械臂的能力,而调用 API可以认为是“软”的能力。

4.自我意识能力。

在GPT-4的 “Code Interpreter”功能开放之后,我认为使用“软”工具的能力趋于成熟

Google DeepMind 在这块的技术储备是很强的,不管是 PaLM-E 还是 RoboCat,都是成功的尝试。Gemini 从视频中学习出连续的视觉理解能力是非常可能的。而一旦AGI 具备了连续的视觉理解能力,接下来的发展将势不可挡了。

Gemini 应该使用了Youtube 的视频来训练模型,结合哈萨比斯所说的在尝试使用机器人和神经科学【ranging from robotics to neuroscience】的创新方法来增强模型的能力,这就很值得品味了。很有可能就使用视频数据来训练模型的连续视觉理解能力,毕竟机器人视觉和神经科学的很重要一环就是视觉理解。

Gemini 的做一些猜测:

1.神经网络使用MoE架构【高可能性】

2.用某种方法融合了知识图谱来增强记忆【中可能性】

3.训练时用了强化学习,使用了 PPO 之外的优化方法【高可能性】

4.推断时使用了强化学习【低可能性】

5.最大参数在1T~10T 之间【高可能性】,大于10T【中可能性】,小于1T【低可能性】

6.推断时激活参数大于100B【高可能性】,小于100B【低可能性】

7.训练语料的文本词元(tokens)数量大于20~100T【高可能性】(2023年6月谷歌的monorepo Piper 模型的训练数据量是86TB),大于100T【中可能性】,小于10T【低可能性】

8.训练语料的图片10~50B 张【高可能性】,小于10B 张【低可能性】,大于50B 张【中可能性】

9.训练语料的视频大于1000万分钟【高可能性】。

10.训练时间:TPUv4 和 TPUv5 约120 天 ( GPT-5 约 ~25,000 H100/A100 ~120 天, GPT-4 @ ~25,000 A100s for ~90 天, GPT-3 @ ~1,024 A100s for 34 天)

11.预计发布时间也许是2023年9月27日Google 的25岁生日【随便猜测】,2023年年底前【高可能性】。

Gemini相关paper

Gemini在谷歌的定位是AGI,其中之一自我意识是最难的点,谷歌2023年Consciousness in Artificial Intelligence: Insights from the Science of Consciousness 的论文中预测下一个10年将产生具有自我意识的AGI,AGI的发展相关Paper。而代号Gemini是具有自我意识AGI的最迟的原型产品。下面是关于AGI发展进度情况

| 日期 | 进展总结 | 参考文献 |

|---|---|---|

| 2023年8月22日 | 60%人工智能中的意识——来自意识科学的见解,讨论的意识的定义以及如何评估是否真正具备意识 | arXiv |

| 2023年8月 | 55%GDM Soft MoE:“一个完全可微的稀疏转换器……保持MoE的优势。”。Soft MoE通过将所有输入代币的不同加权组合传递给每个专家来执行隐含的软分配…Soft MoE大大优于标准Transformers(ViTs)和流行的MoE变体(代币选择和专家选择)。” | (arXiv) |

| 2023年7月 | 54% GDM RT-2:“在机器人轨迹数据和互联网规模的视觉语言任务(如视觉问答)上共同微调最先进的视觉语言模型。” | (项目地址) |

| 2023年7月 | 52%: | Anthropic (PDF) |

| 2023年7月 | 51%: 谷歌DeepMind/普林斯顿:寻求帮助的机器人(“建模不确定性,可以补充和扩展基础模型不断增长的能力。”) | Project page |

| 2023年7月 | 51%: 微软LongNet:1B令牌序列长度(“为建模超长序列开辟了新的可能性,例如,将整个语料库甚至整个互联网视为序列。”) | Microsoft (arxiv) |

| 2023年6月 | 50%: 谷歌DeepMind RoboCat(“自主改进循环……RoboCat不仅表现出跨任务转移的迹象,而且在适应新任务方面变得更加高效。”) | DeepMind blog, Paper (PDF) |

| 2023年6月 | 50%: 微软推出了监视器引导解码(MGD)(“提高了LM…生成与基本事实相匹配的标识符的能力……提高了编译率并与基本事实保持一致。”) | Paper (arxiv) |

| 2023年6月 | 50%:前OpenAI顾问使用GPT-4在化学中实现人工智能(“指令、机器人动作、合成分子”) | Paper (arxiv), notes |

| 2023年6月 | 50%: 哈佛大学引入了“推理时间干预”(ITI)(“在高水平上,我们首先识别出一组稀疏的注意力头,这些注意力头对真实性的线性探测精度很高。然后,在推理过程中,我们沿着这些与真实性相关的方向转移激活。我们自回归地重复相同的干预,直到生成完整的答案。”) | Harvard (arxiv) |

| 2023年6月 | 49%: Google DeepMind在其86TB代码库中对LLM(DIDACT)进行迭代代码训练(“经过训练的模型可以以各种令人惊讶的方式使用……通过将多个预测链接在一起,以展开更长的活动轨迹……我们从一个空白文件开始,并要求模型连续预测接下来会进行哪些编辑,直到它写下完整的代码文件。令人惊讶的是,该模型以一种循序渐进的方式开发代码开发者) | Google Blog, Twitter |

| 2023年5月 | 49%: Ability Robotics将LLM与他们的人形机器人Digit相结合。 | Agility Robotics (YouTube) |

| 2023年5月 | 49%:PaLM 2打破了WinoGrande的90%大关。WinoGrande是一个“更具挑战性、对抗性”的Winograd版本,设计对人工智能来说非常困难,一个大型语言模型首次突破了90%的大关。微调后的PaLM 2得分为90.9%;人类占94% | PaLM 2 paper (PDF, Google) |

| 2023年5月 | 49%: Robot+text-davinci-003(“……我们展示了LLM可以直接使用现成的LLM来实现机器人的泛化,利用它们从大量文本数据中学习到的强大摘要功能。”) | Princeton/Google/others |

| 2023年4月 | 48%: 波士顿 Dynamics+ChatGPT(“我们将ChatGPT与我们的[波士顿 Dynamics Spot]机器人集成在一起。”) | Levatas |

| 2023年5月 | 48%:微软推出了TaskMatrix.ai(“我们展示TaskMatrix.ai如何通过[LLM]在物理世界中执行任务与机器人和物联网设备交互……所有这些案例都已在实践中实施……通过摄像头API了解环境,并将用户指令转换为机器人提供的动作API……通过连接物联网设备,促进在机器人的帮助下处理体力工作和建造智能家居…”)。 | Microsoft (arxiv) |

| 2023年5月 | 48%: OpenAI引入了GPT-4,可考证的记录微软认为GPT-4是“早期AGI”(“鉴于GPT-4能力的广度和深度,以合理地被视为人工通用智能(AGI)系统的早期(但仍然不完整)版本。”)。微软删除的论文原标题是“首次接触AGI系统”。请注意,LLM仍然没有体现。 | Microsoft Research |

| 2023年5月 | 42%: 谷歌推出了PaLM-E 562B(PaLM体现。“PaLM-E可以根据视觉和语言输入成功规划多个阶段……成功规划长期任务……”) | |

| 2023年2月 | 41%: 微软在机器人中使用了ChatGPT,它自我改进了(“我们对ChatGPT仅使用语言反馈进行本地化代码改进的能力印象深刻。”) | Microsoft |

| 2022年12月 | 39%: 通过人工智能反馈强化学习(RLAIF)训练的人类RL-CAI 52B(“我们已经远离了对人类监督的依赖,更接近于自我监督的对齐方法”) | LifeArchitect.ai, Anthropic paper (PDF) |

| 2022年7月 | 39%: NVIDIA的Hopper(H100)电路由人工智能设计(“最新的NVIDIA Hopper GPU架构有近13000个人工智能设计的电路实例”)。 | LifeArchitect.ai, NVIDIA |

| 2022年5月 | 39%: DeepMind Gato是第一个多面手特工,可以“玩Atari、配图片、聊天、用真正的机械臂堆叠区块等等”。 | Watch Alan’s video about Gato. |

| 2021年6月 | 31% 谷歌的TPUv4芯片由人工智能设计(“允许芯片设计由比任何人类设计师都更有经验的人工代理执行。我们的方法被用于设计谷歌的下一代人工智能(AI)加速器,有可能为每一代新产品节省数千小时的人力。”我们相信,更强大的人工智能设计硬件将推动人工智能的发展,在这两个领域之间建立共生关系”)。 | LifeArchitect.ai, Nature, Venturebeat |

| 2020年11月 | 30%: Connor Leahy,EleutherAI的联合创始人,GPT-2的再创造者,GPT-J和GPT-NeoX-20B的创造者,谈到OpenAI GPT-3时说:“我认为GPT-3是人工通用智能,AGI。我认为GPT-3和人类一样聪明。我认为它可能在某种程度上比人类更聪明……在很多方面,它比人类更纯粹聪明。我觉得人类正在接近GPT-3的所作所为,而不是相反。” | 视频 (timecode) |

| 2017年8月 | 20%: Google Transformer 架构对搜索、翻译以及语言模型产生了深远的影响 | 初始报道文章. |

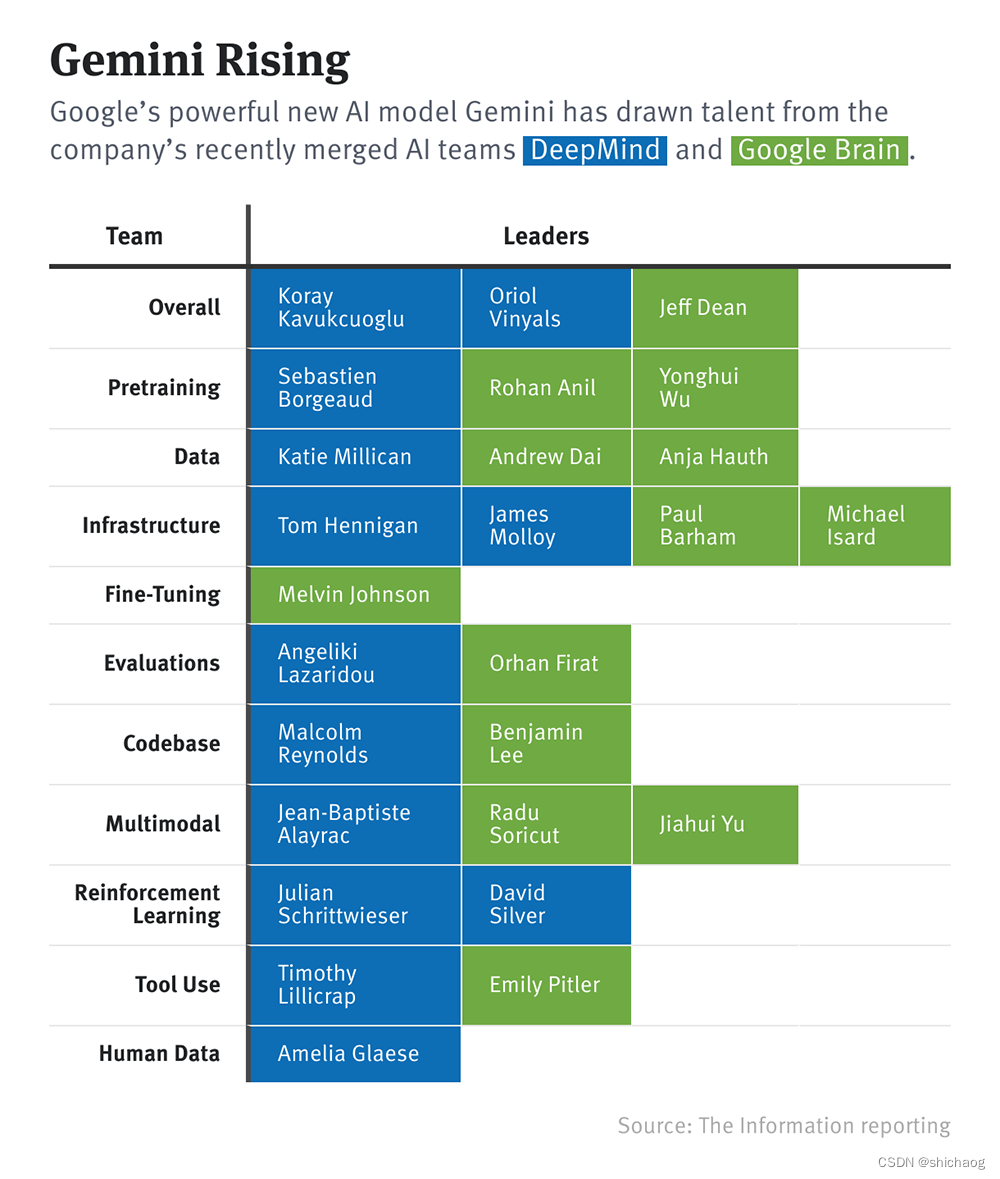

Gemini团队组成

Gemini 将团队划分为约 10 个小组,分别负责预训练、数据、基础设施、模型微调、模型评估、代码库、多模态、强化学习、工具使用以及人工标注数据。

Gemini细节

实现Paper、技术report以及开源资料,待谷歌发布后