当前,以ChatGPT为代表的大语言模型(LLM)正在掀起新一轮的AI 浪潮,数字产业生态也迎来前所未有的变局。随着大模型应用的兴起,如何低成本地实现大模型的构建和应用,成为企业关注的重点。

数据仓库是企业数据的存储、分析、加工、处理和计算的核心场所,为企业打造垂类模型、搭建面向场景的智能应用提供了天然的数据和计算环境。通过把大语言模型带入数据仓库,企业可以充分利用数据仓库强大的数据处理、分布式计算、大规模向量数据存储与检索等核心优势,一站式完成从数据处理、模型微调到智能应用搭建的全流程。

酷克数据作为国内最早专注于云原生数仓研发的企业之一,从成立之初,就致力于降低大数据分析和应用的门槛。为解决当前大模型规模化应用面临的高成本问题,酷克数据基于HashData云数仓开发了下一代In-Database高级分析和数据科学工具HashML,通过机器学习、深度学习及预训练大模型等技术,为开发者提供简单易用、算法先进、性能卓越的AI开发体验。

HashML是酷克数据核心产品HashData云数仓的扩展实现工具,随数仓的部署提供开箱即用的AI能力,让数据科学家、数据工程师、应用开发者无门槛地使用大模型,大幅降低大模型系统部署的成本和复杂度,推动大模型走向规模化应用。

大模型热潮涌来 成本问题备受关注

目前,在大模型领域,国内外科技巨头的竞争已经白热化。OpenAI、Meta、谷歌、百度、华为、阿里等企业竞相涌入,相继推出各自的大模型服务。

中国科学技术信息研究发布的《中国人工智能大模型地图研究报告》显示,截至今年5月份,国内已公开披露的大模型数量达到79个。

然而,对于企业而言,当前要部署和使用大模型,仍面临着高昂的成本负担。

据了解,大模型在企业落地的成本主要包括模型前期预训练与微调的成本以及模型后期与业务结合的运行成本,涉及计算资源、存储费用、网络传输、数据标注等费用。

从训练成本来看,以ChatGPT为例,其训练成本一次大概需要数百万美元。华为公布的数据显示,大模型开发和训练一次所需的费用大约1200万美元。在高度迭代和反复训练过程中,再加上供不应求的算力成本,大模型入门门槛将高达上亿级别,这对于众多企业来说是很难承受的压力。

可以说,高昂的成本已经成为大模型规模化应用巨大阻碍。与此同时,各大科技企业也在积极探索利用创新技术降低大模型应用的成本。

降低AI开发门槛 云原生数仓助力大模型普惠化

值得关注的是,云计算平台在大模型训练方面具备与生俱来的成本优势。企业可以基于云平台自动伸缩、按需计费的特性,对大模型训练成本进行合理规划和控制。

大模型的核心逻辑是对海量数据的收集、处理、统计和预测结果的输出。如果将大模型比作“烹饪”,数据就好比是“食材”,数据仓库则是必不可少的“厨具”。伴随大模型热潮的兴起,对于支撑AI的底层数据仓库也提出了更高的要求。

大模型庞大的数据量带来了存储和计算资源的压力,这要求数据库能够提供可以横向的并发访问能力、多范式的数据处理分析能力和海量异构数据的存储管理能力。在这种趋势下,基于云原生架构的数据仓库将成为未来数据库行业发展的重要方向。

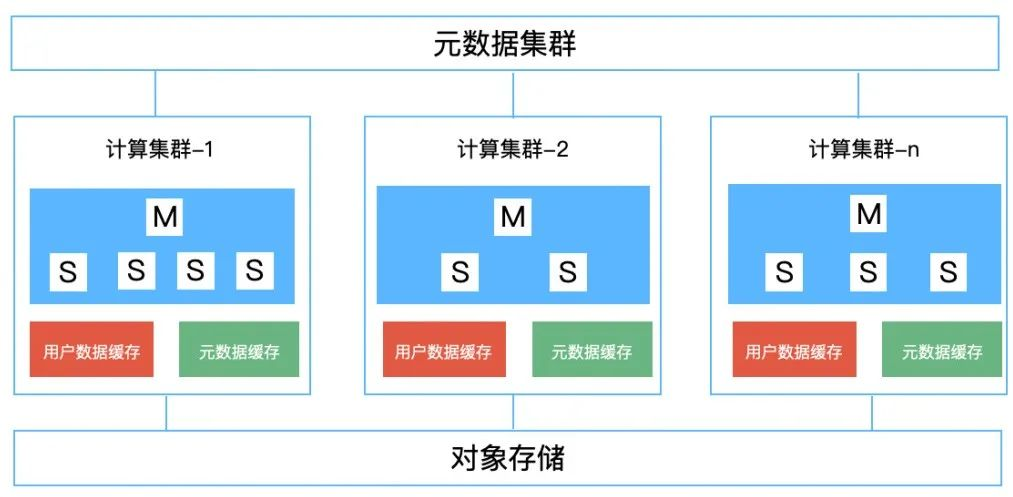

HashData云数仓基于云原生架构设计,通过元数据、计算和存储层解耦,从而最大限度发挥云平台的弹性和扩展能力。

图1:HashData产品架构

酷克数据即将推出的AI开发工具HashML,是一款基于HashData云数仓打造的新一代高级分析和数据科学工具箱,能够为开发者提供丰富的AI算法和模型能力,仅需几行代码就能开启模型训练、推理预测、模型部署,在统一的框架下支持各种经典的机器学习、深度学习算法以及预训练大模型。

HashML与HashData云数仓共享统一的存储和计算资源,随数仓的部署提供开箱即用的AI能力,大幅降低了系统部署的成本和复杂度,为开发者提供了统一的数据查询、分析、建模环境。

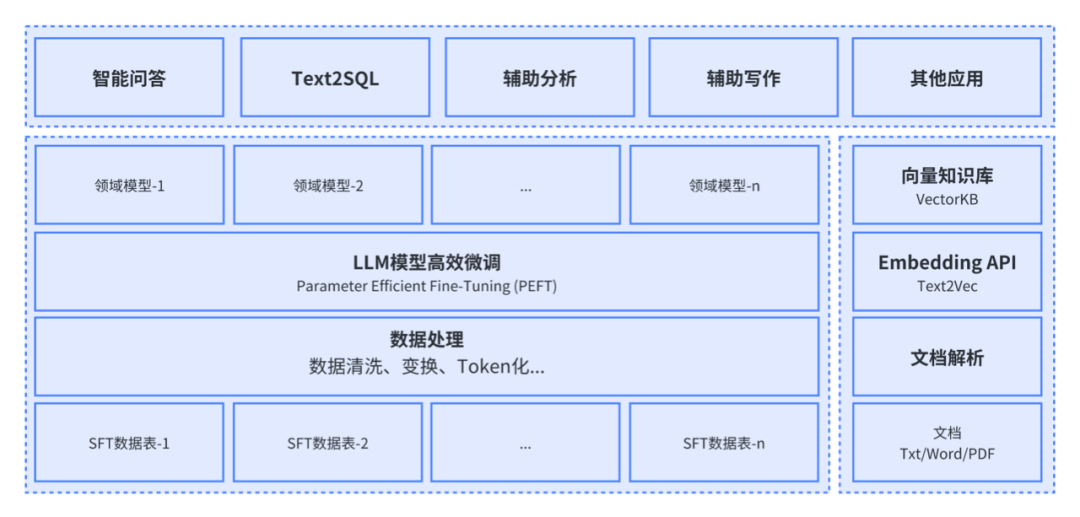

图2:基于HashData的LLM低成本落地方案

借助HashML,基于HashData的AI应用开发将会变得非常简单。HashML提供了从数据查询处理、高级分析到机器学习/深度学习模型的训练、推理和服务部署的全套工具,包括对大语言模型微调和推理的支持,另外提供了Python和SQL两种编程语言接口。

同时,HashData正在开发增强数据仓库支持向量数据存储和处理检索能力的功能组件,结合云数仓的高扩展性、高可用和高弹性,实现更好地支撑和扩展大模型的应用场景。

未来,大模型将成为新型基础设施的关键底座之一。酷克数据将通过领先的技术和完善的生态,推动人工智能技术普惠化,让更多企业“用得起、用得上、用得好”大模型,助力企业走好数字化转型之路。